Dla osób, które nie znają się na kodowaniu, tworzenie skrobaka internetowego może być trudne. Na szczęście oprogramowanie do skrobania stron internetowych jest dostępne zarówno dla programistów, jak i nie-programistów. Oprogramowanie do skrobania stron internetowych to specjalnie zaprojektowane oprogramowanie do pozyskiwania odpowiednich danych ze stron internetowych. Narzędzia te są korzystne dla każdego, kto chce w jakiś sposób pozyskać dane z Internetu. Informacje te są zapisywane w lokalnym pliku na komputerze lub w bazie danych. Jest to technika autonomicznego zbierania danych dla sieci. Przedstawiamy listę 31 najlepszych darmowych narzędzi do skrobania stron internetowych.

Spis treści:

31 najlepszych narzędzi do skrobania stron internetowych

Wybraną listę najlepszych narzędzi do web scrapingu można znaleźć tutaj. Ta lista zawiera zarówno narzędzia komercyjne, jak i open-source, a także linki do odpowiednich stron internetowych.

1. Przechytrzyć

Outwit to dodatek do przeglądarki Firefox, który można łatwo zainstalować ze sklepu z dodatkami do przeglądarki Firefox.

- To narzędzie do skrobania danych sprawia, że zbieranie kontaktów z Internetu i poczty e-mail jest dziecinnie proste.

- W zależności od wymagań będziesz mieć trzy alternatywy zakupu tego produktu.

- Zawodowiec

-

Ekspert i

-

Dostępne są wersje Enterprise.

- Pobieranie danych z witryn korzystających z centrum Outwit nie wymaga znajomości programowania.

- Możesz zacząć zdrapywać setki stron internetowych jednym kliknięciem przycisku eksploracji.

2. PareseHub

ParseHub to kolejne z najlepszych darmowych narzędzi do skrobania sieci.

- Przed pobraniem danych oczyść tekst i kod HTML.

- To tak proste, jak wybranie danych, które chcesz wyodrębnić za pomocą naszego wyrafinowanego narzędzia do przeszukiwania sieci.

- Jest to jedno z najlepszych narzędzi do skrobania danych, ponieważ umożliwia przechowywanie zeskrobanych danych w dowolnym formacie do dalszej analizy.

- Przyjazny dla użytkownika interfejs graficzny

- To narzędzie do skrobania Internetu umożliwia automatyczne zbieranie i zapisywanie danych na serwerach.

3. Apify

Apify to kolejne z najlepszych narzędzi do skrobania i automatyzacji stron internetowych, które pozwala zbudować interfejs API dla dowolnej witryny internetowej, z wbudowanymi serwerami proxy do użytku domowego i centrum danych, które ułatwiają wyodrębnianie danych.

- Apify zajmuje się infrastrukturą i rozliczeniami, umożliwiając programistom zarabianie pasywnych pieniędzy poprzez projektowanie narzędzi dla innych.

- Niektóre dostępne złącza to Zapier, Integromat, Keboola i Airbyte.

- Apify Store posiada gotowe rozwiązania do scrapingu dla popularnych stron internetowych, takich jak Instagram, Facebook, Twitter i Google Maps.

- JSON, XML, CSV, HTML i Excel to wszystkie ustrukturyzowane formularze, które można pobrać.

- HTTPS, targetowanie geograficzne, sprytna rotacja adresów IP i serwery proxy Google SERP to cechy Apify Proxy.

- Bezpłatna 30-dniowa wersja próbna serwera proxy z 5 USD kredytu na platformę.

4. Stos złomu

Scrapestack jest używany przez ponad 2000 firm i polegają na tym unikalnym interfejsie API, który jest zasilany przez apilayer. Jest to jedno z najlepszych darmowych narzędzi do skrobania stron internetowych.

- Korzysta z ogólnoświatowej puli adresów IP obejmującej 35 milionów centrów danych.

- Umożliwia jednoczesne wykonywanie wielu żądań API.

- Obsługiwane jest zarówno deszyfrowanie CAPTCHA, jak i renderowanie JavaScript.

- Dostępne są zarówno bezpłatne, jak i płatne opcje.

- Scrapestack to internetowy interfejs API REST do scrapingu, który działa w czasie rzeczywistym.

- Scrapestack API umożliwia zbieranie stron internetowych w milisekundach przy użyciu milionów adresów IP proxy, przeglądarek i kodów CAPTCHA.

- Żądania skrobania sieci mogą być wysyłane z ponad 100 różnych lokalizacji na całym świecie.

5. Fminer

W systemach Windows i Mac OS FMiner jest popularnym programem do scrapingu online, ekstrakcji danych, przeszukiwania ekranu indeksowania, makr i wsparcia internetowego.

- Dane mogą być zbierane z trudnych do zindeksowania dynamicznych witryn Web 2.0.

- Umożliwia tworzenie projektu ekstrakcji danych za pomocą prostego w obsłudze edytora wizualnego.

- Wykorzystuje kombinację struktur linków, menu rozwijanych i dopasowywania wzorców adresów URL, aby umożliwić przeglądanie stron internetowych.

- Możesz użyć automatycznych usług decaptcha innych firm lub ręcznego wprowadzania danych, aby docelowo chronić witrynę CAPTCHA.

6. Sekwencja

Sequentum to solidne narzędzie Big Data do pozyskiwania wiarygodnych danych online. Jest to kolejne z najlepszych darmowych narzędzi do skrobania stron internetowych.

- W porównaniu z alternatywnymi rozwiązaniami, wyodrębnianie danych online staje się szybsze.

- Korzystając z tej funkcji, możesz przechodzić między wieloma platformami.

- Jest to jeden z najpotężniejszych skrobaków internetowych do rozwoju Twojej firmy. Zawiera proste funkcje, w tym wizualny edytor typu „wskaż i kliknij”.

- Dedykowany internetowy interfejs API pomoże Ci w tworzeniu aplikacji internetowych, umożliwiając wykonywanie danych internetowych bezpośrednio z Twojej witryny.

7. Agenci

Agenty to program do scrapingu danych, ekstrakcji tekstu i OCR, który wykorzystuje Robotic Process Automation.

- Ten program umożliwia ponowne wykorzystanie wszystkich przetworzonych danych do celów analitycznych.

- Możesz zbudować agenta za pomocą kilku kliknięć myszką.

- Po zakończeniu zadania otrzymasz wiadomość e-mail.

- Pozwala połączyć się z Dropbox i korzystać z bezpiecznego FTP.

- Wszystkie dzienniki aktywności dla wszystkich zdarzeń są dostępne do wglądu.

- Pomaga w zwiększaniu sukcesu Twojej firmy.

- Umożliwia łatwe wdrażanie reguł biznesowych i niestandardowej logiki.

8. Importuj.io

Importując dane z określonej strony internetowej i eksportując je do pliku CSV, aplikacja web scraping import.io pomaga w tworzeniu zestawów danych. Jest to również jedno z najlepszych narzędzi do skrobania sieci. Oto cechy tego narzędzia.

- Formularze/loginy internetowe są proste w użyciu.

- Jest to jedno z najlepszych rozwiązań do scrapingu danych, które wykorzystuje interfejsy API i elementy webhook do integracji danych z aplikacjami.

- Możesz uzyskać wgląd w raporty, wykresy i wizualizacje.

- Pozyskiwanie danych powinno być zaplanowane z wyprzedzeniem.

- Chmura Import.io umożliwia przechowywanie i dostęp do danych.

- Interakcję z siecią i przepływy pracy można zautomatyzować.

9. Webz.io

Webz.io umożliwia indeksowanie setek stron internetowych i natychmiastowy dostęp do uporządkowanych danych w czasie rzeczywistym. Jest to również jedno z najlepszych darmowych narzędzi do skrobania stron internetowych.

Możesz pozyskać zorganizowane, odczytywalne komputerowo zestawy danych w formatach JSON i XML.

- Daje dostęp do historycznych kanałów obejmujących ponad dziesięć lat danych.

- Pozwala na dostęp do dużej bazy danych bez konieczności ponoszenia dodatkowych kosztów.

- Możesz użyć zaawansowanego filtra, aby przeprowadzić szczegółowe analizy i zbiory danych.

10. Skowronek

Scrape Owl to platforma do skrobania sieci, która jest łatwa w użyciu i ekonomiczna.

- Podstawowym celem Scrape Owl jest zbieranie wszelkich danych, w tym e-commerce, tablice ogłoszeń i wykazy nieruchomości.

- Przed wyodrębnieniem materiału możesz uruchomić niestandardowy JavaScript.

- Możesz używać lokalizacji do obchodzenia lokalnych ograniczeń i uzyskiwania dostępu do lokalnych treści.

- Zapewnia niezawodną funkcję oczekiwania.

- Obsługiwane jest renderowanie JavaScript na całej stronie.

- Ta aplikacja może być używana bezpośrednio w Arkuszu Google.

- Oferuje bezpłatny okres próbny o wartości 1000 kredytów, aby wypróbować usługę przed zakupem członkostwa. Nie ma potrzeby używania karty kredytowej.

11. Skrobak

Scrapingbee to interfejs API do zgarniania stron internetowych, który zajmuje się ustawieniami proxy i przeglądarkami bezgłowymi.

- Może wykonywać JavaScript na stronach i obracać serwery proxy dla każdego żądania, dzięki czemu możesz czytać surowy kod HTML bez umieszczania na czarnej liście.

- Dostępny jest również drugi interfejs API do wyodrębniania wyników wyszukiwania Google.

- Obsługiwane jest renderowanie JavaScript.

- Posiada funkcję automatycznej rotacji proxy.

- Z tej aplikacji można korzystać bezpośrednio w Arkuszach Google.

- Do korzystania z programu wymagana jest przeglądarka internetowa Chrome.

- Jest idealny do skrobania Amazon.

- Pozwala na skrobanie wyników Google.

12. Jasne dane

Bright Data to wiodąca na świecie internetowa platforma danych, oferująca ekonomiczne rozwiązanie do gromadzenia publicznych danych internetowych na dużą skalę, łatwego przekształcania danych nieustrukturyzowanych w dane strukturalne oraz zapewniania najwyższej jakości obsługi klienta przy zachowaniu pełnej przejrzystości i zgodności.

- Jest najbardziej elastyczny, ponieważ zawiera gotowe rozwiązania i można go rozbudowywać i dostosowywać.

- Data Collector nowej generacji firmy Bright Data zapewnia zautomatyzowany i spersonalizowany przepływ danych na jednym pulpicie nawigacyjnym, niezależnie od wielkości kolekcji.

- Jest otwarty 24 godziny na dobę, siedem dni w tygodniu i oferuje pomoc klientom.

- Od trendów w handlu elektronicznym i danych z sieci społecznościowych po informacje o konkurencji i badania rynku — zestawy danych są dostosowane do potrzeb Twojej firmy.

- Możesz skoncentrować się na swojej podstawowej działalności, automatyzując dostęp do wiarygodnych danych w swojej branży.

- Jest najbardziej wydajny, ponieważ wykorzystuje rozwiązania bez kodu i zużywa mniej zasobów.

- Najbardziej niezawodny, z najlepszą jakością danych, dłuższym czasem pracy bez przestojów, szybszymi danymi i lepszą obsługą klienta.

13. API skrobaka

Możesz użyć narzędzia Scraper API do obsługi serwerów proxy, przeglądarek i CAPTCHA.

- Narzędzie zapewnia niezrównaną szybkość i niezawodność, umożliwiając tworzenie skalowalnych skrobaków sieci.

- Możesz uzyskać kod HTML z dowolnej strony internetowej za pomocą jednego wywołania interfejsu API.

- Konfiguracja jest prosta, ponieważ wszystko, co musisz zrobić, to wysłać żądanie GET z kluczem API i adresem URL do punktu końcowego API.

- Umożliwia łatwiejsze renderowanie kodu JavaScript.

- Pozwala dostosować typ żądania i nagłówki dla każdego żądania.

- Obrotowe proxy z lokalizacją geograficzną

14. Dexi Inteligentny

Dexi Intelligent to internetowa aplikacja do scrapingu, która umożliwia przekształcenie dowolnej ilości danych internetowych w szybką wartość komercyjną.

- To internetowe narzędzie do skrobania pozwala zaoszczędzić pieniądze i czas Twojej firmy.

- Poprawiła produktywność, dokładność i jakość.

- Umożliwia najszybszą i najbardziej wydajną ekstrakcję danych.

- Posiada system przechwytywania wiedzy na dużą skalę.

15. Diffbot

Diffbot umożliwia szybkie uzyskanie różnych ważnych faktów z Internetu.

- Dzięki ekstraktorom AI będziesz w stanie wyodrębnić dokładne dane strukturalne z dowolnego adresu URL.

- Nie zostaniesz obciążony czasochłonnym skrobaniem strony lub ręcznym zapytaniem.

- Aby zbudować kompletny i dokładny obraz każdego obiektu, łączy się wiele źródeł danych.

- Możesz wyodrębnić dane strukturalne z dowolnego adresu URL za pomocą narzędzi AI Extractors.

- Dzięki Crawlbot możesz skalować ekstrakcję do dziesiątek tysięcy domen.

- Funkcja Grafu wiedzy zapewnia sieci Web dokładne, pełne i głębokie dane, których potrzebuje BI do dostarczania znaczących informacji.

16. Streamer danych

Data Streamer to technologia, która pozwala na pobieranie materiałów społecznościowych z całego Internetu.

- Jest to jeden z największych skrobaków internetowych, który wykorzystuje przetwarzanie języka naturalnego do pobierania kluczowych metadanych.

-

Kibana i Elasticsearch służą do zapewnienia zintegrowanego wyszukiwania pełnotekstowego.

- Na podstawie algorytmów wyszukiwania informacji, zintegrowanego usuwania szablonów i ekstrakcji treści.

- Zbudowany na infrastrukturze odpornej na uszkodzenia, aby zapewnić wysoką dostępność informacji.

17. Mozenda

Możesz wyodrębnić tekst, zdjęcia i materiały PDF ze stron internetowych za pomocą Mozendy.

- Możesz użyć wybranego przez siebie narzędzia lub bazy danych Bl do gromadzenia i publikowania danych online.

- Jest to jedno z najlepszych narzędzi do scrapingu online do organizowania i formatowania plików danych do publikacji.

- Dzięki interfejsowi typu „wskaż i kliknij” możesz w ciągu kilku minut utworzyć agentów do przeszukiwania sieci.

- Aby zbierać dane internetowe w czasie rzeczywistym, użyj funkcji Job Sequencer i Request Blocking.

- Zarządzanie kontem i obsługa klienta należą do najlepszych w branży.

18. Rozszerzenie Data Miner do Chrome

Wtyczka do przeglądarki Data Miner ułatwia skrobanie stron internetowych i przechwytywanie danych.

- Ma możliwość indeksowania kilku stron, a także dynamicznego wyodrębniania danych.

- Wyboru danych można dokonać na różne sposoby.

- Sprawdza informacje, które zostały zeskrobane.

- To zeskrobane dane można zapisać jako plik CSV.

- Pamięć lokalna służy do przechowywania zeskrobanych danych.

- Dodatek Chrome Web Scraper pobiera dane z witryn dynamicznych.

- Mapy witryn można importować i eksportować.

19. Złośliwy

Scrapy jest również jednym z najlepszych narzędzi do skrobania stron internetowych. Jest to oparta na Pythonie platforma do scrapingu online o otwartym kodzie źródłowym do tworzenia skrobaków internetowych.

- Zapewnia wszystkie narzędzia potrzebne do szybkiego wyodrębniania danych ze stron internetowych, analizowania ich i zapisywania w wybranej przez siebie strukturze i formacie.

- To narzędzie do scrapingu danych jest niezbędne, jeśli masz duży projekt do scrapingu danych i chcesz, aby był jak najbardziej wydajny, zachowując jednocześnie dużą elastyczność.

- Dane mogą być eksportowane w formacie JSON, CSV lub XML.

- Obsługiwane są systemy Linux, Mac OS X i Windows.

- Został opracowany na bazie technologii sieci asynchronicznej Twisted, która jest jedną z jej kluczowych funkcji.

- Scrapy wyróżnia się prostotą obsługi, obszerną dokumentacją i aktywną społecznością.

20. Chmura Scrape Hero

ScrapeHero wykorzystał swoją wieloletnią wiedzę o indeksowaniu sieci i przekształcił ją w ekonomiczne i proste w użyciu, gotowe roboty i interfejsy API do zgarniania danych z witryn takich jak Amazon, Google, Walmart i innych.

- Roboty ScrapeHero Cloud obejmują automatyczne obracanie serwerów proxy i opcję uruchamiania wielu robotów jednocześnie.

- Aby korzystać ze ScrapeHero Cloud, nie musisz pobierać ani uczyć się, jak korzystać z narzędzi lub oprogramowania do scrapingu danych.

- Roboty indeksujące ScrapeHero Cloud pozwalają błyskawicznie zeskrobać dane i wyeksportować je w formatach JSON, CSV lub Excel.

- Klienci planów Free i Lite ScrapeHero Cloud otrzymują pomoc e-mail, podczas gdy wszystkie inne plany otrzymują usługę priorytetową.

- Roboty indeksujące ScrapeHero Cloud można również skonfigurować tak, aby spełniały określone wymagania klienta.

- Jest to oparty na przeglądarce internetowej skrobak, który działa z każdą przeglądarką internetową.

- Nie potrzebujesz żadnej wiedzy programistycznej ani rozwijania skrobaka; to tak proste, jak klikanie, kopiowanie i wklejanie!

21. Skrobak danych

Data Scraper to darmowa aplikacja do skrobania online, która pobiera dane z pojedynczej strony internetowej i zapisuje je jako pliki CSV lub XSL.

- To rozszerzenie przeglądarki, które konwertuje dane do zgrabnego formatu tabelarycznego.

- Zainstalowanie wtyczki wymaga korzystania z przeglądarki Google Chrome.

- Dzięki bezpłatnej wersji możesz zeskrobać 500 stron każdego miesiąca; ale jeśli chcesz zeskrobać więcej stron, musisz przejść na jeden z drogich planów.

22. Wizualny ripper sieciowy

Visual Web Ripper to narzędzie do automatycznego pobierania danych ze stron internetowych.

- Struktury danych są zbierane ze stron internetowych lub wyników wyszukiwania za pomocą tego narzędzia.

- Możesz eksportować dane do plików CSV, XML i Excel i posiada przyjazny dla użytkownika interfejs.

- Może również zbierać dane z dynamicznych witryn internetowych, na przykład korzystających z technologii AJAX.

- Wystarczy skonfigurować kilka szablonów, a web scraper zajmie się resztą.

- Visual Web Ripper oferuje opcje planowania, a nawet wysyła wiadomość e-mail w przypadku niepowodzenia projektu.

23. Ośmiornica

Octoparse to przyjazna dla użytkownika aplikacja do skrobania stron internetowych z interfejsem wizualnym. Jest to jedno z najlepszych darmowych narzędzi do skrobania stron internetowych. Oto cechy tego narzędzia.

- Interfejs typu „wskaż i kliknij” ułatwia wybieranie informacji, które chcesz pobrać ze strony internetowej. Octoparse może obsługiwać zarówno statyczne, jak i dynamiczne strony internetowe dzięki AJAX, JavaScript, plikom cookie i innym możliwościom.

- Zaawansowane usługi w chmurze, które pozwalają wyodrębnić duże ilości danych, są teraz dostępne.

- Zebrane informacje można zapisać jako pliki TXT, CSV, HTML lub XLSX.

- Darmowa wersja Octoparse pozwala na zbudowanie do 10 crawlerów; jednak płatne plany członkostwa obejmują funkcje, takie jak interfejs API i dużą liczbę anonimowych serwerów proxy IP, które przyspieszą ekstrakcję i pozwolą pobierać duże ilości danych w czasie rzeczywistym.

24. Web Harvey

Wizualny skrobak WebHarvey ma wbudowaną przeglądarkę do pobierania danych z witryn internetowych. Jest to również jedno z najlepszych narzędzi do skrobania sieci. Oto kilka funkcji tego narzędzia.

- Oferuje interfejs typu „wskaż i kliknij”, który ułatwia wybieranie przedmiotów.

- Ten skrobak ma tę zaletę, że nie wymaga pisania żadnego kodu.

-

Do zapisywania danych można użyć plików CSV, JSON i XML.

- Możliwe jest również zapisanie go w bazie danych SQL. WebHarvey zawiera wielopoziomową funkcję usuwania kategorii, która może pobierać dane ze stron z listami, śledząc każdy poziom połączeń kategorii.

- Wyrażenia regularne mogą być używane z internetowym narzędziem do scrapingu, co daje dodatkową swobodę.

- Możesz skonfigurować serwery proxy, aby ukryć swój adres IP podczas pobierania danych ze stron internetowych, co pozwala zachować pewną prywatność.

25. PySpider

PySpider jest również jednym z najlepszych darmowych narzędzi do przeszukiwania sieci, które jest robotem indeksującym opartym na Pythonie. Poniżej wymieniono kilka funkcji tego narzędzia.

- Posiada rozproszoną architekturę i obsługuje strony JavaScript.

- W ten sposób możesz mieć wiele robotów. PySpider może przechowywać dane na dowolnym wybranym przez Ciebie backendzie, w tym MongoDB, MySQL, Redis i innych.

- Dostępne są kolejki wiadomości, takie jak RabbitMQ, Beanstalk i Redis.

- Jedną z zalet PySpider jest prosty interfejs użytkownika, który pozwala na zmianę skryptów, monitorowanie uruchomionych działań i badanie wyników.

- Informacje można pobrać w formatach JSON i CSV.

- PySpider to skrobak internetowy, który należy wziąć pod uwagę, jeśli pracujesz z interfejsem użytkownika opartym na witrynie internetowej.

- Działa również ze stronami internetowymi, które używają dużo AJAX.

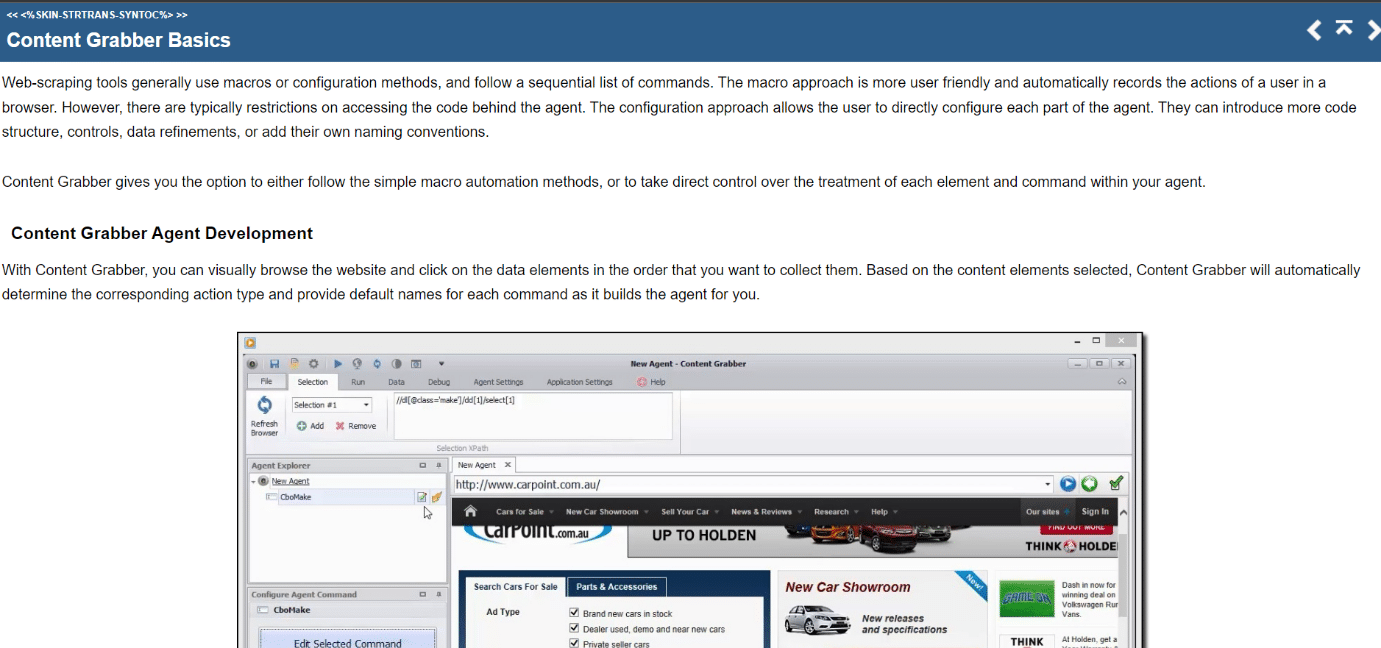

26. Pochłaniacz treści

Content Grabber to wizualne narzędzie do skrobania online z łatwym w użyciu interfejsem typu „wskaż i kliknij” do wybierania elementów. Oto cechy tego narzędzia.

- CSV, XLSX, JSON i PDF to formaty, w których można eksportować dane. Do korzystania z tego narzędzia wymagane są średnio zaawansowane umiejętności programowania.

- Paginacja, nieograniczone przewijanie stron i wyskakujące okienka są możliwe dzięki interfejsowi użytkownika.

- Zawiera również przetwarzanie AJAX/Javascript, rozwiązanie captcha, obsługę wyrażeń regularnych i rotację adresów IP (przy użyciu Nohodo).

27. Kimuraj

Kimurai to platforma do scrapingu sieci Ruby do tworzenia scraperów i wyodrębniania danych. Jest to również jedno z najlepszych darmowych narzędzi do skrobania stron internetowych. Oto kilka funkcji tego narzędzia.

- Pozwala nam na skrobanie i interakcję ze stronami internetowymi utworzonymi w języku JavaScript od razu po wyjęciu z pudełka za pomocą Headless Chromium/Firefox, PhantomJS lub podstawowych zapytań HTTP.

- Ma podobną składnię do Scrapy i konfigurowalne opcje, w tym ustawianie opóźnienia, obracanie agentów użytkownika i domyślne nagłówki.

- Współdziała również ze stronami internetowymi za pomocą platformy testowej Capybara.

28. Cheerio

Cheerio to kolejne z najlepszych narzędzi do skrobania sieci. Jest to pakiet, który analizuje dokumenty HTML i XML oraz umożliwia operowanie na pobranych danych przy użyciu składni jQuery. Oto cechy tego narzędzia.

- Jeśli tworzysz skrobak sieci JavaScript, interfejs API Cheerio zapewnia szybki wybór do analizowania, modyfikowania i wyświetlania danych.

- Nie renderuje danych wyjściowych w przeglądarce internetowej, nie stosuje CSS, nie ładuje zasobów zewnętrznych ani nie uruchamia JavaScript.

- Jeśli którakolwiek z tych funkcji jest wymagana, powinieneś spojrzeć na PhantomJS lub JSDom.

29. Lalkarz

Puppeteer to pakiet Node, który pozwala zarządzać bezgłową przeglądarką Google Chrome za pomocą potężnego, ale prostego interfejsu API. Poniżej wymieniono kilka funkcji tego narzędzia.

- Działa w tle, wykonując polecenia przez API.

- Bezgłowa przeglądarka to taka, która może wysyłać i odbierać żądania, ale nie ma graficznego interfejsu użytkownika.

- Puppeteer jest właściwym rozwiązaniem dla tego zadania, jeśli informacje, których szukasz, są generowane przy użyciu kombinacji danych API i kodu JavaScript.

- Możesz naśladować wrażenia użytkownika, pisząc i klikając w te same miejsca, w których się znajdują.

- Puppeteer może być również używany do przechwytywania zrzutów ekranu stron internetowych, które są domyślnie wyświetlane po otwarciu przeglądarki internetowej.

30. Dramaturg

Playwright to biblioteka Microsoft Node przeznaczona do automatyzacji przeglądarki. Jest to kolejne z najlepszych darmowych narzędzi do skrobania stron internetowych. Oto kilka funkcji tego narzędzia.

- Oferuje kompetentną, niezawodną i szybką automatyzację sieci w różnych przeglądarkach.

- Celem Playwright było ulepszenie zautomatyzowanych testów interfejsu użytkownika poprzez usunięcie niestabilności, zwiększenie szybkości wykonywania i zapewnienie wglądu w działanie przeglądarki.

- Jest to nowoczesna aplikacja do automatyzacji przeglądarki, która pod wieloma względami jest porównywalna do Puppeteer i jest dostarczana z fabrycznie zainstalowanymi kompatybilnymi przeglądarkami.

- Jego główną zaletą jest kompatybilność z różnymi przeglądarkami, ponieważ może obsługiwać Chromium, WebKit i Firefox.

- Playwright regularnie integruje się z platformami Docker, Azure, Travis CI i AppVeyor.

31. PJScrape

PJscrape to oparty na Pythonie zestaw narzędzi do scrapingu online, który wykorzystuje JavaScript i JQuery. Oto cechy tego narzędzia.

- Został zaprojektowany do pracy z PhantomJS, dzięki czemu można pobierać witryny z wiersza poleceń w całkowicie wyrenderowanym kontekście obsługującym JavaScript, bez potrzeby korzystania z przeglądarki.

- Oznacza to, że możesz uzyskać dostęp nie tylko do DOM, ale także do zmiennych i funkcji JavaScript, a także do zawartości ładowanej AJAX.

- Funkcje skrobaka są oceniane w kontekście całej przeglądarki.

***

Mamy nadzieję, że ten przewodnik był pomocny w zakresie najlepszych narzędzi do scrapingu w sieci. Daj nam znać, które narzędzie jest dla Ciebie łatwe. Odwiedzaj naszą stronę, aby uzyskać więcej fajnych wskazówek i wskazówek oraz zostaw swoje komentarze poniżej.