Zbudowanie jednego modelu uczenia maszynowego jest stosunkowo łatwe. Tworzenie setek lub tysięcy modeli i powtarzanie istniejących jest trudne.

W chaosie łatwo się zgubić. Ten chaos pogarsza się, gdy pracujesz jako zespół, ponieważ musisz teraz śledzić, co wszyscy robią. Uporządkowanie chaosu wymaga, aby cały zespół postępował zgodnie z procesem i dokumentował swoje działania. To jest esencja MLOps.

Spis treści:

Co to jest MLOps?

Źródło: ml-ops.org

Według MLOps.org, Machine Learning Operationalization próbuje zbudować kompleksowy proces rozwoju uczenia maszynowego w celu projektowania, tworzenia i zarządzania odtwarzalnym, testowalnym i rozwijalnym oprogramowaniem opartym na ML. Zasadniczo MLOps to zasady DevOps stosowane w uczeniu maszynowym.

Podobnie jak DevOps, kluczową ideą MLOps jest automatyzacja w celu ograniczenia ręcznych czynności i zwiększenia wydajności. Ponadto, podobnie jak DevOps, MLOps obejmuje zarówno ciągłą integrację (CI), jak i ciągłe dostarczanie (CD). Oprócz tych dwóch obejmuje również szkolenie ciągłe (CT). Dodatkowym aspektem CT jest ponowne uczenie modeli o nowe dane i ponowne ich wdrażanie.

MLOps jest zatem kulturą inżynierską, która promuje metodyczne podejście do rozwoju modelu uczenia maszynowego i automatyzację różnych etapów metody. Proces obejmuje przede wszystkim ekstrakcję danych, analizę, przygotowanie, szkolenie modeli, ocenę, udostępnianie modeli i monitorowanie.

Zalety MLOps

Ogólnie rzecz biorąc, korzyści płynące ze stosowania zasad MLOps są takie same, jak korzyści wynikające ze stosowania Standardowych Procedur Operacyjnych. Zalety są następujące:

- Dobrze zdefiniowany proces zapewnia mapę drogową wszystkich kluczowych kroków, które należy podjąć w rozwoju modelu. Gwarantuje to, że nie zostaną pominięte żadne krytyczne kroki.

- Etapy procesu, które można zautomatyzować, można zidentyfikować i zautomatyzować. Zmniejsza to ilość powtarzalnej pracy i zwiększa szybkość rozwoju. Eliminuje również błędy ludzkie, jednocześnie zmniejszając ilość pracy, którą należy wykonać.

- Łatwiej jest ocenić postęp w rozwoju modelu, wiedząc, na jakim etapie potoku znajduje się model.

- Zespołom łatwiej jest się komunikować, ponieważ istnieje wspólne słownictwo określające kroki, które należy podjąć podczas opracowywania.

- Proces ten można wielokrotnie stosować do opracowywania wielu modeli, zapewniając sposób zarządzania chaosem.

Tak więc ostatecznie rolą MLOps w uczeniu maszynowym jest zapewnienie metodycznego podejścia do tworzenia modeli, które można zautomatyzować w jak największym stopniu.

Platformy do budowy rurociągów

Aby pomóc Ci zaimplementować MLOps w swoich potokach, możesz użyć jednej z wielu platform, które omówimy tutaj. Chociaż poszczególne funkcje tych platform mogą się różnić, zasadniczo pomagają one wykonać następujące czynności:

- Przechowuj wszystkie swoje modele wraz z powiązanymi z nimi metadanymi modeli — takimi jak konfiguracje, kod, dokładność i eksperymenty. Zawiera również różne wersje twoich modeli do kontroli wersji.

- Przechowuj metadane zestawu danych, takie jak dane używane do uczenia modeli.

- Monitoruj modele w produkcji, aby wykryć problemy, takie jak dryf modelu.

- Wdróż modele do produkcji.

- Twórz modele w środowiskach z małą ilością kodu lub bez kodu.

Poznajmy najlepsze platformy MLOps.

MLFflow

MLFlow jest prawdopodobnie najpopularniejszą platformą do zarządzania cyklem życia uczenia maszynowego. Jest darmowy i open source. Zapewnia następujące funkcje:

- śledzenie w celu rejestrowania eksperymentów uczenia maszynowego, kodu, danych, konfiguracji i wyników końcowych;

- projekty spakowania Twojego kodu w formacie łatwym do odtworzenia;

- wdrożenie do wdrażania uczenia maszynowego;

- rejestr do przechowywania wszystkich modeli w centralnym repozytorium

MLFlow integruje się z popularnymi bibliotekami uczenia maszynowego, takimi jak TensorFlow i PyTorch. Integruje się również z platformami takimi jak Apache Spark, H20.asi, Google Cloud, Amazon Sage Maker, Azure Machine Learning i Databricks. Współpracuje również z różnymi dostawcami usług w chmurze, takimi jak AWS, Google Cloud i Microsoft Azure.

Azure Machine Learning

Azure Machine Learning to kompleksowa platforma uczenia maszynowego. Zarządza różnymi działaniami cyklu życia maszyny w potoku MLOP. Czynności te obejmują przygotowywanie danych, budowanie i trenowanie modeli, sprawdzanie poprawności i wdrażanie modeli oraz zarządzanie i monitorowanie wdrożeń.

Azure Machine Learning umożliwia tworzenie modeli przy użyciu preferowanego środowiska IDE i wybranej struktury, PyTorch lub TensorFlow.

Integruje się również z ONNX Runtime i Deepspeed, aby zoptymalizować trening i wnioskowanie. Poprawia to wydajność. Wykorzystuje infrastrukturę sztucznej inteligencji na platformie Microsoft Azure, która łączy procesory graficzne NVIDIA i sieć Mellanox, aby pomóc w tworzeniu klastrów uczenia maszynowego. Dzięki AML możesz utworzyć centralny rejestr do przechowywania i udostępniania modeli i zestawów danych.

Azure Machine Learning integruje się z akcjami Git i GitHub w celu tworzenia przepływów pracy. Obsługuje również konfigurację hybrydową lub wielochmurową. Można go również zintegrować z innymi usługami platformy Azure, takimi jak Synapse Analytics, Data Lake, Databricks i Security Center.

Sztuczna inteligencja wierzchołków Google

Google Vertex AI to ujednolicona platforma danych i sztucznej inteligencji. Zapewnia narzędzia potrzebne do tworzenia niestandardowych i wstępnie wyszkolonych modeli. Służy również jako kompleksowe rozwiązanie do implementacji MLOps. Aby ułatwić korzystanie, integruje się z BigQuery, Dataproc i Spark, zapewniając bezproblemowy dostęp do danych podczas szkolenia.

Oprócz interfejsu API, Google Vertex AI zapewnia środowisko narzędziowe z małą ilością kodu i bez kodu, dzięki czemu może być używane przez osoby niebędące programistami, takie jak analitycy biznesowi i danych oraz inżynierowie. API umożliwia programistom integrację z istniejącymi systemami.

Google Vertex AI umożliwia także tworzenie generatywnych aplikacji AI przy użyciu Generative AI Studio. Dzięki temu wdrażanie i zarządzanie infrastrukturą jest łatwe i szybkie. Idealne przypadki użycia sztucznej inteligencji Google Vertex obejmują zapewnienie gotowości danych, inżynierię funkcji, szkolenie i dostrajanie hiperparametrów, udostępnianie modeli, dostrajanie i zrozumienie modeli, monitorowanie modeli i zarządzanie modelami.

Kostki danych

Datakostki to usługa Data Lakehouse, która umożliwia przygotowywanie i przetwarzanie danych. Dzięki kostkom danych możesz zarządzać całym cyklem życia uczenia maszynowego, od eksperymentowania do produkcji.

Zasadniczo Databricks zapewnia zarządzane MLFlow zapewniające funkcje, takie jak rejestrowanie danych w wersji reklamowej modeli ML, śledzenie eksperymentów, udostępnianie modeli, rejestr modeli i śledzenie metryk reklam. Rejestr modeli umożliwia przechowywanie modeli w celu ich odtwarzania, a rejestr pomaga śledzić wersje i etap cyklu życia, w którym się znajdują.

Wdrażanie modeli przy użyciu Dataricks można wykonać za pomocą jednego kliknięcia, a będziesz mieć punkty końcowe interfejsu API REST do wykorzystania do prognozowania. Wśród innych modeli dobrze integruje się z istniejącymi, wstępnie wytrenowanymi generatywnymi i dużymi modelami językowymi, takimi jak te z biblioteki transformatorów przytulania twarzy.

Dataricks udostępnia notesy Databricks do współpracy, które obsługują języki Python, R, SQL i Scala. Ponadto upraszcza zarządzanie infrastrukturą, udostępniając wstępnie skonfigurowane klastry zoptymalizowane pod kątem zadań uczenia maszynowego.

AWS SageMaker

AWS SageMaker to usługa AWS w chmurze, która zapewnia narzędzia potrzebne do opracowywania, trenowania i wdrażania modeli uczenia maszynowego. Głównym celem SageMaker jest automatyzacja żmudnej i powtarzalnej pracy ręcznej związanej z budowaniem modelu uczenia maszynowego.

W rezultacie zapewnia narzędzia do budowania potoku produkcyjnego dla modeli uczenia maszynowego przy użyciu różnych usług AWS, takich jak instancje Amazon EC2 i pamięć masowa Amazon S3.

SageMaker współpracuje z Jupyter Notebooks zainstalowanymi w instancji EC2 wraz ze wszystkimi popularnymi pakietami i bibliotekami potrzebnymi do kodowania modelu uczenia maszynowego. W przypadku danych SageMaker może pobierać dane z Amazon Simple Storage Service.

Domyślnie otrzymujesz implementacje typowych algorytmów uczenia maszynowego, takich jak regresja liniowa i klasyfikacja obrazów. SageMaker jest również wyposażony w monitor modelu, który zapewnia ciągłe i automatyczne dostrajanie w celu znalezienia zestawu parametrów, które zapewniają najlepszą wydajność modeli. Wdrażanie jest również uproszczone, ponieważ możesz łatwo wdrożyć swój model w AWS jako bezpieczny punkt końcowy HTTP, który możesz monitorować za pomocą CloudWatch.

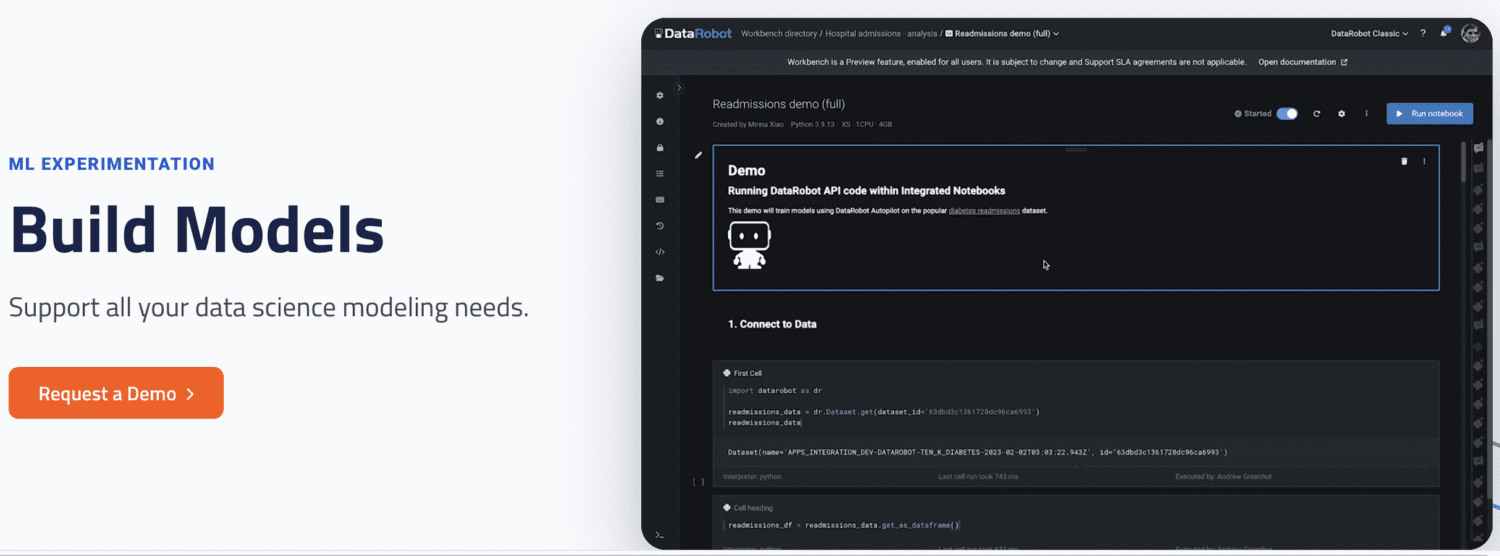

DataRobot

DataRobot to popularna platforma MLOps, która umożliwia zarządzanie różnymi etapami cyklu życia uczenia maszynowego, takimi jak przygotowywanie danych, eksperymentowanie z uczeniem maszynowym, sprawdzanie poprawności i zarządzanie modelami.

Posiada narzędzia do automatyzacji przeprowadzania eksperymentów z różnymi źródłami danych, testowania tysięcy modeli i oceny najlepszych do wdrożenia w środowisku produkcyjnym. Obsługuje budowanie modeli dla różnych typów modeli AI do rozwiązywania problemów w szeregach czasowych, przetwarzaniu języka naturalnego i wizji komputerowej.

Dzięki DataRobot możesz budować przy użyciu gotowych modeli, więc nie musisz pisać kodu. Alternatywnie możesz wybrać podejście oparte na kodzie i wdrożyć modele przy użyciu niestandardowego kodu.

DataRobot jest dostarczany z notatnikami do pisania i edytowania kodu. Alternatywnie możesz użyć interfejsu API, aby tworzyć modele w wybranym przez siebie środowisku IDE. Korzystając z GUI, możesz śledzić eksperymenty swoich modeli.

Uruchom AI

Run AI próbuje rozwiązać problem niepełnego wykorzystania infrastruktury AI, w szczególności GPU. Rozwiązuje ten problem, promując widoczność całej infrastruktury i upewniając się, że jest ona wykorzystywana podczas szkolenia.

Aby to zrobić, Run AI znajduje się pomiędzy oprogramowaniem MLOps a sprzętem firmy. Podczas zajmowania tej warstwy wszystkie zadania szkoleniowe są następnie uruchamiane przy użyciu Run AI. Platforma z kolei planuje uruchomienie każdego z tych zadań.

Nie ma ograniczeń co do tego, czy sprzęt musi być oparty na chmurze, takiej jak AWS i Google Cloud, on-premises czy rozwiązanie hybrydowe. Zapewnia warstwę abstrakcji zespołom uczenia maszynowego, działając jako platforma wirtualizacji GPU. Możesz uruchamiać zadania z Jupyter Notebook, terminala bash lub zdalnego PyCharm.

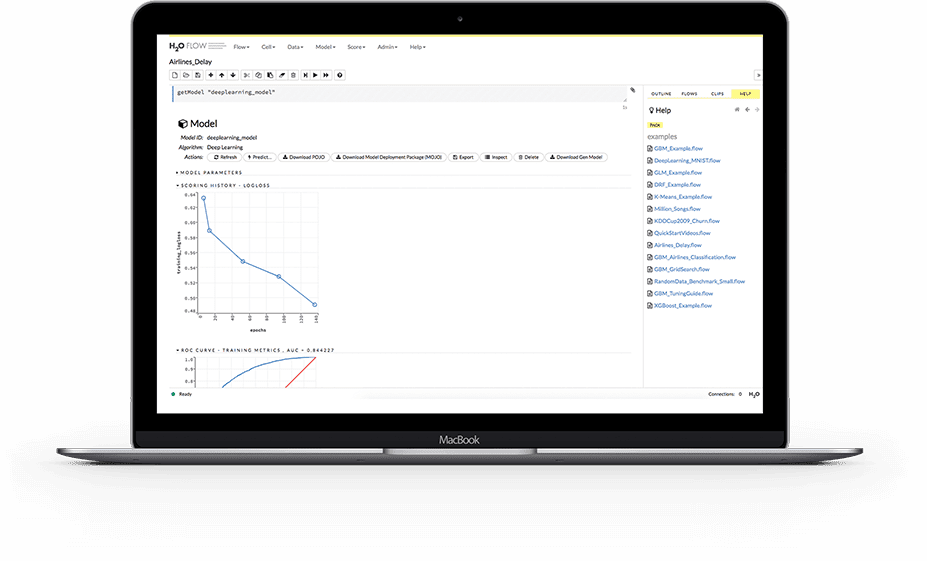

H2O.ai

H2O to rozproszona platforma uczenia maszynowego typu open source. Umożliwia zespołom współpracę i tworzenie centralnego repozytorium modeli, w którym analitycy danych mogą eksperymentować i porównywać różne modele.

Jako platforma MLOps, H20 zapewnia szereg kluczowych funkcji. Po pierwsze, H2O upraszcza również wdrożenie modelu na serwerze jako punkt końcowy REST. Zapewnia różne tematy wdrażania, takie jak testy A/B, modele Champoion-Challenger i proste wdrażanie pojedynczego modelu.

Podczas szkolenia przechowuje i zarządza danymi, artefaktami, eksperymentami, modelami i wdrożeniami. Pozwala to na powtarzalność modeli. Umożliwia także zarządzanie uprawnieniami na poziomie grupy i użytkownika w celu zarządzania modelami i danymi. Gdy model działa, H2O zapewnia również monitorowanie w czasie rzeczywistym dryfu modelu i innych wskaźników operacyjnych.

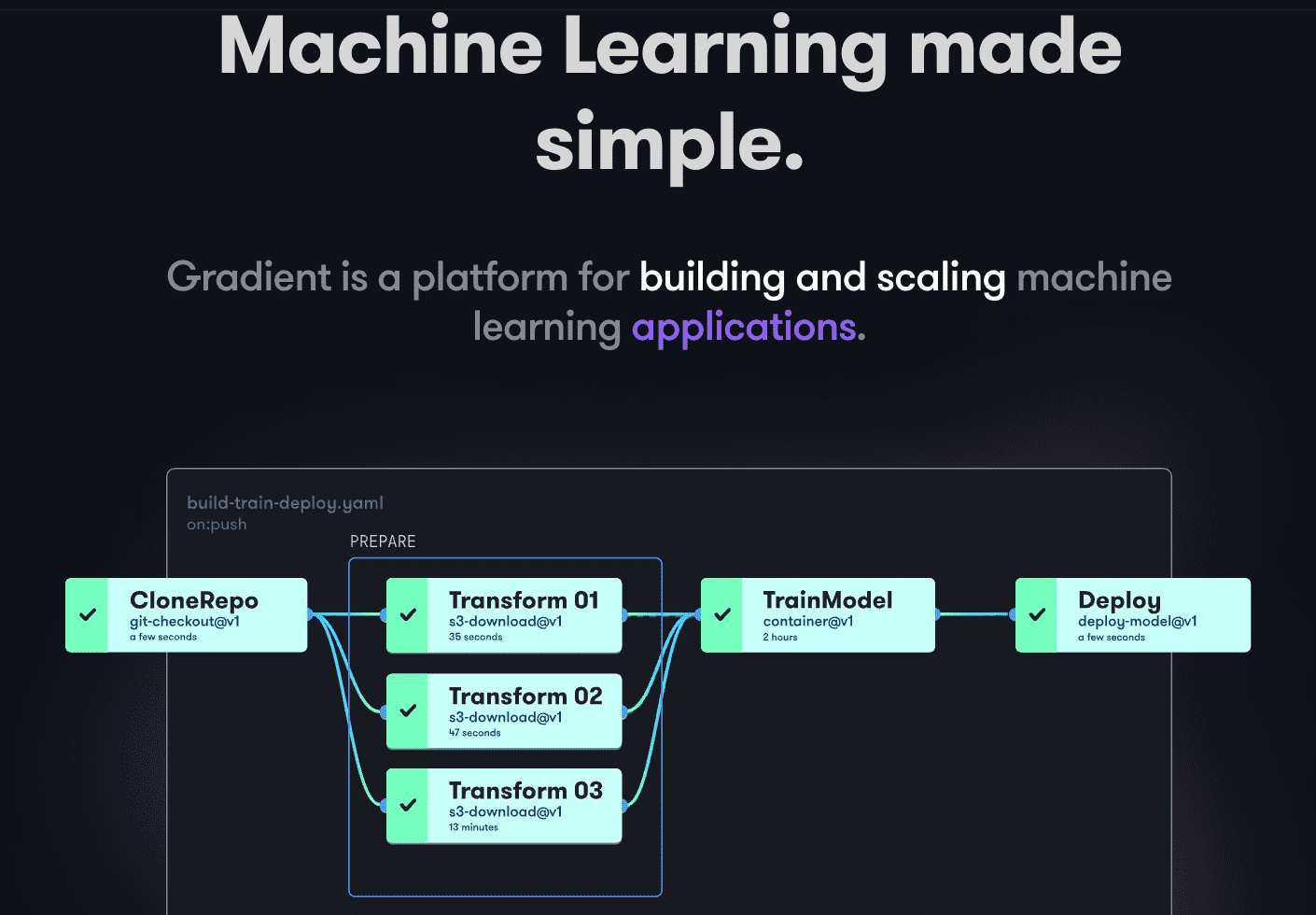

Gradient przestrzeni papieru

Gradient pomaga programistom na wszystkich etapach cyklu rozwoju Machine Learning. Zapewnia notebooki obsługiwane przez platformę Jupyter o otwartym kodzie źródłowym do opracowywania modeli i szkolenia w chmurze przy użyciu wydajnych procesorów graficznych. Pozwala to na szybkie eksplorowanie i tworzenie prototypów modeli.

Potoki wdrażania można zautomatyzować, tworząc przepływy pracy. Te przepływy pracy są definiowane przez opisywanie zadań w YAML. Korzystanie z przepływów pracy sprawia, że tworzenie wdrożeń i udostępnianie modeli jest łatwe do replikacji, a co za tym idzie skalowalne.

Jako całość Gradient zapewnia kontenery, maszyny, dane, modele, metryki, dzienniki i klucze tajne, aby pomóc Ci zarządzać różnymi etapami potoku opracowywania modelu uczenia maszynowego. Twoje potoki działają w klastrach Gradiet. Te klastry znajdują się na Paperspace Cloud, AWS, GCP, Azure lub na innych serwerach. Możesz wchodzić w interakcje z Gradientem za pomocą CLI lub SDK programowo.

Ostatnie słowa

MLOps to wydajne i wszechstronne podejście do budowania i wdrażania modeli uczenia maszynowego oraz zarządzania nimi na dużą skalę. MLOps jest łatwy w użyciu, skalowalny i bezpieczny, co czyni go dobrym wyborem dla organizacji każdej wielkości.

W tym artykule omówiliśmy MLOPs, dlaczego ważne jest ich wdrożenie, co się z tym wiąże oraz różne popularne platformy MLOps.

Następnie możesz przeczytać nasze porównanie Dataricks i Snowflake.