Zastanawiasz się, jak uzyskać wiarygodne i spójne dane do analizy danych? Zaimplementuj te strategie czyszczenia danych już teraz!

Twoja decyzja biznesowa opiera się na analizie danych. Podobnie spostrzeżenia pochodzące z wejściowych zestawów danych zależą od jakości danych źródłowych. Niskiej jakości, niedokładne, śmieciowe i niespójne źródła danych to trudne wyzwania dla branży data science i analityki danych.

Dlatego eksperci wymyślili obejścia. Tym obejściem jest czyszczenie danych. Oszczędza to podejmowania decyzji opartych na danych, które wyrządzą szkodę firmie zamiast ją ulepszyć.

Czytaj dalej, aby poznać najlepsze strategie czyszczenia danych, z których korzystają odnoszący sukcesy naukowcy i analitycy danych. Zapoznaj się także z narzędziami, które mogą oferować czyste dane do natychmiastowych projektów analizy danych.

Spis treści:

Co to jest czyszczenie danych?

Jakość danych ma pięć wymiarów. Identyfikowanie i korygowanie błędów w danych wejściowych poprzez przestrzeganie zasad jakości danych jest znane jako czyszczenie danych.

Parametry jakościowe tego pięciowymiarowego standardu to:

# 1. Kompletność

Ten parametr kontroli jakości zapewnia, że dane wejściowe mają wszystkie wymagane parametry, nagłówki, wiersze, kolumny, tabele itp. dla projektu analizy danych.

#2. Precyzja

Wskaźnik jakości danych, który mówi, że dane są zbliżone do prawdziwej wartości danych wejściowych. Dane mogą mieć prawdziwą wartość, jeśli przestrzegasz wszystkich standardów statystycznych dotyczących ankiet lub zbierania danych.

#3. Ważność

Ten parametr data science, że dane są zgodne z regułami biznesowymi, które skonfigurowałeś.

#4. Jednolitość

Jednolitość potwierdza, czy dane zawierają jednolitą treść, czy nie. Na przykład dane ankietowe dotyczące zużycia energii w USA powinny zawierać wszystkie jednostki imperialnego systemu miar. Jeśli używasz systemu metrycznego dla niektórych treści w tej samej ankiecie, dane nie są jednolite.

#5. Spójność

Spójność zapewnia spójność wartości danych między tabelami, modelami danych i zestawami danych. Należy również uważnie monitorować ten parametr podczas przenoszenia danych między systemami.

W skrócie, zastosuj powyższe procesy kontroli jakości do nieprzetworzonych zbiorów danych i oczyść dane przed przekazaniem ich do narzędzia analizy biznesowej.

Znaczenie czyszczenia danych

Tak po prostu, nie możesz prowadzić swojego cyfrowego biznesu na kiepskim planie przepustowości Internetu; nie można podejmować świetnych decyzji, gdy jakość danych jest nie do zaakceptowania. Jeśli spróbujesz wykorzystać śmieci i błędne dane do podejmowania decyzji biznesowych, zobaczysz utratę przychodów lub niski zwrot z inwestycji (ROI).

Według raportu Gartnera na temat niskiej jakości danych i jej konsekwencji, think tank ustalił, że średnia strata, z jaką boryka się firma, wynosi 12,9 miliona dolarów. Służy to tylko podejmowaniu decyzji na podstawie błędnych, sfałszowanych i śmieciowych danych.

Ten sam raport sugeruje, że wykorzystywanie złych danych w całych Stanach Zjednoczonych kosztuje kraj oszałamiającą roczną stratą w wysokości 3 bilionów dolarów.

Ostateczny wgląd z pewnością będzie śmieciem, jeśli zasilisz system BI danymi śmieciowymi.

Dlatego należy oczyścić surowe dane, aby uniknąć strat pieniężnych i podejmować skuteczne decyzje biznesowe z projektów analizy danych.

Korzyści z czyszczenia danych

# 1. Unikaj strat pieniężnych

Czyszcząc dane wejściowe, możesz uchronić swoją firmę przed stratami pieniężnymi, które mogą być karą za niezgodność lub utratę klientów.

#2. Podejmuj świetne decyzje

Wysokiej jakości dane, które można wykorzystać, dostarczają cennych spostrzeżeń. Takie spostrzeżenia pomagają podejmować znakomite decyzje biznesowe dotyczące marketingu produktów, sprzedaży, zarządzania zapasami, ustalania cen itp.

#3. Zdobądź przewagę nad konkurentem

Jeśli zdecydujesz się na czyszczenie danych wcześniej niż konkurencja, odniesiesz korzyści płynące z szybkiego rozwoju w swojej branży.

#4. Spraw, aby projekt był wydajny

Usprawniony proces czyszczenia danych zwiększa poziom zaufania członków zespołu. Ponieważ wiedzą, że dane są wiarygodne, mogą bardziej skoncentrować się na analizie danych.

#5. Zapisz zasoby

Czyszczenie i przycinanie danych zmniejsza rozmiar całej bazy danych. W związku z tym usuwasz miejsce do przechowywania bazy danych, eliminując niepotrzebne dane.

Strategie czyszczenia danych

Standaryzuj dane wizualne

Zbiór danych będzie zawierał wiele typów znaków, takich jak teksty, cyfry, symbole itp. Należy zastosować jednolity format wielkich liter we wszystkich tekstach. Upewnij się, że symbole mają właściwe kodowanie, takie jak Unicode, ASCII itp.

Na przykład termin Bill pisany wielką literą oznacza imię osoby. Przeciwnie, rachunek lub rachunek oznacza pokwitowanie transakcji; dlatego kluczowe znaczenie ma odpowiednie formatowanie wielkimi literami.

Usuń zreplikowane dane

Zduplikowane dane dezorientują system BI. W rezultacie wzór zostanie przekrzywiony. Dlatego musisz usunąć zduplikowane wpisy z wejściowej bazy danych.

Duplikaty zwykle pochodzą z procesów wprowadzania danych przez ludzi. Jeśli możesz zautomatyzować proces wprowadzania nieprzetworzonych danych, możesz wyeliminować replikacje danych z katalogu głównego.

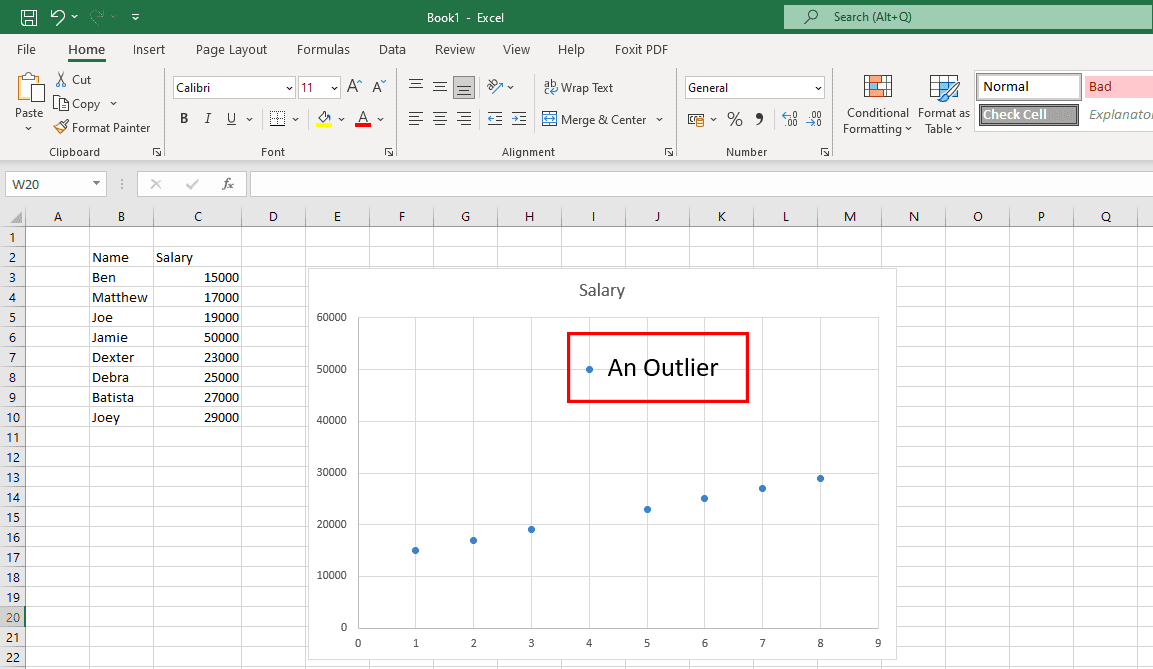

Napraw niechciane wartości odstające

Wartości odstające to nietypowe punkty danych, które nie mieszczą się we wzorcu danych, jak pokazano na powyższym wykresie. Prawdziwe wartości odstające są w porządku, ponieważ pomagają naukowcom danych odkryć błędy ankiety. Jeśli jednak wartości odstające wynikają z błędów ludzkich, stanowi to problem.

Aby wyszukać wartości odstające, należy umieścić zestawy danych na wykresach lub diagramach. Jeśli znajdziesz, zbadaj źródło. Jeśli źródłem jest błąd ludzki, usuń dane odstające.

Skoncentruj się na danych strukturalnych

Jest to głównie znajdowanie i naprawianie błędów w zbiorach danych.

Na przykład zestaw danych zawiera jedną kolumnę USD i wiele kolumn innych walut. Jeśli Twoje dane dotyczą użytkowników ze Stanów Zjednoczonych, przelicz inne waluty na ekwiwalent USD. Następnie zamień wszystkie inne waluty na USD.

Zeskanuj swoje dane

Ogromna baza danych pobrana z hurtowni danych może zawierać tysiące tabel. Możesz nie potrzebować wszystkich tabel dla swojego projektu nauki o danych.

Dlatego po uzyskaniu bazy danych musisz napisać skrypt, aby wskazać potrzebne tabele danych. Gdy już to wiesz, możesz usunąć nieistotne tabele i zminimalizować rozmiar zestawu danych.

Ostatecznie doprowadzi to do szybszego wykrywania wzorców danych.

Oczyść dane w chmurze

Jeśli Twoja baza danych korzysta ze schematu przy zapisie, musisz przekonwertować ją na schemat przy odczycie. Umożliwi to czyszczenie danych bezpośrednio w chmurze i ekstrakcję sformatowanych, uporządkowanych i gotowych do analizy danych.

Tłumacz języki obce

Jeśli prowadzisz ankietę na całym świecie, możesz spodziewać się języków obcych w surowych danych. Musisz przetłumaczyć wiersze i kolumny zawierające języki obce na język angielski lub dowolny inny preferowany język. W tym celu można skorzystać z narzędzi do tłumaczenia wspomaganego komputerowo (CAT).

Oczyszczanie danych krok po kroku

# 1. Zlokalizuj krytyczne pola danych

Hurtownia danych zawiera terabajty baz danych. Każda baza danych może zawierać od kilku do kilku tysięcy kolumn danych. Teraz musisz spojrzeć na cel projektu i odpowiednio wyodrębnić dane z takich baz danych.

Jeśli Twój projekt bada trendy zakupowe mieszkańców USA w handlu elektronicznym, gromadzenie danych o sklepach detalicznych offline w tym samym skoroszycie nic nie da.

#2. Organizuj dane

Po zlokalizowaniu ważnych pól danych, nagłówków kolumn, tabel itp. w bazie danych należy je uporządkować.

#3. Usuń duplikaty

Surowe dane zebrane z hurtowni danych zawsze będą zawierać zduplikowane wpisy. Musisz zlokalizować i usunąć te repliki.

#4. Wyeliminuj puste wartości i spacje

Niektóre nagłówki kolumn i odpowiadające im pola danych mogą nie zawierać żadnych wartości. Musisz wyeliminować te nagłówki/pola kolumn lub zastąpić puste wartości właściwymi alfanumerycznymi.

#5. Wykonaj dokładne formatowanie

Zestawy danych mogą zawierać niepotrzebne spacje, symbole, znaki itp. Należy je sformatować za pomocą formuł, aby cały zestaw danych wyglądał jednakowo pod względem rozmiaru i rozpiętości komórek.

#6. Standaryzuj proces

Musisz utworzyć SPO, którą członkowie zespołu analityki danych mogą śledzić i wykonywać swoje obowiązki podczas procesu czyszczenia danych. Musi zawierać następujące elementy:

- Częstotliwość zbierania surowych danych

- Kierownik ds. przechowywania i konserwacji surowych danych

- Częstotliwość czyszczenia

- Kierownik ds. przechowywania i utrzymania czystych danych

Oto kilka popularnych narzędzi do czyszczenia danych, które mogą pomóc w projektach związanych z nauką o danych:

WinPure

Jeśli szukasz aplikacji, która pozwala dokładnie i szybko czyścić i szorować dane, WinPure jest niezawodnym rozwiązaniem. To wiodące w branży narzędzie oferuje funkcję czyszczenia danych na poziomie przedsiębiorstwa z niezrównaną szybkością i precyzją.

Ponieważ jest przeznaczony do obsługi użytkowników indywidualnych i firm, każdy może z niego korzystać bez trudności. Oprogramowanie wykorzystuje funkcję zaawansowanego profilowania danych do analizowania typów, formatów, integralności i wartości danych w celu kontroli jakości. Jego potężny i inteligentny mechanizm dopasowywania danych wybiera idealne dopasowania z minimalną liczbą fałszywych dopasowań.

Oprócz powyższych funkcji WinPure oferuje również oszałamiające efekty wizualne dla wszystkich danych, dopasowań grupowych i niedopasowań.

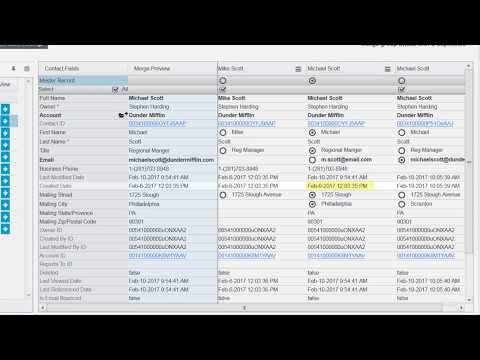

Działa również jako narzędzie do scalania, które łączy zduplikowane rekordy w celu wygenerowania rekordu głównego, który może zachować wszystkie bieżące wartości. Ponadto możesz użyć tego narzędzia do zdefiniowania zasad wyboru rekordu głównego i natychmiastowego usunięcia wszystkich rekordów.

OtwórzPopraw

OpenRefine to bezpłatne narzędzie o otwartym kodzie źródłowym, które pomaga przekształcić niechlujne dane w czysty format, który można wykorzystać w usługach internetowych. Wykorzystuje aspekty do czyszczenia dużych zestawów danych i działa na filtrowanych widokach zestawów danych.

Z pomocą potężnej heurystyki narzędzie może łączyć podobne wartości, aby pozbyć się wszelkich niespójności. Oferuje usługi uzgadniania, dzięki którym użytkownicy mogą łączyć swoje zbiory danych z zewnętrznymi bazami danych. Ponadto użycie tego narzędzia oznacza, że w razie potrzeby można wrócić do starszej wersji zestawu danych.

Ponadto użytkownicy mogą odtwarzać historię operacji w zaktualizowanej wersji. Jeśli martwisz się o bezpieczeństwo danych, OpenRefine jest odpowiednią opcją dla Ciebie. Czyści twoje dane na twoim komputerze, więc nie ma w tym celu migracji danych do chmury.

Trifacta Designer Cloud

Chociaż czyszczenie danych może być skomplikowane, Trifacta Designer Cloud ułatwia to zadanie. Wykorzystuje nowatorskie podejście do przygotowywania danych do czyszczenia danych, dzięki czemu organizacje mogą uzyskać z niego jak najwięcej korzyści.

Przyjazny dla użytkownika interfejs umożliwia użytkownikom nietechnicznym czyszczenie i czyszczenie danych w celu przeprowadzenia zaawansowanej analizy. Teraz firmy mogą zrobić więcej ze swoimi danymi, wykorzystując inteligentne sugestie Trifacta Designer Cloud oparte na ML.

Co więcej, będą musieli poświęcić mniej czasu na ten proces, jednocześnie mając do czynienia z mniejszą liczbą błędów. Wymaga to użycia ograniczonych zasobów, aby uzyskać więcej z analizy.

Cloudingo

Jesteś użytkownikiem Salesforce i martwisz się o jakość zbieranych danych? Użyj Cloudingo, aby wyczyścić dane klientów i mieć tylko niezbędne dane. Ta aplikacja ułatwia zarządzanie danymi klientów dzięki funkcjom takim jak deduplikacja, import i migracja.

Tutaj możesz kontrolować łączenie rekordów za pomocą dostosowywalnych filtrów i reguł oraz standaryzować dane. Usuń bezużyteczne i nieaktywne dane, zaktualizuj brakujące punkty danych i zapewnij dokładność adresów pocztowych w USA.

Ponadto firmy mogą zaplanować automatyczną deduplikację danych w Cloudingo, aby zawsze mieć dostęp do czystych danych. Synchronizacja danych z Salesforce to kolejna kluczowa funkcja tego narzędzia. Dzięki niemu możesz nawet porównywać dane Salesforce z informacjami przechowywanymi w arkuszu kalkulacyjnym.

ZoomInfo

ZoomInfo jest dostawcą rozwiązań do czyszczenia danych, które przyczyniają się do produktywności i efektywności Twojego zespołu. Firmy mogą osiągnąć większą rentowność, ponieważ to oprogramowanie dostarcza dane bez powielania do firmowego CRM i MAT.

Ułatwia zarządzanie jakością danych, usuwając wszystkie kosztowne zduplikowane dane. Użytkownicy mogą również zabezpieczyć obwód CRM i MAT za pomocą ZoomInfo. Może oczyścić dane w ciągu kilku minut dzięki automatycznej deduplikacji, dopasowywaniu i normalizacji.

Użytkownicy tej aplikacji mogą cieszyć się elastycznością i kontrolą nad dopasowywaniem kryteriów i łączonymi wynikami. Pomaga zbudować ekonomiczny system przechowywania danych poprzez standaryzację dowolnego typu danych.

Ostatnie słowa

Należy dbać o jakość danych wejściowych w projektach nauki o danych. Jest to podstawowy kanał dla dużych projektów, takich jak uczenie maszynowe (ML), sieci neuronowe dla automatyzacji opartej na sztucznej inteligencji itp. Jeśli kanał jest wadliwy, zastanów się, jaki byłby wynik takich projektów.

Dlatego Twoja organizacja musi przyjąć sprawdzoną strategię czyszczenia danych i wdrożyć ją jako standardową procedurę operacyjną (SOP). W konsekwencji poprawi się również jakość danych wejściowych.

Jeśli jesteś wystarczająco zajęty projektami, marketingiem i sprzedażą, lepiej pozostawić część związaną z czyszczeniem danych ekspertom. Ekspertem może być dowolne z powyższych narzędzi do czyszczenia danych.

Być może zainteresuje Cię również schemat usługi, który pozwoli bez wysiłku wdrożyć strategie czyszczenia danych.