Dzień dobry! 👋 Mamy dla Was garść najnowszych informacji o produktach! 📢

OpenAI, Google, Microsoft i Anthropic łączą siły w celu regulacji rozwoju sztucznej inteligencji

Cztery czołowe firmy z sektora sztucznej inteligencji – OpenAI, Microsoft, Google i Anthropic – nawiązały współpracę, tworząc Forum Modelów Granicznych. Zadaniem tej organizacji branżowej jest zapewnienie bezpiecznego i odpowiedzialnego rozwoju zaawansowanych modeli sztucznej inteligencji i uczenia maszynowego, określanych mianem „AI granicznej”.

OpenAI wprowadziło termin „AI graniczna” w publikacji z 6 lipca. Odnosi się on do modeli, które potencjalnie niosą zagrożenia dla bezpieczeństwa publicznego.

Głównymi celami Forum są:

- Rozwijanie badań nad bezpieczeństwem sztucznej inteligencji.

- Określanie standardów tworzenia i wdrażania modeli granicznych.

- Współpraca z zainteresowanymi stronami.

- Wspieranie zastosowań sztucznej inteligencji, które służą rozwiązywaniu problemów.

Utworzenie Forum Modelów Granicznych dowodzi zaangażowania branży w kwestie bezpieczeństwa i proaktywnego podejścia gigantów technologicznych do regulacji poprzez wspólne inicjatywy.

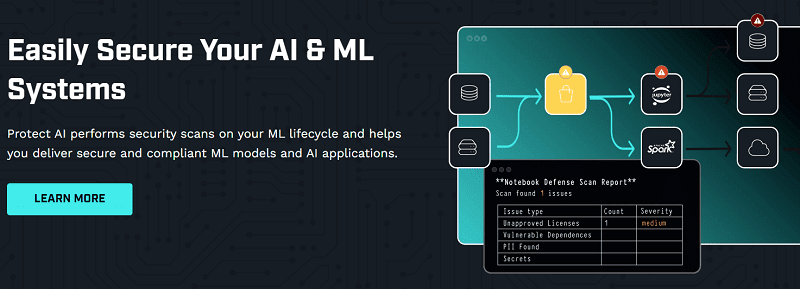

Protect AI oferuje rozwiązania do skanowania bezpieczeństwa i ochrony systemów uczenia maszynowego (ML) i sztucznej inteligencji. Ich celem jest dostarczanie bezpiecznych i zgodnych z regulacjami modeli ML i aplikacji AI. Zapewniają identyfikację zagrożeń, testowanie zabezpieczeń i naprawę systemów AI i ML.

Firma pozyskała 35 milionów dolarów w rundzie finansowania Serii A, prowadzonej przez Evolution Equity Partners, przy udziale Salesforce Ventures i dotychczasowych inwestorów. Łącznie do tej pory zgromadzili 48,5 miliona dolarów na pomoc organizacjom w ochronie systemów ML i aplikacji AI przed lukami w zabezpieczeniach, naruszeniami danych i nowymi zagrożeniami.

Rozwiązanie Protect AI NB Defense chroni notebooki Jupyter Lab, zwiększając efektywność pracy i ułatwiając współpracę. Ogranicza ryzyko, skanuje w poszukiwaniu problemów z bezpieczeństwem i dostarcza istotnych informacji. Narzędzia AI automatycznie zabezpieczają łańcuch dostaw oprogramowania ML, przeprowadzają skanowanie i naprawiają wykryte problemy.

Trustmi pozyskuje 17 milionów dolarów na rozwój technologii zapobiegania oszustwom płatniczym

Trustmi wykorzystuje sztuczną inteligencję, uczenie maszynowe i analizę danych do proaktywnej identyfikacji i zapobiegania oszustwom w transakcjach płatniczych. Platforma oferuje szeroki zakres funkcjonalności, umożliwiających firmom podniesienie poziomu bezpieczeństwa płatności.

Wśród tych funkcjonalności znajdują się:

- Monitorowanie transakcji w poszukiwaniu podejrzanych aktywności, takich jak płatności z krajów wysokiego ryzyka lub od nieznanych dostawców.

- Weryfikacja płatności poprzez porównanie ich z różnymi źródłami danych, w tym czarnymi listami kart kredytowych i listami dostawców.

- Umożliwienie użytkownikom kontrolowania płatności, pozwalające na ich zatwierdzanie lub odrzucanie, oraz ustawianie limitów dla poszczególnych dostawców.

Firma pozyskała 17 milionów dolarów w rundzie Serii A, zwiększając całkowite finansowanie do 21 milionów dolarów. Runda ta była prowadzona przez Cyberstarts z udziałem Zeev Ventures.

Więcej aktualności znajdziesz w kategorii Najnowsze technologie.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.