Jako dziecko z niecierpliwością wyczekiwałem kreskówek, gdzie auta poruszały się bez udziału kierowcy. Moja wyobraźnia podpowiadała mi, że wewnątrz tych pojazdów kryją się malutkie roboty, które w magiczny sposób przejmowały kontrolę nad kierownicą.

Dziś, w dobie zaawansowanej technologii, samochody autonomiczne stają się realnością! Fascynuje mnie to zjawisko. Czy te pojazdy rozpoznają konieczność zatrzymania, na przykład przed znakami „stop” lub na czerwonym świetle? Czy potrafią dostrzec zwierzęta i ludzi na drodze? Jak radzą sobie podczas jazdy w ciemności, deszczu lub śniegu?

Zagłębmy się w świat samochodów autonomicznych! Są to pojazdy, które potrafią poruszać się samodzielnie, bez ingerencji kierowcy. Firmy takie jak Tesla i Waymo wykorzystują zaawansowane techniki komputerowe, w tym głębokie uczenie, aby nadać tym samochodom wyjątkową inteligencję. Głębokie uczenie pozwala im na interpretowanie znaków drogowych i zapewnienie bezpiecznej jazdy, nawet w trudnych warunkach atmosferycznych. To innowacyjne podejście zmienia przyszłość transportu!

Historia

Historia aut autonomicznych przypomina pasjonującą odyseję. Przenieśmy się myślami do lat 20. XX wieku, kiedy pojazdy bez kierowcy były jedynie fantazją. Wówczas Francis Houdina, innowator o niezwykłym umyśle, stworzył pojazd, który poruszał się zgodnie z liniami wyznaczonymi na drodze. Jednak jego działanie wymagało specjalnych przewodów umieszczonych pod nawierzchnią.

Źródło: theatlantic.com

Źródło: theatlantic.com

W latach 80. i 90. naukowcy z Carnegie Mellon University dokonali przełomowego odkrycia. Opracowali samochody wyposażone w kamery, które umożliwiały im „widzenie” i poruszanie się po zatłoczonych ulicach. Te pionierskie pojazdy przypominały odkrywców, którzy uczyli się jazdy, analizując otoczenie.

W 2004 roku doszło do przełomowego wydarzenia, które miało miejsce na pustynnym terenie. Samochody autonomiczne wzięły udział w wymagającym wyścigu. Co prawda nie wygrały, ale był to kamień milowy w ich rozwoju. Traktowano to jako swoisty poligon doświadczalny, dzięki któremu pojazdy mogły udoskonalić swoje umiejętności.

Prawdziwy przełom nastąpił na przełomie wieków, gdy do gry wkroczyły czołowe korporacje, takie jak Tesla, Uber i Google (obecnie Waymo). Google rozpoczęło testowanie autonomicznych aut w 2009 roku. W 2015 roku Tesla wprowadziła funkcję, która pozwalała jej pojazdom poruszać się autonomicznie po wybranych trasach. Auta te radziły sobie ze sterowaniem i utrzymaniem toru jazdy bez ciągłej kontroli człowieka.

Wraz z przyłączaniem się kolejnych firm, rywalizacja w tworzeniu w pełni autonomicznych pojazdów zaostrzyła się. Wyobraźmy sobie zespoły inżynierów, którzy z determinacją pracowali nad samochodami, które mogłyby jeździć bez udziału kierowcy.

Jednak to nie koniec historii. Wciąż trwają prace nad udoskonaleniem technologii, która zrewolucjonizuje nasze podróże. Ta przygoda trwa, a to z kolei oznacza, że będziemy podróżować bezpieczniej i wygodniej, ponieważ te niezwykłe autonomiczne pojazdy stają się coraz bardziej zaawansowane.

Jak działają samochody autonomiczne?

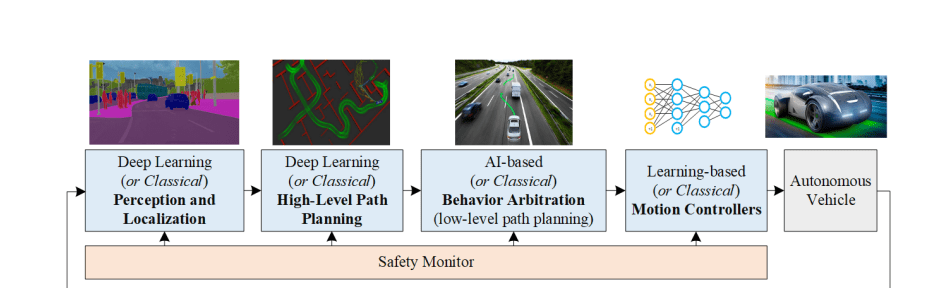

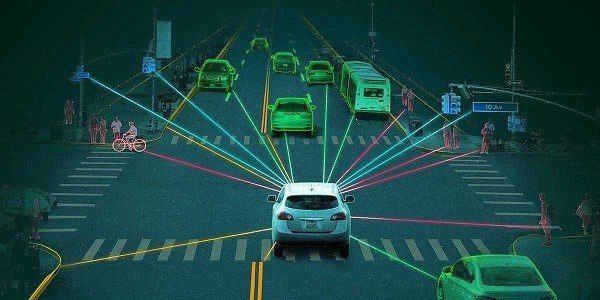

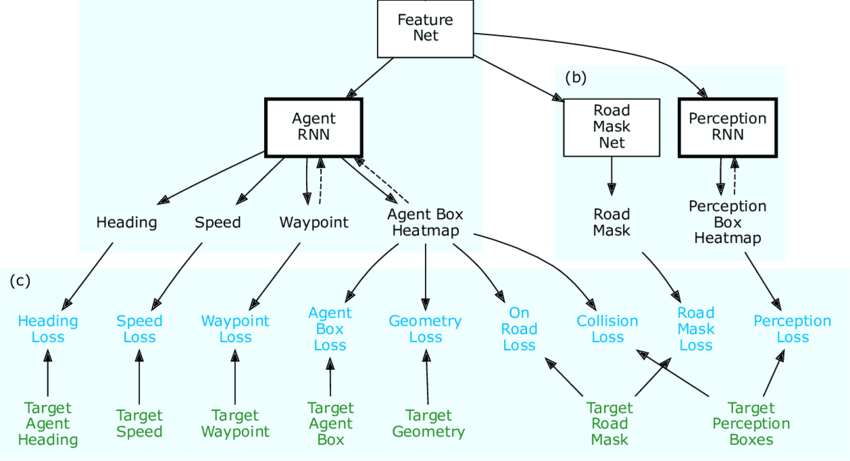

Autonomiczne samochody to inteligentne systemy decyzyjne! Wykorzystują kamery, LiDAR, RADAR, GPS i czujniki bezwładnościowe do gromadzenia danych o swoim otoczeniu. Następnie specjalne algorytmy, w tym głębokie uczenie, analizują te dane, aby zrozumieć dynamikę otoczenia. Dzięki tej wiedzy samochód podejmuje kluczowe decyzje dotyczące bezpiecznej i płynnej jazdy.

Źródło: arxiv.org

Źródło: arxiv.org

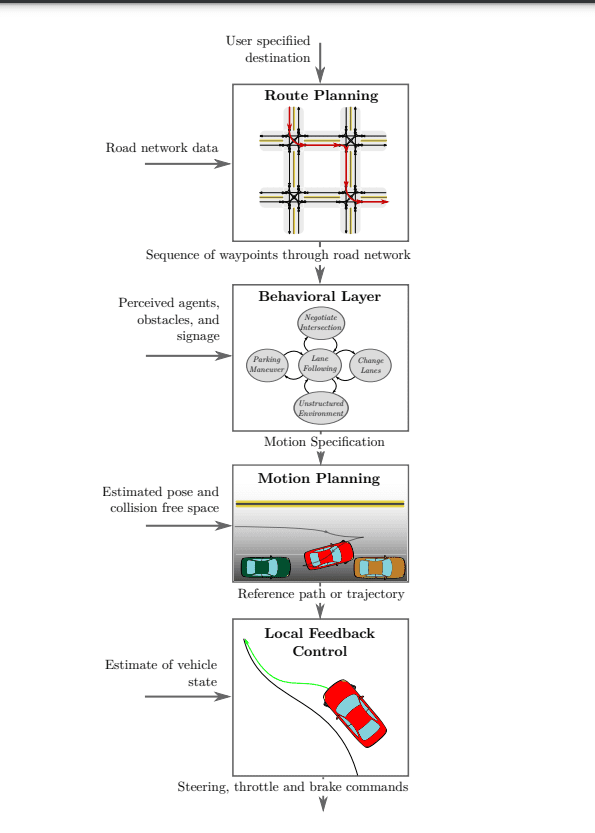

Aby zrozumieć, jak dokładnie działają samochody autonomiczne, przyjrzyjmy się bliżej czterem podstawowym elementom przedstawionym na powyższym schemacie. Ich zrozumienie pozwoli nam poznać złożoność działania tych niesamowitych pojazdów:

- Percepcja

- Lokalizacja

- Prognozowanie

- Podejmowanie decyzji

- Planowanie trasy na poziomie strategicznym

- Arbitraż zachowania

- Kontrola ruchu

Percepcja

#1. Kamera

Kamery są kluczowymi „oczami” samochodu autonomicznego, umożliwiając mu orientację w przestrzeni. Ich zadaniem jest zbieranie informacji o otoczeniu, dokonywanie segmentacji obrazu i ustalanie pozycji pojazdu.

Aby zapewnić kompleksowy obraz, kamery są umieszczone z przodu, z tyłu oraz po bokach auta. Współpracując, tworzą panoramiczny widok otoczenia. To tak, jakby samochód miał specjalny system widzenia 360 stopni!

Kamery te pełnią różnorodne funkcje. Niektóre z nich mają szerokie pole widzenia, sięgające nawet 200 metrów, aby samochód mógł przewidywać sytuację na drodze. Inne z kolei koncentrują się na obiektach znajdujących się w pobliżu, umożliwiając analizę szczegółów. Działając wspólnie, kamery dostarczają pełen obraz sytuacji, pomagając samochodowi podejmować trafne decyzje i bezpiecznie prowadzić.

Kamery są szczególnie pomocne podczas parkowania, zapewniając szeroki widok i ułatwiając podejmowanie precyzyjnych manewrów.

Jednak używanie wyłącznie kamer do postrzegania otoczenia może stanowić problem, zwłaszcza w niesprzyjających warunkach atmosferycznych, takich jak mgła, intensywny deszcz czy noc. W takich okolicznościach obrazy z kamer mogą być nieczytelne i zaszumione, co może stwarzać zagrożenie.

Aby poradzić sobie z tymi wyzwaniami, konieczne jest zastosowanie specjalnych czujników, które będą działać w ciemności lub nawet w całkowitej ciemności. Powinny one również mierzyć odległość od obiektów bez konieczności używania światła. W połączeniu z kamerami (system percepcji), samochód będzie lepiej radził sobie w trudnych warunkach, zapewniając bezpieczeństwo wszystkim uczestnikom ruchu drogowego.

#2. LiDAR

LiDAR, czyli wykrywanie i określanie odległości za pomocą światła, to innowacyjna technologia wykorzystująca lasery do precyzyjnego pomiaru dystansu. LiDAR emituje wiązki laserowe i mierzy czas ich powrotu.

Współpraca LiDAR z kamerami umożliwia samochodowi pełniejsze zrozumienie otoczenia. LiDAR tworzy trójwymiarową mapę, którą następnie analizują inteligentne algorytmy, pomagając samochodowi przewidywać ruch innych pojazdów. Jest to szczególnie przydatne na ruchliwych skrzyżowaniach, gdzie samochód może monitorować zachowanie innych uczestników ruchu i bezpiecznie manewrować.

LiDAR ma jednak pewne ograniczenia. Chociaż doskonale radzi sobie w nocy i w ciemności, może mieć trudności w deszczu lub we mgle, co może prowadzić do nieprecyzyjnych pomiarów. Dlatego też, w celu zwiększenia niezawodności, stosuje się czujniki LiDAR w połączeniu z RADARem. Te dodatkowe dane umożliwiają samochodowi dokładniejsze zrozumienie sytuacji i bezpieczną jazdę.

#3. RADAR

RADAR, czyli radiowe wykrywanie i określanie odległości, to technologia szeroko stosowana w życiu codziennym, w tym w wojsku. Pierwotnie RADAR wykorzystywany był do lokalizowania obiektów za pomocą fal radiowych. Obecnie RADAR jest kluczowym elementem wielu pojazdów, zwłaszcza autonomicznych.

RADAR charakteryzuje się odpornością na różne warunki pogodowe i oświetleniowe. Wykorzystuje on fale radiowe, co czyni go bardzo elastycznym. RADAR to czujnik „zakłóceniowy”, co oznacza, że może wykrywać obiekty nawet wtedy, gdy nie są one widoczne dla kamer.

Mózg autonomicznego samochodu może zostać zdezorientowany nadmiarem danych z RADARU, które określamy „szumem”. Aby to skorygować, samochód musi „oczyścić” informacje, aby podejmować właściwe decyzje.

Czyszczenie danych polega na rozróżnianiu mocnych i słabych sygnałów, czyli oddzieleniu istotnych informacji od mniej ważnych. Samochód wykorzystuje w tym celu transformatę Fouriera (FFT), która umożliwia jeszcze dokładniejszą analizę.

RADAR i LiDAR dostarczają informacje w postaci pojedynczych punktów. Aby je lepiej zrozumieć, samochód wykorzystuje grupowanie. To tak, jakby łączyć podobne elementy w zbiory. Samochód stosuje w tym celu metody statystyczne, takie jak grupowanie euklidesowe lub K-średnich, co pozwala na bezpieczne i efektywne prowadzenie pojazdu.

Lokalizacja

W samochodach autonomicznych algorytmy lokalizacji pełnią istotną funkcję w określaniu pozycji i orientacji pojazdu podczas nawigacji. Jest to znane jako odometria wizualna (VO). Funkcja VO polega na identyfikowaniu i dopasowywaniu kluczowych punktów w kolejnych klatkach wideo.

Samochód analizuje specjalne punkty, które przypominają znaki na mapie. Następnie wykorzystuje statystyki SLAM, aby ustalić położenie i ruch obiektów. Dzięki temu auto wie, gdzie znajdują się drogi i inni użytkownicy.

Aby jeszcze bardziej zwiększyć dokładność, samochód korzysta z głębokiego uczenia. To jak superinteligentny komputer.

Te zaawansowane techniki umożliwiają samochodowi bardzo dokładne zrozumienie otoczenia. Sieci neuronowe, takie jak PoseNet i VLocNet++, wykorzystują dane punktowe do szacowania pozycji 3D i orientacji obiektów. Te szacunkowe pozycje i orientacje 3D można następnie wykorzystać do uzyskania semantyki sceny. Dzięki wykorzystaniu zaawansowanej matematyki i informatyki, auto dokładnie wie, gdzie się znajduje i co je otacza. Pozwala to na bezpieczną i płynną jazdę.

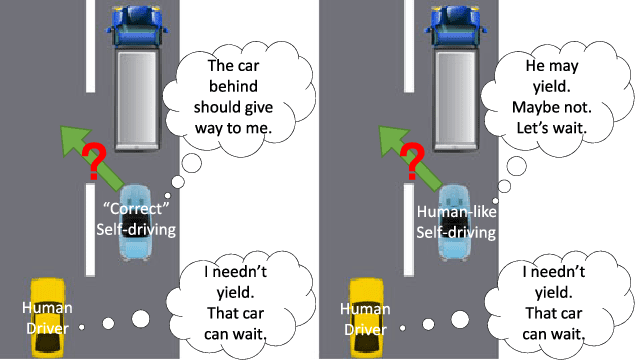

Prognozowanie

Zrozumienie intencji ludzkich kierowców jest bardzo trudne, ponieważ ich zachowanie często wynika z emocji, a nie tylko logiki. Ponieważ nie jesteśmy w stanie przewidzieć działań innych kierowców, niezwykle ważne jest, aby samochody autonomiczne potrafiły skutecznie prognozować zachowanie innych uczestników ruchu drogowego. Ma to kluczowe znaczenie dla bezpieczeństwa na drodze.

Wyobraźmy sobie, że autonomiczne auta mają oczy dookoła, umożliwiając widok 360 stopni. Dzięki temu mogą rejestrować wszystko, co się dzieje. Te informacje są następnie wykorzystywane w procesie głębokiego uczenia się. Samochód używa zaawansowanych technik, aby przewidywać zachowanie innych kierowców. To jak gra, w której musisz dobrze zaplanować swoje ruchy.

Przewidywanie przy użyciu głębokiego uczenia się

Przewidywanie przy użyciu głębokiego uczenia się

Specjalne czujniki w autonomicznych autach działają jak ich oczy. Pomagają one samochodom rozpoznawać obiekty na obrazach, określać ich położenie i przewidywać ruch. Dzięki temu samochód wie, co znajduje się w pobliżu i może podejmować trafne decyzje.

Podczas procesu szkolenia algorytmy głębokiego uczenia analizują złożone dane z obrazów, LiDAR-a i RADAR-a. Podczas jazdy (wnioskowania) ten sam model pozwala samochodowi przygotować się na ewentualne manewry, takie jak hamowanie, zatrzymywanie, zwalnianie, zmiana pasa ruchu i inne.

Głębokie uczenie jest jak inteligentny asystent w samochodzie. Pozwala mu interpretować dane, określać pozycję i usprawniać jazdę. Dzięki temu podróż jest bezpieczniejsza i bardziej komfortowa.

Jednak najtrudniejszą częścią jest wybór najlepszego działania spośród wielu możliwości. Podjęcie trafnych decyzji wymaga szczegółowej analizy, aby samochód mógł prowadzić bezpiecznie.

Podejmowanie decyzji

Samochody autonomiczne muszą podejmować ważne decyzje w skomplikowanych sytuacjach, co nie jest łatwe. Dzieje się tak, ponieważ czujniki nie zawsze działają idealnie, a ludzie na drodze mogą zachowywać się nieprzewidywalnie. Auto musi prognozować zachowanie innych i podjąć odpowiednie działania, aby uniknąć kolizji.

Aby podjąć właściwą decyzję, samochód potrzebuje mnóstwa informacji. Auto zbiera te dane za pomocą czujników, a następnie wykorzystuje algorytmy głębokiego uczenia, aby określić położenie obiektów i przewidzieć potencjalne zdarzenia. Lokalizacja pozwala określić początkową pozycję, a prognozowanie generuje różne scenariusze w oparciu o otoczenie.

Pozostaje pytanie: jak auto wybiera najlepsze działanie spośród wielu opcji?

Źródło: semanticscholar.org

Źródło: semanticscholar.org

Uczenie przez głębokie wzmacnianie (DRL) to technika podejmowania decyzji, która wykorzystuje proces decyzyjny Markowa (MDP). MDP pomaga w prognozowaniu, jak mogą zachowywać się inni użytkownicy dróg. Im więcej obiektów znajduje się w otoczeniu, tym sytuacja staje się bardziej skomplikowana. Samochód autonomiczny musi wtedy analizować więcej potencjalnych działań.

Aby poradzić sobie z wyzwaniem znalezienia najlepszej strategii działania, model głębokiego uczenia jest optymalizowany za pomocą optymalizacji Bayesa. Czasami do podejmowania decyzji wykorzystuje się strukturę łączącą ukryty model Markowa i optymalizację Bayesa, co umożliwia autonomicznemu samochodowi efektywną i bezpieczną nawigację w różnych złożonych sytuacjach.

Źródło: arxiv.org

Źródło: arxiv.org

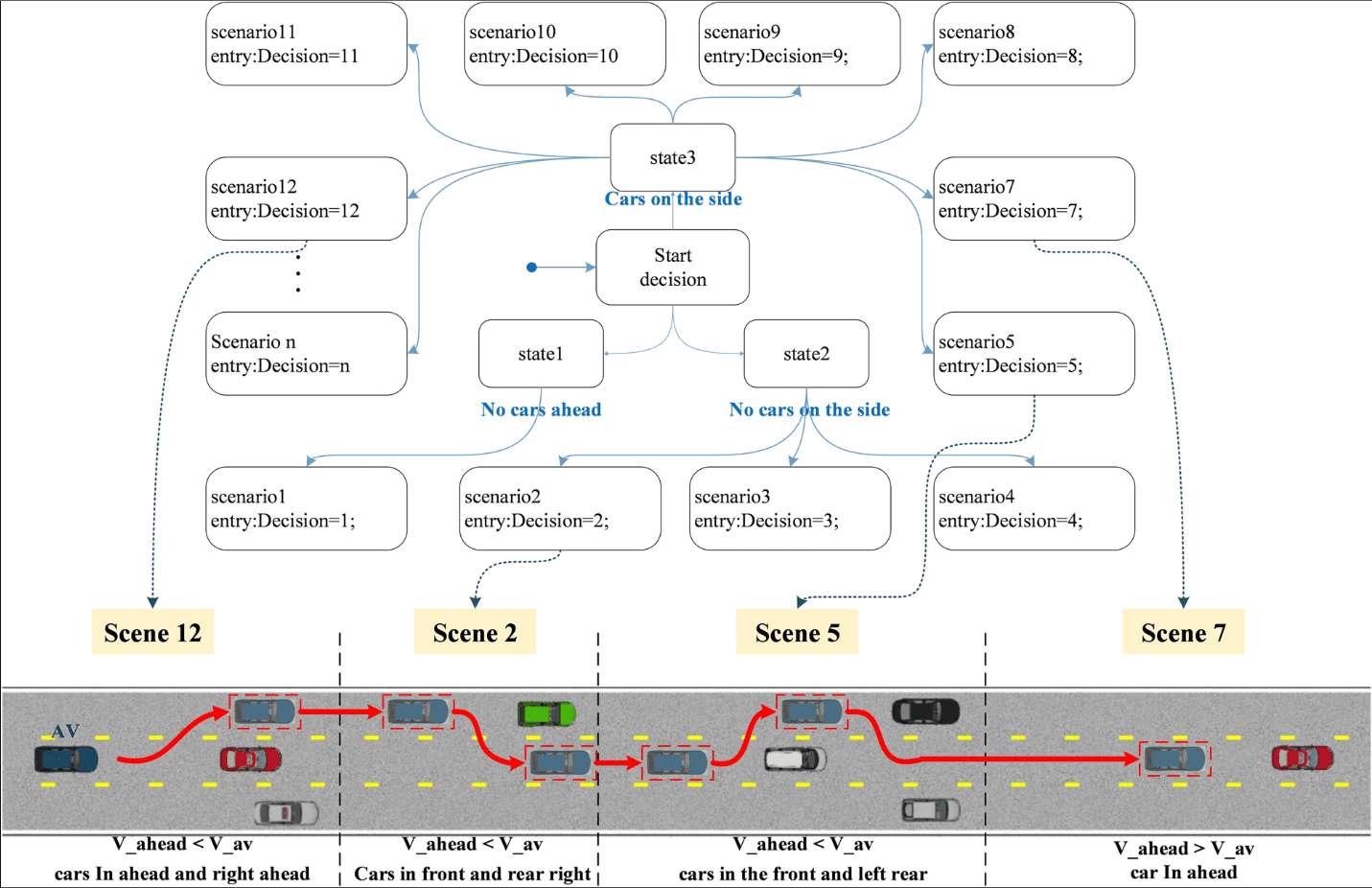

Podejmowanie decyzji w autonomicznych samochodach odbywa się w sposób hierarchiczny, z podziałem na cztery kluczowe elementy:

Planowanie trasy: Na początku podróży samochód wyznacza najkorzystniejszą trasę z aktualnej pozycji do miejsca docelowego. Celem jest wybór optymalnego rozwiązania spośród wielu możliwości.

Arbitraż zachowania: Po ustaleniu trasy samochód musi nią nawigować. Auto rozpoznaje statyczne obiekty, takie jak drogi i skrzyżowania, ale nie jest w stanie przewidzieć zachowania innych kierowców. Aby poradzić sobie z tą niepewnością, stosuje się inteligentne metody, takie jak procesy decyzyjne Markowa (MDP).

Scenariusz decyzji najwyższej maszyny stanu

Scenariusz decyzji najwyższej maszyny stanu

Planowanie ruchu: Dysponując trasą i warstwą behawioralną, system planowania ruchu koordynuje ruchy samochodu. Ma to na celu zapewnienie bezpiecznej i komfortowej jazdy. System bierze pod uwagę takie czynniki, jak prędkość, zmiana pasa i otoczenie.

Sterowanie pojazdem: Ostatnim krokiem jest sterowanie pojazdem zgodnie ze ścieżką wygenerowaną przez system planowania ruchu. Zapewnia to płynną i bezpieczną jazdę po zamierzonej trajektorii.

Dzięki podziałowi procesu decyzyjnego na te etapy, autonomiczne samochody mogą jeździć sprawnie i bezpiecznie w złożonych warunkach. Pasażerowie mogą cieszyć się komfortową i płynną podróżą.

Konwolucyjne sieci neuronowe

Konwolucyjne sieci neuronowe (CNN) są powszechnie wykorzystywane w samochodach autonomicznych ze względu na ich zdolność do modelowania danych przestrzennych, zwłaszcza obrazów. CNN doskonale radzą sobie z wydobywaniem istotnych cech z obrazów, co jest kluczowe w wielu aplikacjach.

W CNN, wraz ze wzrostem głębokości sieci, poszczególne warstwy rejestrują różne wzorce. Wcześniejsze warstwy analizują proste cechy, takie jak krawędzie, a głębsze warstwy identyfikują bardziej złożone obiekty, np. liście drzew lub opony samochodowe. Dzięki temu CNN stanowią podstawowy algorytm w samochodach autonomicznych.

Podstawowym elementem CNN jest warstwa splotowa, która wykorzystuje tzw. jądro splotowe (macierz filtrów) do przetwarzania lokalnych obszarów obrazu wejściowego.

Macierz filtrów jest aktualizowana podczas procesu uczenia w celu uzyskania znaczących wag. Kluczową cechą sieci CNN jest podział wag, gdzie te same parametry są używane do reprezentowania różnych transformacji. Pozwala to oszczędzać zasoby obliczeniowe i umożliwia różnorodne reprezentacje cech.

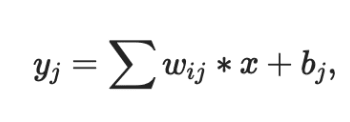

Wyjście warstwy splotowej jest zazwyczaj przepuszczane przez nieliniową funkcję aktywacji, taką jak Sigmoid, Tanh lub ReLU. Najczęściej wybierany jest ReLU, ponieważ zapewnia szybszą zbieżność. Ponadto wynik często przechodzi przez warstwę maksymalnego łączenia. Pomaga to w zachowaniu najważniejszych detali obrazu, takich jak tło i tekstury.

Trzy fundamentalne właściwości CNN czynią je uniwersalnymi i niezastąpionymi w samochodach autonomicznych:

- Lokalne pola recepcyjne

- Wspólne ciężary

- Próbkowanie przestrzenne

Właściwości te redukują nadmierne dopasowanie i zachowują kluczowe reprezentacje i cechy ważne dla klasyfikacji, segmentacji, lokalizacji i analizy obrazów.

Oto dwie sieci CNN, z których korzystają firmy zajmujące się rozwojem autonomicznych aut:

- HydraNet firmy Tesla

- ChauffeurNet firmy Google Waymo

Dowiedz się więcej o konwolucyjnych sieciach neuronowych.

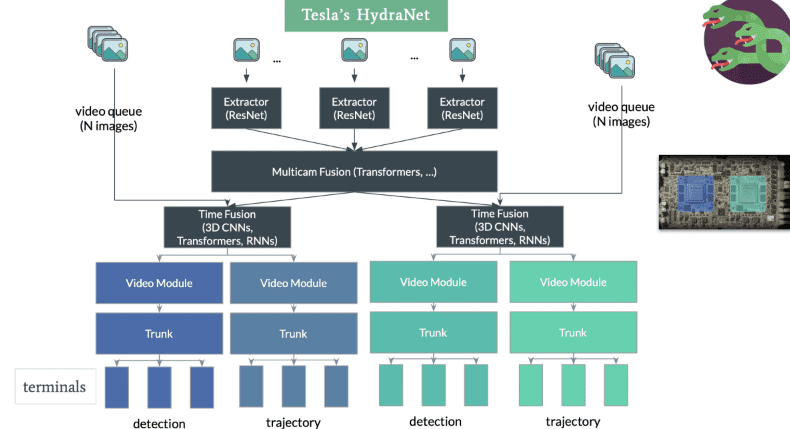

#1. HydraNet firmy Tesla

HydraNet to dynamiczna architektura, którą Ravi i in. przedstawili w 2018 roku. Została ona opracowana głównie z myślą o segmentacji semantycznej w autonomicznych autach. Jej głównym celem jest poprawa efektywności obliczeniowej podczas wnioskowania.

Koncepcja HydraNet zakłada przypisanie różnych sieci CNN, zwanych gałęziami, do określonych zadań. Każda gałąź otrzymuje różne dane wejściowe, a sieć może selektywnie wybierać, które gałęzie będą uruchamiane podczas wnioskowania. Wyniki z różnych gałęzi są następnie łączone w celu podjęcia ostatecznej decyzji.

W kontekście autonomicznych aut, dane wejściowe mogą przedstawiać różne aspekty otoczenia, takie jak obiekty statyczne (drzewa, bariery), drogi, pasy ruchu, sygnalizacja świetlna, itp. Te dane wejściowe są analizowane w osobnych gałęziach. Podczas wnioskowania mechanizm decyduje, które gałęzie aktywować, a moduł łączący zbiera dane w celu podjęcia ostatecznej decyzji.

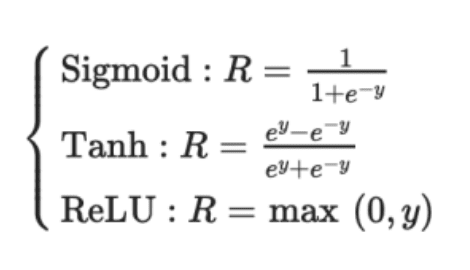

Wykrywanie prędkości, pasa ruchu i ruchu

Wykrywanie prędkości, pasa ruchu i ruchu

Tesla dostosowała architekturę HydraNet, włączając współdzielony szkielet, aby sprostać wyzwaniom związanym z segregacją danych. Wspólny szkielet, zwykle zmodyfikowane bloki ResNet-50, umożliwia uczenie sieci na danych wszystkich obiektów. Nagłówki specyficzne dla zadań, oparte na architekturze segmentacji semantycznej, takiej jak U-Net, umożliwiają modelowi przewidywanie wyników specyficznych dla danego zadania.

HydraNet Tesli charakteryzuje się możliwością wyświetlania widoku z lotu ptaka, tworząc trójwymiarową reprezentację środowiska pod dowolnym kątem. Ta zwiększona perspektywa wspomaga nawigację. Co ciekawe, Tesla osiąga to bez użycia czujników LiDAR. Zamiast tego opiera się jedynie na dwóch czujnikach: kamerze i radarze. Wydajność HydraNet pozwala na przetwarzanie danych z ośmiu kamer i generowanie percepcji głębi, co jest imponującym osiągnięciem bez konieczności stosowania dodatkowej technologii LiDAR.

#2. ChauffeurNet firmy Google Waymo

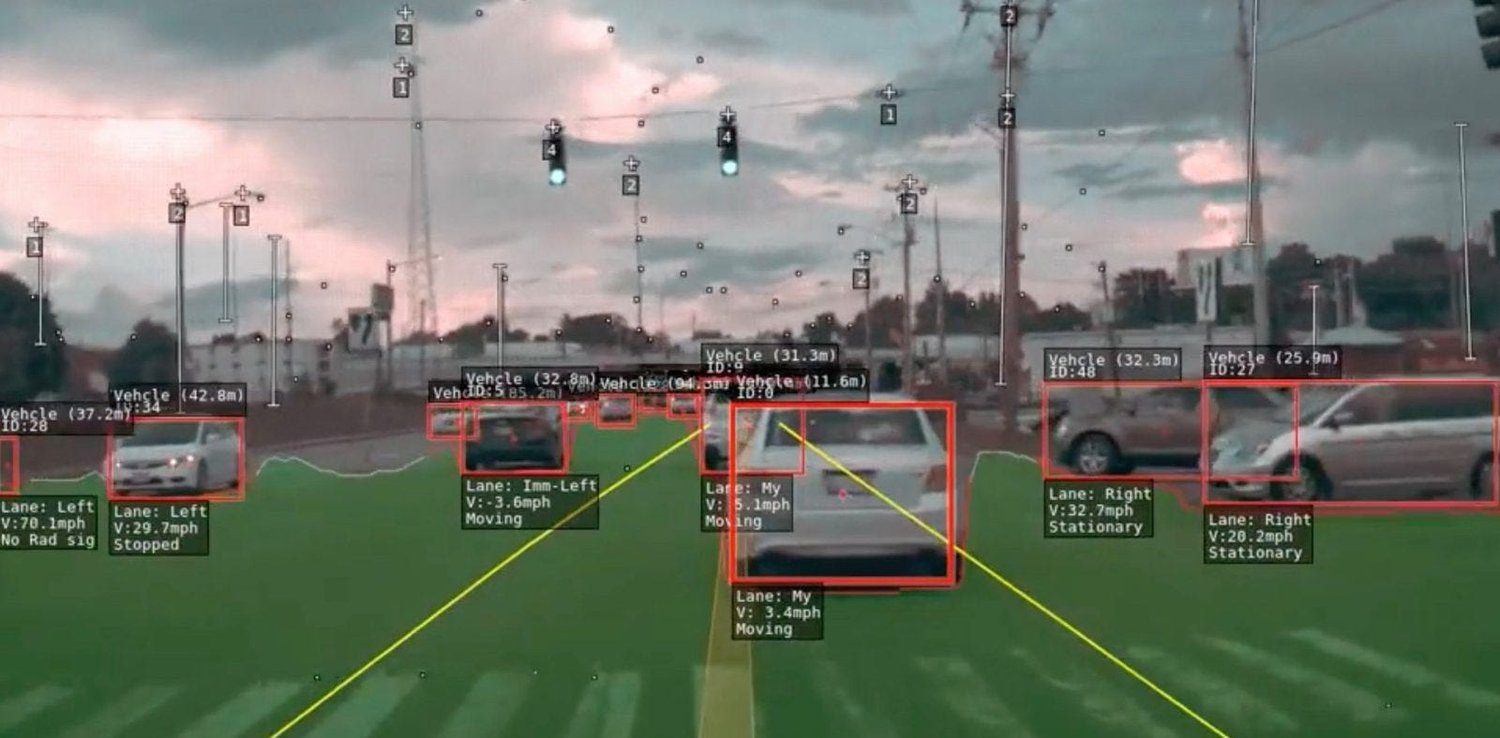

ChauffeurNet to sieć neuronowa oparta na RNN, wykorzystywana przez Google Waymo do szkolenia autonomicznych samochodów za pomocą uczenia przez naśladowanie. Chociaż do generowania trajektorii jazdy opiera się głównie na RNN, zawiera również komponent CNN znany jako FeatureNet.

Ta splotowa sieć wydobywa kontekstowe reprezentacje cech, które są wspólne dla innych sieci. FeatureNet służy do wyodrębniania cech z systemu percepcji.

Źródło: Brama badawcza

Źródło: Brama badawcza

Koncepcja ChauffeurNet polega na uczeniu autonomicznego samochodu poprzez naśladowanie doświadczonych kierowców z wykorzystaniem uczenia przez naśladowanie. Aby przezwyciężyć ograniczenia wynikające z niewystarczającej ilości rzeczywistych danych szkoleniowych, autorzy artykułu „ChauffeurNet: Learning to Drive by Imitating the Best and Synthesizing the Worst” wprowadzili dane syntetyczne.

Te syntetyczne dane wprowadzają różne odchylenia, takie jak zaburzanie trajektorii, dodawanie przeszkód i tworzenie nienaturalnych scen. Stwierdzono, że trenowanie samochodu z wykorzystaniem danych syntetycznych jest bardziej skuteczne niż używanie wyłącznie danych rzeczywistych.

W ChauffeurNet system percepcji nie jest częścią kompleksowego procesu, ale działa jako system średniego poziomu. Dzięki temu sieć może przyjmować różne warianty danych wejściowych z systemu percepcji. Sieć analizuje średniopoziomową reprezentację sceny z czujników i, wykorzystując te dane w połączeniu z danymi syntetycznymi, naśladuje zachowanie doświadczonego kierowcy.

Poprzez uwzględnienie zadania percepcji i tworzenie widoku otoczenia z lotu ptaka, ChauffeurNet umożliwia łatwiejsze uczenie transferowe, pozwalając sieci podejmować lepsze decyzje na podstawie danych rzeczywistych i symulowanych. Sieć generuje trajektorie jazdy poprzez iteracyjne przewidywanie kolejnych punktów na ścieżce jazdy. Takie podejście okazało się obiecujące w szkoleniu autonomicznych aut, otwierając drogę do bezpieczniejszych i bardziej niezawodnych systemów jazdy autonomicznej.

#3. Częściowo obserwowalny proces decyzyjny Markowa stosowany w samochodach autonomicznych

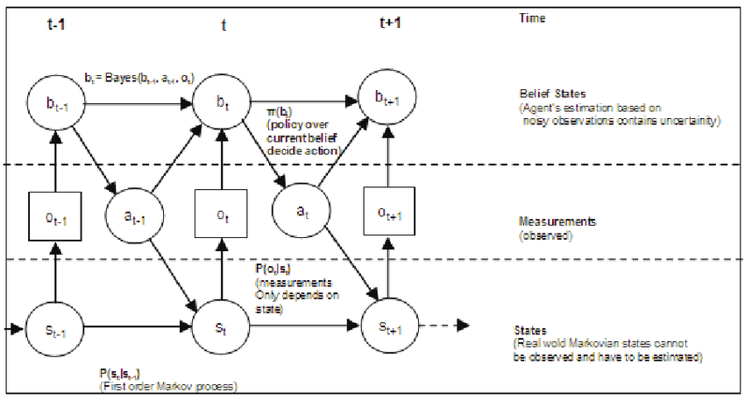

Częściowo obserwowalny proces decyzyjny Markowa (POMDP) to struktura matematyczna, którą wykorzystuje się w kontekście autonomicznych samochodów do podejmowania decyzji w warunkach niepewności. W rzeczywistych warunkach samochody autonomiczne często dysponują ograniczoną ilością informacji o otoczeniu z powodu zakłóceń czujników, zasłonięć lub niedoskonałych systemów percepcji. POMDP został zaprojektowany tak, aby radzić sobie z tą częściową obserwowalnością i podejmować optymalne decyzje, uwzględniając zarówno niepewność, jak i dostępne obserwacje.

W POMDP agent decyzyjny działa w środowisku o stanach częściowo obserwowalnych. Agent podejmuje działanie, a środowisko zmienia swój stan w sposób probabilistyczny. Agent otrzymuje jednak tylko częściowe lub zaszumione informacje o rzeczywistym stanie środowiska. Celem jest znalezienie strategii, która maksymalizuje oczekiwane zyski w czasie, biorąc pod uwagę niepewność otoczenia i obserwacje agenta.

Źródło: Brama badawcza

Źródło: Brama badawcza

W kontekście autonomicznych samochodów POMDP jest szczególnie przydatny w zadaniach takich jak planowanie ruchu, prognozowanie trajektorii i interakcja z innymi użytkownikami dróg. Autonomiczne auto może wykorzystywać POMDP do podejmowania decyzji dotyczących zmiany pasa ruchu, dostosowania prędkości oraz interakcji z pieszymi i innymi pojazdami, uwzględniając niepewność otoczenia.

POMDP składa się z sześciu elementów, co można oznaczyć jako POMDP

M:= (I, S, A, R, P, γ)

Gdzie,

Ja: Obserwacje

S: Skończony zbiór stanów

O: Skończony zbiór działań

R: Funkcja nagrody

P: Funkcja prawdopodobieństwa przejścia

γ: współczynnik dyskontujący przyszłe nagrody.

POMDP mogą być wyzwaniem obliczeniowym ze względu na konieczność uwzględniania wielu możliwych stanów i obserwacji. Stosuje się w tym celu zaawansowane algorytmy, takie jak planowanie przestrzeni przekonań i metody Monte Carlo, aby efektywnie przybliżyć optymalną strategię i umożliwić podejmowanie decyzji w czasie rzeczywistym w autonomicznych samochodach.

Dzięki wykorzystaniu POMDP w algorytmach podejmowania decyzji, autonomiczne samochody mogą skuteczniej i bezpieczniej poruszać się w złożonych warunkach, uwzględniając niepewność odczytów czujników i podejmując świadome decyzje w celu osiągnięcia zamierzonych celów.

Autonomiczny samochód, jako agent, uczy się poprzez interakcję z otoczeniem za pomocą uczenia przez wzmacnianie (RL), które jest rodz

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.