Ludzkie języki stanowią wyzwanie dla maszyn, z powodu swojej złożoności, zawierającej skróty, niuanse znaczeniowe, gramatykę, kontekst, slang i wiele innych aspektów.

Jednakże, wiele operacji biznesowych i procesów wykorzystuje technologie, co prowadzi do konieczności interakcji między ludźmi a maszynami.

Dlatego też, naukowcy dążyli do stworzenia technologii, która umożliwiłaby maszynom analizę ludzkich języków i ułatwiła im proces uczenia.

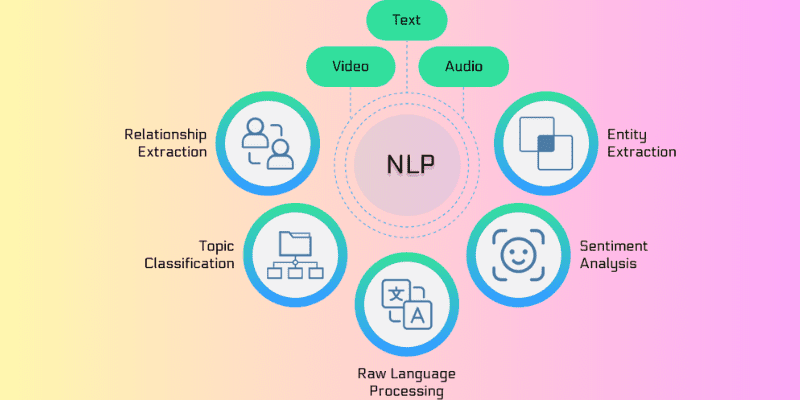

W odpowiedzi na te potrzeby narodziło się przetwarzanie języka naturalnego, czyli NLP. Algorytmy NLP sprawiły, że oprogramowanie komputerowe stało się zdolne do interpretowania różnych języków, zarówno w formie pisemnej, jak i mówionej.

NLP opiera się na różnorodnych algorytmach przetwarzania językowego. Wraz z ich rozwojem, technologia ta stała się kluczowym elementem sztucznej inteligencji (AI), usprawniając analizę nieustrukturyzowanych danych.

W tym artykule zagłębimy się w świat NLP, omawiając jego działanie oraz przedstawiając najczęściej stosowane algorytmy.

Zacznijmy!

Czym jest NLP?

Przetwarzanie języka naturalnego (NLP) to dziedzina łącząca informatykę, lingwistykę i sztuczną inteligencję, skoncentrowana na interakcjach między językiem ludzkim a komputerami. Celem NLP jest umożliwienie maszynom analizowania i przetwarzania dużych zbiorów danych w języku naturalnym.

Mówiąc prościej, NLP to nowoczesna technologia, która pozwala maszynom rozumieć, analizować i interpretować ludzki język. Dzięki NLP, komputery potrafią przetwarzać zarówno tekst pisany, jak i mowę. Otwiera to drogę do tłumaczeń, rozpoznawania mowy, podsumowywania tekstów, segmentacji tematycznej oraz wielu innych zadań wykonywanych przez maszyny w imieniu programistów.

Istotne jest, że NLP działa w czasie rzeczywistym, wykorzystując zaawansowane algorytmy, co znacząco podnosi jego efektywność. Technologia ta łączy uczenie maszynowe, uczenie głębokie oraz modele statystyczne z modelowaniem obliczeniowym opartym na zasadach językowych.

Algorytmy NLP umożliwiają komputerom przetwarzanie danych językowych, zarówno tekstowych, jak i głosowych, i interpretowanie ich znaczenia w różnych kontekstach. Rozwój w tej dziedzinie jest tak zaawansowany, że maszyny potrafią nawet rozpoznawać emocje i intencje ukryte w tekście. NLP ma również zdolność przewidywania kolejnych słów lub zdań, które mogą pojawić się podczas pisania lub mówienia.

Technologia ta, rozwijana przez dziesięciolecia, osiągnęła imponujący poziom precyzji. NLP wywodzi się z lingwistyki i odegrało istotną rolę w rozwoju wyszukiwarek internetowych. Z czasem, wraz z postępem technologicznym, zakres zastosowań NLP znacznie się poszerzył.

Obecnie NLP znajduje zastosowanie w wielu sektorach, od finansów, wyszukiwarek i analiz biznesowych, po opiekę zdrowotną i robotykę. Co więcej, NLP jest szeroko wykorzystywane w nowoczesnych systemach, w tym w nawigacji GPS sterowanej głosem, chatbotach obsługi klienta, cyfrowych asystentach, systemach zamiany mowy na tekst i wielu innych.

Jak działa NLP?

NLP to dynamicznie rozwijająca się dziedzina, wykorzystująca różnorodne metody do przekształcania złożonego języka ludzkiego na formę zrozumiałą dla maszyn. Kluczową rolę odgrywa tutaj sztuczna inteligencja, która pomaga w przetwarzaniu i tłumaczeniu słów pisanych oraz mówionych na dane zrozumiałe dla komputerów.

Podobnie jak ludzie posiadają mózg do przetwarzania bodźców, komputery korzystają ze specjalistycznego oprogramowania. Proces konwersji w NLP odbywa się w dwóch fazach: przetwarzanie danych oraz tworzenie algorytmów.

Przetwarzanie danych stanowi pierwszy etap, gdzie tekst wejściowy jest przygotowywany i oczyszczany, aby mógł zostać przeanalizowany przez maszynę. Dane są modyfikowane w taki sposób, aby uwzględnić wszystkie cechy tekstu, czyniąc go odpowiednim dla komputerowych algorytmów. W rezultacie, etap ten przygotowuje dane w formie zrozumiałej dla maszyn.

Techniki stosowane w tej fazie to:

- Tokenizacja: Tekst wejściowy jest dzielony na mniejsze jednostki, aby algorytm NLP mógł na nich operować.

- Usuwanie słów stop: Technika ta eliminuje z tekstu powszechnie występujące słowa, przekształcając go w formę, która zachowuje kluczowe informacje.

- Lematyzacja i stemming: Słowa są redukowane do ich podstawowej formy (lemat) lub rdzenia (stem), co ułatwia ich przetwarzanie przez maszyny.

- Oznaczanie części mowy: Słowa są klasyfikowane jako rzeczowniki, przymiotniki, czasowniki itp., co umożliwia ich dalszą analizę.

Po przejściu przez fazę przetwarzania danych, maszyna tworzy algorytm, który umożliwia jej przetwarzanie danych. Wśród algorytmów NLP, najczęściej wykorzystywane są systemy oparte na regułach oraz systemy wykorzystujące uczenie maszynowe:

- Systemy oparte na regułach: Wykorzystują zdefiniowane reguły językowe do przetwarzania tekstu. Jest to starsza metoda, wciąż stosowana w wielu aplikacjach.

- Systemy oparte na uczeniu maszynowym: To zaawansowane algorytmy, które łączą sieci neuronowe, uczenie głębokie i uczenie maszynowe. Ustalają one własne reguły przetwarzania na podstawie danych treningowych i dostosowują się w miarę rozwoju.

Kategorie algorytmów NLP

Algorytmy NLP to zbiór instrukcji opartych na uczeniu maszynowym, które umożliwiają komputerom analizę i interpretację języka ludzkiego. Służą do tworzenia protokołów i modeli, dzięki którym maszyny potrafią zrozumieć ludzką mowę.

Algorytmy NLP dostosowują się do specyfiki danych treningowych oraz przyjętego podejścia sztucznej inteligencji. Ich głównym zadaniem jest przekształcenie nieustrukturyzowanych danych wejściowych w zrozumiałe informacje, które mogą być wykorzystane przez maszyny w procesie uczenia.

Algorytmy NLP, w oparciu o zasady języka naturalnego, pomagają maszynom zrozumieć kontekst danych wejściowych. Bez tej zdolności, maszyna nie byłaby w stanie prawidłowo zinterpretować i zrealizować żądania użytkownika.

Algorytmy NLP dzielą się na trzy główne kategorie, a wybór odpowiedniej zależy od strategii analizy danych:

#1. Algorytmy symboliczne

Algorytmy symboliczne są jednym z fundamentów NLP. Zajmują się analizą znaczenia tekstu wejściowego, a następnie wykorzystaniem tej wiedzy do określania relacji między różnymi pojęciami.

Algorytmy symboliczne wykorzystują symbole do reprezentowania wiedzy oraz relacji między pojęciami. Poprzez zastosowanie logiki i przypisywanie znaczenia słowom w oparciu o kontekst, algorytmy te mogą osiągnąć wysoki stopień precyzji.

Grafy wiedzy odgrywają kluczową rolę w definiowaniu pojęć języka wejściowego oraz powiązań między nimi. Dzięki zdolności precyzyjnego definiowania pojęć i interpretacji kontekstu słów, algorytmy symboliczne wspierają rozwój XAI (Explainable AI).

Jednakże, ze względu na ograniczenia, algorytmy symboliczne mogą być trudne do rozszerzenia o nowe reguły.

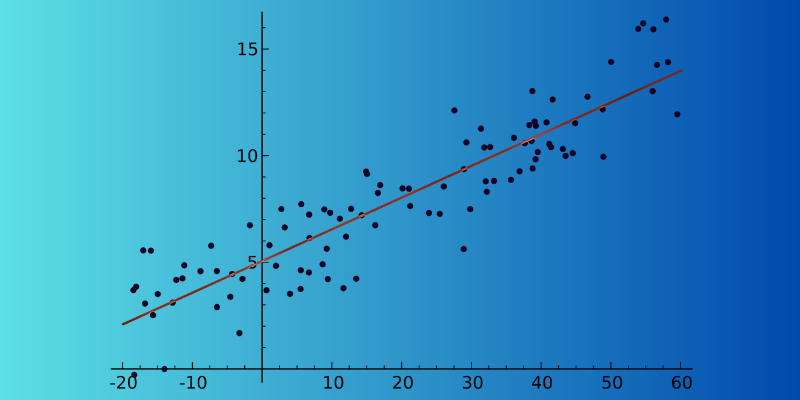

#2. Algorytmy statystyczne

Algorytmy statystyczne umożliwiają maszynom analizę tekstu, zrozumienie jego zawartości i wydobycie znaczenia. To bardzo skuteczna metoda, ponieważ pomaga maszynom uczyć się ludzkiego języka poprzez rozpoznawanie wzorców i trendów w danych wejściowych. Dzięki temu maszyny mogą przewidywać kolejne słowa w zdaniu w czasie rzeczywistym.

Algorytmy statystyczne są szeroko stosowane w wielu aplikacjach, takich jak rozpoznawanie mowy, analiza nastrojów, tłumaczenie maszynowe oraz sugerowanie tekstu. Ich popularność wynika z możliwości pracy na dużych zbiorach danych.

Ponadto, algorytmy statystyczne potrafią rozpoznać, czy dwa zdania mają podobne znaczenie i wybrać właściwe. Główną wadą tej metody jest jej zależność od złożonej inżynierii cech.

#3. Algorytmy hybrydowe

Algorytmy hybrydowe łączą zalety algorytmów symbolicznych i statystycznych, dążąc do osiągnięcia jak najlepszych rezultatów. Dzięki synergii obu podejść, algorytmy te mogą minimalizować słabości każdego z nich, co jest niezbędne dla wysokiej precyzji.

Istnieje wiele sposobów łączenia tych dwóch podejść:

- Symboliczne wsparcie dla uczenia maszynowego.

- Uczenie maszynowe wspierające algorytmy symboliczne.

- Równoczesne działanie obu podejść.

Algorytmy symboliczne mogą wspierać uczenie maszynowe, pomagając w trenowaniu modeli, tak aby wymagały mniej wysiłku w samodzielnej nauce języka. Z kolei uczenie maszynowe może pomóc w tworzeniu początkowego zestawu reguł dla algorytmów symbolicznych, oszczędzając naukowcom konieczności manualnego ich opracowywania.

Współpraca obu podejść prowadzi do lepszych rezultatów, gdyż zapewnia poprawne zrozumienie danego fragmentu tekstu.

Najlepsze algorytmy NLP

Istnieje wiele algorytmów NLP, które pomagają komputerom imitować ludzki język w celu jego zrozumienia. Oto najpopularniejsze z nich:

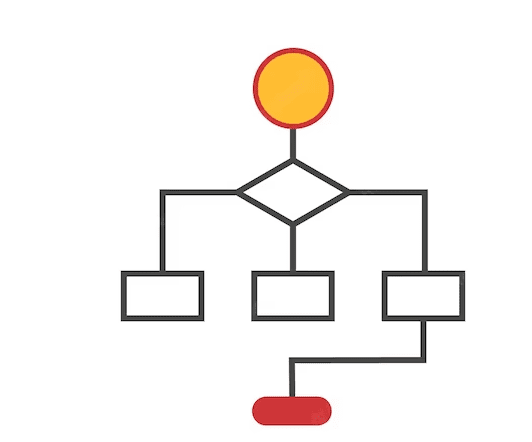

#1. Modelowanie tematyczne

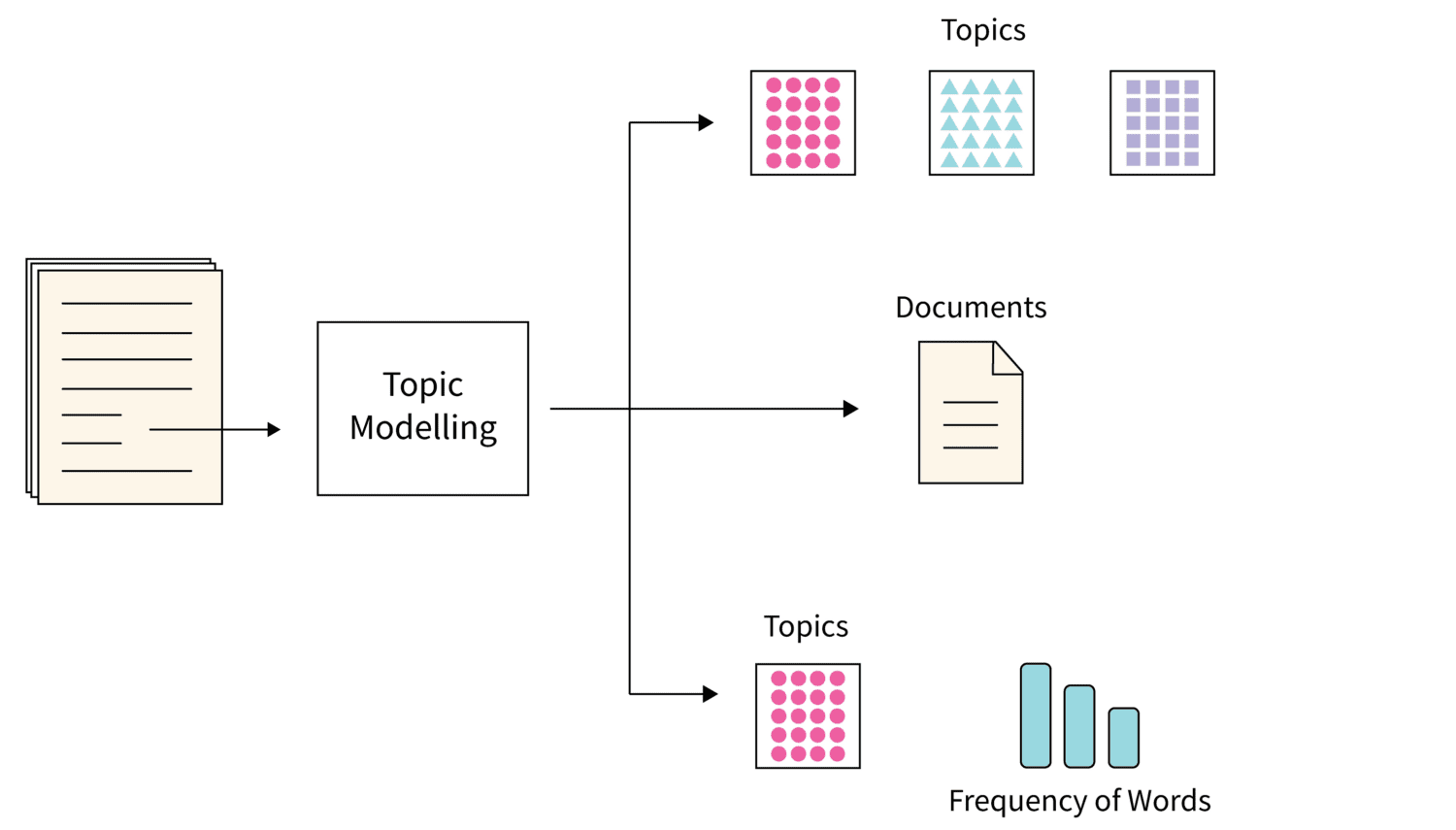

Źródło obrazu: Scaler

Źródło obrazu: Scaler

Modelowanie tematyczne to algorytm, który wykorzystuje techniki statystyczne do identyfikowania motywów przewodnich w dużych zbiorach dokumentów tekstowych. Pomaga on maszynom znaleźć temat, który definiuje dany zbiór tekstów.

Każdy korpus dokumentów tekstowych porusza wiele tematów. Algorytm modelowania tematycznego, poprzez analizę słownictwa, pozwala na wyodrębnienie poszczególnych tematów.

Utajona alokacja Dirichleta (LDA) jest popularnym wyborem, jeśli chodzi o modelowanie tematyczne. Jest to nienadzorowany algorytm uczenia maszynowego, który pomaga w gromadzeniu i porządkowaniu ogromnych ilości danych, co jest niemożliwe w przypadku ręcznej adnotacji.

#2. Podsumowanie tekstu

Jest to zaawansowana technika NLP, w której algorytm tworzy zwięzłe i spójne podsumowanie tekstu. Podsumowanie tekstu pozwala na szybkie wydobycie istotnych informacji bez konieczności czytania całego tekstu.

Podsumowanie tekstu może odbywać się na dwa sposoby:

- Ekstrakcja: Algorytm wybiera kluczowe słowa i frazy z oryginalnego tekstu, nie modyfikując ich.

- Abstrakcja: Algorytm tworzy nowe słowa i frazy, prezentując esencję tekstu w nowej formie.

#3. Analiza sentymentu

Analiza sentymentu to algorytm NLP, który pomaga maszynom zrozumieć emocje i intencje kryjące się w tekście. Jest on powszechnie wykorzystywany w biznesie, gdyż umożliwia firmom zrozumienie opinii klientów na temat ich produktów i usług.

Poprzez analizę danych tekstowych i głosowych, firmy mogą poznać preferencje klientów i odpowiednio na nie zareagować.

#4. Ekstrakcja słów kluczowych

Algorytm ten służy do wyodrębniania kluczowych słów i fraz z dużego zbioru danych tekstowych. Istnieją różne algorytmy ekstrakcji słów kluczowych, takie jak TextRank, Częstotliwość terminów i RAKE.

Każdy z algorytmów ekstrakcji słów kluczowych wykorzystuje swoje własne metody teoretyczne. Jest to korzystne dla wielu organizacji, ponieważ pomaga w przechowywaniu, wyszukiwaniu i pobieraniu treści z nieustrukturyzowanych zbiorów danych.

#5. Grafy wiedzy

Algorytmy grafu wiedzy to efektywna technika przechowywania informacji za pomocą trójek – podmiotu, predykatu i obiektu. Tworzenie grafu wiedzy opiera się na wielu technikach NLP.

Podejście przedmiotowe służy do wydobywania uporządkowanych informacji z nieustrukturyzowanych tekstów.

#6. TF-IDF

TF-IDF to statystyczny algorytm NLP, który służy do oceny ważności słowa w danym dokumencie w kontekście dużego zbioru dokumentów. Technika ta łączy dwa wskaźniki:

- Częstotliwość terminu (TF): Określa, ile razy dane słowo występuje w konkretnym dokumencie. Słowa stop zwykle mają wysoką częstotliwość.

- Odwrotna częstotliwość dokumentów (IDF): Podkreśla terminy, które są specyficzne dla danego dokumentu, a rzadziej występują w całym zbiorze.

#7. Chmura słów

Chmura słów to algorytm NLP, który wizualizuje dane. Ważne słowa są podświetlane i wyświetlane w tabeli, gdzie najważniejsze są większe, a mniej ważne – mniejsze, czasami niewidoczne.

Zasoby edukacyjne

Jeśli chcesz dowiedzieć się więcej o przetwarzaniu języka naturalnego (NLP), możesz rozważyć następujące kursy i książki:

#1. Nauka o danych: przetwarzanie języka naturalnego w Pythonie

Ten kurs Udemy, wysoko oceniany przez uczestników i stworzony przez Lazy Programmer Inc., uczy wszystkiego o algorytmach NLP oraz jak pisać analizy sentymentu. Zawiera 88 wykładów w łącznym czasie 11 godzin i 52 minut.

#2. Przetwarzanie języka naturalnego: NLP z transformatorami w Pythonie

Ten popularny kurs Udemy uczy NLP z modelami transformatorów i daje możliwość tworzenia precyzyjnie dostrojonych modeli. Kurs zawiera 11,5 godzin materiałów wideo i 5 artykułów. Obejmuje również budowanie wektorów i wstępne przetwarzanie danych tekstowych dla NLP.

#3. Przetwarzanie języka naturalnego za pomocą transformatorów

Książka wydana w 2017 roku, która ma pomóc naukowcom danych i programistom poznać NLP. Uczy budowania i optymalizacji modeli transformatorów dla różnych zadań NLP oraz jak wykorzystać transformatory w nauce transferu międzyjęzykowej.

#4. Praktyczne przetwarzanie języka naturalnego

W tej książce autorzy wyjaśniają zadania, problemy i rozwiązania w dziedzinie NLP. Uczą wdrażania i oceny różnych aplikacji NLP.

Podsumowanie

NLP stanowi integralną część współczesnego świata sztucznej inteligencji, umożliwiając maszynom rozumienie i interpretację ludzkich języków. Algorytmy NLP są użyteczne w różnych dziedzinach, od wyszukiwarek i IT, po finanse i marketing.

Oprócz wyżej wymienionych informacji, przedstawiłem również kilka z najlepszych kursów i książek, które mogą pomóc w pogłębieniu wiedzy na temat NLP.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.