Wzrost popularności GPU w chmurze

Wraz z rozwojem zaawansowanych technologii, takich jak głębokie uczenie, sztuczna inteligencja i uczenie maszynowe, zapotrzebowanie na procesory graficzne (GPU) dostępne w chmurze dynamicznie rośnie.

Jeżeli Twoja działalność koncentruje się na wizualizacjach 3D, uczeniu maszynowym, sztucznej inteligencji lub intensywnym przetwarzaniu danych, wybór odpowiedniej metody wykorzystania mocy obliczeniowej GPU ma kluczowe znaczenie.

Tradycyjne podejście do modelowania w ramach głębokiego uczenia często wiązało się z długotrwałymi procesami treningowymi i obliczeniowymi. To pochłaniało czas, generowało wysokie koszty i powodowało problemy z przechowywaniem danych, co negatywnie wpływało na produktywność.

Nowoczesne układy GPU stanowią odpowiedź na te wyzwania. Zapewniają one wysoką wydajność w wykonywaniu równoległych obliczeń, co znacząco przyspiesza proces treningu modeli sztucznej inteligencji.

Według badań przeprowadzonych przez firmę Indigo, procesory graficzne mogą oferować wydajność nawet 250 razy wyższą niż standardowe procesory CPU podczas treningu sieci neuronowych w ramach głębokiego uczenia.

Postęp w dziedzinie przetwarzania w chmurze umożliwił powstanie procesorów graficznych w chmurze, które rewolucjonizują świat nauki o danych i innych nowoczesnych technologii. Oferują one zwiększoną wydajność, prostotę konserwacji, obniżone koszty, szybką skalowalność oraz oszczędność czasu.

W tym artykule przybliżymy koncepcję GPU w chmurze, omówimy jego zastosowanie w kontekście AI, ML i głębokiego uczenia. Zaprezentujemy także najlepsze platformy oferujące GPU w chmurze, które pozwolą Ci wdrożyć preferowane rozwiązanie.

Zaczynajmy!

Czym jest GPU w chmurze?

Aby dokładnie zrozumieć ideę GPU w chmurze, zacznijmy od wyjaśnienia, czym są procesory graficzne.

Jednostka przetwarzania grafiki (GPU) to specjalizowany układ elektroniczny, który umożliwia szybkie modyfikowanie i operowanie pamięcią w celu przyspieszenia generowania obrazów i grafiki.

Współczesne procesory graficzne oferują znacznie wyższą wydajność w przetwarzaniu obrazów i grafiki komputerowej dzięki swojej równoległej architekturze, w porównaniu z tradycyjnymi jednostkami centralnymi (CPU). Procesor GPU może być zintegrowany z płytą główną, umieszczony na karcie graficznej lub jako część układu procesora komputera.

Chmurowe Jednostki Graficzne (GPU) to instancje komputerowe wyposażone w wydajną akcelerację sprzętową. Ułatwiają one uruchamianie aplikacji, które obsługują intensywne obciążenia związane ze sztuczną inteligencją i głębokim uczeniem w środowisku chmurowym. Nie ma konieczności fizycznego wdrażania GPU na swoim urządzeniu.

Do popularnych producentów GPU należą NVIDIA, AMD, Radeon oraz GeForce.

Procesory GPU znajdują zastosowanie w:

- Telefonach komórkowych

- Konsolach do gier

- Stacjach roboczych

- Systemach wbudowanych

- Komputerach osobistych

Zastosowania GPU:

Poniżej przedstawiamy kilka przykładów zastosowania procesorów graficznych:

- W AI i ML do rozpoznawania obrazów

- Do obliczeń w grafice komputerowej 3D i projektowaniu CAD

- Do mapowania tekstur i renderowania wielokątów

- Do obliczeń geometrycznych, takich jak przekształcenia i obroty wierzchołków w układach współrzędnych

- Do obsługi programowalnych shaderów, które manipulują teksturami i wierzchołkami

- Do akcelerowanego przez GPU kodowania, dekodowania i strumieniowania wideo

- Do gier z zaawansowaną grafiką oraz gier w chmurze

- Do modelowania matematycznego na dużą skalę, analiz i głębokiego uczenia, które wymagają możliwości równoległego przetwarzania oferowanych przez procesory graficzne ogólnego przeznaczenia.

- Do edycji wideo, projektowania graficznego i tworzenia treści

Jakie korzyści oferują procesory graficzne w chmurze?

Główne zalety korzystania z procesorów graficznych w chmurze to:

Wysoka skalowalność

Wraz z rozwojem Twojej organizacji, obciążenie pracą naturalnie wzrośnie. Potrzebny będzie procesor graficzny, który sprosta temu wyzwaniu. Procesory graficzne w chmurze oferują możliwość łatwego dodawania kolejnych jednostek GPU, co umożliwia elastyczne zarządzanie zwiększonym obciążeniem. W analogiczny sposób, redukcja mocy obliczeniowej jest równie szybka i bezproblemowa.

Minimalizacja kosztów

Zamiast inwestować w kosztowne fizyczne procesory graficzne o dużej mocy, można skorzystać z wynajmu GPU w chmurze, które są dostępne w korzystniejszych stawkach godzinowych. Płacisz jedynie za faktyczny czas korzystania z procesora graficznego, a nie za samo jego posiadanie, co pozwala na znaczne oszczędności.

Oszczędność lokalnych zasobów

Procesory GPU w chmurze nie obciążają zasobów lokalnych, w przeciwieństwie do fizycznych GPU, które zajmują sporo miejsca i mogą spowalniać działanie komputera, szczególnie podczas intensywnych zadań. Dzięki chmurze możesz przenieść całą moc obliczeniową na zewnątrz, używając swojego komputera tylko do kontroli i zarządzania procesami.

Oszczędność czasu

Układy GPU w chmurze umożliwiają projektantom szybkie iteracje i skracają czas renderowania. Zadania, które wcześniej zajmowały godziny lub dni, można wykonać w ciągu kilku minut. W efekcie wzrasta produktywność Twojego zespołu, a Ty zyskujesz więcej czasu na innowacje.

Jak procesory graficzne wspierają głębokie uczenie i sztuczną inteligencję?

Głębokie uczenie stanowi podstawę sztucznej inteligencji. Jest to zaawansowana technika uczenia maszynowego, która koncentruje się na reprezentacji danych za pomocą sztucznych sieci neuronowych (ANN). Modele głębokiego uczenia są używane do przetwarzania dużych zbiorów danych i procesów o wysokiej złożoności obliczeniowej.

Jak w tym kontekście działają procesory GPU?

GPU zostały zaprojektowane do wykonywania obliczeń równoległych, czyli wielu obliczeń jednocześnie. Umożliwia to wykorzystanie potencjału modeli głębokiego uczenia, przyspieszając realizację wymagających zadań obliczeniowych.

Dzięki swojej wielordzeniowej architekturze, procesory graficzne oferują znakomitą wydajność w przetwarzaniu równoległym. Dodatkowo, charakteryzują się większą przepustowością pamięci, co pozwala na obsługę ogromnych ilości danych potrzebnych w systemach głębokiego uczenia. Dlatego są powszechnie stosowane w trenowaniu modeli AI, renderowaniu modeli CAD, grach wideo oraz wielu innych zastosowaniach.

Co więcej, jeśli potrzebujesz eksperymentować z kilkoma algorytmami jednocześnie, możesz uruchomić różne procesory graficzne niezależnie. To ułatwia obsługę wielu procesów równocześnie, bez konieczności ich wykonywania na jednym procesorze. Możesz do tego celu wykorzystać wiele procesorów GPU na różnych komputerach fizycznych lub w ramach jednej maszyny, aby zarządzać złożonymi modelami danych.

Jak zacząć korzystać z GPU w chmurze?

Rozpoczęcie pracy z procesorami graficznymi w chmurze jest łatwe i szybkie, o ile rozumiesz podstawy. Najpierw musisz wybrać dostawcę GPU w chmurze, na przykład Google Cloud Platform (GCP).

Następnie zarejestruj się w GCP. Zyskasz dostęp do wszystkich standardowych korzyści, takich jak funkcje chmurowe, opcje przechowywania danych, zarządzanie bazami danych, integracja z aplikacjami i wiele innych. Możesz również skorzystać z Google Colaboratory, które działa podobnie do Jupyter Notebook i umożliwia korzystanie z jednego GPU ZA DARMO. Na koniec możesz rozpocząć renderowanie z wykorzystaniem procesorów graficznych dla swojego przypadku użycia.

Przyjrzyjmy się zatem różnym dostępnym opcjom, dzięki którym procesory graficzne w chmurze wspomagają AI i duże obciążenia.

Linode

Linode oferuje procesory graficzne na żądanie, które można wykorzystać do równoległego przetwarzania danych, np. podczas przetwarzania wideo, obliczeń naukowych, uczenia maszynowego i sztucznej inteligencji. Platforma udostępnia zoptymalizowane maszyny wirtualne z akceleracją GPU, które bazują na rdzeniach NVIDIA Quadro RTX 6000, Tensor i RT. Wykorzystują one również technologię CUDA do realizacji zadań związanych z ray tracingiem, głębokim uczeniem i zaawansowanym przetwarzaniem.

Dzięki dostępowi do GPU Linode możesz przekształcić swoje wydatki kapitałowe w koszty operacyjne i w pełni wykorzystać zalety chmury. Ponadto Linode pozwala skupić się na podstawowych kompetencjach, zamiast martwić się o infrastrukturę sprzętową.

Procesory graficzne Linode eliminują ograniczenia związane z wykorzystaniem ich w złożonych przypadkach użycia, takich jak przesyłanie strumieniowe wideo, sztuczna inteligencja i uczenie maszynowe. W zależności od zapotrzebowania na moc obliczeniową, do każdej instancji można przypisać do 4 kart.

Karta Quadro RTX 6000 zawiera 4608 rdzeni CUDA, 576 rdzeni Tensor, 72 rdzenie RT, 24 GB pamięci GPU GDDR6, 84T RTX-OPS, 10 Giga Rays/sec Rays Cast i wydajność FP32 na poziomie 16,3 TFLOPS.

Cena dedykowanego planu GPU z procesorem RTX6000 wynosi 1,5 USD za godzinę.

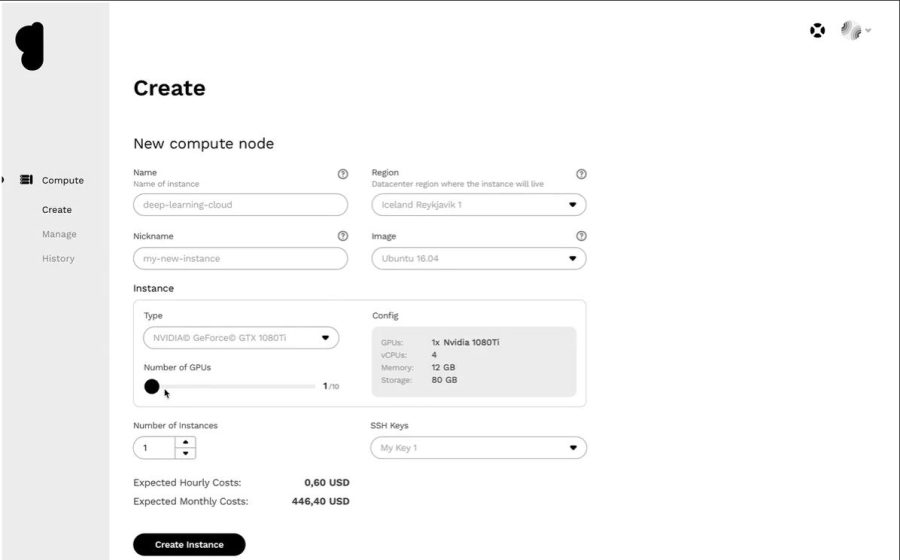

Paperspace Core

Zoptymalizuj swój przepływ pracy dzięki infrastrukturze obliczeniowej nowej generacji, wykorzystując Paperspace Core. Platforma oferuje intuicyjny interfejs, który zapewnia proste narzędzia do włączania, współpracy oraz aplikacje komputerowe dla systemów Mac, Linux i Windows. Możesz ją wykorzystać do uruchamiania wymagających aplikacji, korzystając z nieograniczonej mocy obliczeniowej.

Core zapewnia szybką sieć, natychmiastowe przydzielanie zasobów, wsparcie dla aplikacji 3D oraz kompletny interfejs API do programowego dostępu. Uzyskaj pełny wgląd w swoją infrastrukturę za pomocą prostego i intuicyjnego interfejsu graficznego. Dodatkowo, uzyskaj doskonałą kontrolę dzięki interfejsowi zarządzania Core, który zawiera zaawansowane narzędzia i umożliwia filtrowanie, sortowanie, łączenie i tworzenie maszyn, sieci i użytkowników.

Zaawansowana konsola zarządzania Core umożliwia szybkie wykonywanie zadań, takich jak dodawanie integracji z Active Directory lub VPN. Możesz też w łatwy sposób zarządzać złożonymi konfiguracjami sieci i wykonywać zadania za pomocą kilku kliknięć.

Ponadto, znajdziesz wiele dodatkowych integracji, które usprawnią Twoją pracę. Zyskaj zaawansowane funkcje zabezpieczeń, udostępnione dyski i więcej, dzięki tej platformie GPU w chmurze. Ciesz się tanimi procesorami graficznymi dzięki zniżkom edukacyjnym, alertom rozliczeniowym i naliczaniu sekundowemu.

Zwiększ prostotę i szybkość swojego przepływu pracy w cenie początkowej 0,07 USD/godzinę.

Procesory graficzne Google Cloud

Uzyskaj dostęp do wysokowydajnych procesorów GPU przeznaczonych do obliczeń naukowych, wizualizacji 3D i uczenia maszynowego, korzystając z Procesorów graficznych Google Cloud. Platforma umożliwia przyspieszenie procesów HPC, wybór szerokiej gamy procesorów graficznych, dostosowanie cen i wydajności oraz minimalizację obciążenia pracą dzięki dostosowaniu maszyn i elastycznym opcjom cenowym.

Dostępnych jest wiele procesorów graficznych, takich jak NVIDIA K80, P4, V100, A100, T4 i P100. Ponadto, procesory graficzne Google Cloud zapewniają równowagę między pamięcią, procesorem, szybkim dyskiem oraz możliwością wykorzystania do 8 procesorów graficznych w każdej instancji, w zależności od indywidualnych potrzeb.

Dodatkowo, uzyskujesz dostęp do wiodącej w branży sieci, analizy danych i magazynowania. Urządzenia GPU są dostępne tylko w określonych strefach w wybranych regionach. Cena zależy od regionu, wybranego procesora graficznego i typu maszyny. Możesz obliczyć koszt za pomocą Kalkulatora cen Google Cloud, definiując swoje wymagania.

Alternatywnie, możesz wybrać te rozwiązania:

Elastyczna usługa GPU

Elastyczna usługa GPU (EGS) zapewnia równoległe i wydajne możliwości obliczeniowe dzięki technologii GPU. Jest idealna do różnych zastosowań, takich jak przetwarzanie wideo, wizualizacja, obliczenia naukowe i głębokie uczenie. EGS korzysta z kilku procesorów graficznych, takich jak NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 i AMD FirePro S7150.

Możesz skorzystać z usług wnioskowania i szkoleń z zakresu głębokiego uczenia online, identyfikacji treści, rozpoznawania obrazu i głosu, kodowania multimediów HD, wideokonferencji, naprawy filmów źródłowych i 4K/8K HD na żywo.

Dodatkowo zyskasz opcje takie jak renderowanie wideo, finanse obliczeniowe, prognozowanie klimatu, symulacja kolizji, inżynieria genetyczna, edycja nieliniowa, aplikacje do zdalnej edukacji oraz projektowanie inżynieryjne.

- Instancja GA1 oferuje do 4 procesorów graficznych AMD FirePro S7150, 160 GB pamięci i 56 procesorów wirtualnych. Zawiera 8192 rdzeni i 32 GB pamięci GPU, która działa równolegle i zapewnia 15 TFLOPS w pojedynczej precyzji oraz jeden TFLOPS w podwójnej precyzji.

- Instancja GN4 oferuje do 2 procesorów graficznych NVIDIA Tesla M40, 96 GB pamięci i 56 procesorów wirtualnych. Zawiera 6000 rdzeni i 24 GB pamięci GPU, która zapewnia 14 TFLOPS w pojedynczej precyzji. Dostępnych jest też wiele innych instancji, takich jak GN5, GN5i i GN6.

- EGS obsługuje wewnętrznie przepustowość sieci 25 Gbit/s i do 2 000 000 PPS, aby zapewnić maksymalną wydajność sieci wymaganą przez węzły obliczeniowe. Ma szybką lokalną pamięć podręczną, która jest dołączona do dysków SSD lub Ultra Cloud.

- Wysokowydajne dyski NVMe obsługują 230 000 IOPS z opóźnieniem we/wy 200 μs i zapewniają przepustowość odczytu 1900 Mb/s oraz przepustowość zapisu 1100 Mb/s.

Możesz wybrać spośród różnych opcji zakupu, aby zdobyć zasoby i płacić tylko za faktycznie wykorzystane moce obliczeniowe.

Seria Azure N

Seria Azure N maszyn wirtualnych platformy Azure (VM) oferuje dostęp do procesorów GPU. Procesory GPU są idealne do obsługi obciążeń graficznych i tych, które wymagają dużej mocy obliczeniowej. Pomagają użytkownikom w innowacjach w różnych scenariuszach, takich jak uczenie głębokie, analiza predykcyjna i zdalna wizualizacja.

Poszczególne serie N mają różne oferty, dopasowane do konkretnych potrzeb:

- Seria NC jest ukierunkowana na wysokowydajne uczenie maszynowe i obciążenia obliczeniowe. Najnowsza wersja to NCsv3, która zawiera procesor graficzny NVIDIA NVIDIA Tesla V100.

- Seria ND koncentruje się na scenariuszach wnioskowania i treningu, szczególnie w obszarze głębokiego uczenia. Wykorzystuje procesory graficzne NVIDIA Tesla P40. Najnowsza wersja to NDv2 z procesorami graficznymi NVIDIA Tesla V100.

- Seria NV skupia się na zdalnej wizualizacji i innych intensywnych obciążeniach aplikacji, korzystając z procesora graficznego NVIDIA Tesla M60.

- Maszyny wirtualne NC, NCsv3, NDs i NCsv2 oferują połączenie InfiniBand, które zwiększa możliwości skalowania. Dzięki temu uzyskasz dostęp do mocy obliczeniowej potrzebnej do głębokiego uczenia, renderowania grafiki, edycji wideo, gier i nie tylko.

IBM Cloud

IBM Cloud oferuje elastyczność, moc i wiele opcji GPU. Ponieważ procesor graficzny zwiększa moc obliczeniową procesora, IBM Cloud umożliwia dostęp do szerokiej gamy serwerów, które bezproblemowo integrują się z architekturą, aplikacjami i interfejsami API IBM Cloud, a także z rozproszoną siecią centrów danych na całym świecie.

- Oferowane są opcje GPU dla serwerów bare metal, takie jak Intel Xeon 4210, karta graficzna NVIDIA T4, 20 rdzeni, 32 GB pamięci RAM, 2,20 GHz i przepustowość 20 TB. Dostępne są także opcje Intel Xeon 5218 i Intel Xeon 6248.

- W przypadku serwerów wirtualnych dostępna jest instancja AC1.8×60, która ma osiem vCPU, 60 GB RAM i 1 x GPU P100. Dostępne są również opcje AC2.8×60 oraz AC2.8×60.

Możesz zakupić serwer bare metal GPU w cenie początkowej 819 USD/miesiąc, a wirtualny serwer GPU w cenie początkowej 1,95 USD/godz.

AWS i NVIDIA

AWS i NVIDIA współpracują, aby stale dostarczać opłacalne, elastyczne i wydajne rozwiązania oparte na procesorach graficznych. Oferta obejmuje instancje Amazon EC2 z procesorami graficznymi NVIDIA oraz usługi takie jak AWS IoT Greengrass, które są wdrażane z modułami NVIDIA Jetson Nano.

Użytkownicy wykorzystują AWS i NVIDIA do wirtualnych stacji roboczych, uczenia maszynowego (ML), usług IoT i obliczeń o wysokiej wydajności. Instancje Amazon EC2 zasilane przez procesory graficzne NVIDIA zapewniają skalowalną wydajność. Dodatkowo, możesz użyć AWS IoT Greengrass, aby rozszerzyć usługi chmurowe AWS na urządzenia brzegowe oparte na NVIDIA.

Procesory graficzne NVIDIA A100 Tensor Core zasilają instancje Amazon EC2 P4d, zapewniając wiodącą w branży sieć o niskich opóźnieniach i dużej przepustowości. Dostępnych jest także wiele innych instancji, dopasowanych do konkretnych zastosowań, takich jak Amazon EC2 P3, Amazon EC2 G4 i inne.

Złóż wniosek o BEZPŁATNĄ wersję próbną i poznaj moc GPU w połączeniu z chmurą.

OVHcloud

OVHcloud dostarcza serwery w chmurze zaprojektowane do obsługi dużych obciążeń równoległych. Procesory graficzne mają wiele instancji zintegrowanych z GPU NVIDIA Tesla V100, aby sprostać potrzebom głębokiego uczenia i uczenia maszynowego.

Pomagają przyspieszyć obliczenia w dziedzinie grafiki, jak również sztucznej inteligencji. OVH współpracuje z NVIDIA, aby oferować najlepszą platformę z akceleracją GPU do obliczeń o wysokiej wydajności, AI i głębokiego uczenia.

Skorzystaj z prostego sposobu wdrażania i obsługi kontenerów akcelerowanych przez GPU za pośrednictwem pełnego katalogu. Każda instancja otrzymuje jedną z czterech kart bezpośrednio przez PCI Passthrough, bez warstwy wirtualizacji, aby w pełni wykorzystać moc obliczeniową.

Usługi i infrastruktura OVHcloud posiadają certyfikaty ISO/IEC 27017, 27001, 27701 i 27018. Certyfikaty te potwierdzają, że OVHcloud posiada system zarządzania bezpieczeństwem informacji (ISMS) do zarządzania podatnościami, wdrażania ciągłości działania, zarządzania ryzykiem oraz wdrożony system zarządzania informacjami o prywatności (PIMS).

Dodatkowo, NVIDIA Tesla V100 oferuje wiele cennych funkcji, takich jak PCIe 32 GB/s, 16 GB HBM2 pojemności, 900 GB/s przepustowości, podwójnej precyzji – 7 teraFLOPów, pojedynczej precyzji – 14 teraFLOPów oraz głębokiego uczenia – 112 teraFLOPów.

GPU z Lambdą

Trenuj modele głębokiego uczenia, ML i AI za pomocą Chmury GPU Lambda i skaluj moc od pojedynczej maszyny do wielu maszyn wirtualnych, za pomocą kilku kliknięć. Uzyskaj wstępnie zainstalowane główne platformy i najnowszą wersję stosu lambda, która zawiera sterowniki CUDA i platformy do głębokiego uczenia.

Uzyskaj szybki dostęp do dedykowanego środowiska programistycznego Jupyter Notebook dla każdej maszyny bezpośrednio z pulpitu nawigacyjnego. Użyj SSH za pomocą jednego z kluczy SSH lub połącz się przez terminal internetowy w chmurze na pulpicie nawigacyjnym, aby uzyskać bezpośredni dostęp.

Każda instancja obsługuje przepustowość do 10 Gb/s między węzłami, co umożliwia rozproszone trenowanie za pomocą platform takich jak Horovod. Możesz też zaoszczędzić czas na optymalizacji modelu, skalując do odpowiedniej liczby procesorów graficznych w jednej lub wielu instancjach.

Dzięki Lambda GPU Cloud możesz zaoszczędzić nawet 50% na obliczeniach, zredukować całkowity koszt posiadania chmury i nie musisz podpisywać długoterminowych umów. Wykorzystaj pojedynczy procesor graficzny RTX 6000 z sześcioma VCPU, 46 GiB pamięci RAM, 658 GiB pamięci tymczasowej za jedyne 1,25 USD za godzinę. Wybierz jedną z wielu dostępnych instancji, aby uzyskać cenę na żądanie, dostosowaną do Twoich potrzeb.

Chmura Genesis

Uzyskaj dostęp do wydajnej platformy GPU w chmurze w bardzo przystępnej cenie, korzystając z Chmury Genesis. Platforma współpracuje z wieloma centrami danych na całym świecie, aby oferować szeroką gamę aplikacji.

Wszystkie usługi są bezpieczne, skalowalne, niezawodne i zautomatyzowane. Genesis Cloud zapewnia nieograniczoną moc obliczeniową GPU do efektów wizualnych, uczenia maszynowego, transkodowania, przechowywania i analizy dużych zbiorów danych.

Genesis Cloud oferuje wiele przydatnych funkcji ZA DARMO, takich jak migawki do zapisywania postępów pracy, grupy bezpieczeństwa dla ruchu sieciowego, woluminy pamięci masowej dla zestawów Big Data, FastAI, PyTorch, wstępnie skonfigurowane obrazy oraz publiczne API dla TensorFlow.

Dostępne są różne typy procesorów graficznych NVIDIA i AMD. Możesz trenować sieć neuronową lub generować animacje, wykorzystując moc obliczeniową GPU. Centra danych platformy zasilane są w 100% energią odnawialną ze źródeł geotermalnych, aby ograniczyć emisję dwutlenku węgla.

Ceny są do 85% niższe niż u innych dostawców, a opłaty naliczane są w minutowych interwałach. Możesz dodatkowo zaoszczędzić dzięki długoterminowym i przewidywalnym zniżkom.

Podsumowanie 👩🏫

Procesory graficzne w chmurze oferują niesamowitą wydajność, szybkość, skalowalność, oszczędność miejsca i wygodę. Warto rozważyć wybór preferowanej platformy GPU w chmurze, aby przyspieszyć modele głębokiego uczenia i łatwo obsługiwać obciążenia sztucznej inteligencji.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.