Jeśli interesuje Cię sztuczna inteligencja, ten artykuł z pewnością pomoże Ci zagłębić się w jej zawiłości. Jestem tutaj, aby poprowadzić Cię w podróż do świata platform LLMOps i zapewnić jasność co do kluczowych narzędzi oferowanych do testowania, ulepszania i wdrażania LLM.

Platformy wymienione na tej ważnej liście odgrywają kluczową rolę w uwalnianiu pełnego potencjału modeli językowych, prezentując innowacyjne rozwiązania w zakresie rozwoju i zarządzania.

Cenione organizacje, takie jak Google, OpenAI i Microsoft, wykorzystują platformy LLMOps, aby zapewnić dokładne testowanie, ciągłe udoskonalanie i skuteczne wdrażanie swoich modeli językowych, co skutkuje niezawodnymi i precyzyjnymi wynikami.

Uznając, że LLMOps może być dla wielu nowością, zacznijmy od zdobycia podstawowej wiedzy na temat LLMOps: jego znaczenia, funkcji i korzyści.

Mając tę podstawę, możemy przejść do naszego głównego celu – zidentyfikowania optymalnych narzędzi dla naszych czytelników w oparciu o ich specyficzne wymagania. Główna lista zawarta w tym artykule służy jako przewodnik prowadzący do osiągnięcia tego celu.

Spis treści:

Co to jest LLMOps?

LLMOps oznacza operacje na modelu językowym. Chodzi o zarządzanie, wdrażanie i ulepszanie dużych modeli językowych, takich jak te stosowane w sztucznej inteligencji. LLMOps obejmuje narzędzia i procesy do uczenia, testowania i utrzymywania tych modeli, zapewniając ich dobre działanie i dokładność w miarę upływu czasu.

Chociaż LLM można łatwo prototypować, wykorzystanie ich w produktach komercyjnych stwarza wyzwania. Cykl rozwoju LLM obejmuje skomplikowane etapy, takie jak przygotowanie danych, dostrajanie modelu i wdrażanie, wymagające bezproblemowej pracy zespołowej. LLMOps obejmuje ten cykl, zapewniając płynne eksperymentowanie, wdrażanie i ulepszanie.

I na koniec chciałbym, abyś zrozumiał, czym jest Platforma LLMOps, ponieważ zapewni Ci ona dokładną przejrzystość, a podążanie tą ścieżką z pewnością da ci dobry wynik po jej przeczytaniu.

Platforma LLMOps sprzyja współpracy między badaczami i inżynierami danych, ułatwiając iteracyjną eksplorację danych. Umożliwia współpracę w czasie rzeczywistym, śledzenie eksperymentów, zarządzanie modelami i kontrolowane wdrażanie LLM. LLMOps automatyzuje operacje, synchronizację i monitorowanie w całym cyklu życia ML.

Jak działa LLMOps?

Platformy LLMOps upraszczają cały cykl życia modeli językowych. Centralizują przygotowywanie danych, umożliwiają eksperymentowanie i dostosowywanie do konkretnych zadań. Platformy te ułatwiają także płynne wdrażanie, ciągłe monitorowanie i bezproblemowe przenoszenie wersji.

Promowana jest współpraca, minimalizacja błędów poprzez automatyzację i wspierane jest ciągłe udoskonalanie. Zasadniczo LLMOps optymalizuje zarządzanie modelem języka dla różnorodnych zastosowań.

Korzyści z LLMOps

Do głównych zalet, które uważam za istotne, zalicza się wydajność, dokładność i skalowalność. Oto rozwinięta wersja korzyści, jakie oferuje LLMOps:

- Wydajność: platformy LLMOps optymalizują pełny cykl opracowywania, testowania i wdrażania modelu językowego, co prowadzi do oszczędności czasu i wysiłku.

- Współpraca: platformy te sprzyjają bezproblemowej współpracy między badaczami danych, inżynierami i zainteresowanymi stronami, promując efektywną pracę zespołową.

- Dokładność: LLMOps utrzymują i zwiększają dokładność modelu w czasie poprzez ciągłe monitorowanie i udoskonalanie modeli.

- Automatyzacja: LLMOps automatyzuje kilka zadań, w tym wstępne przetwarzanie i monitorowanie danych, zmniejszając potrzebę ręcznej interwencji.

- Skalowalność: dzięki efektywnemu skalowaniu modeli platformy LLMOps mogą z łatwością sprostać większym obciążeniom lub wymaganiom.

- Łatwość wdrożenia: LLMOps zapewniają płynną integrację modeli z aplikacjami lub systemami, minimalizując wyzwania związane z wdrażaniem.

Zasadniczo LLMOps poprawiają wydajność, dokładność i skalowalność, jednocześnie promując współpracę, automatyzację i bezproblemowe wdrażanie.

Przejdźmy teraz do naszej listy platform. Ta lista jest przewodnikiem od newsblog.pl, ale decyzja o wyborze najlepszej dla Ciebie, w oparciu o Twoje wymagania i potrzeby, leży w Twoich rękach.

Difikuj

Czy intryguje Cię szybki postęp w technologiach LLM, takich jak GPT-4 i podekscytowany ich praktycznym potencjałem? Difikuj został zaprojektowany, aby zaspokoić Twoje potrzeby. Umożliwia programistom, a nawet tym bez dużego zaplecza technicznego, szybkie tworzenie wartościowych aplikacji przy użyciu rozbudowanych modeli językowych. Aplikacje te są nie tylko przyjazne dla użytkownika; są one przeznaczone do ciągłego ulepszania.

Kluczowe cechy:

- Przyjazna dla użytkownika platforma LLMOps: Twórz aplikacje AI przy użyciu GPT-4 i zarządzaj nimi wizualnie.

- Kontekstowa sztuczna inteligencja z Twoimi danymi: wykorzystuj dokumenty, treści internetowe lub notatki Notion jako kontekst sztucznej inteligencji. Dify obsługuje przetwarzanie wstępne i nie tylko, oszczędzając czas programowania.

- Uwolnij potencjał LLM: Dify zapewnia bezproblemowy dostęp do modelu, osadzanie kontekstu, kontrolę kosztów i adnotacje danych w celu płynnego tworzenia sztucznej inteligencji.

- Gotowe szablony: Wybieraj spośród szablonów dialogów i generowania tekstu, gotowych do dostosowania do konkretnych zastosowań.

Agentka

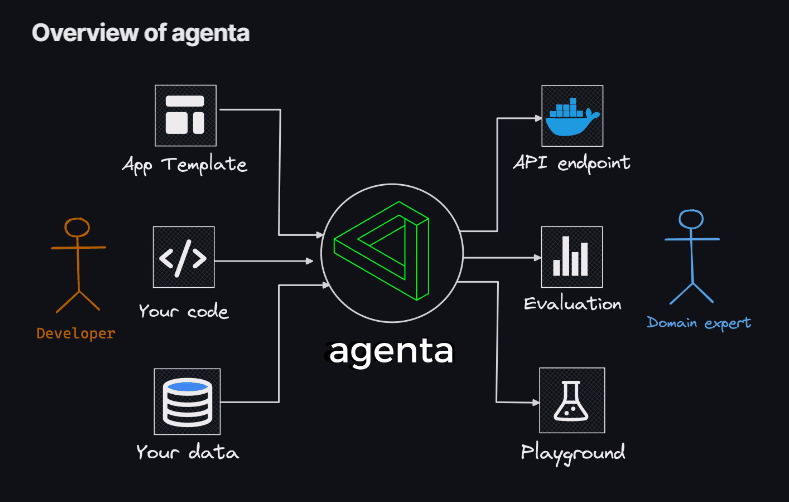

Jeśli szukasz elastyczności w używaniu kodowania do tworzenia aplikacji LLM, bez ograniczeń modeli, bibliotek i frameworków, to Agentka jest Twoim rozwiązaniem. Agenta jawi się jako kompleksowa platforma typu open source, zaprojektowana w celu usprawnienia procesu wdrażania złożonych aplikacji modelu dużego języka (LLM) do środowiska produkcyjnego.

Dzięki Agentie możesz szybko eksperymentować i wersjonować podpowiedzi, parametry i skomplikowane strategie. Obejmuje to uczenie się kontekstowe z osadzeniem, agentami i niestandardową logiką biznesową.

Kluczowe cechy:

- Eksploracja parametrów: Określ parametry aplikacji bezpośrednio w kodzie i bez wysiłku eksperymentuj z nimi za pośrednictwem intuicyjnej platformy internetowej.

- Ocena wydajności: Oceń skuteczność swojej aplikacji na zestawach testowych, korzystając z różnych metodologii, takich jak dokładne dopasowanie, krytyk AI, ocena przez człowieka i nie tylko.

- Struktura testowania: Twórz zestawy testowe bez wysiłku za pomocą interfejsu użytkownika, przesyłając pliki CSV lub płynnie łącząc się z danymi za pośrednictwem naszego interfejsu API.

- Środowisko współpracy: wspieraj pracę zespołową, udostępniając swoją aplikację współpracownikom i prosząc ich o opinie i spostrzeżenia.

- Łatwe wdrażanie: uruchom aplikację jako interfejs API jednym kliknięciem, usprawniając proces wdrażania.

Ponadto Agenta wspiera współpracę z ekspertami dziedzinowymi w celu szybkiego projektowania i oceny. Kolejną atrakcją jest zdolność Agenty do systematycznej oceny aplikacji LLM i ułatwiania wdrażania aplikacji jednym kliknięciem.

Feniks

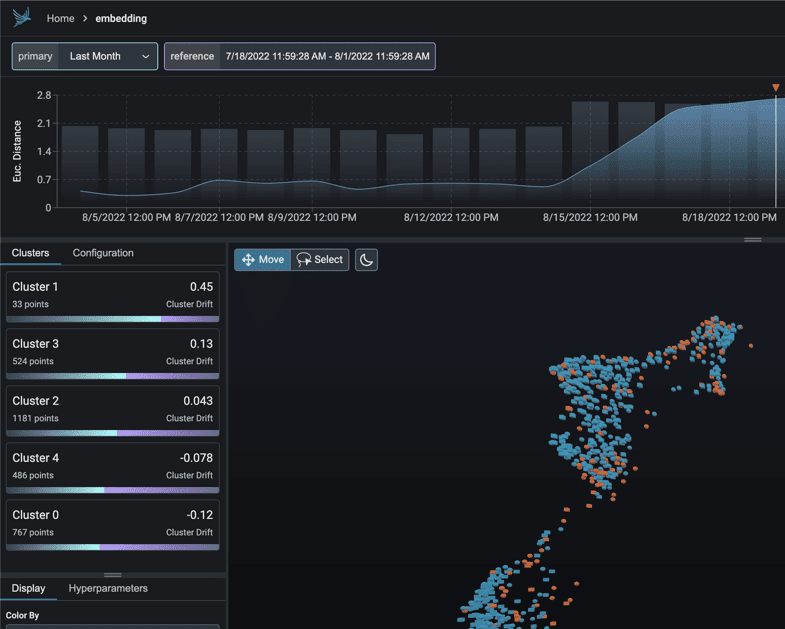

Wyrusz w natychmiastową podróż do wiedzy MLOps obsługiwanej przez Feniks. To genialne narzędzie płynnie umożliwia obserwację wydajności modelu, dryftu i jakości danych, a wszystko to bez konieczności wykonywania skomplikowanych konfiguracji.

Jako awangardowa biblioteka Pythona skupiająca się na notebookach, Phoenix wykorzystuje potencjał osadzania, aby odkrywać ukryte zawiłości w modelach LLM, CV, NLP i tabelarycznych. Podnieś poziom swoich modeli dzięki niezrównanym możliwościom, jakie oferuje oprogramowanie Phoenix.

Kluczowe cechy:

- Wbudowane badanie dryfu: zanurz się w chmurach punktów UMAP w przypadku występowania znacznych odległości euklidesowych i precyzyjnych klastrów dryfu.

- Analiza dryftu i wydajności poprzez klastrowanie: Dekonstruuj dane na klastry o znaczącym dryfcie lub niskiej wydajności za pomocą HDBSCAN.

- Eksploracyjna analiza danych oparta na UMAP: cieniuj chmury punktów UMAP na podstawie atrybutów, dryfu i wydajności modelu, odsłaniając problematyczne segmenty.

LangKit

LangKit to zestaw narzędzi typu open source do metryk tekstowych zaprojektowany do skutecznego monitorowania dużych modeli językowych.

Siłą napędową powstania LangKit jest świadomość, że przekształcanie modeli językowych, w tym LLM, w produkcję niesie ze sobą różne ryzyka. Niezliczone potencjalne kombinacje wejść, prowadzące do równie licznych wyników, stanowią spore wyzwanie.

Kluczowe cechy:

- Szybka analiza iniekcji: ocena podobieństwa do rozpoznanych szybkich ataków iniekcji.

- Analiza nastrojów: oceń ton nastrojów w tekście.

- Ocena jakości tekstu: Oceń czytelność, złożoność i ocenę.

- Wykrywanie jailbreak: Zidentyfikuj wyniki podobieństwa ze znanymi próbami jailbreak.

- Analiza toksyczności: wykrywa poziomy toksyczności w dostarczanej treści.

Nieustrukturyzowany charakter tekstu jeszcze bardziej komplikuje kwestie w zakresie obserwowalności uczenia maszynowego – jest to wyzwanie wymagające rozwiązania. W końcu brak wglądu w zachowanie modelu może mieć znaczące konsekwencje.

LiteLLM

Z LiteLLMuprość interakcje z różnymi interfejsami API LLM – Anthropic, Huggingface, Cohere, Azure OpenAI i nie tylko – korzystając z lekkiego pakietu w formacie OpenAI.

Ten pakiet usprawnia proces wywoływania punktów końcowych API od dostawców takich jak OpenAI, Azure, Cohere i Anthropic. Tłumaczy dane wejściowe na punkty końcowe uzupełniania i osadzania odpowiedniego dostawcy, zapewniając jednolite wyniki. Zawsze możesz uzyskać dostęp do odpowiedzi tekstowych pod adresem [‘choices’][0][‘message’][‘content’].

Kluczowe cechy:

- Usprawnione wywoływanie API LLM: Upraszcza interakcję z interfejsami API LLM, takimi jak Anthropic, Cohere, Azure OpenAI itp.

- Lekki pakiet: kompaktowe rozwiązanie do wywoływania punktów końcowych OpenAI, Azure, Cohere, Anthropic i API.

- Tłumaczenie danych wejściowych: Zarządza tłumaczeniem danych wejściowych na punkty końcowe uzupełniania i osadzania odpowiedniego dostawcy.

- Mapowanie wyjątków: Mapuje typowe wyjątki u dostawców na typy wyjątków OpenAI w celu ustandaryzowanej obsługi błędów.

Dodatkowo pakiet zawiera funkcję mapowania wyjątków. Wyrównuje standardowe wyjątki u różnych dostawców z typami wyjątków OpenAI, zapewniając spójność w obsłudze błędów.

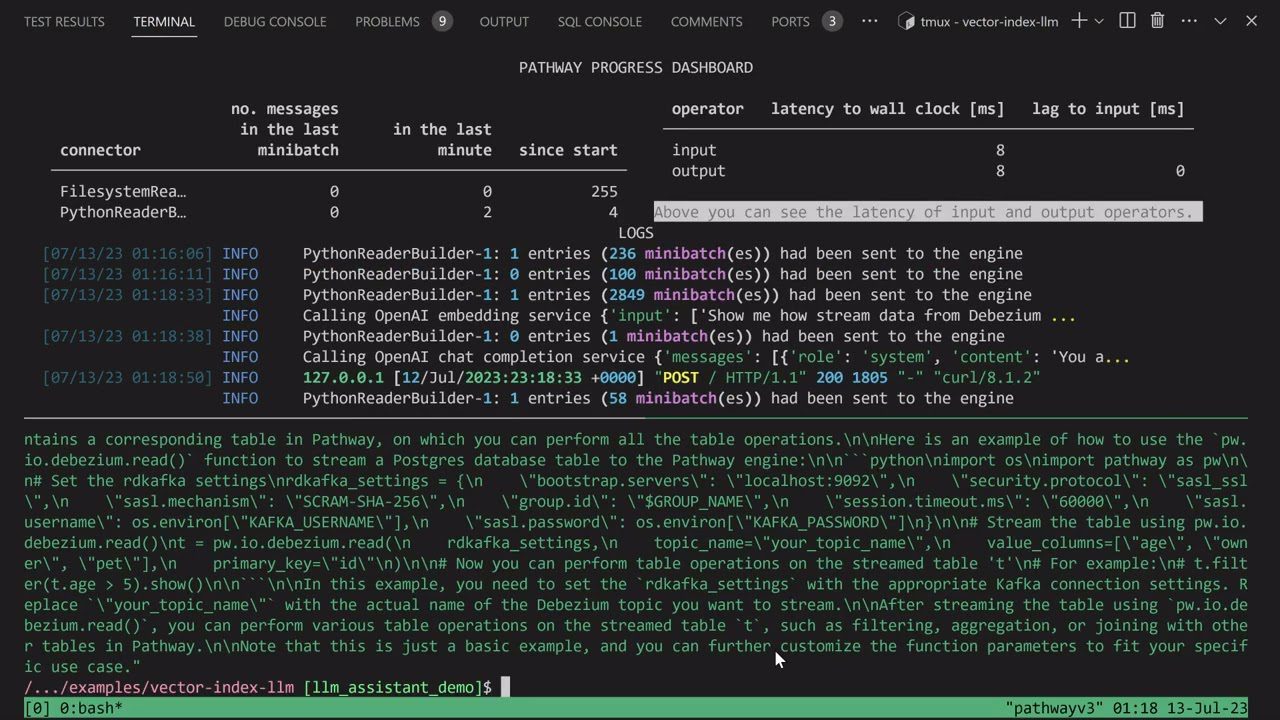

Aplikacja LLM

Wyrusz w podróż tworzenia unikalnego chatbota Discord AI, wzbogaconego o umiejętność odpowiadania na pytania, lub zanurz się w odkrywaniu podobnych pomysłów na boty AI. Wszystkie te urzekające funkcje łączą się w Aplikacja LLM.

Przedstawiam Pathways LLM-App – bibliotekę Pythona, skrupulatnie zaprojektowaną w celu przyspieszenia rozwoju przełomowych aplikacji AI.

Kluczowe cechy:

- Stworzona dla lokalnych modeli ML: aplikacja LLM jest skonfigurowana do działania z lokalnymi modelami ML, pozostając w granicach organizacji.

- Obsługa danych w czasie rzeczywistym: ta biblioteka skutecznie zarządza źródłami danych na żywo, w tym kanałami informacyjnymi, interfejsami API i strumieniami danych Kafki, z uprawnieniami użytkowników i solidnymi zabezpieczeniami.

- Płynne sesje użytkowników: Proces tworzenia zapytań w bibliotece skutecznie obsługuje sesje użytkowników, zapewniając płynne interakcje.

Ten wyjątkowy zasób umożliwia dostarczanie natychmiastowych odpowiedzi odzwierciedlających interakcje międzyludzkie podczas odpowiadania na zapytania użytkowników. Dokonuje tego niezwykłego wyczynu, skutecznie czerpiąc z najnowszych spostrzeżeń ukrytych w źródłach danych.

Przepływy LLMF

Przepływy LLMF jawi się jako platforma dostosowana do upraszczania, wyjaśniania i zapewniania przejrzystości podczas opracowywania aplikacji modelu dużego języka (LLM), takich jak chatboty, systemy odpowiadania na pytania i agenci.

Złożoność można zwiększyć w rzeczywistych scenariuszach ze względu na skomplikowane relacje między podpowiedziami i wywołaniami LLM.

Twórcy LLMFlows przewidzieli jawne API, które umożliwi użytkownikom tworzenie czystego i zrozumiałego kodu. Ten interfejs API usprawnia tworzenie skomplikowanych interakcji LLM, zapewniając płynny przepływ między różnymi modelami.

Kluczowe cechy:

- Bezproblemowo konfiguruj zajęcia LLM, skrupulatnie wybierając określone modele, parametry i ustawienia.

- Zapewnij niezawodne interakcje LLM z automatycznymi ponownymi próbami w przypadku niepowodzeń wywołań modelu, zapewniając niezawodność.

- Zoptymalizuj wydajność i efektywność, wykorzystując przepływy asynchroniczne do równoległego wykonywania LLM, gdy dostępne są dane wejściowe.

- Wprowadź spersonalizowane funkcje manipulacji ciągami bezpośrednio do przepływów, ułatwiając dostosowane transformacje tekstu poza wywołaniami LLM.

- Utrzymuj pełną kontrolę i nadzór nad aplikacjami opartymi na LLM za pomocą wywołań zwrotnych, oferując kompleksowe monitorowanie i wgląd w procesy wykonawcze.

Klasy LLMFlows zapewniają użytkownikom nieograniczoną władzę bez ukrytych podpowiedzi i wywołań LLM.

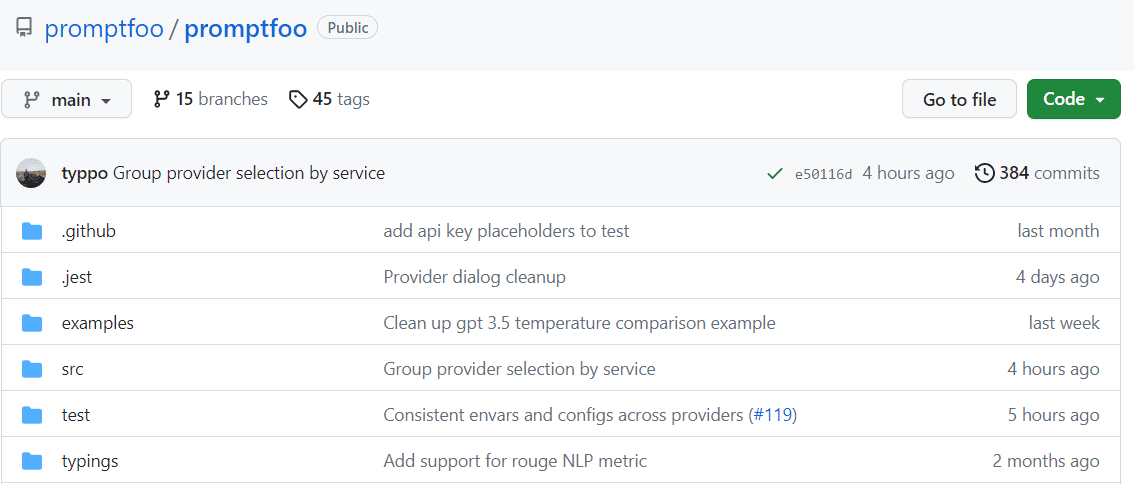

Podpowiedź

Przyspiesz oceny poprzez buforowanie i jednoczesne testowanie szybko. Zapewnia interfejs wiersza poleceń (CLI) i bibliotekę, umożliwia ocenę jakości wyników LLM.

Kluczowe cechy:

- Niezawodność sprawdzona w boju: Promptfoo zostało starannie opracowane w celu oceny i ulepszania aplikacji LLM, które obsługują ponad 10 milionów użytkowników w środowisku produkcyjnym. Dostarczone oprzyrządowanie jest elastyczne i można je dostosować do różnych konfiguracji.

- Przyjazne dla użytkownika przypadki testowe: definiuj oceny bez kodowania i borykania się z nieporęcznymi notatnikami. Proste, deklaratywne podejście usprawnia proces.

- Elastyczność językowa: Niezależnie od tego, czy używasz Pythona, JavaScriptu, czy innego języka, Promptfoo dostosuje się do Twoich preferencji.

Co więcej, Promptfoo umożliwia systematyczne testowanie podpowiedzi względem wcześniej zdefiniowanych przypadków testowych. Pomaga to w ocenie jakości i identyfikacji regresji, ułatwiając bezpośrednie porównanie wyników LLM.

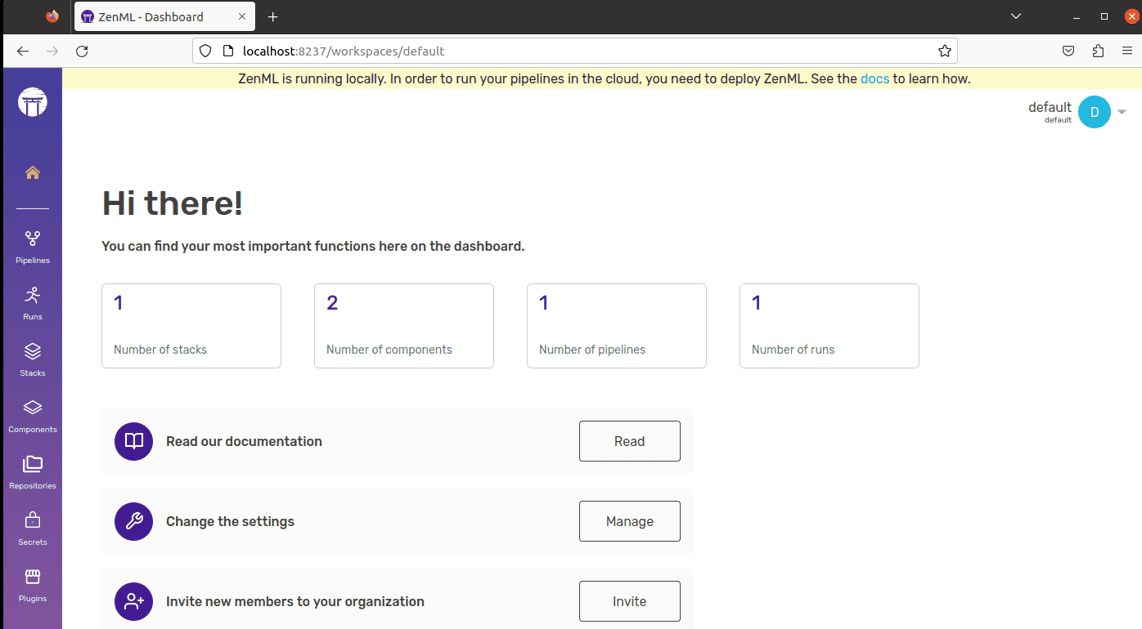

ZenML

Powiedz cześć ZenML – elastyczne narzędzie typu open source zaprojektowane, aby ułatwić profesjonalistom i organizacjom korzystanie z procesów uczenia maszynowego. Wyobraź sobie, że masz narzędzie, które pozwala tworzyć potoki uczenia maszynowego gotowe do użycia w świecie rzeczywistym, niezależnie od tego, jak złożony jest Twój projekt.

ZenML oddziela kwestie techniczne od kodu, ułatwiając współpracę programistom, analitykom danych, ekspertom MLOps i inżynierom ML. Oznacza to, że Twoje projekty mogą płynniej przejść od etapu pomysłu do gotowości do działania.

Kluczowe cechy:

- Dla badaczy danych: skup się na tworzeniu i testowaniu modeli, podczas gdy ZenML przygotowuje Twój kod do rzeczywistego użycia.

- Dla ekspertów ds. infrastruktury MLOps: szybko konfiguruj, zarządzaj i wdrażaj złożone systemy, aby Twoi współpracownicy mogli z nich korzystać bez kłopotów.

- Dla inżynierów ML: Obsługuj każdy etap projektu uczenia maszynowego, od początku do końca, za pomocą ZenML. Oznacza to mniej przekazywania zadań i większą przejrzystość ścieżki organizacji.

ZenML jest przeznaczony dla każdego – niezależnie od tego, czy jesteś profesjonalistą, czy częścią organizacji. Zapewnia sposób pisania kodu przeznaczony do zadań uczenia maszynowego i działa dobrze z dowolną usługą w chmurze lub narzędziem, którego używasz. Dodatkowo pomaga zarządzać projektem w jednym miejscu, dzięki czemu nie musisz się martwić żonglowaniem różnymi sprawami. Po prostu napisz swój kod raz i używaj go z łatwością w innych systemach.

Końcowa myśl

W tej ekscytującej odysei zawsze pamiętaj, że każda platforma ma odrębny klucz, który może odblokować Twoje aspiracje AI. Twój wybór ma moc kształtowania Twojej ścieżki, więc wybieraj mądrze!

Możesz także zapoznać się z niektórymi narzędziami AI dla programistów, aby szybciej tworzyć aplikacje.