Dla osób, które nie mają doświadczenia w programowaniu, stworzenie skrobaka internetowego może być wyzwaniem. Na szczęście dostępne są różnorodne narzędzia do skrobania stron, które mogą być używane zarówno przez programistów, jak i osoby bez umiejętności kodowania. Oprogramowanie to zostało zaprojektowane w celu wydobywania istotnych danych z różnych stron internetowych. Tego rodzaju narzędzia są przydatne dla każdego, kto pragnie pozyskać dane z sieci. Zebrane informacje mogą być zapisywane lokalnie na komputerze użytkownika lub w bazach danych. Jest to technika automatycznego gromadzenia danych w Internecie. Poniżej przedstawiamy zestawienie 31 najlepszych darmowych narzędzi do skrobania stron internetowych.

31 najlepszych narzędzi do skrobania stron internetowych

W tym miejscu znajdziesz starannie wybraną listę najlepszych narzędzi do web scrapingu. Zawiera ona zarówno komercyjne, jak i otwartoźródłowe rozwiązania, a także linki do ich stron internetowych.

1. Outwit

Outwit to dodatek do przeglądarki Firefox, który można łatwo zainstalować z jego sklepu z dodatkami.

- To narzędzie do skrobania danych bardzo ułatwia zbieranie kontaktów oraz adresów e-mail z sieci.

- W zależności od potrzeb, dostępne są trzy opcje zakupu produktu:

- Wersja Profesjonalna

- Wersja Ekspert

- Dostępna jest również wersja Enterprise.

- Nie wymaga znajomości programowania do pobierania danych z witryn przy użyciu centrum Outwit.

- Możesz rozpocząć skrobanie setek stron internetowych jednym kliknięciem przycisku eksploracji.

2. ParseHub

ParseHub to kolejne z czołowych darmowych narzędzi do skrobania w sieci.

- Przed pobraniem danych możesz oczyszczać tekst i kod HTML.

- Prosto wybierasz dane, które chcesz wyodrębnić, za pomocą naszego zaawansowanego narzędzia do przeszukiwania.

- To jedno z najlepszych narzędzi do skrobania danych, umożliwiające przechowywanie wyodrębnionych danych w różnych formatach do późniejszej analizy.

- Interfejs graficzny jest przyjazny dla użytkownika.

- To narzędzie do skrobania pozwala na automatyczne zbieranie i zapisywanie danych na serwerach.

3. Apify

Apify to kolejne doskonałe narzędzie do skrobania i automatyzacji, które pozwala na tworzenie interfejsów API dla dowolnych witryn, z wbudowanymi serwerami proxy, co ułatwia pozyskiwanie danych.

- Apify zajmuje się infrastrukturą i rozliczeniami, co pozwala programistom na generowanie pasywnego dochodu dzięki projektowaniu narzędzi dla innych.

- Dostępne są różne integracje, w tym Zapier, Integromat, Keboola i Airbyte.

- Apify Store oferuje gotowe rozwiązania do scrapingu dla popularnych witryn, takich jak Instagram, Facebook, Twitter i Google Maps.

- Możesz pobierać dane w formatach takich jak JSON, XML, CSV, HTML i Excel.

- Apify Proxy oferuje funkcje takie jak HTTPS, geotargeting, inteligentna rotacja adresów IP oraz serwery proxy dla Google SERP.

- Dostępna jest bezpłatna 30-dniowa wersja próbna z kredytem o wartości 5 USD na platformie.

4. Scrapestack

Scrapestack jest używany przez ponad 2000 firm i opiera się na unikalnym interfejsie API, dostarczanym przez apilayer. To jedno z najlepszych darmowych narzędzi do skrobania stron internetowych.

- Korzysta z globalnej puli adresów IP, obejmującej 35 milionów centrów danych.

- Umożliwia jednoczesne przetwarzanie wielu żądań API.

- Obsługuje deszyfrowanie CAPTCHA oraz renderowanie JavaScript.

- Dostępne są zarówno opcje bezpłatne, jak i płatne.

- Scrapestack to internetowy interfejs API REST do skrobania, działający w czasie rzeczywistym.

- API Scrapestack pozwala na pozyskiwanie stron internetowych w milisekundach z użyciem milionów adresów IP proxy, przeglądarek oraz kodów CAPTCHA.

- Możesz wysyłać żądania skrobania z ponad 100 lokalizacji na całym świecie.

5. FMiner

FMiner jest popularnym narzędziem do skrobania online, które działa na systemach Windows i Mac OS, umożliwiając ekstrakcję danych, przeszukiwanie ekranu, makr oraz wsparcie online.

- Dane mogą być zbierane z trudnych do zindeksowania dynamicznych witryn Web 2.0.

- Umożliwia tworzenie projektów ekstrakcji danych za pomocą prostego edytora wizualnego.

- Wykorzystuje kombinację struktur linków, rozwijanych menu i dopasowywania wzorców adresów URL, co ułatwia przeszukiwanie stron internetowych.

- Możesz użyć automatycznych usług decaptcha innych firm lub ręcznego wprowadzania danych, aby chronić witrynę przed CAPTCHA.

6. Sequentum

Sequentum to solidne narzędzie Big Data do pozyskiwania wiarygodnych danych online. Jest to kolejne z najlepszych darmowych narzędzi do skrobania stron internetowych.

- W porównaniu do innych rozwiązań, wyodrębnianie danych online staje się szybsze.

- Dzięki tej funkcji możesz przechodzić między różnymi platformami.

- Jest to jeden z najpotężniejszych skrobaków internetowych, które mogą pomóc w rozwoju Twojej firmy. Oferuje proste funkcje, w tym wizualny edytor typu „wskaź i kliknij”.

- Dedykowany internetowy interfejs API wspiera tworzenie aplikacji internetowych, umożliwiając wykonywanie operacji na danych bezpośrednio z Twojej witryny.

7. Agents

Agents to program do skrobania danych, ekstrakcji tekstu i OCR, który wykorzystuje automatykę procesów robotycznych.

- Program pozwala na ponowne wykorzystanie wszystkich przetworzonych danych do celów analitycznych.

- Możesz stworzyć agenta za pomocą zaledwie kilku kliknięć.

- Po zakończeniu zadania otrzymasz powiadomienie e-mail.

- Umożliwia połączenie z Dropbox i korzystanie z bezpiecznego FTP.

- Wszystkie dzienniki aktywności są dostępne do wglądu.

- Pomaga zwiększyć sukces Twojej firmy.

- Umożliwia łatwe wdrażanie reguł biznesowych i niestandardowej logiki.

8. Import.io

Import.io to aplikacja do web scrapingu, która pozwala na wydobywanie danych z określonej strony internetowej i eksportowanie ich do pliku CSV, co ułatwia tworzenie zestawów danych.

- Formularze i loginy internetowe są łatwe do obsługi.

- Jest to jedno z najlepszych narzędzi do skrobania danych, które wykorzystuje interfejsy API oraz webhooki do integracji danych z innymi aplikacjami.

- Możesz uzyskać dostęp do raportów, wykresów i wizualizacji.

- Pozyskiwanie danych powinno być zaplanowane z wyprzedzeniem.

- Chmura Import.io umożliwia przechowywanie i dostęp do danych.

- Interakcję z siecią i przepływy pracy można zautomatyzować.

9. Webz.io

Webz.io umożliwia indeksowanie setek stron internetowych oraz natychmiastowy dostęp do uporządkowanych danych w czasie rzeczywistym. To także jedno z najlepszych darmowych narzędzi do skrobania.

Możesz pozyskać zorganizowane, odczytywalne zestawy danych w formatach JSON i XML.

- Daje dostęp do historycznych kanałów z ponad dziesięcioletnim zbiorem danych.

- Pozwala na dostęp do dużej bazy danych bez dodatkowych kosztów.

- Możesz użyć zaawansowanych filtrów do przeprowadzania szczegółowych analiz i zbiorów danych.

10. Scrape Owl

Scrape Owl to platforma do skrobania stron internetowych, która jest przyjazna dla użytkownika oraz ekonomiczna.

- Podstawowym celem Scrape Owl jest zbieranie danych, w tym z e-commerce, ogłoszeń oraz wykazów nieruchomości.

- Przed wyodrębnieniem materiału możesz uruchomić niestandardowy JavaScript.

- Możesz używać lokalizacji do obchodzenia lokalnych ograniczeń i uzyskiwania dostępu do lokalnych treści.

- Zapewnia niezawodną funkcję oczekiwania.

- Obsługiwane jest renderowanie JavaScript na całej stronie.

- Ta aplikacja może być używana bezpośrednio w Arkuszu Google.

- Oferuje bezpłatny okres próbny z 1000 kredytów, aby wypróbować usługę przed zakupem członkostwa, bez potrzeby podawania danych karty kredytowej.

11. Scrapingbee

Scrapingbee to interfejs API do skrobania stron, który obsługuje zarządzanie proxy i przeglądarkami bezgłowymi.

- Może wykonywać JavaScript na stronach oraz rotować serwery proxy dla każdego żądania, co pozwala na odczytywanie surowego kodu HTML bez ryzyka zablokowania.

- Oferuje również interfejs API do wyodrębniania wyników wyszukiwania Google.

- Obsługiwane jest renderowanie JavaScript.

- Ma funkcję automatycznej rotacji proxy.

- Można go używać bezpośrednio w Arkuszach Google.

- Wymagana jest przeglądarka internetowa Chrome do korzystania z programu.

- Jest idealny do skrobania danych z Amazon.

- Umożliwia skrobanie wyników Google.

12. Bright Data

Bright Data to wiodąca platforma do gromadzenia danych internetowych, oferująca ekonomiczne rozwiązania do przekształcania danych nieustrukturyzowanych w strukturalne, z doskonałą jakością obsługi klienta i pełną zgodnością.

- Jest najbardziej elastyczny, ponieważ oferuje gotowe rozwiązania i możliwość rozbudowy oraz dostosowania.

- Data Collector nowej generacji zapewnia zautomatyzowany i spersonalizowany przepływ danych na jednym pulpicie nawigacyjnym, niezależnie od skali zbierania danych.

- Oferuje wsparcie 24/7 dla klientów.

- Zestawy danych są dostosowane do potrzeb Twojej firmy, obejmując trendy w e-commerce, dane z mediów społecznościowych oraz analizy rynku.

- Możesz skoncentrować się na swojej podstawowej działalności, automatyzując dostęp do niezawodnych danych w swojej branży.

- Jest to najefektywniejsze rozwiązanie, które wymaga mniej zasobów.

- Najbardziej niezawodny i z najlepszą jakością danych, z lepszą obsługą klienta.

13. Scraper API

Scraper API obsługuje zarządzanie proxy, przeglądarkami oraz CAPTCHA.

- To narzędzie oferuje niezrównaną prędkość i niezawodność, umożliwiając tworzenie skalowalnych skrobaków internetowych.

- Możesz uzyskać kod HTML z dowolnej strony internetowej za pomocą jednego wywołania interfejsu API.

- Konfiguracja jest bardzo prosta, wystarczy wysłać żądanie GET z kluczem API i adresem URL do punktu końcowego API.

- Umożliwia łatwe renderowanie kodu JavaScript.

- Pozwala na dostosowanie typu żądania i nagłówków dla każdego żądania.

- Oferuje rotację proxy z geotargetingiem.

14. Dexi Intelligent

Dexi Intelligent to aplikacja internetowa do skrobania, która umożliwia przekształcanie danych internetowych w wartościowe informacje komercyjne.

- To narzędzie oszczędza pieniądze oraz czas Twojej firmy.

- Poprawia produktywność, dokładność i jakość danych.

- Umożliwia najszybszą i najbardziej efektywną ekstrakcję danych.

- Posiada system przechwytywania wiedzy na dużą skalę.

15. Diffbot

Diffbot umożliwia szybkie pozyskiwanie istotnych danych z Internetu.

- Dzięki ekstraktorom AI możesz wyodrębnić dokładne dane strukturalne z dowolnego adresu URL.

- Nie musisz tracić czasu na ręczne skrobanie strony ani tworzenie zapytań.

- Łączy wiele źródeł danych, aby zbudować pełny i dokładny obraz każdego obiektu.

- Możesz wyodrębnić dane strukturalne z dowolnego URL przy użyciu narzędzi AI Extractors.

- Dzięki Crawlbot możesz skalować ekstrakcję do dziesiątek tysięcy domen.

- Funkcja Grafu wiedzy zapewnia dokładne i bogate w informacje dane, które są niezbędne do analizy biznesowej.

16. Data Streamer

Data Streamer to technologia umożliwiająca pozyskiwanie danych z mediów społecznościowych z całego Internetu.

- Jest to jeden z największych skrobaków internetowych, używający przetwarzania języka naturalnego do pobierania kluczowych metadanych.

- Kibana i Elasticsearch zapewniają zintegrowane wyszukiwanie pełnotekstowe.

- Oparte na algorytmach wyszukiwania informacji, zintegrowanym usuwaniu szablonów oraz ekstrakcji treści.

- Zbudowane na odpornej infrastrukturze, zapewniającej wysoką dostępność informacji.

17. Mozenda

Za pomocą Mozendy możesz wyodrębnić teksty, obrazy oraz pliki PDF ze stron internetowych.

- Możesz wykorzystać wybrane narzędzie lub bazę danych do gromadzenia i publikowania danych online.

- To jedno z najlepszych narzędzi do skrobania, które umożliwia organizowanie i formatowanie plików danych do publikacji.

- Dzięki interfejsowi „wskaź i kliknij” możesz szybko utworzyć agentów do przeszukiwania sieci.

- Użyj funkcji Job Sequencer oraz Request Blocking do zbierania danych w czasie rzeczywistym.

- Zarządzanie kontem oraz wsparcie dla klientów są na najwyższym poziomie w branży.

18. Rozszerzenie Data Miner do Chrome

Rozszerzenie Data Miner dla przeglądarki Chrome ułatwia skrobanie stron internetowych i zbieranie danych.

- Może indeksować wiele stron oraz dynamicznie wyodrębniać dane.

- Możliwości wyboru danych są różnorodne.

- Sprawdza informacje, które zostały zeskrobane.

- Możesz zapisać zeskrobane dane jako plik CSV.

- Pamięć lokalna przechowuje zeskrobane dane.

- Rozszerzenie Web Scraper do Chrome obsługuje dynamiczne witryny.

- Mapy witryn można importować oraz eksportować.

19. Scrapy

Scrapy to platforma do skrobania stron internetowych napisana w Pythonie, która jest również jednym z najlepszych narzędzi do tego celu.

- Zapewnia wszystkie narzędzia potrzebne do szybkiego wyodrębniania danych ze stron, ich analizy i zapisywania w preferowanej strukturze oraz formacie.

- To narzędzie jest niezbędne dla dużych projektów skrobania, gdzie wydajność i elastyczność są kluczowe.

- Dane można eksportować w formatach JSON, CSV lub XML.

- Obsługuje systemy Linux, Mac OS X oraz Windows.

- Oparta na technologii asynchronicznej Twisted, co jest jedną z jej kluczowych cech.

- Scrapy wyróżnia się prostotą obsługi i bogatą dokumentacją oraz aktywną społecznością użytkowników.

20. Scrape Hero Cloud

ScrapeHero oferuje gotowe roboty i interfejsy API do skrobania danych z witryn takich jak Amazon, Google oraz Walmart, wykorzystując swoją wieloletnią wiedzę o indeksowaniu sieci.

- Roboty ScrapeHero Cloud oferują automatyczne obracanie serwerów proxy i możliwość uruchamiania wielu robotów równocześnie.

- Nie musisz pobierać ani uczyć się korzystać z narzędzi do scrapingu, aby korzystać z ScrapeHero Cloud.

- Roboty ScrapeHero Cloud pozwalają na szybkie skrobanie danych i ich eksport w formatach JSON, CSV lub Excel.

- Klientom planów Free i Lite przysługuje pomoc e-mail, podczas gdy inne plany oferują priorytetową obsługę.

- Roboty ScrapeHero Cloud można dostosować do specyficznych wymagań klientów.

- To oparty na przeglądarce skrobak, który działa z każdą przeglądarką internetową.

- Nie wymaga umiejętności programistycznych ani rozwoju skrobaka; wystarczy kliknąć, skopiować i wkleić!

21. Data Scraper

Data Scraper to darmowa aplikacja do skrobania online, która pozwala na pobieranie danych z pojedynczej strony internetowej i zapisywanie ich jako pliki CSV lub XSL.

- To rozszerzenie przeglądarki konwertuje dane do formatu tabelarycznego.

- Wymaga korzystania z przeglądarki Google Chrome.

- Bez płatnej wersji możesz zeskrobać 500 stron miesięcznie; jeśli potrzebujesz więcej, musisz przejść na płatny plan.

22. Visual Web Ripper

Visual Web Ripper to narzędzie do automatycznego pobierania danych ze stron internetowych.

- Struktury danych są gromadzone z witryn internetowych lub wyników wyszukiwania za pomocą tego narzędzia.

- Możesz eksportować dane do plików CSV, XML i Excel, a jego interfejs jest przyjazny dla użytkownika.

- Może również zbierać dane z dynamicznych witryn, takich jak te korzystające z technologii AJAX.

- Wystarczy skonfigurować kilka szablonów, a skrobak zajmie się resztą.

- Visual Web Ripper oferuje opcje planowania oraz powiadomienia e-mail w przypadku niepowodzenia projektu.

23. Octoparse

Octoparse to aplikacja do skrobania stron internetowych z przyjaznym dla użytkownika interfejsem wizualnym. To jedno z najlepszych darmowych narzędzi do skrobania stron internetowych. Oto niektóre z jego cech.

- Interfejs typu „wskaź i kliknij” ułatwia wybór informacji do pobrania ze strony internetowej. Octoparse obsługuje zarówno statyczne, jak i dynamiczne strony, w tym te korzystające z AJAX, JavaScript oraz plików cookie.

- Oferuje zaawansowane usługi w chmurze, umożliwiające wyodrębnienie dużych ilości danych.

- Zebrane dane można zapisywać w formatach TXT, CSV, HTML lub XLSX.

- Darmowa wersja Octoparse umożliwia stworzenie do 10 crawlerów; płatne plany oferują dodatkowe funkcje, takie jak interfejs API oraz dostęp do licznych anonimowych serwerów proxy IP, co przyspiesza ekstrakcję danych.

24. WebHarvy

WebHarvy to wizualny skrobak, który ma wbudowaną przeglądarkę do pobierania danych z witryn.

- Oferuje interfejs typu „wskaź i kliknij”, co ułatwia wybór przedmiotów.

- Nie wymaga pisania żadnego kodu.

- Możesz zapisywać dane w formatach CSV, JSON i XML.

- Możliwe jest również zapisanie danych w bazie SQL. WebHarvy oferuje wielopoziomową funkcję usuwania kategorii, która umożliwia pobieranie danych ze stron z listami, śledząc każdy poziom połączeń kategorii.

- Możesz korzystać z wyrażeń regularnych, co daje dodatkową swobodę w pracy z danymi.

- Możesz skonfigurować serwery proxy, aby ukryć swój adres IP podczas pobierania danych, co zwiększa prywatność.

25. PySpider

PySpider to kolejny z najlepszych darmowych narzędzi do przeszukiwania sieci, które działa jako robot indeksujący oparty na Pythonie. Oto jego funkcje.

- Ma rozproszoną architekturę i obsługuje strony JavaScript.

- Możesz mieć wiele robotów, a PySpider może przechowywać dane na wybranym backendzie, w tym MongoDB, MySQL, Redis i innych.

- Dostępne są kolejki wiadomości, takie jak RabbitMQ, Beanstalk i Redis.

- Jedną z zalet PySpider jest prosty interfejs użytkownika, który pozwala na edytowanie skryptów, monitorowanie działań i analizowanie wyników.

- Możesz pobierać dane w formatach JSON i CSV.

- PySpider to skrobak internetowy, który warto rozważyć, zwłaszcza przy pracy z interfejsem użytkownika opartym na witrynie.

- Obsługuje także strony korzystające z AJAX.

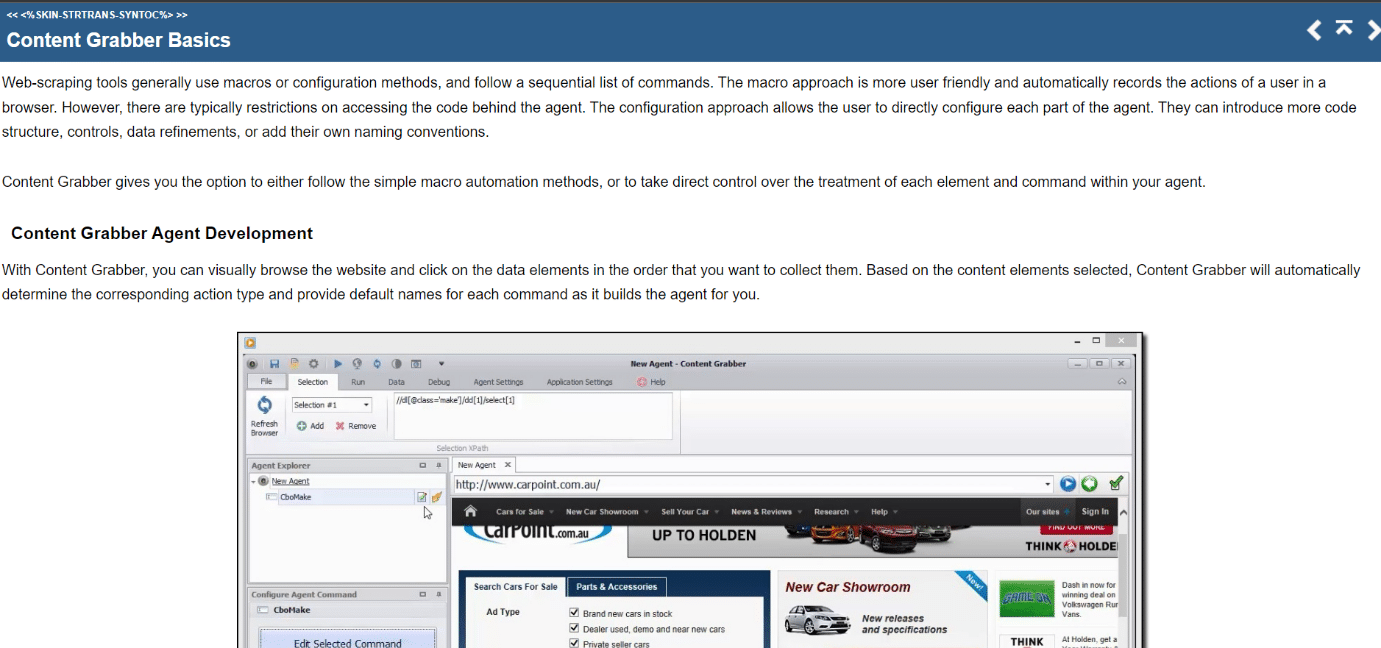

26. Content Grabber

Content Grabber to wizualne narzędzie do skrobania online, które oferuje łatwy w obsłudze interfejs typu „wskaź i kliknij” do wybierania elementów. Oto cechy tego narzędzia.

- Możesz eksportować dane do formatów CSV, XLSX, JSON i PDF. Wymaga to średnio zaawansowanych umiejętności programowania.

- Paginacja, nieograniczone przewijanie stron oraz obsługa wyskakujących okienek są możliwe dzięki interfejsowi użytkownika.

- Oferuje również przetwarzanie AJAX/JavaScript, rozwiązanie do obsługi CAPTCHA, wsparcie dla wyrażeń regularnych oraz rotację adresów IP (przy użyciu Nohodo).

27. Kimurai

Kimurai to platforma do scrapingu w Ruby, umożliwiająca tworzenie skrobaków i wyodrębnianie danych. To jedno z najlepszych darmowych narzędzi do skrobania.

- Umożliwia skrobanie i interakcję ze stronami internetowymi napisanymi w JavaScript bez dodatkowej konfiguracji, używając Headless Chromium/Firefox, PhantomJS lub podstawowych zapytań HTTP.

- Ma podobną składnię do Scrapy oraz konfigurowalne opcje, w tym ustawianie opóźnienia, obracanie agentów użytkownika i domyślne nagłówki.

- Współdziała z platformą testową Capybara.

28. Cheerio

Cheerio to kolejny z doskonałych narzędzi do skrobania sieci. Jest to pakiet, który analizuje dokumenty HTML i XML, umożliwiając operowanie na pobranych danych przy użyciu składni jQuery. Oto cechy tego narzędzia.

- Jeśli tworzysz skrobak sieci oparty na JavaScript, interfejs API Cheerio oferuje szybki wybór do analizowania, modyfikowania i wyświetlania danych.

- Nie renderuje danych wyjściowych w przeglądarkach, nie stosuje CSS, nie ładuje zasobów zewnętrznych ani nie uruchamia JavaScript.

- Jeśli potrzebujesz tych funkcji, powinieneś rozważyć użycie PhantomJS lub JSDom.

29. Puppeteer

Puppeteer to pakiet Node, który umożliwia zarządzanie bezgłową przeglądarką Google Chrome poprzez potężny, ale prosty interfejs API. Oto kilka cech tego narzędzia.

- Działa w tle, wykonując polecenia przez API.

- Bezgłowa przeglądarka wysyła i odbiera żądania, ale nie ma graficznego interfejsu użytkownika.

- Puppeteer to odpowiednie rozwiązanie, gdy dane, których szukasz, są generowane przy użyciu kombinacji danych API oraz kodu JavaScript.

- Możesz naśladować interakcje użytkownika, klikając w określone miejsca, gdzie są umieszczone.

- Puppeteer umożliwia również przechwytywanie zrzutów ekranu stron otwieranych w przeglądarkach.

30. Playwright

Playwright to biblioteka Microsoft Node do automatyzacji przeglądarki i jedno z najlepszych narzędzi do skrobania. Oto jego cechy.

- Oferuje kompetentną, niezawodną i szybką automatyzację w różnych przeglądarkach.

- Playwright został zaprojektowany, aby poprawić automatyzację testów interfejsu użytkownika poprzez zwiększenie stabilności, szybkości oraz zapewnienie wglądu w działanie przeglądarki.

- To nowoczesna aplikacja, porównywalna z Puppeteer, z fabrycznie zainstalowanymi kompatybilnymi przeglądarkami.

- Jego główną zaletą jest wszechstronność, obsługując różne przeglądarki, takie jak Chromium, WebKit i Firefox.

- Regularnie integruje się z platformami Docker, Azure, Travis CI oraz AppVeyor.

31. PJscrape

PJscrape to zestaw narzędzi do scrapingu online oparty na Pythonie, który wykorzystuje JavaScript oraz JQuery. Oto jego cechy.

- Opracowano go do pracy z PhantomJS, umożliwiając pobieranie witryn z wiersza poleceń w pełni renderowanym kontekście z obsługą JavaScript, bez potrzeby używania przeglądarki.

- To pozwala na dostęp do DOM, zmiennych oraz funkcji JavaScript, a także treści ładowanej przez AJAX.

- Funkcje skrobaka ocenia się w kontekście całej przeglądarki.

***

Liczymy na to, że ten przewodnik okazał się pomocny w wyborze najlepszych narzędzi do scrapingu w sieci. Daj nam znać, które z nich są dla Ciebie najłatwiejsze w użyciu. Zachęcamy do odwiedzania naszej strony w celu uzyskania kolejnych interesujących wskazówek oraz dzielenia się swoimi uwagami w komentarzach poniżej.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.