Jeśli fascynuje Cię świat sztucznej inteligencji, ten artykuł z pewnością rozjaśni wiele kwestii. Zapraszam Cię w podróż po meandrach platform LLMOps, gdzie przyjrzymy się narzędziom służącym do testowania, doskonalenia i implementacji modeli językowych (LLM).

Platformy, które przedstawiam, odgrywają zasadniczą rolę w wykorzystaniu pełnego potencjału modeli językowych. To dzięki nim możliwe jest wdrażanie innowacyjnych rozwiązań w obszarze rozwoju i zarządzania.

Renomowane organizacje, takie jak Google, OpenAI i Microsoft, aktywnie korzystają z platform LLMOps, aby rygorystycznie testować, stale udoskonalać i efektywnie wdrażać swoje modele językowe. Dzięki temu uzyskują niezawodne i precyzyjne rezultaty.

Rozumiem, że koncepcja LLMOps może być dla niektórych nowa, dlatego zaczniemy od omówienia podstawowych zagadnień. Zrozumiemy, czym jest LLMOps, jakie pełni funkcje i jakie korzyści ze sobą niesie.

Dysponując solidną wiedzą teoretyczną, przejdziemy do głównego celu tego artykułu, czyli identyfikacji najodpowiedniejszych narzędzi dla Ciebie. Nasza lista posłuży jako przewodnik, który pomoże Ci w dokonaniu świadomego wyboru.

Czym jest LLMOps?

LLMOps, czyli operacje na modelach językowych, to proces zarządzania, wdrażania i ulepszania zaawansowanych modeli językowych. Mowa tutaj o modelach wykorzystywanych w sztucznej inteligencji. LLMOps obejmuje narzędzia i metodyki potrzebne do uczenia, testowania i konserwacji tych modeli. Wszystko po to, aby ich działanie i precyzja były na wysokim poziomie.

Prototypowanie LLM jest stosunkowo proste, jednak implementacja ich w produktach komercyjnych wiąże się z wyzwaniami. Cykl rozwoju LLM składa się ze skomplikowanych etapów, takich jak przygotowanie danych, dostrajanie modelu i wdrożenie. Wymaga to sprawnej pracy zespołowej. LLMOps integruje ten cykl, zapewniając płynność w eksperymentowaniu, wdrażaniu i doskonaleniu.

Chciałbym, abyś na koniec dobrze zrozumiał czym jest platforma LLMOps. To właśnie to zrozumienie pozwoli Ci z pełną jasnością poruszać się po tym temacie, a dzięki temu artykułowi osiągniesz zamierzony cel.

Platforma LLMOps ułatwia współpracę między badaczami a inżynierami danych, wspierając iteracyjną analizę danych. Umożliwia kooperację w czasie rzeczywistym, śledzenie eksperymentów, zarządzanie modelami i kontrolowane wdrażanie LLM. LLMOps automatyzuje operacje, synchronizację i monitoring w całym cyklu życia uczenia maszynowego (ML).

Jak działa LLMOps?

Platformy LLMOps upraszczają cały cykl życia modeli językowych. Centralizują proces przygotowania danych, ułatwiają eksperymentowanie i adaptację do konkretnych zadań. Te platformy umożliwiają również płynne wdrażanie, ciągłe monitorowanie i bezproblemowe przejścia między wersjami.

Promowana jest współpraca, automatyzacja redukuje błędy, a ciągłe ulepszanie jest standardem. Mówiąc wprost, LLMOps optymalizuje zarządzanie modelem językowym w różnych zastosowaniach.

Korzyści z LLMOps

Główne korzyści, które uważam za istotne to wydajność, dokładność i skalowalność. Poniżej rozwinę temat korzyści, jakie oferuje LLMOps:

- Wydajność: Platformy LLMOps optymalizują cały cykl tworzenia, testowania i wdrażania modeli językowych, co pozwala oszczędzić czas i wysiłek.

- Współpraca: Te platformy umożliwiają płynną współpracę między badaczami danych, inżynierami i innymi interesariuszami, co sprzyja efektywnej pracy zespołowej.

- Dokładność: LLMOps dba o utrzymanie i zwiększanie dokładności modeli w czasie, dzięki ciągłemu monitorowaniu i ulepszaniu.

- Automatyzacja: LLMOps automatyzuje wiele zadań, takich jak wstępne przetwarzanie danych i monitorowanie, zmniejszając potrzebę ręcznej interwencji.

- Skalowalność: Dzięki możliwości efektywnego skalowania modeli, platformy LLMOps mogą bez problemu radzić sobie z większym obciążeniem lub nowymi wymaganiami.

- Łatwość wdrożenia: LLMOps zapewnia płynną integrację modeli z aplikacjami lub systemami, minimalizując trudności związane z wdrażaniem.

Reasumując, LLMOps podnosi wydajność, dokładność i skalowalność, wspierając jednocześnie współpracę, automatyzację i bezproblemowe wdrożenia.

Przejdźmy teraz do naszej listy platform. Lista ta jest przewodnikiem zaczerpniętym z newsblog.pl, natomiast ostateczna decyzja o wyborze najlepszego rozwiązania, zależy od Twoich indywidualnych potrzeb i wymagań.

Dify

Czy śledzisz z zapartym tchem postępy w technologiach LLM, takich jak GPT-4, i jesteś podekscytowany ich praktycznym potencjałem? Dify został stworzony, aby spełnić Twoje oczekiwania. Umożliwia programistom, a nawet osobom bez zaawansowanego zaplecza technicznego, szybkie tworzenie wartościowych aplikacji opartych na rozbudowanych modelach językowych. Aplikacje te są nie tylko łatwe w obsłudze, ale również są zaprojektowane tak, aby można je było stale ulepszać.

Najważniejsze cechy:

- Przyjazna platforma LLMOps: Twórz i wizualnie zarządzaj aplikacjami AI, wykorzystując potencjał GPT-4.

- Kontekstowa sztuczna inteligencja: Użyj swoich dokumentów, treści internetowych lub notatek z Notion jako kontekstu dla sztucznej inteligencji. Dify obsługuje wstępne przetwarzanie, oszczędzając Twój czas.

- Wykorzystaj pełnię potencjału LLM: Dify zapewnia łatwy dostęp do modelu, osadzanie kontekstu, kontrolę kosztów oraz adnotacje danych, aby tworzenie sztucznej inteligencji było jak najbardziej płynne.

- Gotowe szablony: Wybieraj spośród szablonów dialogów i generowania tekstu, które możesz dostosować do swoich konkretnych potrzeb.

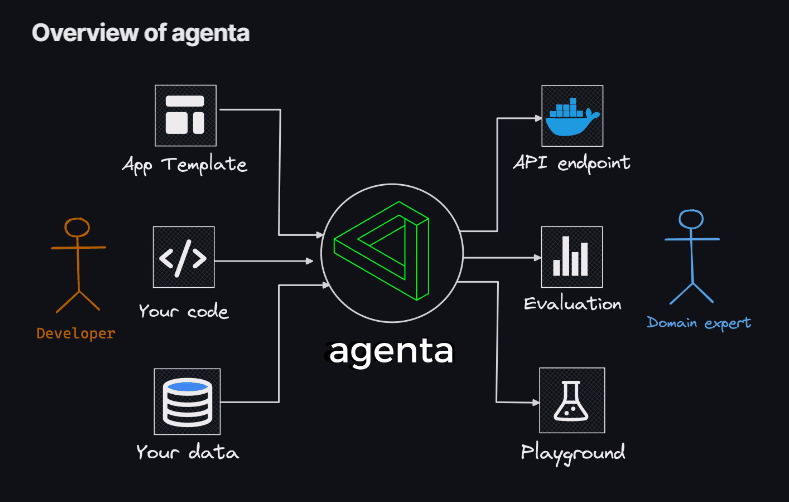

Agenta

Jeśli potrzebujesz elastyczności i chcesz wykorzystywać kod do tworzenia aplikacji LLM, bez ograniczeń w wyborze modeli, bibliotek i frameworków, to Agenta jest tym, czego szukasz. Agenta to wszechstronna platforma open source, stworzona w celu ułatwienia procesu implementacji zaawansowanych aplikacji opartych na modelach językowych (LLM) w środowisku produkcyjnym.

Agenta umożliwia szybkie eksperymentowanie, wersjonowanie podpowiedzi, parametrów i złożonych strategii. Obejmuje ona także uczenie się kontekstowe z osadzaniem, agentami i niestandardową logiką biznesową.

Najważniejsze cechy:

- Eksploracja parametrów: Definiuj parametry aplikacji w kodzie i bez problemu eksperymentuj z nimi za pomocą intuicyjnej platformy internetowej.

- Ocena wydajności: Sprawdź skuteczność swojej aplikacji na zestawach testowych, wykorzystując różne metody, takie jak dokładne dopasowanie, krytyka AI, ocena przez człowieka i inne.

- Struktura testowania: Twórz zestawy testowe za pomocą interfejsu użytkownika, przesyłając pliki CSV lub łącząc się z danymi poprzez API.

- Środowisko współpracy: Wspieraj pracę zespołową, udostępniając aplikację współpracownikom i zbierając ich opinie.

- Łatwe wdrażanie: Uruchom aplikację jako API jednym kliknięciem, upraszczając cały proces wdrożenia.

Dodatkowo, Agenta umożliwia współpracę z ekspertami z różnych dziedzin, co przyspiesza projektowanie i ocenę. Ważną zaletą Agenty jest też możliwość systematycznej oceny aplikacji LLM i ich wdrożenie za pomocą jednego kliknięcia.

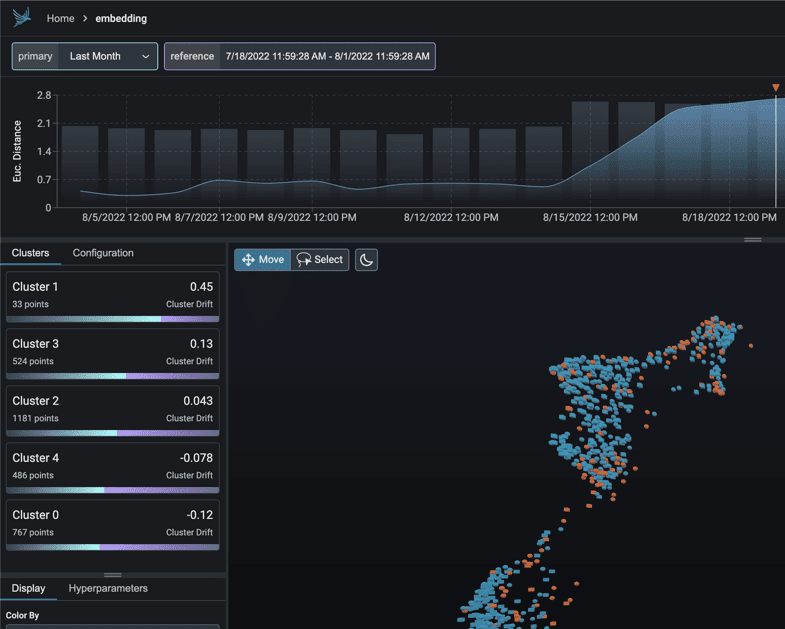

Phoenix

Z Phoenix wejdziesz w świat MLOps w mgnieniu oka. To narzędzie umożliwia płynną obserwację wydajności modelu, dryftu i jakości danych. Wszystko to bez konieczności skomplikowanej konfiguracji.

Phoenix, jako biblioteka Pythona stworzona z myślą o notebookach, wykorzystuje potencjał osadzania do odkrywania ukrytych zależności w modelach LLM, CV, NLP i tabelarycznych. Podnieś poziom swoich modeli z oprogramowaniem Phoenix.

Najważniejsze cechy:

- Wbudowane badanie dryftu: Analizuj chmury punktów UMAP w poszukiwaniu dużych odległości euklidesowych i precyzyjnych klastrów dryftu.

- Analiza dryftu i wydajności poprzez klastrowanie: Rozłóż dane na klastry, które charakteryzuje znaczący dryft lub niska wydajność, używając algorytmu HDBSCAN.

- Eksploracyjna analiza danych oparta na UMAP: Cieniuj chmury punktów UMAP, biorąc pod uwagę atrybuty, dryft i wydajność modelu, aby zidentyfikować problematyczne segmenty.

LangKit

LangKit to zestaw narzędzi open source do metryk tekstowych, zaprojektowany do efektywnego monitorowania zaawansowanych modeli językowych.

Powstanie LangKit wynika z potrzeby monitorowania ryzyka związanego z wdrożeniem modeli językowych, w tym LLM, w środowisku produkcyjnym. Ogromna liczba potencjalnych kombinacji wejść, przekłada się na równie dużą liczbę wyników, co stanowi poważne wyzwanie.

Najważniejsze cechy:

- Analiza iniekcji promptów: Ocenia podobieństwo do znanych ataków polegających na wstrzykiwaniu kodu do promptów.

- Analiza nastrojów: Ocenia emocjonalny wydźwięk tekstu.

- Ocena jakości tekstu: Sprawdza czytelność, złożoność i ocenę.

- Wykrywanie jailbreak: Identyfikuje wyniki podobne do znanych prób jailbreak.

- Analiza toksyczności: Wykrywa poziomy toksyczności w dostarczonej treści.

Niestrukturalny charakter tekstu dodatkowo komplikuje kwestię obserwowalności w uczeniu maszynowym. Brak wglądu w zachowanie modelu może mieć poważne konsekwencje.

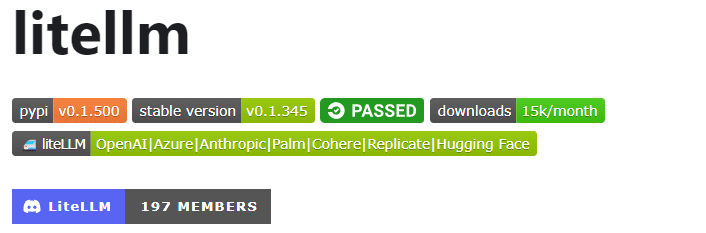

LiteLLM

Z LiteLLM uprościsz interakcję z różnymi API LLM – Anthropic, Huggingface, Cohere, Azure OpenAI i innymi – dzięki lekkiemu pakietowi w formacie OpenAI.

Ten pakiet usprawnia proces wywoływania punktów końcowych API od dostawców takich jak OpenAI, Azure, Cohere i Anthropic. Tłumaczy dane wejściowe na punkty końcowe uzupełniania i osadzania odpowiedniego dostawcy, gwarantując spójne wyniki. Odpowiedzi tekstowe są dostępne pod adresem [‘choices’][0][‘message’][‘content’].

Najważniejsze cechy:

- Usprawnione wywoływanie API LLM: Ułatwia interakcję z interfejsami API LLM, takimi jak Anthropic, Cohere, Azure OpenAI.

- Lekki pakiet: Kompaktowe rozwiązanie do wywoływania punktów końcowych API od OpenAI, Azure, Cohere, Anthropic.

- Tłumaczenie danych wejściowych: Zarządza tłumaczeniem danych wejściowych na punkty końcowe uzupełniania i osadzania odpowiedniego dostawcy.

- Mapowanie wyjątków: Mapuje typowe wyjątki u dostawców na typy wyjątków OpenAI, co zapewnia ujednoliconą obsługę błędów.

Pakiet zawiera również funkcję mapowania wyjątków. Wyrównuje standardowe wyjątki od różnych dostawców z typami wyjątków OpenAI, zapewniając spójność w obsłudze błędów.

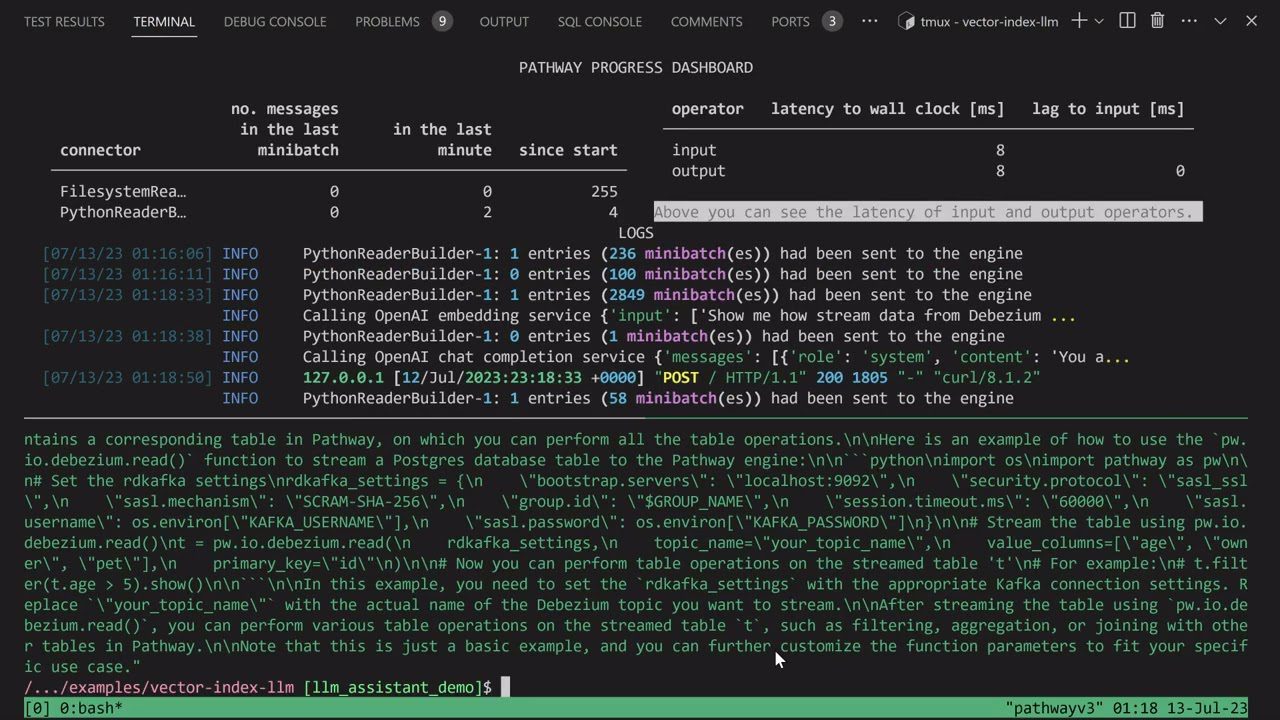

Aplikacja LLM

Wyrusz w podróż tworzenia unikalnego chatbota Discord AI, który potrafi odpowiadać na pytania, lub zgłębiaj podobne pomysły na boty AI. Te wszystkie funkcje łączy w sobie Aplikacja LLM.

Przedstawiam Pathways LLM-App – bibliotekę Pythona, która została starannie zaprojektowana, aby przyspieszyć rozwój nowatorskich aplikacji AI.

Najważniejsze cechy:

- Stworzona z myślą o lokalnych modelach ML: Aplikacja LLM jest przystosowana do pracy z lokalnymi modelami ML, w obrębie Twojej organizacji.

- Obsługa danych w czasie rzeczywistym: Ta biblioteka efektywnie zarządza źródłami danych na żywo, takimi jak kanały informacyjne, API i strumienie danych Kafki, z uwzględnieniem uprawnień użytkowników i zaawansowanych zabezpieczeń.

- Płynne sesje użytkowników: Proces generowania zapytań w bibliotece sprawnie obsługuje sesje użytkowników, zapewniając płynne interakcje.

Ten unikalny zasób umożliwia dostarczanie natychmiastowych odpowiedzi, które odzwierciedlają interakcje międzyludzkie podczas odpowiadania na pytania użytkowników. Realizuje to zadanie, skutecznie czerpiąc z najnowszych informacji ukrytych w źródłach danych.

Przepływy LLMF

Przepływy LLMF to platforma, która ma na celu uproszczenie, wyjaśnienie i zwiększenie przejrzystości podczas tworzenia aplikacji opartych na modelach językowych (LLM), takich jak chatboty, systemy odpowiadania na pytania i agenci.

W rzeczywistych scenariuszach złożoność może się zwiększyć ze względu na skomplikowane zależności między promptami a wywołaniami LLM.

Twórcy LLMFlows przewidzieli jawne API, które umożliwi użytkownikom tworzenie czystego i zrozumiałego kodu. To API ułatwia tworzenie złożonych interakcji LLM, zapewniając płynny przepływ między różnymi modelami.

Najważniejsze cechy:

- Bezproblemowo konfiguruj klasy LLM, starannie wybierając modele, parametry i ustawienia.

- Zapewnij niezawodne interakcje LLM z automatycznymi ponownymi próbami w przypadku niepowodzeń wywołań, gwarantując stabilność.

- Zoptymalizuj wydajność, wykorzystując przepływy asynchroniczne do równoległego wykonywania LLM, kiedy są dostępne dane wejściowe.

- Wprowadź niestandardowe funkcje manipulacji ciągami bezpośrednio do przepływów, ułatwiając transformację tekstu poza wywołaniami LLM.

- Utrzymuj pełną kontrolę i nadzór nad aplikacjami opartymi na LLM, dzięki wywołaniom zwrotnym, które umożliwiają kompleksowe monitorowanie i wgląd w procesy.

Klasy LLMFlows dają użytkownikom pełną kontrolę, bez ukrytych podpowiedzi i wywołań LLM.

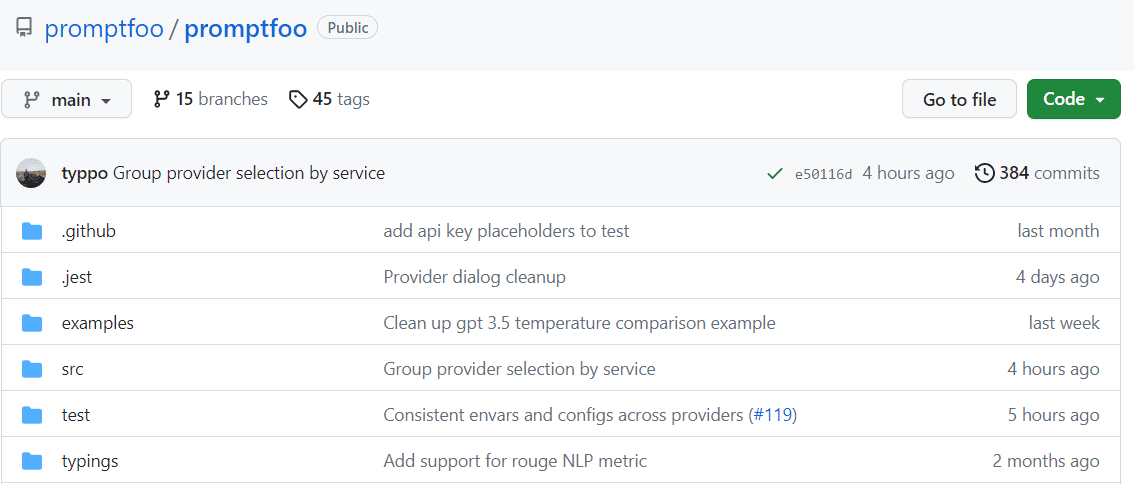

Promptfoo

Z Promptfoo przyspieszysz ocenę, dzięki buforowaniu i równoczesnemu testowaniu. Promptfoo, dostarczając interfejs wiersza poleceń (CLI) i bibliotekę, umożliwia ocenę jakości wyników LLM.

Najważniejsze cechy:

- Niezawodność: Promptfoo został zaprojektowany do oceny i ulepszania aplikacji LLM, które obsługują ponad 10 milionów użytkowników w środowisku produkcyjnym. Dostępne narzędzia są elastyczne i można je dostosować do różnych konfiguracji.

- Łatwe w użyciu przypadki testowe: Definiuj oceny bez kodowania, unikając trudności związanych z nieporęcznymi notatnikami. Proste, deklaratywne podejście usprawnia cały proces.

- Elastyczność językowa: Niezależnie od tego, czy preferujesz Pythona, JavaScript czy inny język, Promptfoo dostosuje się do Twoich potrzeb.

Ponadto, Promptfoo umożliwia systematyczne testowanie podpowiedzi w oparciu o wcześniej zdefiniowane przypadki testowe. Pomaga to w ocenie jakości i identyfikacji regresji, umożliwiając bezpośrednie porównanie wyników LLM.

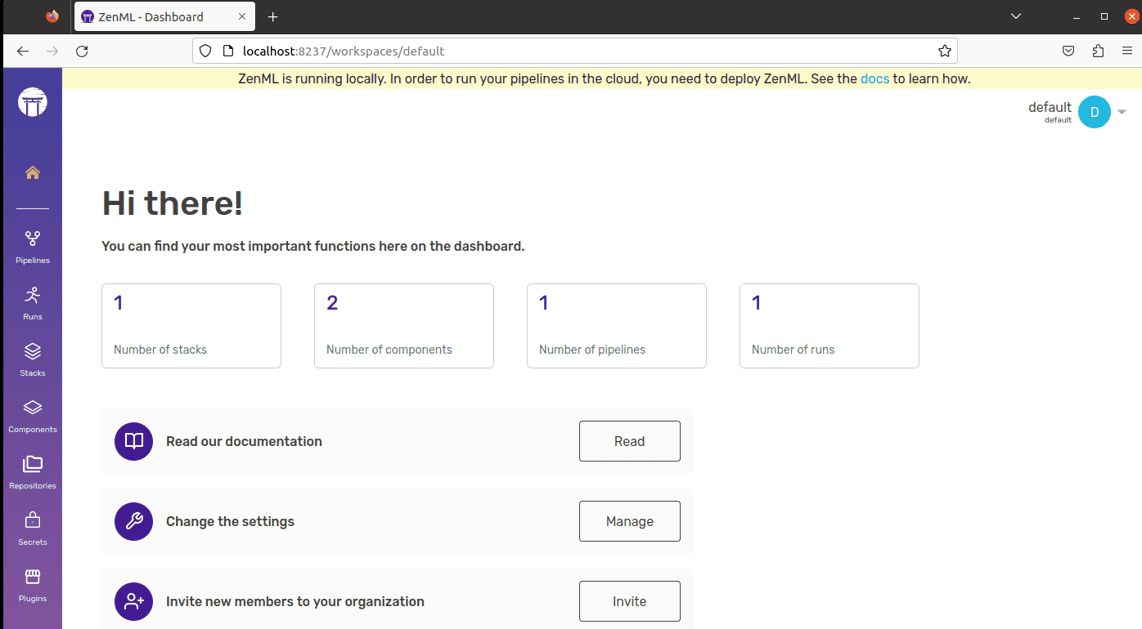

ZenML

Poznaj ZenML – elastyczne narzędzie typu open source, stworzone z myślą o profesjonalistach i organizacjach, które korzystają z procesów uczenia maszynowego. Wyobraź sobie, że dysponujesz narzędziem, które pozwala tworzyć potoki uczenia maszynowego, które są gotowe do zastosowania w praktyce, niezależnie od skomplikowania Twojego projektu.

ZenML oddziela aspekty techniczne od kodu, ułatwiając współpracę między programistami, analitykami danych, ekspertami MLOps i inżynierami ML. Dzięki temu Twoje projekty płynnie przechodzą od pomysłu do gotowego rozwiązania.

Najważniejsze cechy:

- Dla badaczy danych: Skup się na tworzeniu i testowaniu modeli, a ZenML przygotuje Twój kod do rzeczywistego użycia.

- Dla ekspertów ds. infrastruktury MLOps: Szybko konfiguruj, zarządzaj i wdrażaj zaawansowane systemy, aby Twoi współpracownicy mogli z nich korzystać bez problemów.

- Dla inżynierów ML: Obsługuj każdy etap projektu uczenia maszynowego, od początku do końca, z pomocą ZenML. Oznacza to mniej przekazywania zadań i lepszą kontrolę nad procesem.

ZenML jest przeznaczone dla każdego – zarówno dla profesjonalistów, jak i dla organizacji. Zapewnia sposób pisania kodu, który jest przeznaczony do zadań uczenia maszynowego i działa z dowolną usługą w chmurze lub narzędziem. Dodatkowo, pomaga w zarządzaniu projektem w jednym miejscu, dzięki czemu nie musisz się martwić żonglowaniem różnymi elementami. Po prostu napisz swój kod raz i korzystaj z niego w innych systemach.

Podsumowanie

W tej fascynującej podróży pamiętaj, że każda platforma ma swój unikalny potencjał, który może pomóc Ci w realizacji Twoich aspiracji związanych ze sztuczną inteligencją. Twój wybór ma moc kształtowania Twojej ścieżki, więc dokonuj go rozważnie!

Zachęcam Cię również do zapoznania się z narzędziami AI dla programistów, które pomogą Ci szybciej tworzyć aplikacje.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.