TensorFlow to otwarta platforma, stworzona przez Google, która wspiera rozwój uczenia maszynowego i sztucznej inteligencji. Ułatwia programistom realizację różnorodnych zadań w tych obszarach.

Zanim rozpoczniesz pracę z TensorFlow, kluczowe jest zrozumienie zasad uczenia maszynowego, a w szczególności głębokiego uczenia.

W tym artykule przybliżę Ci TensorFlow, opiszę jego funkcje oraz przedstawię szybkie metody instalacji w systemach Windows i Linux.

TensorFlow – wprowadzenie

TensorFlow to platforma o otwartym kodzie źródłowym, która pomaga w tworzeniu aplikacji opartych na głębokim uczeniu i innych zastosowaniach uczenia maszynowego.

Usprawnia tworzenie i wdrażanie aplikacji wykorzystujących uczenie maszynowe. Jeśli szukasz rozwiązania problemu za pomocą ML, TensorFlow może okazać się nieoceniony.

Platforma udostępnia narzędzia umożliwiające projektowanie i trenowanie modeli z użyciem języka Python lub JavaScript. Choć nie jestem programistą, polecam zapoznanie się z dokumentacją, aby zrozumieć, jak TensorFlow może usprawnić proces wdrażania aplikacji uczenia maszynowego.

Funkcjonalności TensorFlow

TensorFlow cieszy się popularnością z wielu powodów. Samodzielnie ocenisz jego możliwości, gdy poznasz jego najważniejsze cechy.

Analizując aspekty techniczne, należy odnieść je do swoich potrzeb. Skupmy się zatem na ogólnych funkcjach, które są przydatne dla większości użytkowników.

1. Otwarty kod źródłowy

W 2015 roku Google udostępniło TensorFlow jako projekt open source, umożliwiając społeczności jego dalsze rozwijanie i zapewniając transparentność jego działania.

Programiści mogą w różnorodny sposób dostosować bibliotekę do rozwiązywania nieoczekiwanych problemów.

Bez otwartej struktury, TensorFlow prawdopodobnie nie osiągnąłby obecnej popularności.

2. Łatwe debugowanie

TensorFlow został zaprojektowany tak, aby ułatwiać tworzenie modeli, dlatego bezproblemowe debugowanie jest jego integralną częścią.

Dodatkowym atutem jest intuicyjny interfejs użytkownika.

3. Wsparcie dla procesorów CPU i GPU

TensorFlow umożliwia trenowanie danych zarówno na procesorach CPU, jak i GPU. Zazwyczaj GPU znacząco przyspiesza działanie aplikacji głębokiego uczenia w porównaniu do CPU.

Jeśli dysponujesz wydajnym procesorem graficznym, TensorFlow pozwoli Ci w pełni wykorzystać jego możliwości.

4. Przydatne API uczenia maszynowego

Interfejsy API ułatwiają programistom integrację różnych funkcji z aplikacjami. TensorFlow oferuje dostęp do obszernego zbioru stabilnych API.

Niektóre z nich mogą również poprawić wydajność. Oficjalne zapewnienia gwarantują, że te dostępne w Pythonie nie sprawią Ci kłopotów. W przypadku innych języków, sprawdź u twórców TensorFlow, czy są one odpowiednie dla Twojego przypadku.

5. Gotowe modele do zastosowania

TensorFlow zawiera wiele wstępnie wytrenowanych modeli. Niezależnie od Twojego doświadczenia, możesz ich użyć, aby oszczędzić czas i szybciej tworzyć modele ML.

Poza tymi funkcjami, zyskujesz elastyczność, prostotę obsługi, narzędzia do wizualizacji i wiele innych elementów, które mogą wesprzeć Twój proces programowania w dziedzinie uczenia maszynowego.

Skoro masz już ogólne pojęcie o TensorFlow, gdzie możesz go pobrać? Jak go zainstalować i skonfigurować w systemach Windows i Linux?

Omówimy to poniżej.

Pobieranie i instalacja TensorFlow

W przeciwieństwie do innych programów, tutaj nie otrzymasz pliku instalacyjnego .exe. Najpierw musisz pobrać pakiet za pomocą preferowanego menedżera pakietów.

Ogólnie, istnieje kilka sposobów instalacji, które możemy sklasyfikować w następujący sposób:

- Z wykorzystaniem Minicondy i pip

- Z wykorzystaniem Minicondy i pip w WSL 2

- Z wykorzystaniem kontenera Docker

- Budowa ze źródeł

Jak zainstalować TensorFlow w systemie Windows?

Podobnie jak w przypadku innych programów, nie otrzymasz tutaj pliku instalacyjnego .exe. Będziesz musiał pobrać pakiet za pomocą zalecanego menedżera pakietów.

#1. Użycie Minicondy i pip (metoda zalecana)

Uwaga: W momencie pisania tego tekstu, TensorFlow 2.10 jest ostatnią wersją obsługującą GPU w systemie Windows natywnie. W przypadku nowszych pakietów TensorFlow zaleca instalację w WSL 2, co zostanie omówione dalej.

Aby używać TensorFlow z obsługą GPU, zaleca się skorzystanie z Minicondy (instalatora menedżera pakietów conda).

Dzięki Minicondzie możesz stworzyć odizolowane środowisko, unikając konfliktów z innym oprogramowaniem w systemie.

Aby rozpocząć, pobierz najnowszy instalator Miniconda Windows Installer i postępuj zgodnie z instrukcjami wyświetlanymi na ekranie, aby zakończyć instalację.

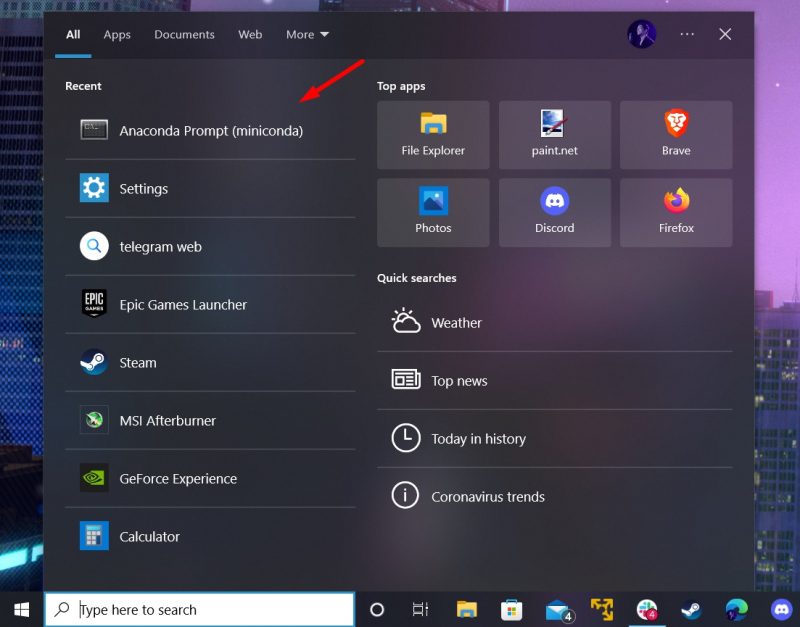

Po zakończeniu uruchom wiersz poleceń Miniconda, jak pokazano na zrzucie ekranu:

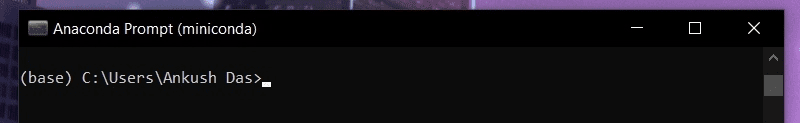

Tak to wygląda:

Po uruchomieniu wiersza poleceń Anacondy wpisz poniższe polecenie, aby zaktualizować menedżer pakietów conda:

conda update -n base -c defaults conda

Następnie, wykonaj kroki konieczne do zainstalowania TensorFlow:

Najpierw, utwórz nowe środowisko (o nazwie tf):

conda create --name tf python=3.9

Wskazówka: Możesz je aktywować/dezaktywować za pomocą poleceń: conda activate tf i conda deactivate

Aby przejść dalej, musisz je aktywować. W celu włączenia obsługi GPU, upewnij się, że masz zainstalowany sterownik karty graficznej (NVIDIA), a następnie zainstaluj kilka pakietów za pomocą poniższego polecenia:

conda install -c conda-forge cudatoolkit=11.2 cudnn=8.1.0

Zostanie pobrany około 1 gigabajt pakietów, które zawierają narzędzia do wdrażania aplikacji uczenia maszynowego z wykorzystaniem GPU i głębokiej sieci neuronowej.

Ostatecznie, użyj menedżera pakietów pip, aby zainstalować pakiet TensorFlow. Możesz zainstalować TensorFlow za pomocą conda, ale może on nie zawierać najnowszej stabilnej wersji.

Przed kontynuacją, upewnij się, że pip został zaktualizowany za pomocą polecenia:

pip install --upgrade pip

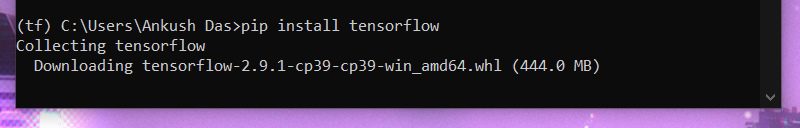

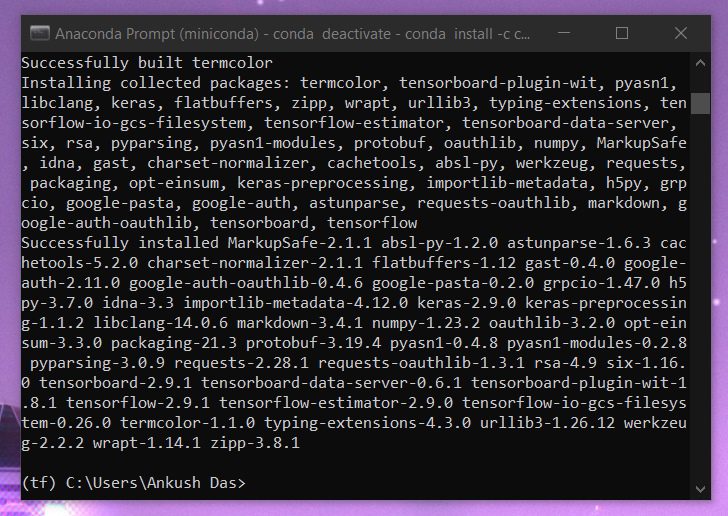

Po zakończeniu, zainstaluj TensorFlow za pomocą:

pip install tensorflow

Zauważysz, że budowanych/instalowanych jest wiele pakietów. Może się wydawać, że proces się zawiesił, ale daj mu chwilę, a powinien wznowić i dokończyć instalację.

#2. Użycie Condy i pip w WSL 2

Zakładając, że masz już skonfigurowane WSL 2, możesz zainstalować TensorFlow za pomocą poniższych poleceń w terminalu dystrybucji:

conda install -c conda-forge cudatoolkit=11.2 cudnn=8.1.0

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:$CONDA_PREFIX/lib/

python3 -m pip install tensorflow

# Verify install:

python3 -c "import tensorflow as tf; print(tf.config.list_physical_devices('GPU'))"

Możesz wkleić to wszystko naraz, a polecenia będą przetwarzane jedno po drugim.

Jeśli nie masz zainstalowanego WSL 2, uruchom wiersz polecenia z uprawnieniami administratora i wpisz następujące polecenie:

wsl.exe --install

Pobierze on Ubuntu i włączy funkcję WSL. Aby dokończyć instalację, musisz ponownie uruchomić komputer.

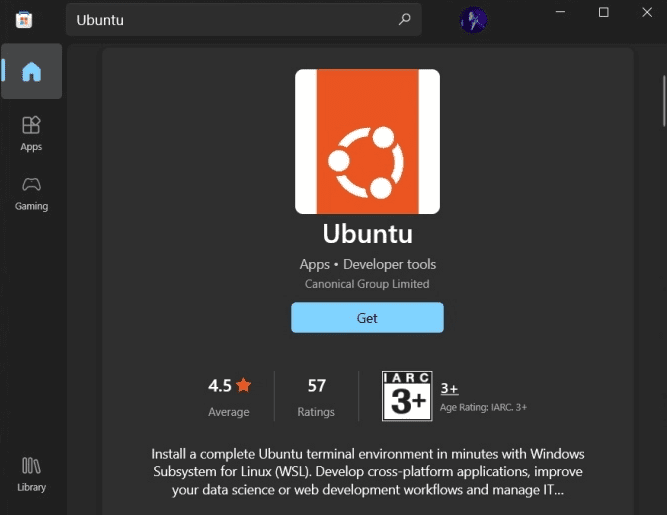

Jeśli nie możesz znaleźć Ubuntu w systemie, możesz przejść do Microsoft Store i zainstalować Ubuntu WSL.

#3. Budowa ze źródeł

Ponieważ TensorFlow jest oprogramowaniem open source, możesz je zbudować od podstaw, korzystając z opcji konfiguracyjnych.

To rozwiązanie jest zalecane dla zaawansowanych użytkowników, którzy znają wszystkie opcje i tajniki konfiguracji. Szczegółowe informacje znajdziesz w oficjalnej dokumentacji.

Jak zainstalować TensorFlow w systemie Linux?

Podobnie jak w systemie Windows, możesz zainstalować TensorFlow za pomocą Minicondy i pip. Możesz również wybrać budowę ze źródeł.

Poniżej pokażę, jak to zrobić:

#1. Użycie Minicondy i pip (metoda zalecana)

Uwaga: postępuj zgodnie z tymi samymi poleceniami, co w systemie Windows. Jedyną różnicą jest sposób instalacji/pobierania Minicondy w systemie Linux.

Oto, jak zainstalować Minicondę w systemie Linux za pomocą terminala:

curl https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh -o Miniconda3-latest-Linux-x86_64.sh bash Miniconda3-latest-Linux-x86_64.sh

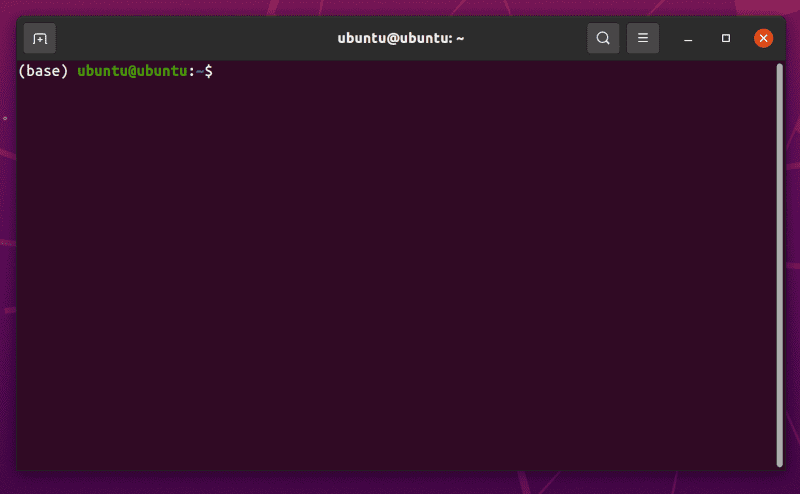

Uruchom ponownie terminal, aby zobaczyć coś takiego:

Zauważysz „(base)” przed zmiennymi zachęty terminala. Oznacza to, że conda jest aktywna i zainstalowana.

Nie dezaktywuj jej, dopóki nie zakończysz instalacji TensorFlow.

Możesz przejść do kroków opisanych dla systemu Windows i zainstalować pakiet. Możesz też wkleić poniższy kod, aby zainstalować TensorFlow:

conda install -c conda-forge cudatoolkit=11.2 cudnn=8.1.0

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:$CONDA_PREFIX/lib/

python3 -m pip install tensorflow

# Verify install:

python3 -c "import tensorflow as tf; print(tf.config.list_physical_devices('GPU'))"

W systemie Linux mogą wystąpić problemy ze sterownikiem GPU. W takim przypadku powinieneś zapoznać się z dokumentacją NVIDIA.

#2. Budowa ze źródeł

Podobnie jak w systemie Windows, budowanie ze źródeł jest zaawansowanym procesem i jest przeznaczone dla doświadczonych użytkowników.

Ty (zakładając, że jesteś początkującym) nie powinieneś wybierać tej metody, chyba że masz konkretne powody. Najlepszym sposobem na zdobycie wiedzy w tym zakresie jest zapoznanie się z dokumentacją.

Jak zainstalować TensorFlow za pomocą Dockera? (Windows i Linux)

Docker umożliwia bezproblemową instalację obrazów TensorFlow, niezależnie od platformy.

Upewnij się, że masz zainstalowanego Dockera. Jeśli potrzebujesz pomocy, skorzystaj z naszego poradnika instalacji Dockera.

Po zakończeniu konfiguracji, w Dockerze wprowadź poniższe polecenie:

docker pull tensorflow/tensorflow

Potrzebujesz wiedzy o kontenerach Docker, aby uruchomić kontener z konfiguracjami niezbędnymi do działania.

Aby uzyskać szczegółową obsługę GPU lub pobrać inną wersję TensorFlow, zapoznaj się z opcjami dostępnymi w oficjalnej dokumentacji.

Oto, jak wygląda polecenie, gdy chcesz je uruchomić za pomocą Dockera:

docker run [-it] [--rm] [-p hostPort:containerPort] tensorflow/tensorflow[:tag] [command]

Podsumowanie

Instalacja TensorFlow jest jednorazową czynnością, a dzięki temu przewodnikowi, dla większości powinna być prostym procesem.

Jeśli masz wcześniejsze konfiguracje lub ustawienia ze starszymi wersjami Pythona lub starszego menedżera pakietów Conda, zadbaj o najnowsze aktualizacje, aby bez problemów zainstalować TensorFlow.

Możesz również zapoznać się z najlepszymi platformami AI do tworzenia aplikacji AI i ML.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.