Wiele firm korzysta z technik web scrapingu, aby pozyskiwać informacje z sieci, porządkować je i analizować, co z kolei wspiera ich działalność.

Jednakże, ręczne gromadzenie danych ze stron internetowych, poprzez przeglądanie setek witryn i ciągłe wyciąganie z nich danych, może stać się żmudne i obarczone ryzykiem.

Możesz napotkać na ograniczenia geograficzne lub zostać zablokowanym na tych stronach, ponieważ każda z nich dba o ochronę swoich danych.

W związku z tym, korzystnym rozwiązaniem może być użycie narzędzia takiego jak kolektor danych.

Sprawny kolektor danych umożliwi szybkie, bezpieczne i pewne gromadzenie informacji. W rezultacie, będziesz mógł wykorzystywać wysokiej jakości dane do prognozowania, usprawniania procesów i kształtowania działań firmy.

W tym artykule omówimy, czym jest gromadzenie danych, jakie są jego rodzaje oraz stosowane techniki. Na koniec, przedstawimy kilka polecanych narzędzi do zbierania danych.

Zaczynajmy!

Czym jest gromadzenie danych?

Gromadzenie danych to proces, w którym zbiera się i analizuje określone informacje, aby odpowiedzieć na konkretne pytania oraz ocenić rezultaty. Jego celem jest dogłębne zbadanie danego tematu. Po zebraniu danych, są one poddawane weryfikacji hipotez, w celu wyjaśnienia konkretnych zjawisk lub zdarzeń.

Dane gromadzi się z różnych powodów, na przykład, aby przewidywać przyszłe trendy i prawdopodobieństwa.

Narzędziem ułatwiającym ten proces jest kolektor danych lub oprogramowanie do zbierania danych. Posiada ono bogate funkcje i zalety, wspierające pełen proces gromadzenia danych.

Rodzaje gromadzenia danych

Proces gromadzenia danych dzieli się na dwie główne kategorie: gromadzenie danych pierwotnych i wtórnych.

Gromadzenie danych pierwotnych

Gromadzenie danych pierwotnych polega na pozyskiwaniu nieprzetworzonych danych bezpośrednio ze źródła lub oryginalnych danych w konkretnym celu, takim jak web scraping, badania czy inne zastosowanie. Dzieli się na dwa typy:

- Gromadzenie danych ilościowych: Istnieje wiele metod zbierania danych ilościowych, np. telefonicznie, mailowo, online lub podczas spotkań osobistych. Metody te wykorzystują obliczenia matematyczne do analizy i są przedstawiane w formie liczb. Przykładami mogą być kwestionariusze z pytaniami zamkniętymi, regresja, mediana, średnia i moda.

- Badania jakościowe: Jest to metoda pozyskiwania danych, która nie wymaga operacji matematycznych ani liczb. Opiera się na elementach niemierzalnych, takich jak emocje lub odczucia badanej osoby. Techniki te mogą obejmować kwestionariusze z pytaniami otwartymi, wywiady pogłębione, ankiety online oraz dane z grup, forów, i społeczności internetowych.

Gromadzenie danych wtórnych

Gromadzenie danych wtórnych oznacza korzystanie z informacji zebranych przez kogoś innego, a nie przez użytkownika pierwotnego. W tym procesie pozyskujemy dane z już opublikowanych materiałów, takich jak książki, portale internetowe, czasopisma itd. Jest to proces prostszy i tańszy.

W tego rodzaju gromadzeniu danych, mamy dostęp do informacji, które zostały już przeanalizowane. Wtórne gromadzenie danych dzieli się na dwa typy:

- Dane opublikowane: mogą to być publikacje rządowe, podcasty, strony internetowe, rejestry publiczne, dokumenty statystyczne i historyczne, czasopisma branżowe, pliki techniczne, dokumenty biznesowe itd.

- Dane nieopublikowane: mogą pochodzić z listów, pamiętników i nieopublikowanych biografii.

Wybór między pierwotnym a wtórnym gromadzeniem danych zależy od specyfiki badania, rodzaju niszy, dostępnych środków, celu projektu i innych czynników. Należy wybrać metodę, która najlepiej odpowiada danym potrzebom, aby podejmować trafne decyzje.

Korzyści z narzędzia do gromadzenia danych

Jak wspomniano wcześniej, narzędzie do gromadzenia danych to oprogramowanie, które służy do pozyskiwania informacji za pomocą kwestionariuszy papierowych, ankiet, analiz studiów przypadków, badań, obserwacji itp.

Ponieważ badania, analizy, studia lub web scraping są przeprowadzane w różnych celach, musisz upewnić się, że gromadzisz prawdziwe dane wysokiej jakości, aby uzyskać wiarygodne rozwiązania. W tym celu, konieczne jest wykorzystanie solidnego narzędzia do gromadzenia danych. Oferuje ono szereg funkcji i zalet, które sprawiają, że proces gromadzenia danych jest prosty i efektywny.

Oto niektóre z korzyści wynikających z używania narzędzia do gromadzenia danych.

Precyzja

Nowoczesne narzędzia do gromadzenia danych oferują obszerną bazę wiarygodnych informacji. Baza ta jest regularnie aktualizowana, dostarczając świeże i aktualne dane, które są istotne i precyzyjne.

Szybsze działanie

Kolektory danych przyspieszają proces przeszukiwania sieci lub badań. Dzieje się tak dlatego, że są one połączone z obszerną bazą danych, zawierającą przydatne informacje, do których można uzyskać dostęp z dowolnego miejsca i w dowolnym czasie za pomocą kilku kliknięć. Pozwala to na prowadzenie badań w podróży, w biurze lub w domu, co przyspiesza cały proces zbierania danych i oszczędza czas.

Mniej błędów

Ręczne gromadzenie danych może być obarczone błędami ludzkimi. Korzystanie z dedykowanego narzędzia do gromadzenia danych zapewnia dokładność i spójność informacji, które będą wspierać procesy biznesowe i realizację celów, pomagając zachować integralność badań, studiów i web scrapingu.

Lepsze rezultaty

Dzięki dostępowi do kompletnych, wiarygodnych, bezbłędnych i istotnych danych, uzyskanych za pomocą narzędzia do gromadzenia danych, możliwe jest osiągnięcie lepszych wyników. Zamiast borykać się z błędami, które mogą prowadzić do problemów, precyzyjne i kompletne dane pomogą podejmować lepsze decyzje biznesowe i dokonywać trafnych prognoz.

Gromadzenie danych a tradycyjne rozwiązania do zbierania danych z sieci

Tradycyjne narzędzia do web scrapingu, choć wszechstronne, mogą być czasochłonne i wymagające. Jest to szczególnie widoczne w przypadku dużych wolumenów danych. Internet zawiera ogromną ilość informacji, pochodzących z ankiet, forów, stron internetowych i raportów, a wyodrębnienie z nich istotnych, użytecznych danych stanowi wyzwanie.

Z kolei, korzystając z zaawansowanego narzędzia do zbierania danych, takiego jak Bright Data Collector, można szybko i łatwo pozyskiwać dane, w bardziej dynamiczny sposób.

Ze względu na dużą liczbę dostępnych kolektorów danych, wiele osób ma trudności z wyborem odpowiedniego narzędzia. Oto kilka wskazówek, jak wybrać najlepsze narzędzie do gromadzenia danych, odpowiadające konkretnym potrzebom.

Jak wybrać odpowiednie narzędzie do gromadzenia danych?

Wybierając narzędzie do zbierania danych, należy zwrócić uwagę na następujące aspekty:

- Przydatne funkcje: wybierz kolektor danych, który ma funkcje przydatne w Twoich działaniach. Oceń swoje potrzeby, a następnie wybierz narzędzie, które oferuje funkcje, z których będziesz realnie korzystać. Powinno ono również integrować się z innymi narzędziami, aby ułatwić pracę za pomocą jednego rozwiązania.

- Łatwość obsługi: Aby w pełni wykorzystać możliwości kolektora danych, wybierz taki, który jest prosty w obsłudze. Musi mieć przejrzysty i funkcjonalny interfejs, łatwą nawigację i intuicyjny dostęp.

- Dostępność cenowa: zainwestuj w narzędzie, które mieści się w Twoim budżecie, ale ma bogaty zestaw przydatnych funkcji. Chodzi o znalezienie równowagi. Sprawdź również, czy dostępna jest darmowa wersja próbna, aby przetestować działanie narzędzia.

Jeśli poszukujesz dobrego narzędzia do zbierania danych, Bright Data Collector może być właściwym wyborem. Przyjrzyjmy się bliżej temu rozwiązaniu, aby ocenić, czy będzie ono odpowiednie w Twoim przypadku.

Jak Bright Data może pomóc?

Bright Data Collector to jedna z najlepszych platform do gromadzenia danych i web scrapingu. Pozwala na pozyskiwanie danych z internetu na dużą skalę, bez konieczności posiadania własnej infrastruktury. Umożliwia szybkie wyodrębnienie publicznie dostępnych informacji z dowolnej witryny, realizując potrzeby związane z web scrapingiem lub badaniami.

Możesz wybrać pobieranie danych w partiach lub w czasie rzeczywistym. Wystarczy ocenić swoje wymagania i skorzystać z Bright Data Collector, aby je zaspokoić.

Bright Data Collector: kluczowe cechy

Oto niektóre z kluczowych funkcji Bright Data Collector:

Platforma bez kodu

Uprość działania związane z web scrapingiem dzięki platformie Bright Data Collector, która nie wymaga kodowania. Oznacza to, że nie trzeba pisać kodu, aby korzystać z tego narzędzia i skutecznie przeprowadzać web scraping.

Wcześniej proces ten był złożony i wymagał od programistów prawidłowej konfiguracji narzędzia. Wymagało to również specjalistów w dziedzinie pozyskiwania danych, scrapingu i zarządzania proxy.

Dzięki platformie bez kodu, Bright Data Collector staje się łatwy w obsłudze dla wszystkich użytkowników, bez względu na to, czy są programistami, czy ekspertami w zakresie ekstrakcji danych. Pozwala to zaoszczędzić wiele czasu i zasobów, które można wykorzystać na inne, ważne zadania.

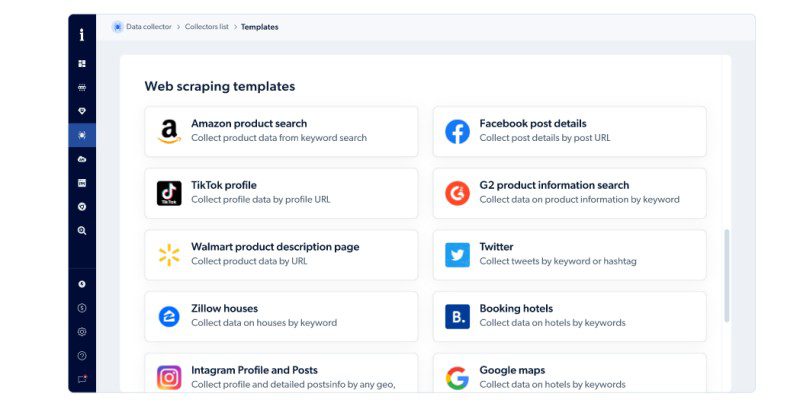

Gotowe szablony i funkcje kodowania

Hostowane rozwiązanie Bright Data oferuje gotowe szablony i funkcje kodowania, co ułatwia tworzenie narzędzia do web scrapingu na dużą skalę. Dzięki temu, możesz szybciej zbierać publicznie dostępne dane w czasie rzeczywistym za pomocą środowiska IDE JavaScript. Możesz również połączyć API z procesami pracy i cieszyć się usprawnionym procesem gromadzenia danych.

Bright Data Collector oferuje szablony web scrapingu dla wyszukiwań produktów na Amazon, domów na Zillow, profili i postów na Instagramie, Map Google, Twittera, detali postów na Facebooku, stron produktów Walmart i innych.

Bezproblemowa struktura

Bright Data Collector wykorzystuje algorytmy sztucznej inteligencji do automatycznego dopasowywania, czyszczenia, przetwarzania, strukturyzowania i syntezy nieustrukturyzowanych danych ze stron internetowych, przed ich dostarczeniem. Dzięki temu, otrzymane zbiory danych są szybciej gotowe do analizy.

Zautomatyzowana elastyczność

Struktura stron internetowych ulega ciągłym zmianom, dlatego pobieranie z nich danych może być trudne. Bright Data Collector oferuje znakomite rozwiązanie tego problemu. Szybko dostosowuje się do zmian strukturalnych na stronach i wyodrębnia potrzebne dane, które mogą wspierać proces analizy.

Skalowalność na poziomie korporacyjnym

Gromadzenie danych na dużą skalę wymaga solidnej infrastruktury sprzętowej i programowej, a także czasu i zasobów, co może stanowić przeszkodę dla organizacji o ograniczonych budżetach.

Bright Data Collector może w tym pomóc, pozwalając na gromadzenie dokładnych i użytecznych danych łatwo i niezawodnie na dużą skalę, bez konieczności inwestowania w kosztowną infrastrukturę.

Zgodność

Przestrzeganie obowiązujących przepisów i regulacji jest niezwykle istotne. Chronią one nie tylko przed karami, ale także pomagają utrzymać zaufanie klientów i pracowników.

Bright Data Collector jest w pełni zgodny z przepisami o ochronie danych, w tym RODO, UE i CCPA, co pozwala na bezpieczne przeprowadzanie web scrapingu. Dzięki temu, możliwe jest szybkie przejście audytów.

Wszechstronność

Firma Bright Data Collector opracowała najlepsze praktyki i kompleksowe wytyczne dotyczące korzystania z platformy, przy jednoczesnym zapewnieniu ochrony danych, dlatego jest ona zaufana przez korporacje różnej wielkości, a także rządy i uniwersytety.

Solidna infrastruktura sieci proxy

Bright Data posiada zaawansowaną infrastrukturę sieci proxy, na której opiera się Data Collector. Dzięki temu nie napotkasz trudności z dostępem do żadnej publicznej strony internetowej. Pokonuje ona wszelkie przeszkody, takie jak ograniczenia geograficzne, dostępność itp. Możesz więc pozyskiwać dane z każdego publicznie dostępnego źródła.

Wsparcie biznesowe

Możesz korzystać z tej platformy samodzielnie lub wykorzystać jej zasoby programistyczne. Dostępni programiści, menedżerowie produktów i kont, pomogą Ci na każdym etapie w rozwiązywaniu problemów biznesowych i zaspokajaniu potrzeb, aby wspierać rozwój firmy.

Jak działa Bright Data Collector?

Korzystanie z Bright Data Collector nie wymaga specjalistycznej wiedzy z zakresu kodowania lub web scrapingu. Platformę można łatwo zainstalować i używać bez pomocy zewnętrznej.

Praca z tym narzędziem obejmuje trzy proste kroki:

Wybierz szablon

Wybierz gotowy szablon z dostępnych opcji, który odpowiada Twoim potrzebom. Możesz również stworzyć własny szablon od podstaw, zamiast korzystać z gotowych rozwiązań.

Na przykład, jeśli poszukujesz list produktów na Amazon, możesz wykorzystać szablon do wyszukiwania produktów Amazon.

Dostosuj

Kolejnym krokiem jest dostosowanie lub opracowanie web scrapera przy użyciu gotowych funkcji Bright Data Collector.

Jeśli nie masz umiejętności kodowania, to nie problem. To rozwiązanie bez kodu umożliwia tworzenie web scrapera od podstaw. Jeśli jednak potrafisz programować, masz znacznie więcej możliwości. Możesz edytować kod, aby skraper lepiej odpowiadał Twoim wymaganiom.

Dane w czasie rzeczywistym lub partiami

Po utworzeniu web scrapera dla danego zastosowania, wybierz sposób pozyskiwania danych – w czasie rzeczywistym lub partiami. Częstotliwość pobierania danych zależy od Twoich potrzeb. Oceń najpierw swoje wymagania, a następnie wybierz odpowiednią opcję, aby przejść do następnego etapu.

Format i dostawa

W tym kroku należy wybrać format pliku, w którym mają zostać zapisane pobrane dane. Może to być CSV, JSON, XLSX lub NDJSON.

Następnie należy wybrać sposób przesyłania zebranych danych. Dostępne są opcje: e-mail, webhook, API, Google Cloud, Amazon S3, MS Azure i SFTP.

Obsługa klienta

Jeśli napotkasz problemy, możesz skorzystać z całodobowej pomocy technicznej Bright Data. Zapewnia ona profesjonalne i sprawne wsparcie, które pomoże rozwiązać Twoje problemy o każdej porze.

Ceny: Bright Data Collector

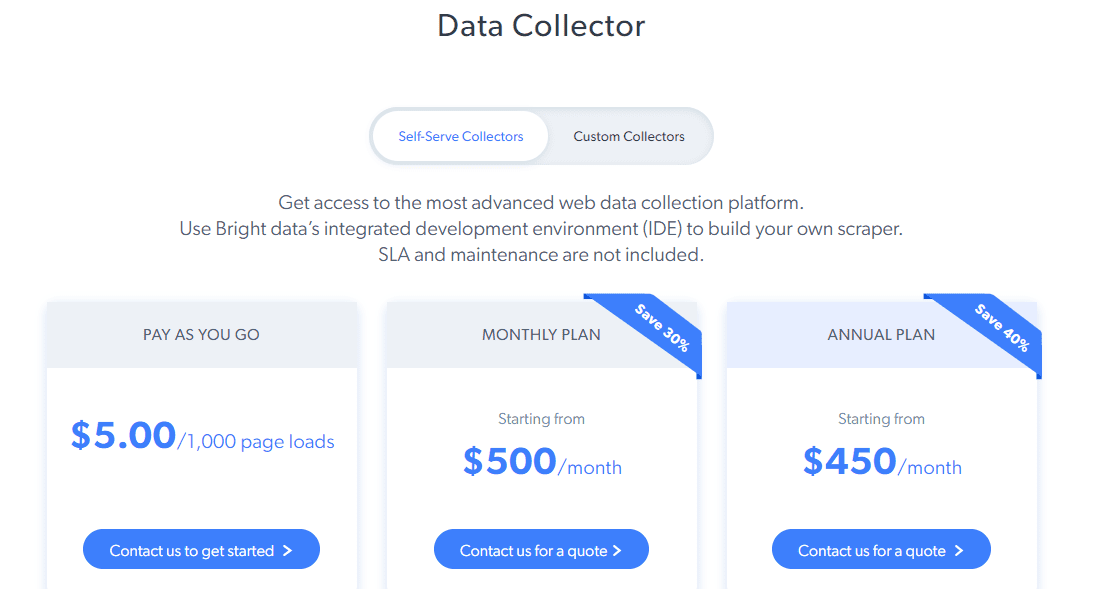

Bright Data Collector oferuje dwa rodzaje cenników – dla kolektorów samoobsługowych i kolektorów niestandardowych.

Self-Serve Collector: Zapewnia dostęp do zaawansowanych funkcji, takich jak IDE Bright Data do tworzenia web scrapera, alertów, monitorowania wskaźnika sukcesu, wyższej wydajności, proxy klasy branżowej i innych. Plany cenowe są następujące:

- Pay As You Go: 5 USD za 1000 załadowanych stron

- Abonament miesięczny: zaczyna się od 500 USD miesięcznie

- Abonament roczny: zaczyna się od 450 USD miesięcznie

W przypadku kolektorów niestandardowych ceny zaczynają się od 1000 USD miesięcznie.

Dostępna jest również BEZPŁATNA opcja próbna na ograniczony czas, aby ocenić, czy narzędzie spełnia Twoje oczekiwania.

Alternatywy dla Bright Data Collector

Nie każde rozwiązanie jest odpowiednie dla każdego użytkownika. Ze względu na ceny, funkcje lub zasady, niektórzy mogą nie być zadowoleni z Bright Data Collector. Jeśli należysz do tej grupy, sprawdźmy alternatywne rozwiązania:

Oxylaby

Popularna platforma Oxylabs oferuje interfejs API do web scrapingu, umożliwiający pozyskiwanie danych w bezproblemowy sposób.

Kluczowe cechy

- Wysokiej jakości gromadzenie danych z dowolnej strony internetowej za pomocą zaawansowanego rotatora proxy

- Pozyskiwanie danych ze 195 krajów

- Łatwe omijanie ograniczeń geograficznych

- Brak konieczności obsługi

- Opłata tylko za dane dostarczone z powodzeniem

Możesz wypróbować Oxylabs bezpłatnie przez 7 dni lub wybrać abonament od 99 USD miesięcznie.

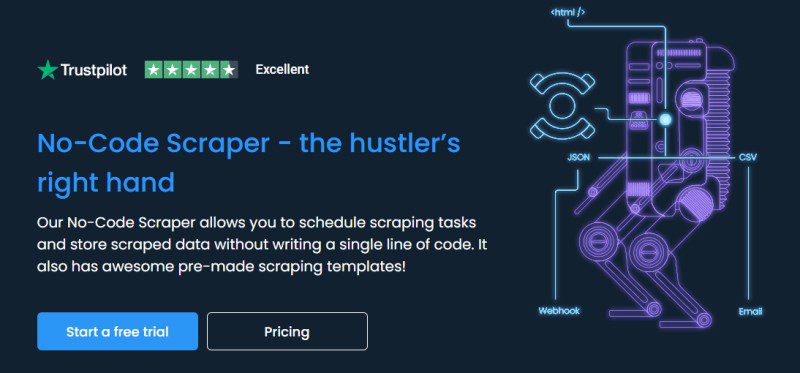

Inteligentne proxy

Jeśli szukasz platformy do web scrapingu bez kodu innej niż Bright Data, wypróbuj Smartproxy. Pomaga ona planować zadania związane ze skrobaniem sieci i bezpiecznie przechowywać dane, bez konieczności programowania.

Kluczowe cechy

- Wiele gotowych szablonów do web scrapingu

- Konfiguracja jednym kliknięciem

- Eksport danych w formacie CSV lub JSON

- Przechowywanie danych w chmurze

- Bezpłatne rozszerzenie do Chrome

Wypróbuj Smartproxy ZA DARMO przez 3 dni lub wybierz plan od 50 USD miesięcznie.

Zyte

Zyte oferuje zautomatyzowany interfejs API do ekstrakcji danych internetowych, który umożliwia niezawodne, szybsze i bezpieczne gromadzenie danych bez ryzyka blokowania dostępu do witryn. Wykorzystuje opatentowaną technologię sztucznej inteligencji do automatycznej ekstrakcji, która wspiera dostarczanie wysokiej jakości danych w ustrukturyzowanej formie.

Kluczowe cechy

- Szybkie odpowiedzi

- Wysokiej jakości dane z dziesięciu typów

- Uproszczony interfejs API HTTP

- Obsługa ponad 40 języków

- Dostosowanie do zmian na stronie

- Wbudowane zarządzanie blokowaniem

- Nieograniczona skalowalność

Plany cenowe zaczynają się od 60 USD miesięcznie, z BEZPŁATNYM okresem próbnym przez 14 dni.

Podsumowanie

Korzystanie z narzędzia do zbierania danych, takiego jak Bright Data Collector, może znacznie uprościć proces web scrapingu dzięki intuicyjnemu interfejsowi, niezawodnej wydajności i bogatym funkcjom.

Platforma ta może być dobrym rozwiązaniem dla organizacji, uniwersytetów i firm badawczych. Jeśli jednak szukasz alternatyw dla Bright Data, sprawdź powyższe opcje i wybierz tę, która najlepiej spełnia Twoje potrzeby.

Możesz także zapoznać się z innymi popularnymi rozwiązaniami do scrapingu w chmurze.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.