Specjalistyczne narzędzia do pobierania informacji ze stron internetowych, zwane również web scraperami, umożliwiają skuteczne gromadzenie danych z różnorodnych witryn. Wyposażone w zaawansowane funkcje, wspomagają rozwój przedsiębiorstw.

Dane rynkowe stanowią istotny element w identyfikowaniu wartościowych spostrzeżeń i perspektyw rozwoju.

Ekstrakcja danych z sieci jest kluczowa dla efektywnego marketingu, a proces ten można zoptymalizować za pomocą dedykowanych narzędzi. Ręczne pozyskiwanie danych jest czasochłonne i wymaga znacznych zasobów.

Zastosowanie narzędzia do odblokowywania stron nie tylko zwiększa efektywność, produktywność i dokładność, ale również automatyzując proces ekstrakcji danych, prowadzi firmę do sukcesu.

W niniejszym artykule omówimy znaczenie procesu skrobania stron internetowych oraz wyjaśnimy, w jaki sposób specjalistyczne narzędzie ułatwia skuteczne pobieranie danych.

Czym jest Web Scraping?

Web scraping to zautomatyzowany proces zbierania danych ze stron internetowych. W przeciwieństwie do ręcznego pozyskiwania informacji, które wymaga znacznych nakładów czasu, web scraping wykorzystuje inteligentne techniki automatyzacji do gromadzenia ogromnych ilości danych.

Informacje dostępne online często prezentowane są w nieustrukturyzowanym formacie HTML. Web scraping pozwala na wyodrębnienie potrzebnych danych i przekształcenie ich w formę strukturalną, która może być przechowywana w bazach danych lub arkuszach kalkulacyjnych. Tak przygotowane dane mogą być dalej analizowane i wykorzystywane w różnych aplikacjach.

Wiele firm i osób prywatnych stosuje web scraping w celu pozyskania informacji dostępnych publicznie, aby lepiej zrozumieć rynek i podejmować bardziej świadome decyzje. Główne zastosowania to między innymi analiza konkurencji, monitorowanie cen, badania rynkowe, obserwacja wiadomości i generowanie potencjalnych klientów.

Trudności związane ze skrobaniem sieci

Pomimo że web scraping jest istotną technologią w procesie pozyskiwania danych, wiąże się z pewnymi wyzwaniami.

Działanie botów

Właściciele stron internetowych mogą decydować, czy zezwalać na działanie robotów w celu skrobania danych, czy nie. Wiele witryn blokuje ten proces, ponieważ boty mogą nadmiernie obciążać serwery podczas pobierania dużych ilości danych, co negatywnie wpływa na wydajność strony.

Częste zmiany w strukturze stron

Strony internetowe regularnie wprowadzają zmiany w strukturze, aby ulepszyć interfejs użytkownika i dodać nowe funkcje. Skrypty web scraperów są pisane w odniesieniu do konkretnych elementów kodu strony. Częste zmiany utrudniają pracę skrobakom, gdyż mogą one prowadzić do utraty danych. Utrzymanie aktualności skrobaka, gdy struktura strony ulega częstym zmianom, jest znaczącym wyzwaniem.

Chociaż nie każda zmiana wpływa na konfigurację, niektóre mogą prowadzić do utraty danych, a utrzymanie skrobaków w stanie aktywności, gdy użytkownik pobiera dane, stanowi wyzwanie.

Captcha

Głównym celem captcha jest odróżnienie ludzi od botów poprzez prezentację zadań logicznych, co pomaga w powstrzymaniu spamu. W przypadku obecności captcha podstawowe skrypty używane przez scrapery stają się nieskuteczne.

Blokady i bany

Jeśli bot skrobaka wysyła równolegle wiele zapytań lub nienaturalnie dużą ich liczbę, może zostać uznany za naruszający zasady etycznego skrobania i zablokowany. Skrobak musi być odpowiednio inteligentny, aby unikać tych problemów, przestrzegając zasad i jednocześnie osiągając zamierzony cel.

Skrobanie danych w czasie rzeczywistym

Pobieranie danych w czasie rzeczywistym jest istotne dla wielu przedsiębiorstw w celu pozyskania aktualnych informacji i podejmowania lepszych decyzji. Od wahań cen akcji po zmieniające się ceny produktów, gromadzenie takich danych wspiera wzrost firmy. Pozyskiwanie dużych zbiorów danych i podejmowanie decyzji na ich podstawie jest jednak wyzwaniem. Skrobaki działające w czasie rzeczywistym wykorzystują API REST do monitorowania i zbierania dynamicznie zmieniających się danych. Nieostrożne gromadzenie danych może uszkodzić witrynę i negatywnie wpłynąć na firmę.

Pułapki na boty (Honeypots)

Właściciele witryn stosują pułapki typu honeypot, aby przechwytywać roboty. Są to linki widoczne dla botów, ale niewidoczne dla zwykłych użytkowników. Gdy bot wpadnie w pułapkę, witryna używa tych informacji do zablokowania skrobaka.

Wymóg logowania

Czasami, aby uzyskać dostęp do informacji, konieczne jest zalogowanie się na stronie. Po wprowadzeniu danych logowania przeglądarka dodaje wartość pliku cookie do zapytań wysyłanych do strony, co umożliwia stronie identyfikację użytkownika. Witryna może blokować boty, które nie są w stanie obsłużyć takiego mechanizmu logowania.

Jak Web Unlocker może pomóc?

Web Unlocker to zaawansowane narzędzie, które wspiera marketerów, analityków danych oraz badaczy internetowych w dostępie do stron internetowych, również tych zablokowanych. Umożliwia swobodne eksplorowanie internetu poprzez omijanie blokad, banów, zabezpieczeń captcha i innych ograniczeń, automatyzując jednocześnie proces skrobania.

Dostęp do danych publicznych jest regulowany przepisami. Narzędzie do odblokowywania stron powstało, aby ułatwić legalne pozyskiwanie danych, umożliwiając wysyłanie żądań bez obaw o pułapki czy blokady.

Web Unlocker umożliwia:

- Automatyczne używanie domowego adresu IP lub serwera proxy, aby uniknąć wykrycia przez systemy antybotowe.

- Wyglądanie jak zwykły użytkownik przeglądający strony internetowe.

- Rozwiązywanie problemów z logowaniem.

- Dostęp do treści zlokalizowanych na całym świecie.

- Ochronę przed pułapkami.

- Zarządzanie rotacją adresów IP w pełnym cyklu.

- Dostosowywanie odcisku palca w czasie rzeczywistym.

- Odblokowywanie i rozwiązywanie problemów związanych z captcha.

- Uzyskiwanie dostępu do stron internetowych z ograniczeniami geograficznymi w celu pozyskiwania danych.

- Adaptację w celu uniknięcia wykrycia.

- Ułatwianie ekstrakcji danych za pomocą algorytmów uczenia maszynowego.

- Korzystanie z funkcji API scrapingu.

- Utrzymanie niewykrywalności dzięki rozbudowanemu repozytorium plików cookie, emulowanych urządzeń i nagłówków HTTP.

- Składanie nieograniczonej liczby zapytań o dane.

Jak działa Web Unlocker?

Aby efektywnie pobrać dane, konieczne jest precyzyjne zdefiniowanie, które informacje są potrzebne. Narzędzie, które odblokowuje strony, wówczas wyodrębni dane dokładnie i szybko.

Na przykład, jeśli chcesz uzyskać listę sokowirówek dostępnych w sklepie internetowym, a nie recenzje klientów, możesz określić, że chcesz pobrać tylko dane dotyczące samych produktów.

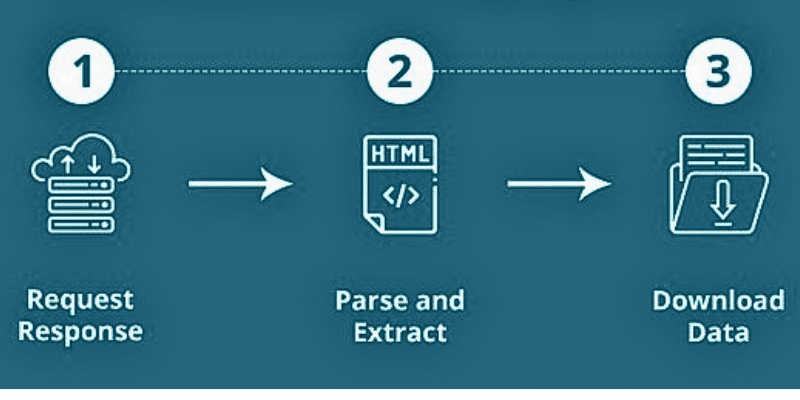

Gdy narzędzie do odblokowania stron internetowych zaczyna pobierać dane z witryny, najpierw wprowadza się adresy URL. Następnie ładuje kody HTML stron, a zaawansowane scrapery mogą pobierać także elementy JavaScript i CSS. Następnie scraper konwertuje dane z HTML do formatu łatwego do zrozumienia.

źródło: Quora

źródło: Quora

Zwykle dane wyjściowe zapisywane są w formacie CSV lub arkuszu kalkulacyjnym Excel. Możliwe jest również przechowywanie danych w innych formatach, w tym JSON.

Skrobanie stron internetowych składa się z dwóch kluczowych elementów:

- Robot indeksujący, czyli algorytm sztucznej inteligencji, który przeszukuje internet w celu odnalezienia konkretnych informacji.

- Skrobak, czyli narzędzie stworzone specjalnie do zbierania danych ze stron internetowych. Jego projekt zależy od złożoności i zakresu projektu.

Dzięki temu dane mogą być pobierane szybko i z dużą dokładnością.

Dlaczego Web Unlocker jest ważny?

Niezależnie od tego, czy jesteś na początku swojej drogi biznesowej, czy już rozwijasz firmę, ekstrakcja danych może znacząco przyspieszyć Twój wzrost. Specjaliści, analitycy i przedsiębiorcy coraz częściej wybierają narzędzia do odblokowywania stron, rezygnując z samodzielnego zarządzania serwerami proxy i rozwiązywaniem problemów z captcha. Poznajmy korzyści, jakie narzędzie do odblokowania stron oferuje firmom.

Uproszczenie ekstrakcji danych

Dzięki nowoczesnym narzędziom, takim jak Web Unlocker, proces pozyskiwania danych staje się znacznie prostszy. Umożliwia to łatwe pobieranie dużych ilości danych. Ponadto można uzyskać dostęp do botów, które umożliwiają gromadzenie danych w dowolnej skali.

Szybkie tempo innowacji

Crawling i scraping umożliwiają firmom szybsze wprowadzanie innowacji i opracowywanie nowych produktów. Wiele firm prosperuje dzięki pozyskiwaniu i analizie danych z różnych źródeł. Web scraping pozwala na doskonalenie propozycji wartości oraz testowanie i wdrażanie nowych pomysłów w oparciu o dane uzyskane ze stron internetowych.

Generowanie leadów

Web Unlocker ułatwia dostęp do danych biznesowych konkurencji, co pomaga w budowaniu zautomatyzowanych systemów sprzedaży. Można wyszukiwać i agregować dane w zależności od potrzebnej jakości i dokładności. Po uzyskaniu niezbędnych danych można generować leady i wspierać rozwój firmy.

Automatyzacja marketingu

Pobieranie danych jest ściśle powiązane z automatyzacją marketingu. Na przykład, jeśli zauważysz, że profil konkurenta na Instagramie ma ponad 18 tysięcy obserwujących, a Twój produkt jest lepszy, warto spróbować przekonać ich do zmiany. Aby to osiągnąć, potrzebny jest skuteczny marketing.

W tym celu można pobrać listę obserwujących konkurenta, śledzić ich i wysyłać im wiadomości. Podobne działania można prowadzić na Twitterze, Facebooku itp., a także na stronach internetowych konkurencji. To pomoże szybciej rozwijać się na rynku, zrozumieć potrzeby klientów i zaoferować im to, czego szukają.

Monitorowanie marki

Zwykle pierwszym krokiem klienta przed zakupem jest sprawdzenie opinii o produkcie. Firmy muszą rekomendować produkty zgodnie z potrzebami i przekonywać klientów, że dokonują właściwego wyboru. Dzięki Web Unlocker można lepiej zrozumieć klientów i oferować im lepsze produkty. Możliwe jest też monitorowanie mediów społecznościowych i analizowanie nastrojów, aby szybko reagować na opinie użytkowników.

Analiza rynku

Jakość danych jest kluczowa w dzisiejszym konkurencyjnym świecie. Zamiast dużych ilości danych potrzebne są inteligentne, dobrze dobrane informacje.

Na przykład, jeśli sprzedajesz części zamienne do maszyn, musisz określić cel zakupu tych części. W tym przypadku wystarczy zebrać dane z konkretnych stron internetowych, które również dystrybuują takie części. Takie podejście ułatwia analizę rynku i wspiera wzrost sprzedaży.

Współpraca z uczeniem maszynowym i głębokim uczeniem

Aby nauczyć maszyny budowania modelu na podstawie danych wejściowych, potrzebne są duże ilości danych. Dane są kluczowe, jeśli chcesz, aby maszyna wykonała zadanie. Niezależnie od tego, czy chcesz przewidzieć rynek giełdowy, czy strategię sprzedaży produktów konkurencji, pozyskiwanie danych za pomocą ML i DL jest skutecznym krokiem do osiągnięcia sukcesu.

SEO

Specjaliści SEO wykorzystują różne narzędzia do wyszukiwania odpowiednich słów kluczowych. Ekstrakcja danych za pomocą Web Unlockera ułatwia to zadanie. Eksperci SEO pobierają dane o działaniach konkurencji, aby dowiedzieć się, jak radzą sobie ich treści. To pomaga również zrozumieć, jakie zmiany należy wprowadzić, aby poprawić własne SEO.

Testowanie od końca do końca

Jeśli jesteś programistą, pobieranie danych z różnych źródeł pomaga usprawnić testowanie i zaoszczędzić czas w procesach, które nie przynoszą rezultatów.

Narzędzia do odblokowywania stron

Poniżej przedstawiono najlepsze narzędzia do odblokowania stron internetowych, które możesz wykorzystać, aby zacząć pobierać dane:

#1. Bright Data

Bright Data oferuje narzędzie do odblokowywania sieci, które pozwala ominąć blokady witryn. Automatyczny program radzi sobie z agentami użytkownika, rozwiązywaniem captcha i zarządzaniem plikami cookie. Zapewnia ciągłe pozyskiwanie danych z docelowych witryn poprzez rotację adresów IP.

Aby użyć tego narzędzia:

- Wybierz witrynę, którą chcesz odblokować.

- Wyślij proste zapytanie proxy wraz z adresem URL witryny.

- Otrzymaj dane, których szukasz.

Dzięki Web Unlocker firmy Bright Data nie zostaniesz ponownie zablokowany. Automatycznie opracowuje nowe metody, aby strony internetowe były zawsze dostępne dla ekstrakcji danych. Narzędzie zarządza wykorzystaniem adresów IP, dbając o to, aby żadne zapytanie nie pochodziło z jednego adresu IP. Ponadto emuluje urządzenia, których serwery oczekują.

Otrzymasz automatyczną emulację użytkownika. Obejmuje to klikanie linków do strony głównej, ruchy myszy i inne. Web Unlocker gwarantuje, że strona docelowa widzi użytkownika, który przechodzi na nią z popularnej witryny. Ponadto, narzędzie identyfikuje pułapki i unika ich.

#2. Oxylabs

Oxylabs Web Unblocker zapewnia swobodne pobieranie danych na dużą skalę, umożliwiając dostęp do danych publicznych z trudnych stron internetowych. Płacisz tylko za udane pobranie danych. Otrzymasz zarządzanie serwerami proxy oparte na ML, dynamiczne odciski palców przeglądarki, automatyczne ponawianie i rozpoznawanie odpowiedzi oparte na ML.

Oxylabs zapewnia, że Twój adres IP nie zostanie zablokowany dzięki rozwiązaniu proxy opartemu na sztucznej inteligencji. Omija systemy antybotowe z wysoką skutecznością, oszczędzając zasoby. Dynamiczny odcisk palca pozwala przeglądać zawartość jak prawdziwy użytkownik.

Web Unblocker firmy Oxylabs automatycznie dobiera odpowiednie pliki cookie, nagłówki i konfiguracje renderowania JavaScript, co umożliwia uzyskanie wiarygodnych wyników i przeglądanie stron bez problemów z captcha. Niezależnie od lokalizacji, możesz uzyskać dostęp do zlokalizowanych treści z dowolnego miejsca na świecie.

Zyskujesz dostęp do ponad 102 milionów etycznie pozyskanych puli proxy. Pozwala to bezproblemowo gromadzić dane publiczne. Dodatkowo otrzymujesz kontrolę sesji, wygodny pulpit nawigacyjny, łatwe skalowanie, renderowanie JavaScript i wiele więcej.

Podsumowanie

Skrobanie stron internetowych jest korzystne dla firm, które gromadzą cenne dane biznesowe i wykorzystują je do ulepszania swojej działalności. Ręczne przeglądanie stron internetowych jest żmudne i czasochłonne, dlatego nowoczesne firmy korzystają z narzędzi do zbierania danych, aby zautomatyzować proces pozyskiwania informacji.

Narzędzia do skrobania stron internetowych wiążą się jednak z pewnymi wyzwaniami, ponieważ technologia rozwija się, a strony internetowe udoskonalają metody wykrywania i blokowania scraperów. W tym kontekście narzędzie do odblokowywania stron może być przydatne, gdyż jest to zaawansowana forma scrapera, która omija ograniczenia, blokady i bany. To zwiększa skuteczność i wydajność procesu skrobania stron.

Jeśli więc szukasz zaawansowanego narzędzia do pobierania danych, rozważ użycie Web Unlockera. Powyżej wymieniono niektóre z najlepszych dostępnych na rynku narzędzi, które możesz wybrać na podstawie potrzeb Twojej firmy.

Możesz także zapoznać się z najlepszymi skrobakami mediów społecznościowych, aby wyodrębnić cenne dane.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.