Jak często zdarza Ci się powierzać zadania lub szukanie odpowiedzi chatbotom czy botom opartym na sztucznej inteligencji (AI)?

Jeśli Twoja odpowiedź to „bardzo często!” lub „ciągle!”, to być może masz powody do zaniepokojenia 😟.

Bez względu na to, czy jesteś studentem korzystającym z AI do przeszukiwania źródeł naukowych, czy programistą próbującym generować kod wyłącznie za pomocą sztucznej inteligencji, ryzyko błędów w wynikach generowanych przez AI jest dość znaczące. Wynika to głównie z niespójności lub nierzetelnych danych wykorzystywanych w procesie uczenia maszynowego AI.

Mimo że modele sztucznej inteligencji i uczenia maszynowego (ML) dokonują rewolucji w wielu dziedzinach – przejmując rutynowe zadania i automatyzując rozwiązania, to wciąż wiele pozostaje do zrobienia, aby generować precyzyjne wyniki w oparciu o wprowadzone polecenia.

Po pewnym czasie korzystania z generatorów treści i chatbotów, z pewnością zauważysz, że otrzymujesz mylne, nieistotne lub wręcz wymyślone odpowiedzi. Takie sytuacje określa się mianem halucynacji lub konfabulacji AI, które stanowią poważny problem dla organizacji i indywidualnych użytkowników botów generatywnych opartych na sztucznej inteligencji.

Niezależnie od tego, czy zetknąłeś się już z halucynacjami AI, czy nie, i chcesz dowiedzieć się więcej na ten temat, w tym artykule szczegółowo omówimy to zagadnienie. Przeanalizujemy, czym są halucynacje AI, jakie są ich przyczyny, przykłady ich występowania oraz czy można je wyeliminować.

Zaczynajmy!

Czym są halucynacje AI?

Halucynacja sztucznej inteligencji to sytuacja, w której model AI lub duży model językowy (LLM) tworzy fałszywe, niedokładne lub pozbawione logiki informacje. Model AI generuje pewną odpowiedź, która nie jest zgodna z danymi, na których był szkolony, lub z którymi jest sprzeczna, i przedstawia ją jako fakt, ignorując brak logiki i zdrowego rozsądku!

Mówi się, że błądzenie jest rzeczą ludzką! 😅

Narzędzia i modele AI, takie jak ChatGPT, są programowane tak, aby przewidywać słowa, które najlepiej pasują do zadanego pytania. Mimo że często generują odpowiedzi oparte na faktach i są dokładne, czasami ten algorytm powoduje, że brakuje im logicznego myślenia. W efekcie chatboty tworzą treści niespójne z rzeczywistością i fałszywe twierdzenia.

Innymi słowy, modele AI niekiedy „halucynują” w poszukiwaniu odpowiedzi, starając się Cię zadowolić (użytkownika) – muszą być bardziej tendencyjne, stronnicze, specyficzne lub wystarczające.

Halucynacje AI mogą przyjmować różne formy – od drobnych niespójności po całkowicie fałszywe lub zmyślone reakcje. Oto różne rodzaje halucynacji AI, z jakimi możesz się zetknąć:

#1. Sprzeczność w obrębie zdań: Występuje, gdy model LLM generuje zdanie, które całkowicie neguje wcześniejsze stwierdzenie.

#2. Sprzeczność z faktami: Ten rodzaj halucynacji pojawia się, gdy model AI prezentuje fałszywe lub fikcyjne informacje jako prawdziwe.

#3. Sprzeczność z poleceniem: Ten rodzaj halucynacji ma miejsce, gdy wynik generowany przez AI jest sprzeczny z poleceniem, na podstawie którego został stworzony. Na przykład, na polecenie „Napisz zaproszenie dla moich znajomych na moje urodziny” model może wygenerować odpowiedź typu „Wszystkiego najlepszego, mamo i tato”.

#4. Losowe lub nieadekwatne halucynacje: Ten typ halucynacji występuje, gdy model generuje całkowicie nieadekwatne dane wyjściowe w odpowiedzi na zadane polecenie. Na przykład, na pytanie „Co jest wyjątkowego w Nowym Jorku?”, możesz otrzymać odpowiedź: „Nowy Jork jest jednym z najbardziej zatłoczonych miast w Ameryce. Psy to najbardziej lojalne zwierzęta i najlepszy przyjaciel człowieka”.

Przeczytaj również: Jak generatywne wyszukiwanie AI zmienia wyszukiwarki

Przykłady halucynacji AI

Halucynacje AI mają na swoim koncie kilka głośnych przykładów, których nie sposób pominąć. Oto kilka z nich:

- Chatbot Google Bard fałszywie stwierdził, że Teleskop Kosmiczny Jamesa Webba wykonał pierwsze w historii zdjęcia egzoplanety spoza naszego Układu Słonecznego.

- Wersja demonstracyjna modelu LLM Meta Galactica z 2022 roku, przeznaczona dla studentów i naukowców, dostarczyła użytkownikom nieścisłych informacji i sfabrykowany artykuł na temat tworzenia awatarów.

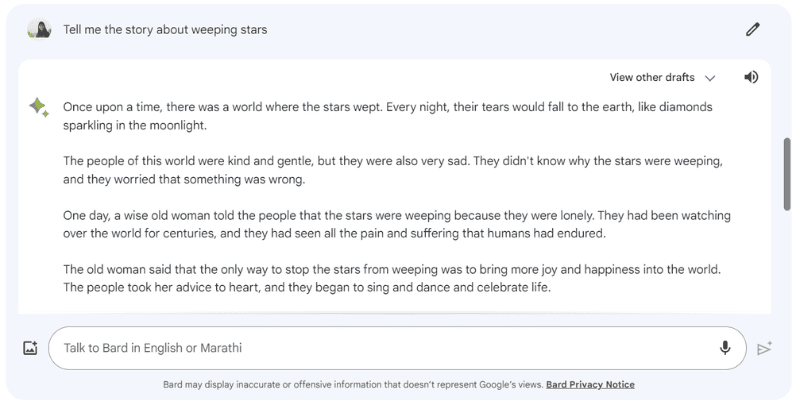

Oto przykład halucynacyjnej odpowiedzi Google Barda na polecenie „Opowiedz mi historię o płaczących gwiazdach”, które tak naprawdę nie istnieją.

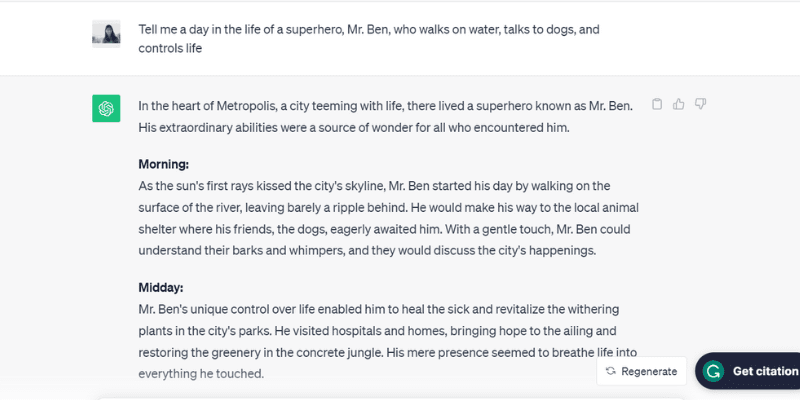

Kolejnym przykładem jest test chatGPT (GPT-3.5), który uległ halucynacji podczas rozmowy o fikcyjnej postaci, panu Benie. Na pytanie: „Opowiedz mi dzień z życia superbohatera, pana Bena, który chodzi po wodzie, rozmawia z psami i kontroluje życie” ChatGPT wygenerował spójną opowieść.

ChatGPT szczegółowo opisał cały dzień, od poranka do wieczora, pana Bena, który nie istnieje, ale działał zgodnie z podpowiedziami, co jest jedną z przyczyn halucynacji AI.

Można by rzec, że AI jest zbyt chętna, aby zadowolić użytkownika!

Zastanówmy się więc, jakie czynniki wywołują halucynacje AI.

Przyczyny halucynacji AI

Istnieje wiele przyczyn technicznych i innych czynników, które mogą wywoływać halucynacje AI. Oto niektóre z nich:

- Niska jakość, niewystarczające lub nieaktualne dane: Modele LLM i AI w dużym stopniu bazują na danych, na których są szkolone. Ich skuteczność jest zatem ograniczona jakością tych danych. Jeśli w danych szkoleniowych AI znajdują się błędy, niespójności, są one tendencyjne lub niekompletne, albo jeśli model nie rozumie zadanego polecenia, może to prowadzić do halucynacji AI. Wynika to z faktu, że model generuje odpowiedź z ograniczonego zestawu danych.

- Przetrenowanie: Model AI szkolony na ograniczonym zbiorze danych może próbować zapamiętywać dane wejściowe i powiązane wyniki, co utrudnia mu skuteczne generowanie lub uogólnianie nowych danych, a w konsekwencji prowadzi do halucynacji AI.

- Kontekst wprowadzanych danych: Halucynacje AI mogą również wynikać z niejasnych, niedokładnych, niespójnych lub sprzecznych poleceń. O ile zbiór danych szkoleniowych modelu AI nie jest dostępny dla użytkowników, o tyle dane wprowadzane jako polecenie już tak. Z tego powodu, niezwykle istotne jest formułowanie jasnych i precyzyjnych poleceń, aby uniknąć halucynacji AI.

- Używanie idiomów lub slangu: Jeśli polecenie zawiera idiomy lub slang, ryzyko halucynacji AI wzrasta, zwłaszcza jeśli model nie jest do takich sformułowań przyzwyczajony.

- Ataki adwersyjne: Hakerzy mogą celowo wprowadzać polecenia, które mają na celu zmylenie modeli AI, uszkodzenie ich danych szkoleniowych i wywołanie halucynacji AI.

Negatywne konsekwencje halucynacji AI

Halucynacje AI stanowią poważny problem etyczny, który niesie poważne konsekwencje dla osób i organizacji. Oto kilka z tych konsekwencji:

- Rozpowszechnianie dezinformacji: Halucynacje AI wywołane błędnymi poleceniami lub niespójnościami w danych szkoleniowych mogą prowadzić do szybkiego rozprzestrzeniania się dezinformacji, dotykając szerokiego grona odbiorców, firm i agencji rządowych.

- Utrata zaufania wśród użytkowników: Gdy dezinformacja tworzona przez AI błyskawicznie rozprzestrzenia się w Internecie, wyglądając na wiarygodną, podważa to zaufanie użytkowników do informacji online.

- Szkody dla użytkowników: Oprócz kwestii etycznych i wprowadzania w błąd ludzi, halucynacje AI mogą również potencjalnie szkodzić poprzez rozpowszechnianie fałszywych informacji na ważne tematy, takie jak choroby i ich leczenie, czy nawet porady, jak odróżnić trującego grzyba od jadalnego. Nawet niewielka dezinformacja lub nieścisłość może zagrażać życiu.

Dobre praktyki w wykrywaniu i zapobieganiu halucynacjom AI

Biorąc pod uwagę negatywne skutki halucynacji AI, ich zapobieganie jest kluczowe. Mimo że firmy stojące za modelami AI starają się zminimalizować to zjawisko, my jako użytkownicy również powinniśmy podejmować wszelkie niezbędne środki ostrożności.

Na podstawie badań, doświadczeń i metody prób i błędów opracowałem kilka strategii, które pomagają wykrywać i zapobiegać halucynacjom AI podczas korzystania z chatbotów lub modeli językowych (LLM).

#1. Korzystaj z reprezentatywnych i różnorodnych danych szkoleniowych

Jako użytkownik powinieneś wybierać modele LLM, które korzystają z różnorodnych danych szkoleniowych, odzwierciedlających świat rzeczywisty. Zmniejszy to ryzyko generowania przez model tendencyjnych, nieprecyzyjnych lub zmyślonych odpowiedzi.

Firmy natomiast muszą regularnie aktualizować i poszerzać zbiory danych, aby uwzględniać najnowsze informacje na tematy kulturalne, polityczne i inne.

#2. Ogranicz wyniki lub reakcje

Jako użytkownik możesz ograniczyć liczbę możliwych odpowiedzi generowanych przez model AI, wydając mu polecenie dotyczące rodzaju odpowiedzi, jakiej oczekujesz.

Na przykład, możesz zadać pytanie i nakazać modelowi odpowiedzieć tylko „tak” lub „nie”. Możesz również wskazać kilka opcji wyboru, ograniczając tym samym możliwość odejścia od rzeczywistej odpowiedzi i wystąpienia halucynacji.

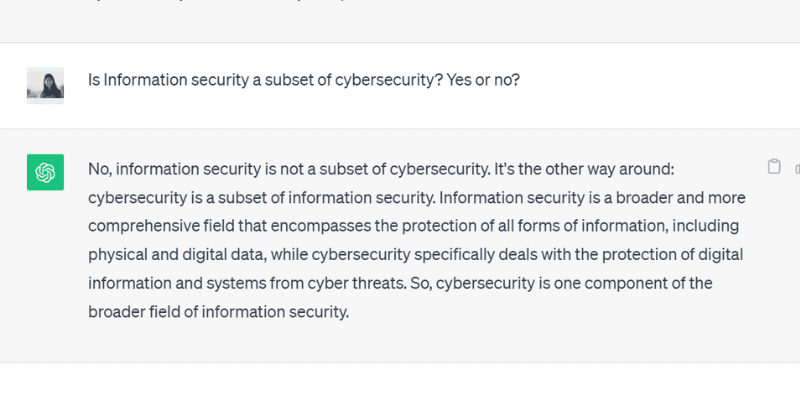

Gdy zadałem ChatGPT GPT 3.5 pytanie, na które można odpowiedzieć „tak” lub „nie”, model wygenerował dokładnie taką odpowiedź:

#3. Dostarcz modelowi odpowiednie dane

Nie można oczekiwać od człowieka, że rozwiąże konkretny problem, jeśli nie posiada odpowiedniej wiedzy lub nie ma do dyspozycji kontekstu. Podobnie jest z modelem AI – jest on tak dobry, jak dane, na których został przeszkolony.

Wprowadzenie do modelu AI danych branżowych i specyficznych dla danego zagadnienia zapewnia dodatkowy kontekst. Dzięki temu model AI może lepiej zrozumieć polecenie i generować dokładne, sensowne i kontekstowe odpowiedzi zamiast halucynacyjnych.

#4. Twórz szablony danych, które model AI ma wykorzystywać

Dostarczenie modelu AI szablonu danych lub przykładu określonej formuły w predefiniowanym formacie może pomóc mu w generowaniu dokładnych odpowiedzi, zgodnych z oczekiwaniami.

Wykorzystywanie wytycznych i szablonów danych zmniejsza ryzyko halucynacji AI i zapewnia spójność i dokładność generowanych odpowiedzi. Dostarczenie modelu referencyjnego w postaci tabeli lub przykładu może pomóc mu w obliczeniach, eliminując ryzyko halucynacji.

#5. Formułuj precyzyjne polecenia, przypisując modelowi określoną rolę

Przypisanie modelowi AI konkretnej roli to jeden z najbardziej skutecznych sposobów zapobiegania halucynacjom. Możesz na przykład użyć polecenia typu „Jesteś doświadczonym gitarzystą” lub „Jesteś genialnym matematykiem”, a następnie zadać konkretne pytanie.

Przypisywanie ról kieruje model w stronę odpowiedzi, której oczekujesz, zamiast zmyślonych halucynacyjnych odpowiedzi.

Nie przejmuj się, możesz nadal dobrze się bawić ze sztuczną inteligencją (nawet z halucynacjami). Sprawdź, jak samodzielnie stworzyć viralową grafikę spiralną AI!

#6. Eksperymentuj z temperaturą

Temperatura odgrywa istotną rolę w określaniu stopnia halucynacji lub kreatywnych reakcji, jakie może wygenerować model AI.

Niższa temperatura zazwyczaj oznacza deterministyczne lub przewidywalne wyniki, natomiast wyższa temperatura zwiększa prawdopodobieństwo generowania losowych odpowiedzi i halucynacji.

Niektóre firmy udostępniają suwak „Temperatura” w narzędziach AI, aby użytkownicy mogli dostosować ustawienia do własnych preferencji.

Firmy mogą również ustawić domyślną temperaturę, aby ich narzędzie generowało rozsądne odpowiedzi, osiągając równowagę pomiędzy dokładnością a kreatywnością.

#7. Zawsze sprawdzaj informacje

Poleganie w 100% na wynikach generowanych przez sztuczną inteligencję bez ich weryfikacji nie jest mądre. Mimo że firmy pracują nad problemem halucynacji AI, jako użytkownik powinieneś zawsze weryfikować odpowiedzi generowane przez model, zanim im całkowicie zaufasz.

Stosując wspomniane praktyki, począwszy od formułowania precyzyjnych poleceń po dostarczanie przykładów i szablonów, zawsze sprawdzaj rezultaty generowane przez AI.

Czy można całkowicie naprawić lub wyeliminować halucynacje AI? Opinia eksperta

Chociaż kontrola halucynacji AI zależy od poleceń, które jej zadajemy, czasami model generuje dane z tak dużą pewnością siebie, że trudno jest odróżnić, co jest prawdą, a co fałszem.

Czy ostatecznie można całkowicie naprawić lub zapobiec halucynacjom AI?

Na to pytanie Suresh Venkatasubramanian, profesor z Uniwersytetu Browna, odpowiedział, że kwestia zapobiegania halucynacjom AI jest „w fazie intensywnych badań”.

Wyjaśnił on, że wynika to z natury modeli AI – ich złożoności, zawiłości i delikatności. Nawet niewielka zmiana w danych wejściowych może znacząco zmienić wyniki.

Podczas gdy Venkatasubramanian uważa, że rozwiązanie problemu halucynacji AI jest obszarem aktywnych badań, Jevin West, profesor z Uniwersytetu Waszyngtońskiego i współzałożyciel Centrum Informacji Publicznej, jest zdania, że halucynacje AI nigdy nie znikną.

West uważa, że niemożliwe jest odtworzenie halucynacji wywoływanych przez boty AI. Halucynacje mogą więc zawsze występować jako nieodłączny element AI.

Ponadto Sundar Pichai, dyrektor generalny Google, powiedział w wywiadzie dla CBS, że wszyscy korzystający ze sztucznej inteligencji zmagają się z problemem halucynacji, i nikt w branży nie znalazł jeszcze rozwiązania. Praktycznie wszystkie modele AI mają ten problem. Stwierdził jednak, że dziedzina sztucznej inteligencji wkrótce poczyni postępy w przezwyciężaniu halucynacji.

W tym samym czasie Sam Altman, dyrektor generalny OpenAI, twórców ChatGPT, podczas wizyty w Indyjskim Instytucie Technologii Informatycznych w Delhi w czerwcu 2023 roku zauważył, że problem halucynacji AI powinien ulec znacznemu zmniejszeniu w ciągu półtora do dwóch lat.

Dodał, że model będzie musiał nauczyć się rozróżniać dokładność od kreatywności i wiedzieć, kiedy użyć jednej, a kiedy drugiej.

Podsumowanie

Halucynacje AI stały się w ostatnich latach ważnym tematem, będąc przedmiotem zainteresowania firm i badaczy, którzy starają się rozwiązać ten problem tak szybko, jak to możliwe.

Mimo że sztuczna inteligencja poczyniła ogromne postępy, nie jest wolna od błędów, a problem halucynacji AI stanowi poważne wyzwanie dla różnych osób i branż, w tym opieki zdrowotnej, tworzenia treści i przemysłu motoryzacyjnego.

Mimo że naukowcy pracują nad rozwiązaniem problemu, my jako użytkownicy również powinniśmy wprowadzać konkretne i dokładne polecenia, dodawać przykłady i dostarczać szablony danych, aby uzyskać precyzyjne odpowiedzi, unikać błędów w danych szkoleniowych modelu AI i zapobiegać halucynacjom.

Nawet jeśli halucynacje AI uda się całkowicie wyleczyć, nadal pozostaje pytanie: czy powinniśmy całkowicie zaufać sztucznej inteligencji? Uważam, że jest nadzieja i że możemy w dalszym ciągu korzystać z systemów sztucznej inteligencji w sposób odpowiedzialny i bezpieczny, aby przynosiły korzyści światu.

A teraz przykłady sztucznej inteligencji (AI) w naszym codziennym życiu.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.