Najważniejsze informacje o oszustwach głosowych

- Technologia klonowania głosu wykorzystująca sztuczną inteligencję pozwala na niezwykle realistyczne odwzorowanie ludzkiego głosu, co oszuści wykorzystują do manipulacji emocjami i wywoływania poczucia pilności.

- Cyberprzestępcy analizują dane z mediów społecznościowych, aby tworzyć przekonujące scenariusze i grać na ludzkich emocjach i relacjach.

- Zawsze zachowuj czujność i naucz się rozpoznawać sygnały ostrzegawcze oszustw związanych z klonowaniem głosu AI. W razie wątpliwości, rozłącz połączenie i zweryfikuj informacje.

Wyobraź sobie, że późną nocą Twoi rodzice odbierają nagranie głosowe, w którym spanikowany głos ich dziecka informuje o poważnych kłopotach – zgubieniu portfela i utknięciu w nieznanym miejscu. Konieczna jest natychmiastowa pomoc finansowa, aby umożliwić mu powrót do domu.

Głos w wiadomości brzmi nadzwyczaj autentycznie, jednak to mistyfikacja. Jest to sklonowany głos AI, stanowiący element nowej, niebezpiecznej strategii oszustwa.

Na czym polega oszustwo z klonowaniem głosu AI?

Klonowanie głosu umożliwia generowanie bardzo wiarygodnych cyfrowych kopii ludzkiego głosu. Technika ta, często nazywana deepfake audio, wykorzystuje zaawansowane narzędzia, takie jak ElevenLabs (przykłady znajdziesz poniżej). W połączeniu z mocą sztucznej inteligencji i syntezą mowy, sklonowany głos potrafi naśladować emocje, niuanse, intonację, a nawet strach.

Dla porównania, posłuchaj, jak brzmi Christian Cawley w swoim podcaście „Really Useful Podcast”.

Do wygenerowania klonu głosu AI wystarczy bardzo krótka próbka – często zaledwie minuta, a nawet mniej. Takie próbki są często pobierane z publicznie dostępnych materiałów w mediach społecznościowych, co stwarza ryzyko dla twórców wideo i influencerów. Jakość nagrań jest wysoka, a dostęp do nich – łatwy.

Gdy oszust zdobędzie próbkę głosu, wykorzystuje technologię zamiany tekstu na mowę lub generowanie mowy w czasie rzeczywistym, aby tworzyć fałszywe połączenia telefoniczne i wiadomości głosowe.

Po przeanalizowaniu kont w mediach społecznościowych i zebraniu danych osobowych ofiary, oszust tworzy wysoce przekonujący scenariusz. Może to być na przykład hospitalizacja, aresztowanie, kradzież, porwanie – czyli sytuacje wywołujące silny lęk. Sklonowany głos jest następnie wykorzystywany do zmanipulowania członka rodziny, który uwierzy, że jego bliska osoba jest w poważnym niebezpieczeństwie.

Realizm głosu i emocjonalne zabarwienie w połączeniu z szokiem i presją czasu mogą zniwelować sceptycyzm, prowadząc do impulsywnych decyzji o przekazaniu pieniędzy lub ujawnieniu wrażliwych danych.

Dlaczego oszustwa z klonowaniem głosu AI są tak skuteczne?

Oszustwa z klonowaniem głosu AI, podobnie jak większość oszustw wycelowanych w rodzinę i przyjaciół, bazują na wykorzystywaniu bliskich relacji. Wiadomość o problemach bliskiej osoby wywołuje panikę, która zakłóca zdolność racjonalnej oceny sytuacji i prowadzi do pochopnych działań. Jest to podobna taktyka do oszustw typu „quid pro quo”, ale spotęgowana przez rozpoznawalny głos bliskiej osoby.

Szczególnie narażone są osoby często aktywne w mediach społecznościowych, a także podróżujące, ponieważ ich sytuacja stwarza wiarygodny kontekst dla sfabrykowanej opowieści. Cyberprzestępcy z wyprzedzeniem gromadzą informacje z publicznych kont, aby uwiarygodnić swoje historie.

Główne sygnały ostrzegawcze oszustwa z klonowaniem głosu AI

Mimo zaawansowania oszustw z klonowaniem głosu AI, istnieją pewne sygnały ostrzegawcze, które mogą pomóc w ich rozpoznaniu:

- Presja czasu: Oszust wywiera presję, twierdząc, że natychmiastowe działanie jest niezbędne.

- Niespójności: Oszuści często nie znają wszystkich szczegółów relacji z celem, więc zwracaj uwagę na ewentualne sprzeczności.

- Nietypowe żądania: Prośby o przelew pieniędzy na zagraniczne konta bankowe lub portfele kryptowalut są częstą taktyką.

Rozpoznanie tych sygnałów w stresującej sytuacji jest trudne, ale może Cię ochronić przed oszustwem.

Co robić, jeśli podejrzewasz oszustwo z klonowaniem głosu AI?

Jeśli otrzymasz telefon lub wiadomość głosową od bliskich osób, które rzekomo są w niebezpieczeństwie, zachowaj spokój. Oszuści liczą na to, że panika i emocje osłabią Twoją zdolność krytycznego myślenia.

Jeśli odbierzesz telefon

W przypadku podejrzenia, że rozmowa telefoniczna może być oszustwem związanym z klonowaniem głosu, natychmiast się rozłącz. Nie podawaj żadnych informacji i nie podejmuj współpracy z oszustami. Zamiast tego, zadzwoń do bliskiej osoby pod znany numer, aby zweryfikować sytuację.

Dalsza rozmowa z oszustami może spowodować, że Twój głos zostanie nagrany i sklonowany.

Jeśli otrzymasz wiadomość głosową

Jeśli oszuści zostawili wiadomość głosową, od razu zapisz ją na telefonie lub komputerze. Próbka audio może być wykorzystana w narzędziu do klasyfikacji mowy AI, aby określić, czy głos jest ludzki. Te klasyfikatory działają na podobnej zasadzie jak detektory tekstu generowanego przez AI. Wystarczy przesłać plik audio, a klasyfikator oceni, czy pochodzi od człowieka, czy został wygenerowany przez sztuczną inteligencję.

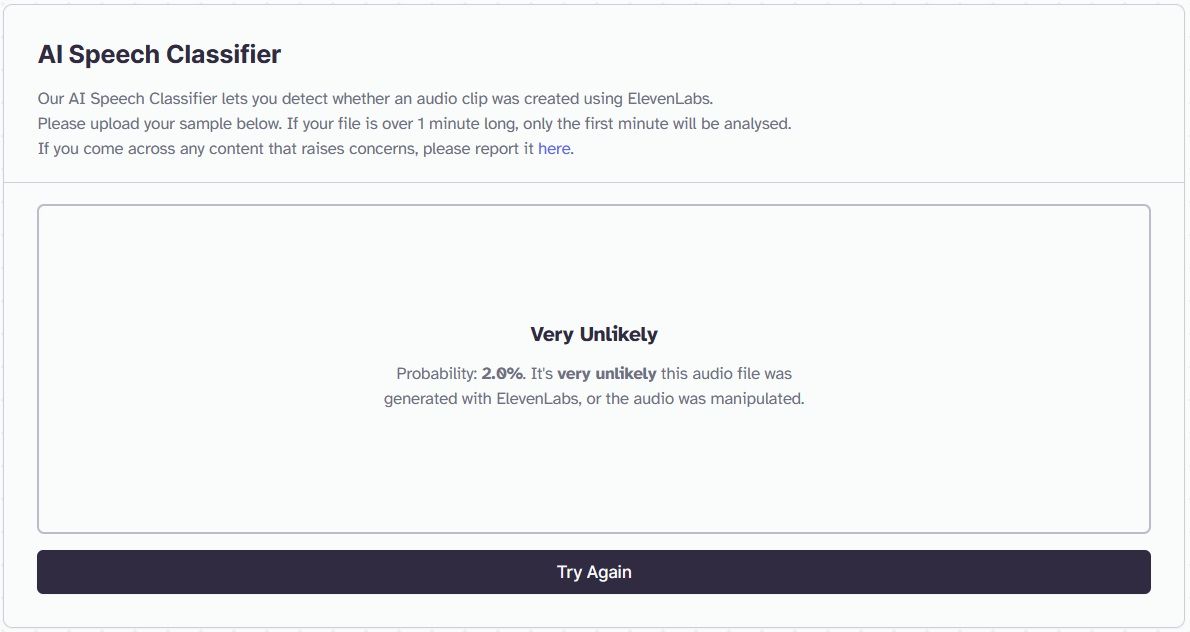

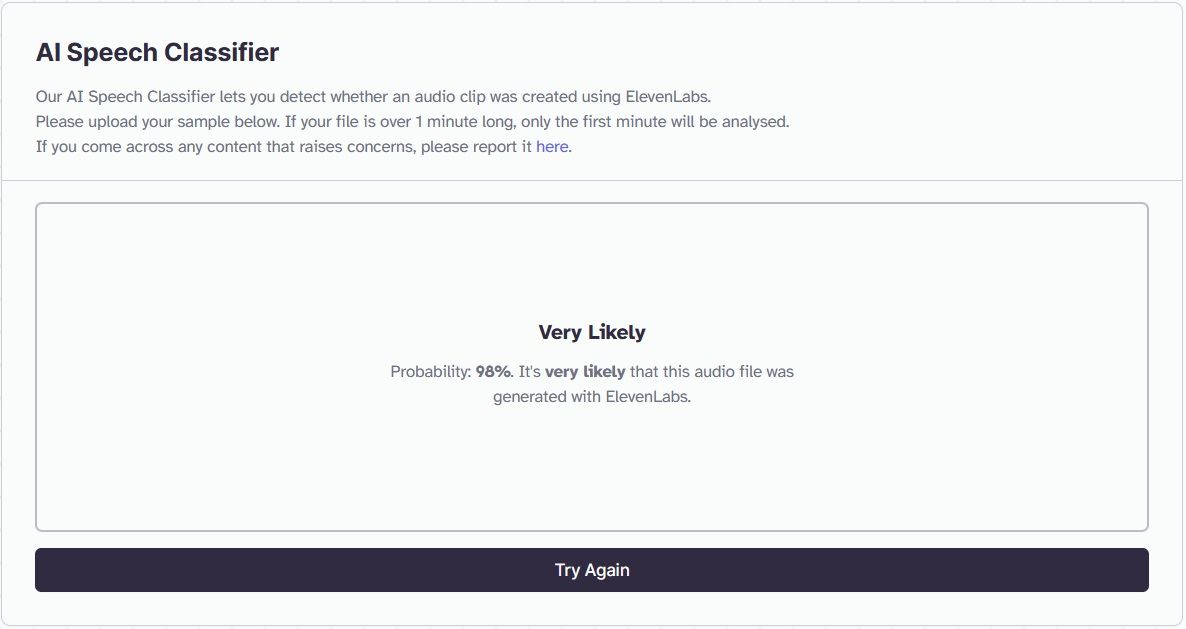

Dobrym narzędziem do sprawdzenia autentyczności głosu jest klasyfikator mowy ElevenLabs. ElevenLabs wspiera wiele platform klonowania głosu AI, co czyni go idealnym narzędziem do weryfikacji, czy dany głos został sklonowany. Oto jak go użyć:

W przedstawionym przykładzie, alarmująca wiadomość została nagrana przez człowieka i przesłana do klasyfikatora. Jak widać, została ona oceniona jako mająca 2% szans na bycie zmanipulowaną.

W kolejnym przykładzie, ta sama wiadomość została wygenerowana za pomocą narzędzia do klonowania głosu AI. Dla ludzkiego ucha głosy są nie do odróżnienia. Natomiast narzędzie wykazało, że wiadomość ma 98% szans na bycie wygenerowaną przez sztuczną inteligencję.

Chociaż ten klasyfikator nie jest niezawodny w 100%, może pomóc w weryfikacji podejrzeń o wykorzystanie sklonowanego głosu. Należy również skontaktować się z bliską osobą pod znanym numerem, aby potwierdzić jej bezpieczeństwo.

Zapobieganie to najlepsza ochrona przed oszustwami z klonowaniem głosu AI

Czasem najlepszym sposobem na ochronę przed oszustwami wykorzystującymi zaawansowaną technologię jest rozwiązanie, które nie wymaga zaawansowanej wiedzy.

Ustal hasło, które znane będzie tylko bliskim. W przypadku panicznego połączenia, użycie hasła może być pewnym sposobem na zweryfikowanie tożsamości osoby dzwoniącej.

Kolejnym krokiem jest ukrywanie prywatnych informacji w mediach społecznościowych. Ograniczenie dostępu do danych znacząco zmniejsza szansę na to, że oszuści będą mogli zebrać wystarczająco dużo informacji, aby stworzyć wiarygodną narrację. Pamiętaj, jeśli nie chcesz, aby wszyscy o czymś wiedzieli, lepiej tego nie publikować w mediach społecznościowych.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.