Ochrona danych firmowych podczas korzystania z ChatGPT

ChatGPT stał się nieocenionym wsparciem w wykonywaniu zadań zawodowych. Jednakże, w kontekście rosnących obaw o bezpieczeństwo danych w sieci, niezbędna jest szczególna ostrożność w kwestii ochrony informacji wrażliwych. Ostatnie przypadki naruszeń bezpieczeństwa danych w ChatGPT stanowią wyraźne ostrzeżenie o podatności technologii na zagrożenia związane z prywatnością. Poniżej przedstawiono kilka wskazówek dotyczących odpowiedzialnego korzystania z ChatGPT, które pomogą w zabezpieczeniu poufnych danych firmowych.

1. Wyłącz zapisywanie historii czatów

Jednym z najprostszych, a zarazem skutecznych sposobów na zwiększenie ochrony prywatności jest rezygnacja z opcji zapisywania historii rozmów. Domyślnie, ChatGPT przechowuje wszystkie interakcje użytkowników z chatbotem. Te konwersacje są gromadzone w celu doskonalenia systemów OpenAI i podlegają weryfikacji przez moderatorów.

Mimo że moderacja ma na celu zapewnienie zgodności z regulaminem OpenAI, stanowi również potencjalne zagrożenie dla użytkownika. Jak donosi The Verge, firmy takie jak Apple, JP Morgan, Verizon i Amazon wprowadziły zakaz korzystania z narzędzi AI przez swoich pracowników, obawiając się wycieku lub gromadzenia poufnych danych wprowadzanych do tych systemów.

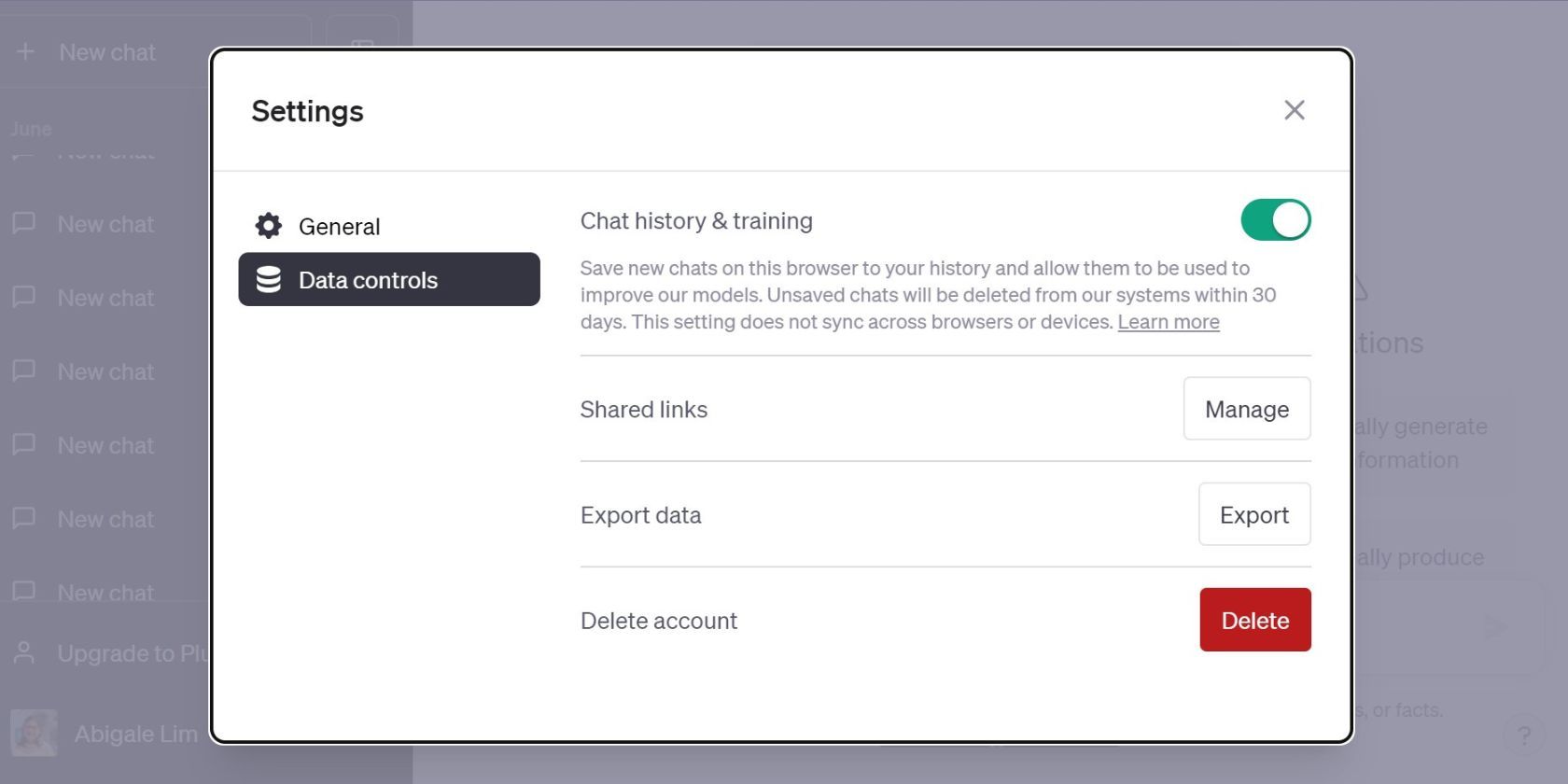

Aby wyłączyć historię czatów, postępuj zgodnie z instrukcjami:

Należy pamiętać, że jak informuje OpenAI, nawet po wyłączeniu tej opcji rozmowy są przechowywane przez 30 dni i mogą być analizowane przez moderatorów pod kątem nadużyć, zanim zostaną trwale usunięte. Mimo to wyłączenie historii czatów jest jedną z najlepszych praktyk, jeśli zamierzasz nadal korzystać z ChatGPT.

Wskazówka: Jeżeli potrzebujesz dostępu do danych wprowadzonych w ChatGPT, najpierw je wyeksportuj. Możesz także zapisać je za pomocą zrzutów ekranu, notatek, kopiowania i wklejania do innej aplikacji lub bezpiecznego magazynu w chmurze.

2. Regularnie usuwaj rozmowy

Poważnym zagrożeniem związanym z ChatGPT OpenAI są potencjalne naruszenia bezpieczeństwa danych. Awaria ChatGPT, która spowodowała dochodzenie Federalnej Komisji Handlu, wyraźnie pokazuje ryzyko związane z korzystaniem z tej aplikacji.

Jak wynika z komunikatu OpenAI dotyczącego awarii z 20 marca 2023 r., incydent był spowodowany błędem w bibliotece open-source. Wyciek umożliwił użytkownikom dostęp do tytułów historii rozmów innych osób. Ujawnił on także informacje dotyczące płatności 1,2% subskrybentów ChatGPT Plus, w tym nazwiska, dane kart kredytowych oraz adresy e-mail.

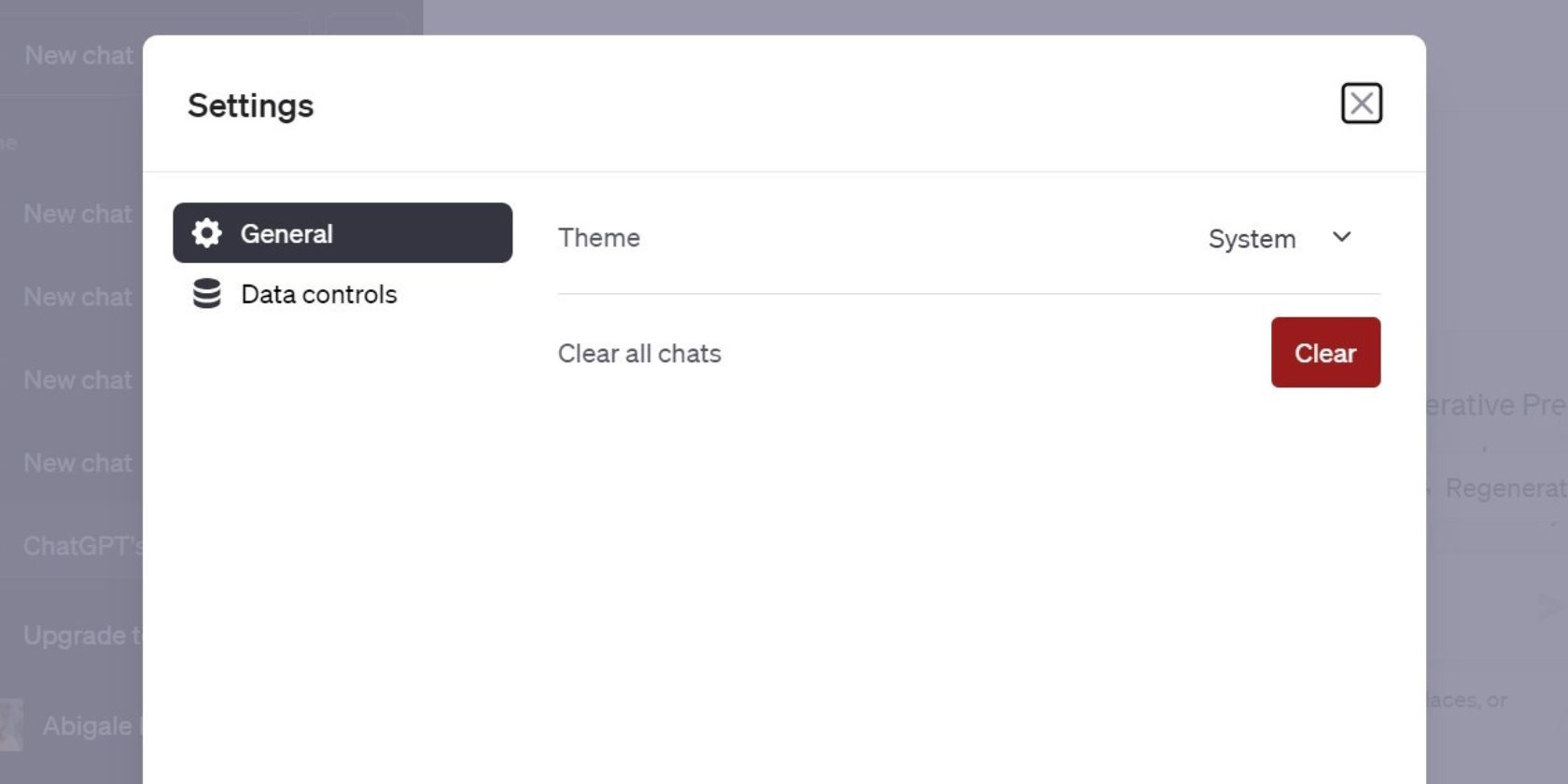

Usuwanie rozmów pomaga w ochronie danych przed takimi zagrożeniami. Aby usunąć rozmowy, wykonaj następujące kroki:

Alternatywnie, można usuwać pojedyncze rozmowy. Ta metoda jest przydatna, gdy chcesz zachować niektóre czaty. Na liście rozmów kliknij wybraną rozmowę, a następnie kliknij ikonę kosza, aby ją usunąć.

3. Unikaj udostępniania poufnych informacji firmowych w ChatGPT

Zachowaj szczególną ostrożność i nie udostępniaj w ChatGPT wrażliwych danych związanych z pracą. Jednym z najczęściej powtarzanych mitów na temat prywatności w Internecie jest przekonanie, że firmy będą chronić Twoje dane wyłącznie dlatego, że deklarują to w regulaminie.

Nie przekazuj do ChatGPT dokumentacji finansowej, informacji o własności intelektualnej, danych klientów ani chronionych danych zdrowotnych. W ten sposób zwiększasz ryzyko ujawnienia wrażliwych informacji cyberprzestępcom. Może to prowadzić do problemów prawnych dla Ciebie i Twojej firmy.

Potężny wyciek danych z ChatGPT w okresie od czerwca 2022 roku do maja 2023 roku pokazuje, jak ważna jest ta zasada. Jak podaje Search Engine Journal, w wyniku tego incydentu ponad 100 000 danych logowania do kont ChatGPT zostało skradzionych i sprzedanych na czarnym rynku internetowym.

Ogranicz korzystanie z ChatGPT do zapytań niepoufnych i unikaj ujawniania zastrzeżonych informacji. Dodatkowo stosuj odpowiednią higienę haseł i włącz uwierzytelnianie dwuskładnikowe, aby zabezpieczyć konto przed naruszeniem bezpieczeństwa.

4. Stosuj techniki anonimizacji danych

Techniki anonimizacji danych pomagają chronić prywatność osób, jednocześnie umożliwiając analizę zbiorów danych. Podczas korzystania z ChatGPT w pracy stosuj te techniki, aby uniemożliwić bezpośrednią lub pośrednią identyfikację osób w danych.

Poniżej przedstawiono kilka podstawowych technik anonimizacji danych, za Singapore Personal Data Protection Commission:

- Pomijanie atrybutów: Usuń te elementy danych, które nie są konieczne w danej analizie. Załóżmy, że chcesz przeanalizować wzorce wydatków klientów. Możesz podać ChatGPT kwoty transakcji i daty zakupów. Nie udostępniaj jednak imienia i nazwiska klienta ani danych jego karty kredytowej, ponieważ nie są one niezbędne do analizy.

- Pseudonimizacja: Zastąp dane osobowe pseudonimami. Na przykład imiona pacjentów w dokumentacji medycznej można zastąpić pseudonimami, takimi jak „Pacjent001”, „Pacjent002” itd.

- Zakłócanie danych: Wprowadzaj drobne modyfikacje w wartościach danych, w określonym przedziale. Przykładowo, udostępniając dane o wieku pacjentów, można dodać niewielkie losowe wartości (np. ±2 lata) do prawdziwego wieku każdej osoby.

- Uogólnianie: Celowo redukuj szczegółowość danych. Zamiast ujawniać dokładny wiek danej osoby, możesz uogólnić go, grupując wiek w szersze przedziały (np. 20-30, 31-40 itd.).

- Maskowanie znaków: Ujawniaj tylko fragment wrażliwych danych. Na przykład możesz pokazać tylko trzy pierwsze cyfry numeru telefonu, a pozostałe zastąpić znakiem „X” (np. 555-XXX-XXXX).

Należy jednak pamiętać, że anonimizacja nie jest niezawodna, ponieważ dane mogą zostać zreidentyfikowane. Zanim zastosujesz którąkolwiek z tych technik, zapoznaj się z koncepcją deanonimizacji i sposobami jej zapobiegania. Zawsze dokonaj oceny ryzyka przed udostępnieniem zanonimizowanych danych.

5. Ogranicz dostęp do poufnych danych

Ograniczenie dostępu do poufnych danych firmowych jest kluczowe, szczególnie w przypadku, gdy pracownicy mogą korzystać z ChatGPT. Jeśli zajmujesz stanowisko kierownicze, ogranicz dostęp do wrażliwych informacji wyłącznie do upoważnionego personelu, który potrzebuje ich w celu wykonywania swoich obowiązków.

Wprowadź odpowiednie mechanizmy kontroli dostępu, aby chronić dane firmy. Przykładowo, kontrola dostępu oparta na rolach (RBAC) zapewnia, że upoważnieni pracownicy mają dostęp jedynie do danych niezbędnych do wykonywania swoich zadań. Regularnie przeprowadzaj przeglądy dostępu, aby upewnić się, że mechanizmy kontroli działają skutecznie. Pamiętaj, aby odebrać dostęp pracownikom, którzy zmieniają stanowisko lub odchodzą z firmy.

6. Uważaj na aplikacje firm trzecich

Ważnym pytaniem jest, czy aplikacje i rozszerzenia przeglądarki ChatGPT firm trzecich są bezpieczne. Zanim zaczniesz używać którejkolwiek z tych aplikacji w pracy, dokładnie je zweryfikuj. Upewnij się, że nie gromadzą i nie przechowują informacji w podejrzanych celach.

Nie instaluj podejrzanych aplikacji, które wymagają losowych uprawnień na Twoim telefonie. Dokładnie sprawdź ich praktyki w zakresie przetwarzania danych, aby upewnić się, że są zgodne z normami ochrony prywatności obowiązującymi w Twojej firmie.

Odpowiedzialne korzystanie z ChatGPT w pracy

Ochrona prywatności podczas korzystania z ChatGPT w pracy jest wyzwaniem. Jeśli musisz używać ChatGPT w pracy, zrozum ryzyko związane z prywatnością. Nie ma niezawodnego sposobu, aby zabezpieczyć dane po ich przekazaniu do narzędzia AI, jednak można podjąć kroki w celu zmniejszenia ryzyka wycieku danych.

ChatGPT ma wiele praktycznych zastosowań w pracy, ale podczas korzystania z niego ważne jest, aby chronić dane firmy. Zrozumienie polityki prywatności ChatGPT pomoże ci zdecydować, czy narzędzie to jest warte ryzyka.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.