Spis treści:

- Deepfakes stwarzają poważne zagrożenia dla społeczeństwa, w tym szerzenie dezinformacji, niszczenie reputacji poprzez podszywanie się i wszczynanie konfliktów w imię bezpieczeństwa narodowego.

- Choć technologia sztucznej inteligencji oferuje narzędzia do wykrywania deepfake’ów, nie są one doskonałe, a w identyfikowaniu deepfake’ów kluczowa jest ludzka dyskrecja.

- Narzędzia do wykrywania ludzi i sztucznej inteligencji mają różne mocne i słabe strony w identyfikowaniu deepfake, a połączenie ich umiejętności może poprawić wskaźniki powodzenia w wykrywaniu i łagodzeniu zagrożeń związanych z technologią deepfake.

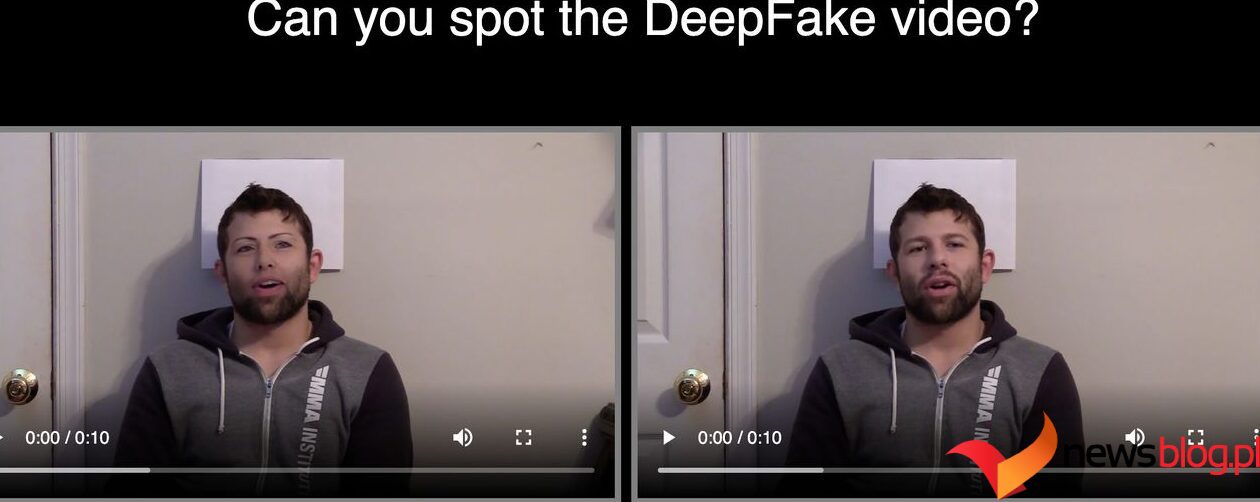

Deepfakes zagrażają każdemu aspektowi społeczeństwa. Nasza zdolność do identyfikowania fałszywych treści ma kluczowe znaczenie dla unicestwienia dezinformacji, ale w miarę doskonalenia się technologii sztucznej inteligencji komu możemy zaufać w wykrywaniu deepfakes: człowiekowi czy maszynie?

Niebezpieczeństwa związane z Deepfakes

W miarę postępu technologii sztucznej inteligencji zagrożenia związane z deepfake’ami stanowią coraz większe zagrożenie dla nas wszystkich. Oto krótkie podsumowanie niektórych z najpilniejszych problemów związanych z deepfakes:

- Dezinformacja: sfałszowane filmy i nagrania głosowe mogą rozpowszechniać dezinformację, na przykład fałszywe wiadomości.

- Podszywanie się pod inne osoby: deepfakes podszywając się pod inne osoby mogą zaszkodzić reputacji danej osoby lub oszukać każdą osobę, której znają.

- Bezpieczeństwo narodowe: Oczywistym scenariuszem zagłady w przypadku deepfakes jest sfabrykowany materiał filmowy lub dźwiękowy przedstawiający światowego przywódcę podżegającego do konfliktu.

- Niepokoje społeczne: strony mogą również wykorzystywać zwodnicze nagrania i nagrania dźwiękowe w celu wzniecania gniewu i niepokojów społecznych wśród określonych grup.

- Cyberbezpieczeństwo: cyberprzestępcy korzystają już z narzędzi do klonowania głosu AI, aby kierować do konkretnych osób przekonujące wiadomości od znanych im osób.

- Prywatność i zgoda: złośliwe wykorzystanie deepfakes polega na podrabianiu podobizny osób bez ich zgody.

- Zaufanie i pewność: jeśli nie potrafisz odróżnić prawdy od oszustwa, dokładne informacje stają się równie niewiarygodne.

Deepfake będą coraz bardziej przekonujące, dlatego potrzebujemy solidnych narzędzi i procesów do ich wykrywania. Sztuczna inteligencja udostępnia jedno z takich narzędzi w postaci modeli wykrywania deepfake. Jednak podobnie jak algorytmy zaprojektowane do identyfikowania tekstów generowanych przez sztuczną inteligencję, narzędzia do wykrywania deepfake nie są doskonałe.

W tej chwili ludzka dyskrecja jest jedynym narzędziem, na którym możemy polegać. Czy jesteśmy lepsi od algorytmów w identyfikowaniu deepfakes?

Czy algorytmy mogą wykrywać deepfakes lepiej niż ludzie?

Deepfakes stanowią na tyle poważne zagrożenie, że giganci technologiczni i grupy badawcze przeznaczają ogromne zasoby na badania i rozwój. W 2019 r. firmy takie jak Meta, Microsoft i Amazon zaoferowały nagrody o wartości 1 000 000 dolarów podczas konkursu Wyzwanie związane z wykrywaniem deepfake’ów dla najdokładniejszego modelu detekcji.

Najskuteczniejszy model miał skuteczność na poziomie 82,56% w porównaniu ze zbiorem danych obejmującym publicznie dostępne filmy. Jednak gdy te same modele przetestowano w oparciu o „zbiór danych czarnej skrzynki” obejmujący 10 000 niewidzianych filmów, najskuteczniejszy model okazał się dokładny jedynie na poziomie 65,18%.

Przeprowadziliśmy również wiele badań analizujących skuteczność narzędzi AI do wykrywania deepfake’ów przeciwko ludziom. Oczywiście wyniki różnią się w zależności od badania, ale ogólnie rzecz biorąc, ludzie albo dorównują wskaźnikowi skuteczności narzędzi do wykrywania deepfake, albo je przewyższają.

Jedno badanie z 2021 r. opublikowane na stronie PNAS odkryli, że „zwykli ludzie obserwatorzy” osiągnęli nieco wyższy współczynnik dokładności niż wiodące narzędzia do wykrywania deepfake. Jednak badanie wykazało również, że uczestnicy badania i modele sztucznej inteligencji były podatne na różnego rodzaju błędy.

Co ciekawe, badania przeprowadzone przez Uniwersytet w Sydney odkryło, że ludzki mózg jest, nieświadomie, skuteczniejszy w wykrywaniu deepfake’ów niż nasze świadome wysiłki.

Wykrywanie wskazówek wizualnych w Deepfakes

Nauka o wykrywaniu deepfake’ów jest złożona, a wymagana analiza różni się w zależności od charakteru materiału filmowego. Na przykład niesławny film deepfake przedstawiający północnokoreańskiego przywódcę Kim Dzong-una z 2020 r. to w zasadzie film mówiący. W tym przypadku najskuteczniejszą metodą wykrywania deepfake może być analiza visemów (ruchów ust) i fonemów (dźwięków fonetycznych) pod kątem niespójności.

Tego rodzaju analizy mogą przeprowadzać eksperci, zwykli widzowie i algorytmy, nawet jeśli wyniki są różne. The MIT definiuje osiem pytań pomagających zidentyfikować filmy deepfake:

- Zwróć uwagę na twarz. Wysokiej klasy manipulacje DeepFake to prawie zawsze transformacje twarzy.

- Zwróć uwagę na policzki i czoło. Czy skóra wydaje się zbyt gładka lub zbyt pomarszczona? Czy starzenie się skóry jest podobne do starzenia się włosów i oczu? DeepFakes mogą być niespójne w niektórych wymiarach.

- Zwróć uwagę na oczy i brwi. Czy cienie pojawiają się w miejscach, których można się spodziewać? DeepFakes może nie odzwierciedlać w pełni naturalnej fizyki sceny.

- Zwróć uwagę na okulary. Czy jest jakiś odblask? Czy jest za dużo odblasków? Czy kąt olśnienia zmienia się, gdy osoba się porusza? Po raz kolejny DeepFakes może nie odzwierciedlić w pełni naturalnej fizyki oświetlenia.

- Zwróć uwagę na zarost lub jego brak. Czy ten zarost wygląda naprawdę? DeepFakes może dodać lub usunąć wąsy, baki lub brodę. Jednak DeepFakes może nie sprawić, że transformacja zarostu na twarzy będzie w pełni naturalna.

- Zwróć uwagę na pieprzyki na twarzy. Czy kret wygląda na prawdziwy?

- Zwróć uwagę na mruganie. Czy osoba mruga wystarczająco czy za dużo?

- Zwróć uwagę na ruchy warg. Niektóre deepfakes opierają się na synchronizacji ruchu warg. Czy ruchy ust wyglądają naturalnie?

Najnowsze narzędzia AI do wykrywania deepfake’ów potrafią ponownie analizować te same czynniki, z różnym skutkiem. Analitycy zajmujący się danymi stale opracowują także nowe metody, takie jak wykrywanie naturalnego przepływu krwi w twarzach głośników ekranowych. Nowe podejścia i ulepszenia istniejących mogą w przyszłości sprawić, że narzędzia do wykrywania deepfake’ów oparte na sztucznej inteligencji będą stale przewyższać ludzi.

Wykrywanie wskazówek dźwiękowych w Deepfakes

Wykrywanie fałszywego dźwięku to zupełnie inne wyzwanie. Bez wizualnych wskazówek wideo i możliwości zidentyfikowania niespójności audiowizualnych wykrywanie deepfake’ów w dużej mierze opiera się na analizie dźwięku (w niektórych przypadkach pomocne mogą być również inne metody, takie jak weryfikacja metadanych).

Badanie opublikowane przez University College London w 2023 r. odkryli, że ludzie potrafią wykryć fałszywą mowę w 73% przypadków (angielski i mandaryński). Podobnie jak w przypadku filmów typu deepfake, słuchacze często intuicyjnie wykrywają nienaturalne wzorce mowy w mowie generowanej przez sztuczną inteligencję, nawet jeśli nie potrafią określić, co wydaje się niewłaściwe.

Typowe objawy obejmują:

- Bełkotliwy

- Brak ekspresji

- Hałas tła lub zakłócenia

- Niespójność głosu lub mowy

- Brak „pełni” w głosach

- Przesyłanie zawierające zbyt dużo skryptów

- Brak niedoskonałości (falstarty, poprawki, chrząkanie itp.)

Po raz kolejny algorytmy mogą również analizować mowę pod kątem tych samych fałszywych sygnałów, ale nowe metody zwiększają skuteczność narzędzi. Badania wg USENIX zidentyfikowali wzorce w rekonstrukcji traktu głosowego AI, które nie naśladują naturalnej mowy. Podsumowując, generatory głosu AI wytwarzają dźwięk dopasowujący się do wąskich dróg głosowych (mniej więcej wielkości słomki do picia) bez naturalnych ruchów ludzkiej mowy.

Wcześniejsze badania z Instytut Horsta Görtza przeanalizował autentyczny i deepfakes dźwięk w języku angielskim i japońskim, ujawniając subtelne różnice w wyższych częstotliwościach prawdziwej mowy i deepfakes.

Zarówno droga głosowa, jak i niespójności w zakresie wysokich częstotliwości są zauważalne dla ludzkich słuchaczy i modeli wykrywania sztucznej inteligencji. W przypadku różnic o wysokiej częstotliwości modele sztucznej inteligencji mogłyby teoretycznie stać się coraz dokładniejsze – chociaż to samo można powiedzieć o deepfakesach AI.

Deepfakes dają się oszukać zarówno ludziom, jak i algorytmom, ale na różne sposoby

Badania sugerują, że ludzie i najnowsze narzędzia do wykrywania sztucznej inteligencji są w podobny sposób zdolne do identyfikowania deepfakes. Wskaźniki powodzenia mogą wahać się od 50% do 90+%, w zależności od parametrów testu.

Co za tym idzie, ludzie i maszyny również w podobnym stopniu dają się oszukać deepfakes. Co jednak najważniejsze, jesteśmy podatni na różne sposoby i to może być naszym największym atutem w walce z zagrożeniami związanymi z technologią deepfake. Połączenie mocnych stron ludzi i narzędzi do wykrywania deepfake złagodzi słabe strony każdego z nich i poprawi wskaźniki powodzenia.

Na przykład, MIT badania wykazały, że ludzie lepiej niż modele sztucznej inteligencji identyfikują fałszywe podróbki światowych przywódców i sławnych osób. Ujawniło również, że modele sztucznej inteligencji miały problemy z materiałami filmowymi z udziałem wielu osób, choć sugerowało, że może to wynikać z trenowania algorytmów na materiałach wideo z pojedynczymi głośnikami.

Z drugiej strony to samo badanie wykazało, że modele sztucznej inteligencji osiągały lepsze wyniki niż ludzie w przypadku materiałów o niskiej jakości (rozmytych, ziarnistych, ciemnych itp.), które można celowo wykorzystać do oszukania widzów. Podobnie najnowsze metody wykrywania sztucznej inteligencji, takie jak monitorowanie przepływu krwi w określonych obszarach twarzy, obejmują analizę, do której ludzie nie są w stanie.

W miarę opracowywania większej liczby metod zdolność sztucznej inteligencji do wykrywania znaków, których nie możemy, tylko się poprawi, ale także jej zdolność do oszukiwania. Najważniejsze pytanie brzmi, czy technologia wykrywania deepfake’ów będzie w dalszym ciągu wyprzedzić same deepfake’i.

Spojrzenie na rzeczy inaczej w epoce Deepfakes

Narzędzia AI do wykrywania deepfake’ów będą w dalszym ciągu udoskonalane, podobnie jak jakość samych treści deepfake. Jeśli zdolność sztucznej inteligencji do oszukiwania przewyższa jej zdolność do wykrywania (jak ma to miejsce w przypadku tekstu generowanego przez sztuczną inteligencję), ludzka dyskrecja może być jedynym narzędziem, jakie nam pozostało do walki z deepfakes.

Każdy ma obowiązek poznać oznaki deepfakes i dowiedzieć się, jak je rozpoznać. Oprócz ochrony przed oszustwami i zagrożeniami bezpieczeństwa wszystko, co omawiamy i udostępniamy w Internecie, jest podatne na dezinformację, jeśli stracimy poczucie rzeczywistości.