Wraz z pojawieniem się nowych technologii, takich jak głębokie uczenie, sztuczna inteligencja i ML, procesory graficzne w chmurze są bardzo poszukiwane.

Jeśli Twoja organizacja zajmuje się wizualizacjami 3D, uczeniem maszynowym (ML), sztuczną inteligencją (AI) lub jakimś ciężkim przetwarzaniem, sposób wykonywania obliczeń GPU ma duże znaczenie.

Tradycyjnie modele uczenia głębokiego w organizacjach zajmowały dużo czasu na zadania szkoleniowe i obliczeniowe. Kiedyś zabijało ich czas, kosztowało ich dużo i pozostawiało im problemy z przechowywaniem i przestrzenią, zmniejszając produktywność.

Układy GPU nowej ery mają na celu rozwiązanie tego problemu. Oferują wysoką wydajność do równoległego wykonywania ciężkich obliczeń i szybszego treningu dla modeli AI.

Według badań Indigo, procesory graficzne mogą oferować 250 razy szybciej wydajność niż procesory podczas uczenia sieci neuronowych związanych z głębokim uczeniem.

Wraz z postępem przetwarzania w chmurze mamy teraz procesory graficzne w chmurze, które przekształcają świat nauki o danych i innych nowych technologii, oferując jeszcze większą wydajność, łatwą konserwację, niższe koszty, szybkie skalowanie i oszczędność czasu.

W tym artykule przedstawiono koncepcje GPU w chmurze, jego związek z AI, ML, uczeniem głębokim i niektórymi z najlepszych platform GPU w chmurze, które można znaleźć, aby wdrożyć preferowany procesor GPU w chmurze.

Zaczynajmy!

Spis treści:

Co to jest procesor graficzny w chmurze?

Aby zrozumieć procesor graficzny w chmurze, porozmawiajmy najpierw o procesorach graficznych.

Jednostka przetwarzania grafiki (GPU) odnosi się do wyspecjalizowanego obwodu elektronicznego używanego do szybkiej zmiany i manipulowania pamięcią w celu przyspieszenia tworzenia obrazów lub grafiki.

Nowoczesne procesory graficzne oferują wyższą wydajność w manipulowaniu przetwarzaniem obrazu i grafiką komputerową ze względu na ich strukturę równoległą niż jednostki centralne (CPU). Procesor graficzny jest osadzony na płycie głównej lub umieszczony na karcie graficznej lub kości procesora komputera PC.

Cloud Graphics Units (GPU) to instancje komputerowe z solidną akceleracją sprzętową pomocną w uruchamianiu aplikacji obsługujących ogromne obciążenia sztucznej inteligencji i uczenia głębokiego w chmurze. Nie musisz wdrażać fizycznego GPU na swoim urządzeniu.

Niektóre popularne procesory graficzne to NVIDIA, AMD, Radeon, GeForce i inne.

GPU są wykorzystywane w:

- Telefony komórkowe

- Konsole gier

- Stacje robocze

- Systemy wbudowane

- Komputery osobiste

Do czego służą GPU:

Oto kilka przypadków użycia procesorów graficznych:

- W AI i ML do rozpoznawania obrazu

- Obliczenia dla grafiki komputerowej 3D i rysunków CAD

- Mapowanie tekstur i renderowanie wielokątów

- Obliczenia geometryczne, takie jak translacje i rotacje wierzchołków na układy współrzędnych

- Obsługa programowalnych shaderów do manipulowania teksturami i wierzchołkami

- Przyspieszone przez GPU kodowanie, dekodowanie i przesyłanie strumieniowe wideo

- Gry z bogatą grafiką i gry w chmurze

- Modelowanie matematyczne na szeroką skalę, analizy i głębokie uczenie, które wymagają możliwości przetwarzania równoległego procesorów graficznych ogólnego przeznaczenia.

- Edycja wideo, projektowanie graficzne i tworzenie treści

Jakie są zalety procesorów graficznych w chmurze?

Główne zalety korzystania z procesorów graficznych w chmurze to:

Wysoce skalowalny

Jeśli chcesz rozwinąć swoją organizację, jej obciążenie pracą w końcu wzrośnie. Będziesz potrzebować procesora graficznego, który może skalować się wraz ze zwiększonym obciążeniem pracą. Procesory graficzne w chmurze mogą Ci w tym pomóc, umożliwiając łatwe i bezproblemowe dodawanie większej liczby procesorów graficznych, dzięki czemu możesz sprostać zwiększonym obciążeniom. I odwrotnie, jeśli chcesz zmniejszyć skalę, jest to również możliwe szybko.

Minimalizuje koszty

Zamiast kupować fizyczne procesory graficzne o dużej mocy, które kosztują niewiarygodnie wysokie ceny, możesz wypożyczyć procesory graficzne w chmurze, które są dostępne za niższą stawkę godzinową. Opłata zostanie naliczona za liczbę godzin korzystania z procesorów graficznych w chmurze, w przeciwieństwie do fizycznych, które kosztowałyby Cię dużo, nawet jeśli nie używasz ich zbyt wiele.

Czyści lokalne zasoby

Procesory GPU w chmurze nie zużywają zasobów lokalnych, w przeciwieństwie do fizycznych procesorów GPU, które zajmują znaczną ilość miejsca na komputerze. Nie wspominając o tym, że uruchamianie wielkoskalowego modelu ML lub renderowanie zadania spowalnia komputer.

W tym celu możesz rozważyć przeniesienie mocy obliczeniowej do chmury bez obciążania komputera i korzystanie z niego z łatwością. Po prostu użyj komputera do kontrolowania wszystkiego, zamiast wywierać na niego całą presję, aby poradzić sobie z obciążeniem pracą i zadaniami obliczeniowymi.

Oszczędza czas

Układy GPU w chmurze zapewniają projektantom elastyczność szybkiej iteracji przy krótszych czasach renderowania. Możesz zaoszczędzić dużo czasu, wykonując zadanie w kilka minut, które wcześniej zajmowało godziny lub dni. W związku z tym produktywność Twojego zespołu znacznie wzrośnie, dzięki czemu będziesz mógł inwestować czas w innowacje zamiast renderowania lub obliczeń.

Jak procesory graficzne pomagają w głębokim uczeniu i sztucznej inteligencji?

Głębokie uczenie to podstawa sztucznej inteligencji. Jest to zaawansowana technika uczenia maszynowego, która kładzie nacisk na uczenie reprezentacyjne za pomocą sztucznych sieci neuronowych (ANN). Model uczenia głębokiego służy do przetwarzania dużych zbiorów danych lub procesów o dużej mocy obliczeniowej.

Jak więc układy GPU pojawiają się na obrazie?

Procesory GPU są zaprojektowane do wykonywania obliczeń równoległych lub wielu obliczeń jednocześnie. Procesory GPU mogą wykorzystać możliwości modelu uczenia głębokiego do przyspieszenia dużych zadań obliczeniowych.

Ponieważ procesory graficzne mają wiele rdzeni, oferują doskonałe obliczenia przetwarzania równoległego. Ponadto mają większą przepustowość pamięci, aby pomieścić ogromne ilości danych dla systemów głębokiego uczenia. Dlatego są szeroko stosowane do trenowania modeli AI, renderowania modeli CAD, grania w bogate w grafikę gry wideo i nie tylko.

Co więcej, jeśli chcesz eksperymentować z wieloma algorytmami jednocześnie, możesz osobno uruchamiać wiele procesorów graficznych. Ułatwia różne procesy na oddzielnych procesorach graficznych bez równoległości. W tym celu można używać wielu procesorów GPU na różnych komputerach fizycznych lub w jednej maszynie do dystrybucji ciężkich modeli danych.

Jak zacząć korzystać z GPU w chmurze

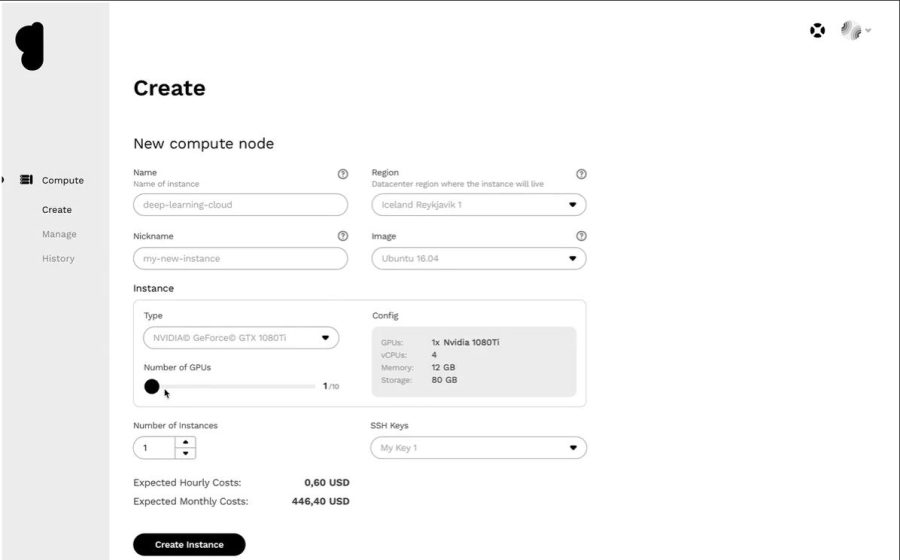

Rozpoczęcie pracy z procesorami graficznymi w chmurze nie jest nauką rakietową. W rzeczywistości wszystko jest łatwe i szybkie, jeśli potrafisz zrozumieć podstawy. Przede wszystkim musisz wybrać dostawcę GPU w chmurze, na przykład Google Cloud Platform (GCP).

Następnie zarejestruj się w GCP. Tutaj możesz skorzystać ze wszystkich standardowych korzyści, takich jak funkcje chmury, opcje przechowywania, zarządzanie bazami danych, integracja z aplikacjami i nie tylko. Możesz także użyć ich Google Colboratory, które działa jak Jupyter Notebook, aby korzystać z jednego GPU ZA DARMO. Na koniec możesz zacząć renderować procesory graficzne dla swojego przypadku użycia.

Przyjrzyjmy się więc różnym opcjom, jakie masz, aby procesory graficzne w chmurze obsługiwały sztuczną inteligencję i ogromne obciążenia.

linoda

linoda oferuje procesory graficzne na żądanie do zadań przetwarzania równoległego, takich jak przetwarzanie wideo, obliczenia naukowe, uczenie maszynowe, sztuczna inteligencja i inne. Zapewnia zoptymalizowane pod kątem GPU maszyny wirtualne akcelerowane przez rdzenie NVIDIA Quadro RTX 6000, Tensor i RT, a także wykorzystuje moc CUDA do wykonywania zadań ray tracingu, głębokiego uczenia i złożonego przetwarzania.

Przekształć swój wydatek kapitałowy w koszty operacyjne, korzystając z dostępu z procesora graficznego Linode, aby wykorzystać moc procesora graficznego i skorzystać z rzeczywistej propozycji wartości chmury. Ponadto Linode pozwala skoncentrować się na podstawowych kompetencjach zamiast martwić się o sprzęt.

Procesory graficzne Linode eliminują barierę w wykorzystywaniu ich w złożonych przypadkach użycia, takich jak strumieniowanie wideo, sztuczna inteligencja i uczenie maszynowe. Dodatkowo otrzymasz do 4 kart na każdą instancję, w zależności od mocy potrzebnej do przewidywanych obciążeń.

Quadro RTX 6000 ma 4608 rdzeni CUDA, 576 rdzeni Tensor, 72 rdzenie RT, 24 GB pamięci GPU GDDR6, 84T RTX-OPS, 10 Giga Rays/sec Rays Cast i wydajność FP32 na poziomie 16,3 TFLOPS.

Cena dedykowanego planu GPU z procesorem RTX6000 wynosi 1,5 USD za godzinę.

Rdzeń Paperspace

Usprawnij swoją organizację pracy dzięki infrastrukturze akcelerowanej obliczeniowej nowej generacji dzięki Rdzeń Paperspace. Oferuje łatwy w użyciu i prosty interfejs, który zapewnia proste narzędzia do dołączania, współpracy i aplikacje komputerowe dla komputerów Mac, Linux i Windows. Używaj go do uruchamiania wymagających aplikacji dzięki nieograniczonej mocy obliczeniowej.

CORE zapewnia błyskawiczną sieć, natychmiastowe przydzielanie zasobów, obsługę aplikacji 3D i pełny interfejs API do programowego dostępu. Uzyskaj pełny wgląd w swoją infrastrukturę dzięki łatwemu i intuicyjnemu GUI w jednym miejscu. Dodatkowo uzyskaj doskonałą kontrolę dzięki interfejsowi zarządzania CORE, który zawiera solidne narzędzia i umożliwia filtrowanie, sortowanie, łączenie lub tworzenie maszyn, sieci i użytkowników.

Potężna konsola zarządzania CORE szybko wykonuje zadania, takie jak dodawanie integracji z Active Directory lub VPN. Możesz także łatwo zarządzać złożonymi konfiguracjami sieci i szybciej wykonywać zadania za pomocą kilku kliknięć.

Ponadto znajdziesz wiele integracji, które są opcjonalne, ale pomocne w Twojej pracy. Zyskaj zaawansowane funkcje zabezpieczeń, dyski współdzielone i nie tylko dzięki tej platformie GPU w chmurze. Ciesz się tanimi procesorami graficznymi dzięki zniżkom edukacyjnym, alertom rozliczeniowym, naliczaniu sekund itd.

Dodaj prostotę i szybkość do przepływu pracy za cenę początkową 0,07 USD/godzinę.

Procesory graficzne Google Cloud

Uzyskaj wysokowydajne procesory GPU do obliczeń naukowych, wizualizacji 3D i uczenia maszynowego dzięki Procesory graficzne Google Cloud. Może pomóc przyspieszyć HPC, wybrać szeroką gamę procesorów graficznych, aby dopasować ceny i wydajność oraz zminimalizować obciążenie pracą dzięki dostosowywaniu maszyn i elastycznym cenom.

Oferują również wiele procesorów graficznych, takich jak NVIDIA K80, P4, V100, A100, T4 i P100. Ponadto procesory graficzne Google Cloud równoważą pamięć, procesor, dysk o wysokiej wydajności i do 8 procesorów graficznych w każdej instancji dla indywidualnego obciążenia.

Ponadto uzyskujesz dostęp do wiodącej w branży sieci, analizy danych i przechowywania. Urządzenia GPU są dostępne tylko w określonych strefach w niektórych regionach. Cena będzie zależeć od regionu, wybranego procesora graficznego i typu maszyny. Możesz obliczyć cenę, definiując swoje wymagania w Kalkulatorze cen Google Cloud.

Alternatywnie możesz wybrać te rozwiązania:

Elastyczna usługa GPU

Elastyczna usługa GPU (EGS) zapewnia równoległe i potężne możliwości obliczeniowe dzięki technologii GPU. Jest idealny do wielu scenariuszy, takich jak przetwarzanie wideo, wizualizacja, obliczenia naukowe i głębokie uczenie. EGS korzysta z kilku procesorów graficznych, takich jak NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 i AMD FirePro S7150.

Zyskasz korzyści, takie jak usługi wnioskowania i szkolenia głębokiego uczenia online, identyfikacja treści, rozpoznawanie obrazu i głosu, kodowanie multimediów HD, wideokonferencje, naprawa filmów źródłowych i 4K/8K HD na żywo.

Ponadto uzyskaj opcje, takie jak renderowanie wideo, finanse obliczeniowe, prognozowanie klimatu, symulacja kolizji, inżynieria genetyczna, edycja nieliniowa, aplikacje do nauczania na odległość i projektowanie inżynierskie.

- Instancja GA1 zapewnia do 4 procesorów graficznych AMD FirePro S7150, 160 GB pamięci i 56 procesorów wirtualnych. Zawiera 8192 rdzeni i 32 GB pamięci GPU, która działa równolegle i zapewnia 15 TFLOPS o pojedynczej precyzji i jeden TFLOPS o podwójnej precyzji.

- Instancja GN4 zapewnia do 2 procesorów graficznych NVIDIA Tesla M40, 96 GB pamięci i 56 procesorów wirtualnych. Zawiera 6000 rdzeni i 24 GB pamięci GPU, która zapewnia 14 TFLOPS pojedynczej precyzji. Podobnie znajdziesz wiele instancji, takich jak GN5, GN5i i GN6.

- EGS obsługuje wewnętrznie 25 Gbit/s i do 2 000 000 PPS przepustowości sieci, aby zapewnić maksymalną wydajność sieci wymaganą przez węzły obliczeniowe. Ma szybką lokalną pamięć podręczną, która jest dołączona do dysków SSD lub Ultra Cloud.

- Wysokowydajne dyski NVMe obsługują 230 000 IOPS z opóźnieniem we/wy 200 μs i zapewniają przepustowość odczytu 1900 Mb/s oraz przepustowość zapisu 1100 Mb/s.

Możesz wybierać spośród różnych opcji zakupu w zależności od potrzeb, aby zdobyć zasoby i płacić tylko za to.

Seria Azure N

Seria Azure N maszyn wirtualnych platformy Azure (VM) ma możliwości procesora GPU. Procesory GPU są idealne do obsługi obciążeń graficznych i wymagających dużej mocy obliczeniowej, pomagając użytkownikom wprowadzać innowacje w różnych scenariuszach, takich jak uczenie głębokie, analiza predykcyjna i zdalna wizualizacja.

Różne serie N mają oddzielne oferty dla określonych obciążeń.

- Seria NC skupia się na wysokowydajnym uczeniu maszynowym i obciążeniach obliczeniowych. Najnowsza wersja to NCsv3, która zawiera procesor graficzny NVIDIA NVIDIA Tesla V100.

- Seria ND skupia się na scenariuszach wnioskowania i szkolenia głównie dla głębokiego uczenia się. Wykorzystuje procesory graficzne NVIDIA Tesla P40. Najnowsza wersja to NDv2 z procesorami graficznymi NVIDIA Tesla V100.

- Seria NV koncentruje się na zdalnej wizualizacji i innych intensywnych obciążeniach aplikacji wspieranych przez procesor graficzny NVIDIA Tesla M60.

- Maszyny wirtualne NC, NCsv3, NDs i NCsv2 oferują połączenie InfiniBand, które umożliwia skalowanie wydajności. Tutaj uzyskasz korzyści, takie jak głębokie uczenie, renderowanie grafiki, edycja wideo, gry itp.

IBM Cloud

IBM Cloud oferuje elastyczność, moc i wiele opcji GPU. Ponieważ procesor graficzny to dodatkowa moc umysłowa, której brakuje procesorowi, IBM Cloud pomaga uzyskać bezpośredni dostęp do bardziej dostępnego wyboru serwera w celu bezproblemowej integracji z architekturą, aplikacjami i interfejsami API IBM Cloud wraz z rozproszoną siecią centrów danych na całym świecie.

- Otrzymasz opcje GPU dla serwerów typu bare metal, takie jak Intel Xeon 4210, karta graficzna NVIDIA T4, 20 rdzeni, 32 GB pamięci RAM, 2,20 GHz i przepustowość 20 TB. Podobnie otrzymujesz również opcje Intel Xeon 5218 i Intel Xeon 6248.

- W przypadku serwerów wirtualnych otrzymujesz AC1.8×60, który ma osiem vCPU, 60 GB RAM, 1 x GPU P100. Tutaj również otrzymasz opcje AC2.8×60 i AC2.8×60.

Kup bare metalowy procesor GPU w cenie początkowej 819 USD/miesiąc i wirtualny serwer GPU w cenie początkowej 1,95 USD/godz.

AWS i NVIDIA

AWS i NVIDIA współpracowali w celu ciągłego dostarczania opłacalnych, elastycznych i wydajnych rozwiązań opartych na procesorach graficznych. Obejmuje instancje Amazon EC2 z procesorami graficznymi NVIDIA i usługi, takie jak AWS IoT Greengrass, które są wdrażane z modułami NVIDIA Jetson Nano.

Użytkownicy używają AWS i NVIDIA do wirtualnych stacji roboczych, uczenia maszynowego (ML), usług IoT i obliczeń o wysokiej wydajności. Instancje Amazon EC2 zasilane przez procesory graficzne NVIDIA są odpowiedzialne za dostarczanie skalowalnej wydajności. Co więcej, użyj AWS IoT Greengrass, aby rozszerzyć usługi chmurowe AWS na urządzenia brzegowe oparte na NVIDIA.

Procesory graficzne NVIDIA A100 Tensor Core zasilają instancje Amazon EC2 P4d, zapewniając wiodącą w branży sieć o niskich opóźnieniach i wysoką przepustowość. Podobnie znajdziesz wiele innych instancji dla konkretnych scenariuszy, takich jak Amazon EC2 P3, Amazon EC2 G4 itp.

Złóż wniosek o BEZPŁATNĄ wersję próbną i poznaj moc GPU do urządzeń brzegowych z chmury.

OVHcloud

OVHcloud dostarcza serwery w chmurze zaprojektowane do przetwarzania ogromnych obciążeń równoległych. Procesory graficzne mają wiele instancji zintegrowanych z procesorami graficznymi NVIDIA Tesla V100, aby sprostać potrzebom uczenia głębokiego i uczenia maszynowego.

Pomagają przyspieszyć obliczenia w dziedzinie obliczeń graficznych, a także sztucznej inteligencji. OVH współpracuje z NVIDIA, aby zaoferować najlepszą akcelerowaną przez GPU platformę do obliczeń o wysokiej wydajności, sztucznej inteligencji i głębokiego uczenia.

Skorzystaj z najprostszego sposobu wdrażania i obsługi kontenerów akcelerowanych przez GPU za pośrednictwem pełnego katalogu. Dostarcza jedną z czterech kart do instancji bezpośrednio przez PCI Passthrough bez żadnej warstwy wirtualizacji, aby poświęcić wszystkie moce do użytku.

Usługi i infrastruktura OVHcloud posiadają certyfikaty ISO/IEC 27017, 27001, 27701 i 27018. Certyfikaty wskazują, że OVHcloud posiada system zarządzania bezpieczeństwem informacji (ISMS) do zarządzania podatnościami, wdrażania ciągłości działania, zarządzania ryzykiem i wdrażania systemu zarządzania informacjami o prywatności (PIMS).

Co więcej, NVIDIA Tesla V100 ma wiele cennych funkcji, takich jak PCIe 32 GB/s, 16 GB HBM2 pojemności, 900 GB/s przepustowości, podwójnej precyzji – 7 teraFLOPów, pojedynczej precyzji – 14 teraFLOPów i głębokiego uczenia – 112 teraFLOPów.

GPU z lambdą

Trenuj modele uczenia głębokiego, ML i AI za pomocą Chmura GPU Lambda i skalowanie z maszyny do łącznej liczby maszyn wirtualnych za pomocą kilku kliknięć. Uzyskaj wstępnie zainstalowane główne platformy i najnowszą wersję stosu lambda, która zawiera sterowniki CUDA i platformy uczenia głębokiego.

Uzyskaj szybki dostęp do dedykowanego środowiska programistycznego Jupyter Notebook dla każdej maszyny z pulpitu nawigacyjnego. Użyj SSH bezpośrednio za pomocą jednego z kluczy SSH lub połącz się przez terminal internetowy na pulpicie nawigacyjnym w chmurze, aby uzyskać bezpośredni dostęp.

Każda instancja obsługuje maksymalnie 10 Gb/s przepustowości między węzłami, co umożliwia rozproszone trenowanie za pomocą platform takich jak Horovod. Możesz także zaoszczędzić czas na optymalizacji modelu, skalując do liczby procesorów graficznych w jednej lub wielu instancjach.

Dzięki Lambda GPU Cloud możesz nawet zaoszczędzić 50% na obliczeniach, zmniejszyć całkowity koszt posiadania chmury i nigdy nie otrzymasz wieloletnich zobowiązań. Użyj pojedynczego procesora graficznego RTX 6000 z sześcioma VCPU, 46 GiB pamięci RAM, 658 GiB tymczasowej pamięci masowej za jedyne 1,25 USD za godzinę. Wybierz jedną z wielu instancji zgodnie z własnymi wymaganiami, aby uzyskać cenę na żądanie za swój użytek.

Chmura Genesis

Uzyskaj wydajną platformę GPU w chmurze w bardzo przystępnej cenie od Chmura Genesis. Mają dostęp do wielu wydajnych centrów danych na całym świecie, z którymi współpracują, aby zaoferować szeroką gamę aplikacji.

Wszystkie usługi są bezpieczne, skalowalne, niezawodne i zautomatyzowane. Genesis Cloud zapewnia nieograniczoną moc obliczeniową GPU do efektów wizualnych, uczenia maszynowego, transkodowania lub przechowywania, analizy Big Data i wielu innych.

Genesis Cloud oferuje wiele bogatych funkcji ZA DARMO, takich jak migawki do zapisywania pracy, grupy bezpieczeństwa dla ruchu sieciowego, woluminy pamięci masowej dla zestawów Big Data, FastAI, PyTorch, wstępnie skonfigurowane obrazy i publiczne API dla TensorFlow.

Ma różne typy procesorów graficznych NVIDIA i AMD. Co więcej, trenuj sieć neuronową lub generuj filmy animowane, wykorzystując moc obliczeniową GPU. Ich centra danych działają w 100% z energii odnawialnej ze źródeł geotermalnych, aby obniżyć emisje dwutlenku węgla.

Ich ceny są o 85% niższe niż w przypadku innych dostawców, ponieważ zapłacisz za przyrosty minutowe. Możesz również zaoszczędzić więcej dzięki długoterminowym i przewidywalnym zniżkom.

Wniosek 👩🏫

Procesory graficzne w chmurze zostały zaprojektowane tak, aby oferować niesamowitą wydajność, szybkość, skalowanie, przestrzeń i wygodę. Dlatego rozważ wybór preferowanej platformy GPU w chmurze z gotowymi funkcjami, aby przyspieszyć modele głębokiego uczenia się i łatwo obsługiwać obciążenia sztucznej inteligencji.