Szukasz narzędzi do poprawy rankingu SEO, ekspozycji i konwersji? Aby to zrobić, potrzebujesz narzędzia robota indeksującego. Robot indeksujący to program komputerowy, który skanuje Internet. Pająki internetowe, oprogramowanie do ekstrakcji danych z sieci i programy do skrobania witryn internetowych to przykłady technologii przeszukiwania sieci w Internecie. Nazywa się go również pająkiem lub pająkiem. Dzisiaj przyjrzymy się kilku darmowym narzędziom robotów internetowych do pobrania.

Spis treści:

25 najlepszych darmowych narzędzi dla robotów indeksujących

Narzędzia przeszukiwacza sieci WWW zapewniają bogactwo informacji do eksploracji i analizy danych. Jego głównym celem jest indeksowanie stron internetowych w Internecie. Może wykrywać uszkodzone linki, zduplikowane treści i brakujące tytuły stron oraz identyfikować poważne problemy z SEO. Pozyskiwanie danych online może przynieść Twojej firmie wiele korzyści.

- Kilka aplikacji robotów internetowych może poprawnie indeksować dane z dowolnego adresu URL witryny.

- Programy te pomagają w ulepszaniu struktury Twojej witryny, tak aby wyszukiwarki mogły ją zrozumieć i podnieść Twoje pozycje w rankingu.

Na liście naszych najlepszych narzędzi przygotowaliśmy listę narzędzi do pobrania za darmo, wraz z ich funkcjami i kosztami do wyboru. Na liście znajdują się również aplikacje płatne.

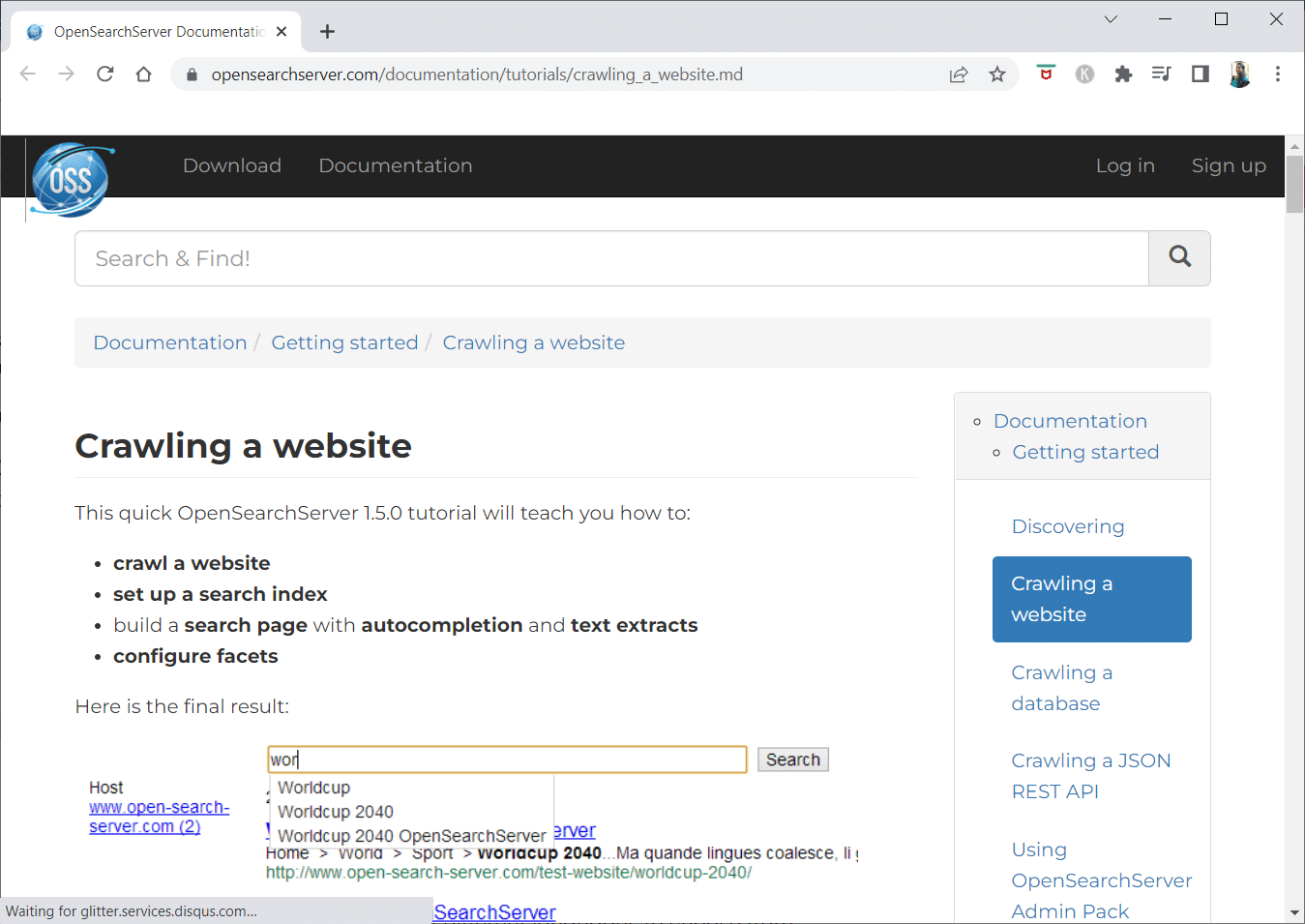

1. Otwórz serwer wyszukiwania

OpenSearchServer to darmowy robot sieciowy, który ma jedną z najwyższych ocen w Internecie. Jedna z najlepszych dostępnych alternatyw.

- Jest to całkowicie zintegrowane rozwiązanie.

- Open Search Server to przeszukiwanie sieci i wyszukiwarka, która jest bezpłatna i ma otwarte źródło.

- To kompleksowe i opłacalne rozwiązanie.

- Zawiera kompleksowy zestaw funkcji wyszukiwania i możliwość skonstruowania własnej strategii indeksowania.

- Roboty indeksujące mogą indeksować praktycznie wszystko.

- Do wyboru są wyszukiwania pełnotekstowe, logiczne i fonetyczne.

- Możesz wybrać z 17 różnych języków.

- Dokonywane są automatyczne klasyfikacje.

- Możesz stworzyć harmonogram dla rzeczy, które często się zdarzają.

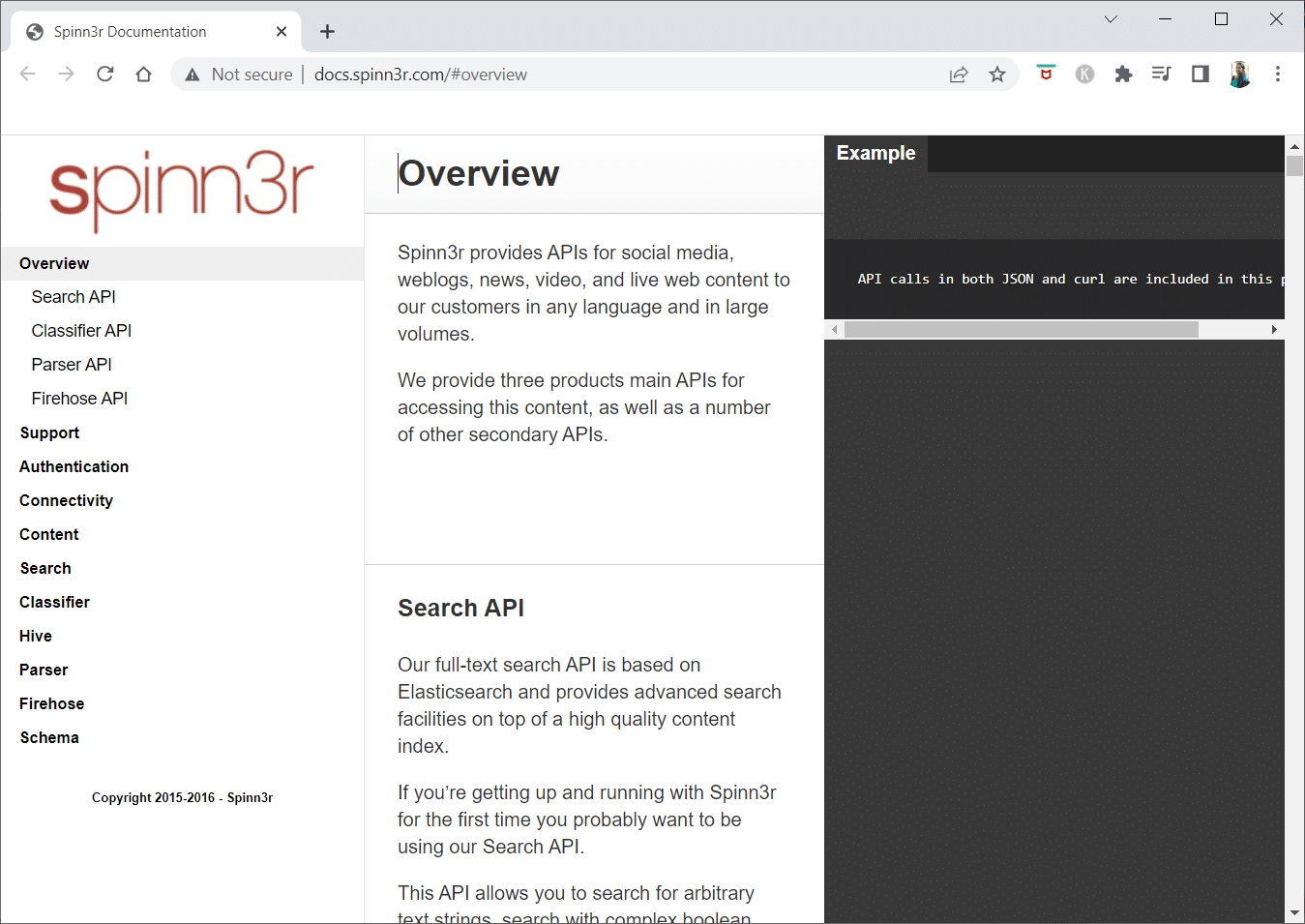

2. Spinn3r

Program robota indeksującego Spinn3r umożliwia pełne wyodrębnienie treści z blogów, wiadomości, serwisów społecznościowych, kanałów RSS i kanałów ATOM.

- Jest wyposażony w błyskawicznie szybki interfejs API, który obsługuje 95% pracy indeksowania.

- Zaawansowana ochrona przed spamem jest zawarta w tej aplikacji do indeksowania stron internetowych, która usuwa spam i nieodpowiednie użycie języka, poprawiając bezpieczeństwo danych.

- Web scraper nieustannie przeszukuje sieć w poszukiwaniu aktualizacji z wielu źródeł, aby prezentować treści w czasie rzeczywistym.

- Indeksuje zawartość w taki sam sposób, jak robi to Google, a wyodrębnione dane są zapisywane jako pliki JSON.

- Parser API umożliwia szybkie analizowanie i zarządzanie informacjami dla dowolnych adresów internetowych.

- Firehose API jest przeznaczony do masowego dostępu do ogromnych ilości danych.

-

Proste nagłówki HTTP służą do uwierzytelniania wszystkich interfejsów API Spinn3r.

- Jest to narzędzie dla robota indeksującego do pobrania za darmo.

- Classifier API umożliwia programistom przesyłanie tekstu (lub adresów URL), które mają być oznaczane etykietami przez naszą technologię uczenia maszynowego.

3. Importuj.io

Import.io pozwala w ciągu kilku minut przeszukiwać miliony stron internetowych i konstruować ponad 1000 interfejsów API w oparciu o Twoje potrzeby bez pisania ani jednej linii kodu.

- Może teraz działać programowo, a dane mogą być teraz pobierane automatycznie.

- Wyodrębnij dane z wielu stron jednym pociągnięciem przycisku.

- Może automatycznie rozpoznawać listy podzielone na strony lub możesz kliknąć następną stronę.

- Za pomocą kilku kliknięć możesz włączyć dane online do swojej aplikacji lub witryny internetowej.

- Utwórz wszystkie potrzebne adresy URL w kilka sekund, stosując wzorce, takie jak numery stron i nazwy kategorii.

- Import.io ułatwia zademonstrowanie, jak pobrać dane ze strony. Po prostu wybierz kolumnę ze swojego zbioru danych i wskaż coś na stronie, które przyciągnie Twoją uwagę.

- Możesz otrzymać wycenę na ich stronie internetowej.

- Linki na stronach z listami prowadzą do szczegółowych stron z dalszymi informacjami.

- Możesz użyć Import.io, aby do nich dołączyć, aby jednocześnie uzyskać wszystkie dane ze stron szczegółowych.

4. BUBING

BUbiNG, narzędzie do przeszukiwania sieci WWW nowej generacji, jest zwieńczeniem doświadczeń autorów z UbiCrawlerem i dziesięciu lat badań nad tym tematem.

- Jeden agent może przeszukiwać tysiące stron na sekundę, zachowując przy tym ścisłe standardy uprzejmości, zarówno w oparciu o hosta, jak io adres IP.

- Jego dystrybucja zadań opiera się na współczesnych, szybkich protokołach, aby zapewnić bardzo wysoką przepustowość, w przeciwieństwie do wcześniejszych rozproszonych przeszukiwaczy typu open source, które opierają się na technikach wsadowych.

- Wykorzystuje odcisk palca usuniętej strony do wykrywania prawie duplikatów.

- BUbiNG to całkowicie rozproszony crawler Java typu open source.

- Ma wiele paralelizmów.

- Wiele osób korzysta z tego produktu.

- To szybkie.

- Umożliwia indeksowanie na dużą skalę.

5. GNU Wget

GNU Wget to bezpłatne narzędzie do przeszukiwania sieci WWW, które można pobrać bezpłatnie i jest to oprogramowanie o otwartym kodzie źródłowym napisane w C, które umożliwia pobieranie plików przez HTTP, HTTPS, FTP i FTPS.

- Jednym z najbardziej charakterystycznych aspektów tej aplikacji jest możliwość tworzenia plików wiadomości opartych na NLS w różnych językach.

- Możesz ponownie uruchomić pobieranie, które zostało zatrzymane, używając REST i RANGE.

- W razie potrzeby może również przekształcić łącza bezwzględne w pobranych dokumentach na łącza względne.

- Rekursywnie używaj symboli wieloznacznych w nazwach plików i katalogach lustrzanych.

- Pliki wiadomości oparte na NLS dla różnych języków.

- Podczas tworzenia kopii lustrzanej lokalne sygnatury czasowe plików są oceniane w celu określenia, czy dokumenty wymagają ponownego pobrania.

6. Wąż.io

Webhose.io to fantastyczna aplikacja do przeszukiwania sieci, która umożliwia skanowanie danych i wyodrębnianie słów kluczowych w kilku językach przy użyciu różnych filtrów, które obejmują szeroki zakres źródeł.

- Archiwum umożliwia również przeglądanie poprzednich danych.

- Ponadto funkcja wyszukiwania danych indeksowania przez webhose.io jest dostępna w maksymalnie 80 językach.

- Wszystkie dane osobowe, które zostały naruszone, można znaleźć w jednym miejscu.

- Zbadaj darknet i aplikacje do przesyłania wiadomości pod kątem cyberzagrożeń.

-

Formaty XML, JSON i RSS są również dostępne dla zeskrobanych danych.

- Możesz otrzymać wycenę na ich stronie internetowej.

- Użytkownicy mogą po prostu indeksować i przeszukiwać uporządkowane dane na Webhose.io.

- We wszystkich językach może monitorować i analizować media.

- Możliwe jest śledzenie dyskusji na forach i forach dyskusyjnych.

- Pozwala śledzić kluczowe posty na blogu z całej sieci.

7. Norconex

Norconex to doskonałe źródło informacji dla firm poszukujących aplikacji typu open source dla robotów indeksujących.

- Ten w pełni funkcjonalny kolektor może być używany lub zintegrowany z Twoim programem.

- Może również zająć polecany obraz strony.

- Norconex daje możliwość indeksowania zawartości dowolnej witryny.

- Możliwe jest wykorzystanie dowolnego systemu operacyjnego.

- To oprogramowanie robota indeksującego może indeksować miliony stron na jednym serwerze o średniej wydajności.

- Zawiera również zestaw narzędzi do modyfikacji treści i metadanych.

- Uzyskaj metadane dla dokumentów, nad którymi aktualnie pracujesz.

-

Obsługiwane są strony renderowane w języku JavaScript.

- Umożliwia wykrywanie kilku języków.

- Umożliwia pomoc w tłumaczeniu.

- Szybkość indeksowania może ulec zmianie.

- Dokumenty, które zostały zmodyfikowane lub usunięte, są identyfikowane.

- Jest to całkowicie darmowy program dla robotów internetowych.

8. Dexi.io

Dexi.io to działająca w przeglądarce aplikacja robota indeksującego, która umożliwia zbieranie informacji z dowolnej witryny internetowej.

-

Ekstraktory, gąsienice i rury to trzy rodzaje robotów, których możesz użyć do zgarniania.

- Rozwój rynku jest prognozowany za pomocą raportów Delta.

- Twoje zebrane dane będą przechowywane przez dwa tygodnie na serwerach Dexi.io przed archiwizacją lub możesz natychmiast wyeksportować wyodrębnione dane jako pliki JSON lub CSV.

- Możesz otrzymać wycenę na ich stronie internetowej.

- Oferowane są profesjonalne usługi, takie jak zapewnienie jakości i bieżąca konserwacja.

- Oferuje usługi komercyjne, które pomogą Ci spełnić Twoje potrzeby w zakresie danych w czasie rzeczywistym.

- Możliwe jest śledzenie zapasów i cen dla nieograniczonej liczby SKU/produktów.

- Pozwala na integrację danych za pomocą pulpitów nawigacyjnych na żywo i pełnej analityki produktu.

- Pomaga przygotować i wypłukać uporządkowane i gotowe do użycia dane produktów dostępne w Internecie.

9. Zyte

Zyte to oparte na chmurze narzędzie do ekstrakcji danych, które pomaga dziesiątkom tysięcy programistów w zlokalizowaniu kluczowych informacji. Jest to również jedna z najlepszych darmowych aplikacji dla robotów internetowych.

- Użytkownicy mogą zeskrobać strony internetowe za pomocą aplikacji do wizualnego skrobania o otwartym kodzie źródłowym, nie znając żadnego kodowania.

-

Crawlera, złożony rotator proxy używany przez Zyte, umożliwia użytkownikom łatwe indeksowanie dużych lub chronionych przez boty witryn, unikając przy tym środków zaradczych botów.

- Twoje informacje online są dostarczane zgodnie z harmonogramem i konsekwentnie. Dzięki temu zamiast zarządzać proxy, możesz skupić się na pozyskiwaniu danych.

- Ze względu na możliwości i renderowanie inteligentnych przeglądarek, antybotami atakującymi warstwę przeglądarki można teraz łatwo zarządzać.

- Na ich stronie internetowej możesz otrzymać wycenę.

- Użytkownicy mogą indeksować z wielu adresów IP i regionów za pomocą prostego interfejsu API HTTP, eliminując potrzebę konserwacji serwera proxy.

- Pomaga generować gotówkę, jednocześnie oszczędzając czas, pozyskując potrzebne informacje.

- Umożliwia wyodrębnianie danych internetowych na dużą skalę, oszczędzając czas na kodowanie i konserwację pająków.

10. Apache Nutch

Apache Nutch jest bezsprzecznie na szczycie listy najlepszych aplikacji typu open source dla robotów indeksujących.

- Może pracować na jednej maszynie. Jednak działa najlepiej w klastrze Hadoop.

- Do uwierzytelniania wykorzystywany jest protokół NTLM.

- Ma rozproszony system plików (poprzez Hadoop).

- Jest to dobrze znany projekt oprogramowania do ekstrakcji danych online typu open source, który można dostosować i skalować do eksploracji danych.

- Używa go wielu analityków danych, naukowców, twórców aplikacji i specjalistów od eksploracji tekstów internetowych na całym świecie.

- Jest to wieloplatformowe rozwiązanie oparte na Javie.

- Domyślnie pobieranie i analizowanie są wykonywane niezależnie.

- Dane są mapowane przy użyciu XPath i przestrzeni nazw.

- Zawiera bazę danych wykresów linków.

11. Wizualny skrobak

VisualScraper to kolejny fantastyczny, niekodujący web scraper do wydobywania danych z Internetu.

- Oferuje prosty interfejs użytkownika typu „wskaż i kliknij”.

- Oferuje również usługi scrapingu online, takie jak rozpowszechnianie danych i budowanie ekstraktorów oprogramowania.

- Monitoruje również twoją konkurencję.

- Użytkownicy mogą planować uruchamianie swoich projektów o określonej godzinie lub powtarzać sekwencję co minutę, dzień, tydzień, miesiąc i rok za pomocą Visual Scraper.

- Jest tańszy i bardziej skuteczny.

- Nie ma nawet kodu do mówienia.

- Jest to całkowicie darmowy program dla robotów internetowych.

- Dane w czasie rzeczywistym mogą być pobierane z kilku stron internetowych i zapisywane jako pliki CSV, XML, JSON lub SQL.

- Użytkownicy mogą go używać do regularnego pobierania wiadomości, aktualizacji i postów na forum.

- Dane są w 100% dokładne i dostosowane.

12. WebSfinks

WebSphinx to fantastyczna osobista darmowa aplikacja do przeszukiwania sieci, która jest prosta w konfiguracji i obsłudze.

- Jest przeznaczony dla zaawansowanych użytkowników sieci i programistów Java, którzy chcą automatycznie skanować ograniczoną część Internetu.

- To rozwiązanie do ekstrakcji danych online obejmuje bibliotekę klas Java i interaktywne środowisko programistyczne.

- Strony można łączyć w jeden dokument, który można przeglądać lub drukować.

-

Wyodrębnij cały tekst pasujący do danego wzorca z sekwencji stron.

- Dzięki temu pakietowi roboty sieciowe mogą być teraz napisane w Javie.

- Crawler Workbench i biblioteka klas WebSPHINX są zawarte w WebSphinx.

- Crawler Workbench to graficzny interfejs użytkownika, który umożliwia dostosowanie i obsługę robota indeksującego.

- Wykres można wykonać z grupy stron internetowych.

- Zapisuj strony na dysku lokalnym do czytania w trybie offline.

13. Centrum OutWit

Platforma OutWit Hub składa się z jądra z obszerną biblioteką możliwości rozpoznawania i ekstrakcji danych, na której można tworzyć nieskończoną liczbę różnych aplikacji, z których każda wykorzystuje funkcje jądra.

- Ta aplikacja przeszukiwacza sieci może skanować witryny i przechowywać wykryte dane w przystępny sposób.

- To wielofunkcyjny kombajn z jak największą liczbą funkcji, aby sprostać różnym wymaganiom.

- Hub istnieje od dłuższego czasu.

- Stało się użyteczną i różnorodną platformą dla nietechnicznych użytkowników i specjalistów IT, którzy wiedzą, jak kodować, ale wiedzą, że PHP nie zawsze jest idealną opcją do wyodrębniania danych.

- OutWit Hub zapewnia pojedynczy interfejs do zgarniania niewielkich lub ogromnych ilości danych w zależności od potrzeb.

- Umożliwia zbieranie dowolnej strony internetowej bezpośrednio z przeglądarki i konstruowanie automatycznych agentów, które pobierają dane i przygotowują je zgodnie z Twoimi wymaganiami.

- Możesz otrzymać wycenę na ich stronie internetowej.

14. Złośliwy

Scrapy to framework do scrapingu online w Pythonie do tworzenia skalowalnych robotów indeksujących.

- Jest to kompletna platforma do przeszukiwania sieci WWW, która obsługuje wszystkie cechy utrudniające tworzenie robotów indeksujących, takie jak oprogramowanie pośredniczące proxy i pytania dotyczące zapytań.

- Możesz napisać zasady wyodrębniania danych, a następnie pozwolić Scrapy zająć się resztą.

- Łatwo jest dodawać nowe funkcje bez modyfikowania rdzenia, ponieważ został on zaprojektowany w ten sposób.

- Jest to program oparty na Pythonie, który działa na systemach Linux, Windows, Mac OS X i BSD.

- Jest to całkowicie darmowe narzędzie.

- Jego biblioteka zapewnia programistom gotową do użycia strukturę do dostosowywania robota sieciowego i wydobywania danych z sieci na ogromną skalę.

15. Mozenda

Mozenda to także najlepsza darmowa aplikacja dla robotów internetowych. Jest to zorientowany na biznes, oparty na chmurze, samoobsługowy program do scrapingu sieci Web. Mozenda ma ponad 7 miliardów zeskrobanych stron i ma klientów korporacyjnych na całym świecie.

- Technologia web scrapingu firmy Mozenda eliminuje konieczność stosowania skryptów i zatrudniania inżynierów.

- Przyspiesza zbieranie danych pięciokrotnie.

- Możesz zeskrobać tekst, pliki, obrazy i informacje PDF ze stron internetowych za pomocą funkcji „wskaż i kliknij” Mozenda.

- Organizując pliki danych możesz przygotować je do publikacji.

- Możesz eksportować bezpośrednio do TSV, CSV, XML, XLSX lub JSON za pomocą API Mozedy.

- Możesz użyć zaawansowanej technologii Data Wrangling firmy Mozenda, aby uporządkować swoje informacje, aby móc podejmować ważne decyzje.

- Możesz użyć jednej z platform partnerów Mozendy do integracji danych lub ustanowienia niestandardowych integracji danych na kilku platformach.

16. Kopia internetowa Cyotek

Cyotek Webcopy to darmowe narzędzie do przeszukiwania sieci WWW, które umożliwia automatyczne pobieranie zawartości witryny na urządzenie lokalne.

- Zawartość wybranej strony zostanie zeskanowana i pobrana.

- Możesz wybrać, które części witryny chcesz sklonować i jak wykorzystać jej złożoną strukturę.

- Nowa trasa lokalna będzie przekierowywać linki do zasobów witryny, takich jak arkusze stylów, zdjęcia i inne strony.

- Przyjrzy się znacznikom HTML witryny i spróbuje znaleźć wszelkie połączone zasoby, takie jak inne witryny, zdjęcia, filmy, pliki do pobrania i tak dalej.

- Może indeksować witrynę i pobierać wszystko, co widzi, aby utworzyć akceptowalną kopię oryginału.

17. Wspólne indeksowanie

Common Crawl był przeznaczony dla wszystkich zainteresowanych badaniem i analizowaniem danych w celu uzyskania przydatnych informacji.

- Jest to organizacja non-profit 501(c)(3), która polega na darowiznach, aby prawidłowo prowadzić swoją działalność.

- Każdy, kto chce korzystać ze wspólnego indeksowania, może to zrobić bez wydawania pieniędzy i powodowania problemów.

- Common Crawl to korpus, który można wykorzystać do nauczania, badań i analiz.

- Powinieneś przeczytać artykuły, jeśli nie masz żadnych umiejętności technicznych, aby dowiedzieć się o niezwykłych odkryciach dokonanych przez innych przy użyciu danych Common Crawl.

- Nauczyciele mogą używać tych narzędzi do nauczania analizy danych.

18. Semrush

Semrush to aplikacja do robota indeksującego witryny, która analizuje strony i strukturę witryny pod kątem technicznych problemów z SEO. Rozwiązanie tych problemów może pomóc ulepszyć wyniki wyszukiwania.

- Posiada narzędzia do SEO, badań rynku, marketingu w mediach społecznościowych i reklamy.

- Posiada przyjazny dla użytkownika interfejs użytkownika.

-

Metadane, HTTP/HTTPS, dyrektywy, kody stanu, duplikaty treści, szybkość odpowiedzi strony, wewnętrzne linki, rozmiary obrazów, dane strukturalne i inne elementy zostaną zbadane.

- Pozwala szybko i prosto przeprowadzić audyt witryny.

- Pomaga w analizie plików dziennika.

- Ten program zapewnia pulpit nawigacyjny, który umożliwia łatwe przeglądanie problemów z witryną.

19. Sitechecker.pro

Sitechecker.pro to kolejna najlepsza darmowa aplikacja dla robotów indeksujących. Jest to narzędzie do sprawdzania SEO dla stron internetowych, które pomaga poprawić rankingi SEO.

- Możesz łatwo zwizualizować strukturę strony internetowej.

- Tworzy na stronie raport z audytu SEO, który klienci mogą otrzymać za pośrednictwem poczty elektronicznej.

- Ten robot indeksujący może przeglądać wewnętrzne i zewnętrzne linki Twojej witryny.

- Pomaga w określeniu szybkości witryny.

- Możesz również użyć Sitechecker.pro, aby sprawdzić problemy z indeksowaniem na stronach docelowych.

- Pomaga bronić się przed atakami hakerów.

20. Webharvy

Webharvy to narzędzie do skrobania sieci z prostym interfejsem typu „wskaż i kliknij”. Jest przeznaczony dla tych, którzy nie potrafią kodować.

- Koszt licencji zaczyna się od 139 USD.

- Będziesz korzystać z wbudowanej przeglądarki WebHarvy do ładowania witryn internetowych i wybierania danych do przeszukania za pomocą kliknięć myszą.

- Może automatycznie zeskrobać tekst, zdjęcia, adresy URL i e-maile ze stron internetowych i zapisywać je w różnych formatach.

-

Serwery proxy lub VPN mogą być używane do uzyskiwania dostępu do docelowych stron internetowych.

- Zeskrobywanie danych nie wymaga tworzenia żadnego oprogramowania ani aplikacji.

- Możesz zeskrobać anonimowo i zapobiec blokowaniu oprogramowania do scrapingu przez serwery internetowe za pomocą serwerów proxy lub sieci VPN w celu uzyskania dostępu do docelowych stron internetowych.

- WebHarvy automatycznie identyfikuje wzorce danych na stronach internetowych.

- Jeśli chcesz zeskrobać listę obiektów ze strony internetowej, nie musisz robić nic więcej.

21. Pająk NetSpeak

NetSpeak Spider to aplikacja typu web crawler na komputery stacjonarne do codziennych audytów SEO, szybkiego identyfikowania problemów, przeprowadzania systematycznych analiz i skrobania stron internetowych.

- Ta aplikacja do indeksowania stron internetowych doskonale sprawdza się w ocenie dużych stron internetowych, jednocześnie minimalizując użycie pamięci RAM.

- Pliki CSV można łatwo importować i eksportować z danych indeksowania sieci.

- Wystarczy kilka kliknięć, aby zidentyfikować te i setki innych poważnych problemów związanych z SEO.

- Narzędzie pomoże Ci ocenić optymalizację witryny na stronie, w tym między innymi kod stanu, instrukcje przeszukiwania i indeksowania, strukturę witryny i przekierowania.

- Dane z Google Analytics i Yandex mogą być eksportowane.

- Uwzględnij zakres danych, rodzaj urządzenia i segmentację dla stron witryny, ruchu, konwersji, celów, a nawet ustawień e-commerce.

- Jego miesięczne subskrypcje zaczynają się od 21 USD.

-

Uszkodzone linki i zdjęcia zostaną wykryte przez robota SEO, podobnie jak zduplikowane materiały, takie jak strony, teksty, zduplikowane tagi tytułu i metaopisu oraz H1.

22. UiPath

UiPath to internetowe narzędzie do zgarniania robotów internetowych, które pozwala zautomatyzować procedury robotyczne. Automatyzuje indeksowanie danych online i na komputerze w przypadku większości programów innych firm.

- Możesz zainstalować aplikację do automatyzacji procesów robotycznych w systemie Windows.

- Potrafi wyodrębniać dane w formie tabelarycznej i opartej na wzorcach z wielu stron internetowych.

- UiPath może przeprowadzać dodatkowe indeksowania od razu po wyjęciu z pudełka.

- Raportowanie śledzi Twoje roboty, dzięki czemu możesz w każdej chwili zapoznać się z dokumentacją.

- Twoje wyniki będą bardziej wydajne i pomyślne, jeśli ujednolicisz swoje praktyki.

-

Miesięczne subskrypcje zaczynają się od 420 USD.

- Ponad 200 gotowych komponentów Marketplace zapewnia Twojemu zespołowi więcej czasu w krótszym czasie.

- Roboty UiPath zwiększają zgodność, stosując dokładną metodę, która spełnia Twoje potrzeby.

- Firmy mogą osiągnąć szybką transformację cyfrową przy niższych kosztach poprzez optymalizację procesów, rozpoznanie ekonomii i oferowanie spostrzeżeń.

23. Zgarniacz helu

Helium Scraper to wizualna aplikacja do przeszukiwania sieci danych online, która działa najlepiej, gdy istnieje niewielki związek między elementami. Na podstawowym poziomie może spełnić wymagania użytkowników dotyczące indeksowania.

- Nie wymaga żadnego kodowania ani konfiguracji.

- Przejrzysty i łatwy w obsłudze interfejs użytkownika umożliwia wybieranie i dodawanie działań z określonej listy.

- Dostępne są również szablony online dla specjalnych wymagań indeksowania.

- Poza ekranem używanych jest kilka przeglądarek internetowych Chromium.

- Zwiększ liczbę równoczesnych przeglądarek, aby uzyskać jak najwięcej danych.

- Zdefiniuj własne działania lub wykorzystaj niestandardowy JavaScript w przypadku bardziej złożonych instancji.

- Może być zainstalowany na komputerze osobistym lub dedykowanym serwerze Windows.

- Jego licencje zaczynają się od 99 USD i stamtąd rosną.

24. 80Nogi

W 2009 roku powstało 80Legs, aby zwiększyć dostępność danych online. Jest to kolejne z najlepszych darmowych narzędzi dla robotów internetowych. Początkowo firma koncentrowała się na świadczeniu usług indeksowania sieci dla różnych klientów.

- Nasza rozbudowana aplikacja dla robotów indeksujących dostarczy Ci spersonalizowanych informacji.

- Szybkość indeksowania jest automatycznie dostosowywana na podstawie ruchu w witrynie.

- Możesz pobrać wyniki do swojego lokalnego środowiska lub komputera za pośrednictwem 80legs.

- Wystarczy podać adres URL, aby zaindeksować witrynę.

- Jego miesięczne subskrypcje zaczynają się od 29 USD miesięcznie.

- Dzięki SaaS możliwe jest konstruowanie i przeprowadzanie indeksowania sieci.

- Posiada wiele serwerów, które umożliwiają przeglądanie witryny z różnych adresów IP.

- Uzyskaj natychmiastowy dostęp do danych witryny zamiast przeszukiwać sieć.

- Ułatwia tworzenie i wykonywanie niestandardowych indeksów sieci.

- Możesz używać tej aplikacji do śledzenia trendów online.

- Możesz tworzyć własne szablony, jeśli chcesz.

25. ParseHub

ParseHub to doskonała aplikacja dla robotów indeksujących, która może zbierać informacje ze stron internetowych korzystających z technologii AJAX, JavaScript, plików cookie i innych powiązanych technologii.

- Jego silnik uczenia maszynowego może odczytywać, oceniać i konwertować treści online na znaczące dane.

- Możesz również skorzystać z wbudowanej aplikacji internetowej w swojej przeglądarce.

- Pozyskiwanie informacji z milionów stron internetowych jest możliwe.

- ParseHub automatycznie przeszuka tysiące linków i słów.

- Dane są gromadzone i przechowywane automatycznie na naszych serwerach.

-

Pakiety miesięczne zaczynają się od 149 USD.

- Jako shareware możesz zbudować tylko pięć publicznych projektów na ParseHub.

- Możesz go używać do uzyskiwania dostępu do rozwijanych menu, logowania się na stronach internetowych, klikania map i zarządzania stronami internetowymi za pomocą nieskończonego przewijania, kart i wyskakujących okienek.

- Klient stacjonarny ParseHub jest dostępny dla systemów Windows, Mac OS X i Linux.

- Możesz pozyskać zeskrobane dane w dowolnym formacie do analizy.

- Możesz założyć co najmniej 20 prywatnych projektów scrapingu z poziomami członkostwa premium.

***

Mamy nadzieję, że ten artykuł był pomocny i wybrałeś swoje ulubione darmowe narzędzie do indeksowania sieci. Podziel się swoimi przemyśleniami, pytaniami i sugestiami w sekcji komentarzy poniżej. Możesz również zasugerować nam brakujące narzędzia. Daj nam znać, czego chcesz się nauczyć dalej.