Poszukujesz narzędzi, które pomogą Ci poprawić pozycjonowanie SEO, zwiększyć widoczność oraz konwersję? Kluczowym elementem w tym procesie jest zastosowanie narzędzia robota indeksującego. Robot indeksujący to program, który skanuje zasoby Internetu. Przykłady takich narzędzi to pająki internetowe, oprogramowanie do ekstrakcji danych oraz aplikacje do skrobania stron. Dzisiaj zaprezentujemy kilka darmowych narzędzi do przeszukiwania sieci, które możesz pobrać.

25 Najlepszych Darmowych Narzędzi dla Robotów Indeksujących

Narzędzia te oferują ogromne możliwości w zakresie eksploracji i analizy danych. Głównym celem robotów indeksujących jest porządkowanie stron internetowych, co pozwala na identyfikację problemów takich jak uszkodzone linki, zduplikowane treści czy brakujące tytuły stron. Zbieranie danych z Internetu może przynieść Twojej firmie wiele korzyści.

- Wiele z tych aplikacji potrafi skutecznie indeksować dane z dowolnego adresu URL.

- Programy te pomagają w poprawie struktury witryny, co ułatwia wyszukiwarkom zrozumienie jej zawartości i zwiększa szansę na wyższe pozycje w wynikach wyszukiwania.

W naszym zestawieniu znajdziesz listę darmowych narzędzi do pobrania, wraz z ich funkcjonalnościami oraz informacjami o kosztach. Na liście uwzględnione zostały również płatne opcje.

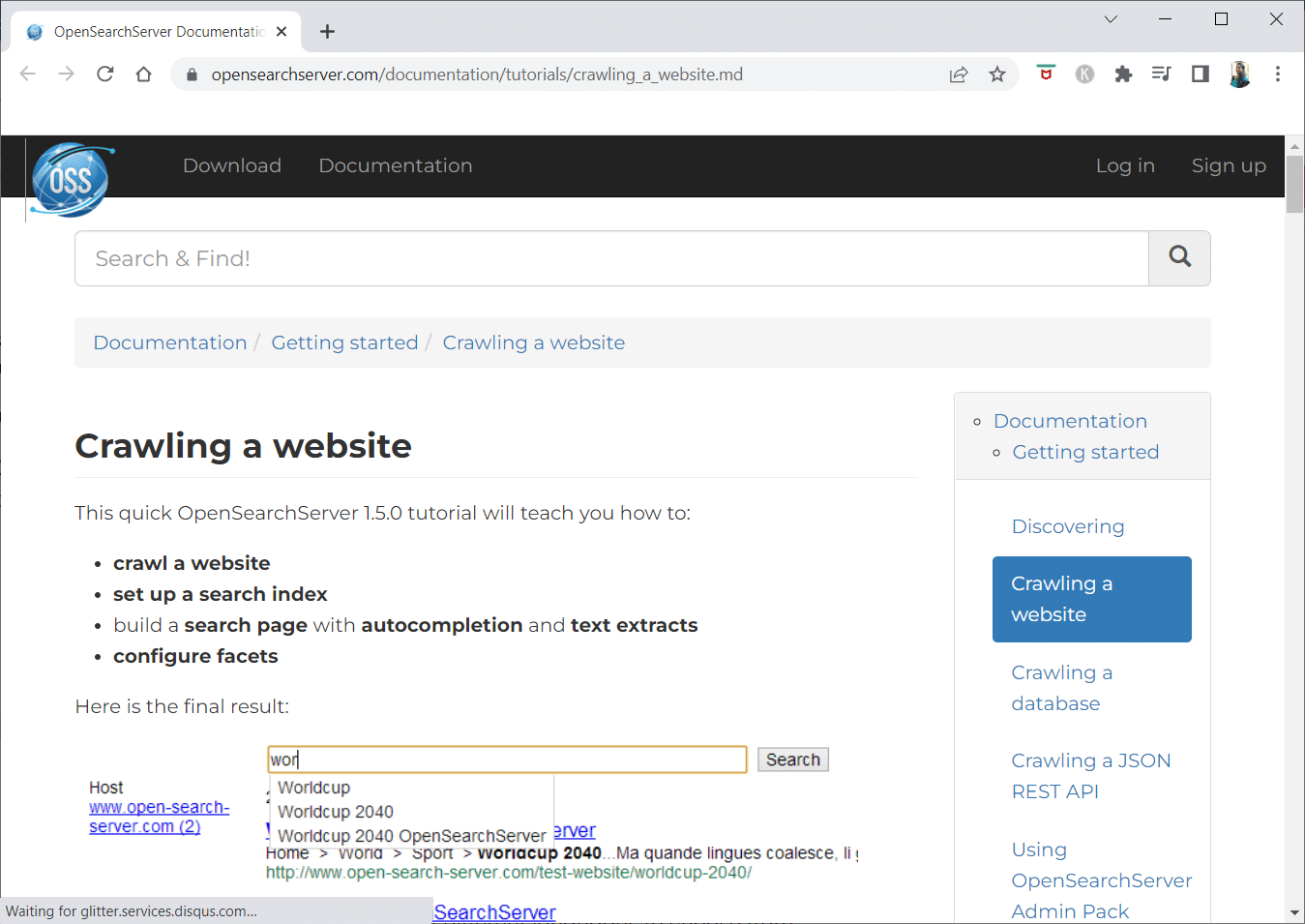

1. OpenSearchServer

OpenSearchServer to bezpłatne narzędzie do przeszukiwania sieci, które cieszy się wysoką oceną wśród użytkowników. Jest to jedna z najlepszych dostępnych opcji.

- To w pełni zintegrowane rozwiązanie.

- Oferuje funkcje przeszukiwania z otwartym źródłem.

- Stanowi kompleksowe i efektywne kosztowo rozwiązanie.

- Wyposażone jest w bogaty zestaw funkcji oraz możliwość opracowania własnej strategii indeksowania.

- Roboty indeksujące są w stanie indeksować niemal wszystko.

- Można wybierać spośród wyszukiwań pełnotekstowych, logicznych oraz fonetycznych.

- Obsługuje 17 różnych języków.

- Umożliwia automatyczną klasyfikację danych.

- Można ustawić harmonogram dla regularnych zadań.

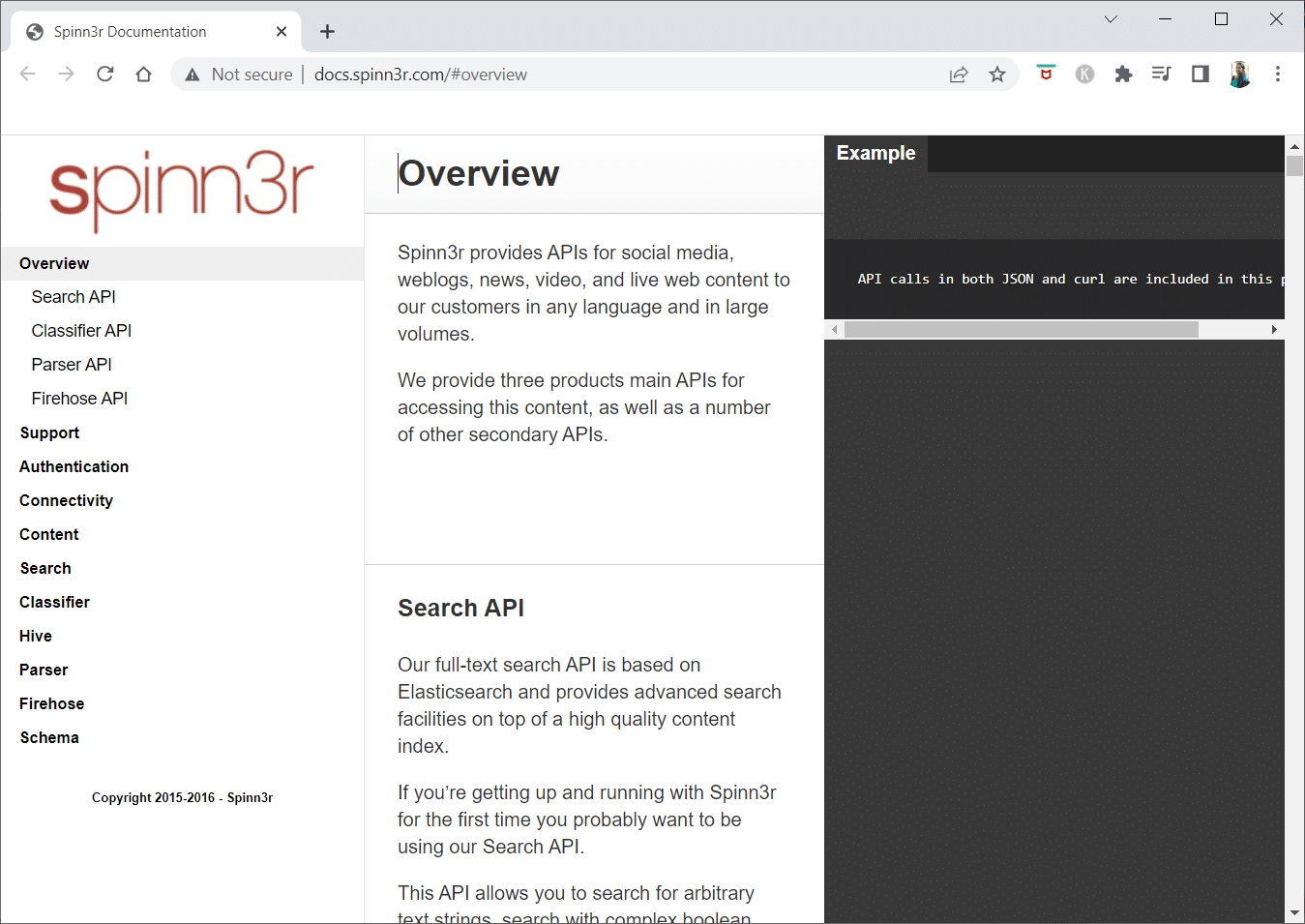

2. Spinn3r

Spinn3r to robot indeksujący, który umożliwia pełne wyodrębnienie treści z blogów, serwisów informacyjnych, portali społecznościowych, kanałów RSS oraz ATOM.

- Dysponuje niezwykle szybkim interfejsem API, który obsługuje 95% zadań związanych z indeksowaniem.

- Oprogramowanie zawiera zaawansowane mechanizmy ochrony przed spamem, co zwiększa bezpieczeństwo danych.

- Web scraper cały czas przeszukuje sieć w poszukiwaniu aktualizacji z różnych źródeł i wyświetla treści w czasie rzeczywistym.

- Indeksuje dane w sposób podobny do Google, a zebrane informacje są zapisywane w formie plików JSON.

- Parser API umożliwia błyskawiczną analizę i zarządzanie informacjami z różnych adresów URL.

- Firehose API pozwala na masowy dostęp do dużych zbiorów danych.

- Proste nagłówki HTTP są używane do autoryzacji wszystkich interfejsów API Spinn3r.

- Jest to darmowe narzędzie do pobrania.

- Classifier API pozwala programistom na przesyłanie tekstów (lub URL), które mają być analizowane przez naszą technologię uczenia maszynowego.

3. Import.io

Import.io pozwala na przeszukiwanie milionów stron internetowych oraz tworzenie ponad 1000 interfejsów API dostosowanych do Twoich potrzeb, bez konieczności pisania kodu.

- Można teraz działać programowo, a dane mogą być pobierane automatycznie.

- Umożliwia jednoczesne wyodrębnienie danych z wielu stron jednym kliknięciem.

- Automatycznie rozpoznaje listy podzielone na strony lub można przejść do następnej strony ręcznie.

- Za pomocą kilku kliknięć można włączyć dane do swojej aplikacji lub strony internetowej.

- Tworzenie potrzebnych adresów URL zajmuje zaledwie kilka sekund, na przykład przy użyciu wzorców numerów stron i nazw kategorii.

- Import.io ułatwia instrukcje dotyczące pozyskiwania danych z witryn. Wystarczy wybrać kolumnę ze zbioru danych i wskazać interesujący element na stronie.

- Można złożyć zapytanie dotyczące wyceny na ich stronie internetowej.

- Linki na stronach z listami prowadzą do szczegółowych stron z dodatkowymi informacjami.

- Można użyć Import.io do jednoczesnego pobrania danych ze stron szczegółowych.

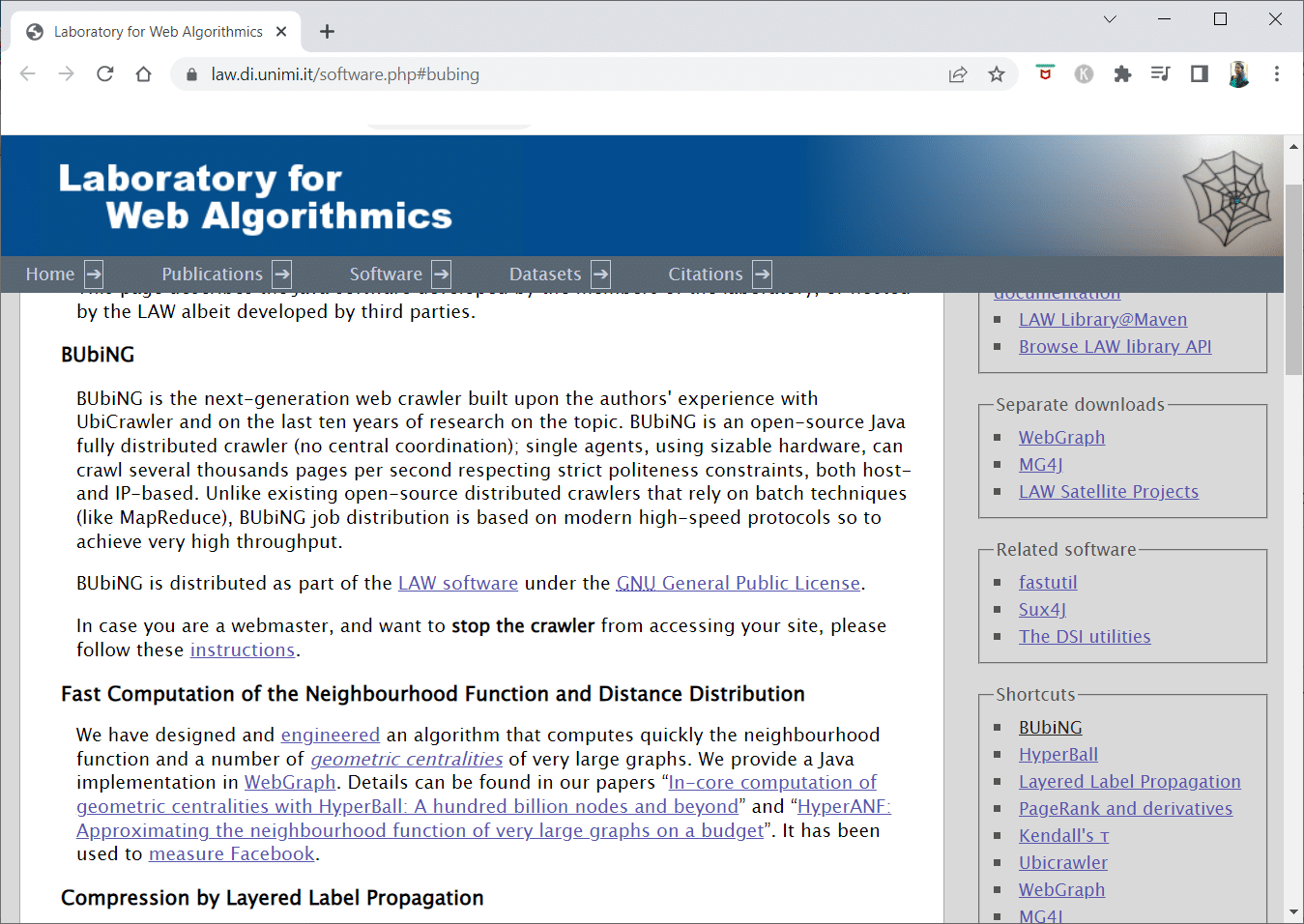

4. BUbiNG

BUbiNG to nowoczesne narzędzie do przeszukiwania, będące efektem dziesięcioletnich badań i doświadczeń jego twórców.

- Jeden agent potrafi skanować tysiące stron na sekundę, zachowując wysokie standardy uprzejmości, zarówno w odniesieniu do hosta, jak i adresu IP.

- Jego dystrybucja zadań opiera się na szybkim protokole, co zapewnia wysoką przepustowość, w przeciwieństwie do wcześniejszych wersji open source, które korzystały z technik wsadowych.

- Wykorzystuje odcisk palca usuniętej strony do wykrywania duplikatów.

- BUbiNG jest całkowicie rozproszonym narzędziem Java typu open source.

- Oferuje wiele równoległych operacji.

- Jest szybki i umożliwia indeksowanie na dużą skalę.

5. GNU Wget

GNU Wget to darmowe narzędzie do przeszukiwania sieci, które jest dostępne jako oprogramowanie open source napisane w C i umożliwia pobieranie plików przez HTTP, HTTPS, FTP i FTPS.

- Jedną z jego charakterystycznych cech jest możliwość tworzenia plików wiadomości opartych na NLS w różnych językach.

- Możesz wznowić pobieranie, które zostało przerwane, używając REST i RANGE.

- W razie potrzeby potrafi przekształcać linki bezwzględne w pobranych dokumentach na linki względne.

- Obsługuje rekurencyjne użycie symboli wieloznacznych w nazwach plików oraz lustrzane pobieranie katalogów.

- Podczas tworzenia kopii lustrzanej lokalne sygnatury czasowe plików są oceniane, aby ustalić, czy dokumenty wymagają ponownego pobrania.

6. Webhose.io

Webhose.io to doskonała aplikacja do przeszukiwania, umożliwiająca skanowanie danych i wyodrębnianie słów kluczowych w wielu językach, korzystając z różnych filtrów i źródeł.

- Archiwum umożliwia również przeglądanie historycznych danych.

- Funkcja wyszukiwania danych indeksowania jest dostępna w maksymalnie 80 językach.

- Wszystkie dane osobowe, które zostały naruszone, są gromadzone w jednym miejscu.

- Możliwe jest badanie darknetu oraz aplikacji do przesyłania wiadomości w kontekście cyberzagrożeń.

- Obsługiwane są formaty XML, JSON oraz RSS dla zeskrobanych danych.

- Można uzyskać wycenę na ich stronie internetowej.

- Użytkownicy mogą łatwo indeksować i przeszukiwać uporządkowane dane na Webhose.io.

- Monitoruje i analizuje media w różnych językach.

- Umożliwia śledzenie dyskusji na forach oraz kluczowych postów na blogach w sieci.

7. Norconex

Norconex to doskonałe rozwiązanie dla firm poszukujących aplikacji typu open source do robotów indeksujących.

- To w pełni funkcjonalny kolektor, który można integrować z Twoim programem.

- Może również przechwytywać polecane obrazy z witryn.

- Norconex umożliwia indeksowanie zawartości dowolnej witryny.

- Działa na różnych systemach operacyjnych.

- Ten robot indeksujący potrafi indeksować miliony stron na jednym serwerze o średniej wydajności.

- Oferuje zestaw narzędzi do modyfikacji treści i metadanych.

- Można uzyskać metadane dla dokumentów w trakcie pracy.

- Obsługuje strony renderowane w JavaScript.

- Umożliwia wykrywanie wielu języków oraz wspomaga tłumaczenie.

- Prędkość indeksowania może się różnić.

- Możliwe jest wykrywanie dokumentów, które zostały zmodyfikowane lub usunięte.

- Jest to darmowe oprogramowanie dla robotów indeksujących.

8. Dexi.io

Dexi.io to aplikacja do przeszukiwania działająca w przeglądarce, która pozwala na zbieranie informacji z dowolnej witryny internetowej.

- Umożliwia korzystanie z trzech rodzajów robotów: ekstraktorów, gąsienic i rur do pozyskiwania danych.

- Umożliwia prognozowanie rozwoju rynku za pomocą raportów Delta.

- Zebrane dane mogą być przechowywane przez dwa tygodnie na serwerach Dexi.io przed archiwizacją lub eksportowane jako pliki JSON lub CSV.

- Można uzyskać wycenę na ich stronie internetowej.

- Oferowane są usługi profesjonalne, takie jak zapewnienie jakości i bieżąca konserwacja.

- Umożliwia śledzenie zapasów i cen dla nieograniczonej liczby SKU/produktów.

- Umożliwia integrację danych z pulpitów nawigacyjnych w czasie rzeczywistym oraz pełną analitykę produktów.

- Ułatwia przygotowanie i uporządkowanie danych produktów dostępnych w Internecie.

9. Zyte

Zyte to oparte na chmurze narzędzie do ekstrakcji danych, które wspiera liczne projekty programistyczne w pozyskiwaniu kluczowych informacji. Jest to jedno z najlepszych darmowych narzędzi dla robotów indeksujących.

- Użytkownicy mogą zeskrobać strony internetowe za pomocą wizualnego narzędzia do skrobania, nawet bez umiejętności programistycznych.

- System rotacji proxy używany przez Zyte pozwala na łatwe indeksowanie dużych lub chronionych witryn, omijając zabezpieczenia przed botami.

- Informacje online dostarczane są zgodnie z harmonogramem, co pozwala skoncentrować się na pozyskiwaniu danych, zamiast zarządzać proxy.

- Dzięki zaawansowanemu renderowaniu przeglądarek można skutecznie radzić sobie z antybotami.

- Można uzyskać wycenę na ich stronie internetowej.

- Użytkownicy mogą indeksować z różnych adresów IP i regionów, korzystając z prostego interfejsu API HTTP, co eliminuje konieczność zarządzania serwerem proxy.

- Umożliwia generację gotowych danych, oszczędzając czas na pozyskiwaniu informacji.

- Umożliwia masowe wyodrębnianie danych z sieci, co oszczędza czas na kodowanie i konserwację robotów.

10. Apache Nutch

Apache Nutch to wiodące narzędzie open source dla robotów indeksujących.

- Może działać na jednej maszynie, ale najlepiej sprawdza się w klastrze Hadoop.

- Używa protokołu NTLM do uwierzytelniania.

- Posiada rozproszony system plików (poprzez Hadoop).

- Jest znanym projektem open source do ekstrakcji danych online, który można dostosować do potrzeb użytkownika.

- Używany jest przez wielu analityków, naukowców danych oraz specjalistów zajmujących się eksploracją tekstu w Internecie na całym świecie.

- To wieloplatformowe rozwiązanie oparte na Javie.

- Domyślnie pobieranie i analiza danych są realizowane niezależnie.

- Dane są przetwarzane z użyciem XPath oraz przestrzeni nazw.

- Zawiera bazę danych wykresów linków.

11. Wizualny skrobak

VisualScraper to intuicyjne narzędzie do skrobania danych z Internetu, które nie wymaga umiejętności programistycznych.

- Oferuje prosty interfejs użytkownika oparty na zasadzie „wskaż i kliknij”.

- Dodatkowo oferuje usługi online, takie jak dystrybucja danych i budowanie ekstraktorów oprogramowania.

- Monitoruje również aktywność konkurencji.

- Umożliwia zaplanowanie uruchamiania projektów na określony czas lub powtarzanie ich co minutę, dzień, tydzień, miesiąc lub rok.

- Jest bardziej przystępny cenowo i efektywny.

- Nie wymaga żadnego kodowania.

- To w pełni darmowe narzędzie dla robotów indeksujących.

- Dane w czasie rzeczywistym mogą być pozyskiwane z różnych stron i zapisywane w formacie CSV, XML, JSON lub SQL.

- Można go używać do regularnego pobierania wiadomości, aktualizacji oraz postów na forach.

- Dane są dokładnie przetwarzane i dostosowywane do potrzeb użytkownika.

12. WebSfinks

WebSphinx to osobista aplikacja do przeszukiwania, która jest łatwa do skonfigurowania i obsługi.

- Jest skierowana do zaawansowanych użytkowników sieci oraz programistów Java, którzy chcą automatycznie skanować wybrane obszary Internetu.

- Oferuje bibliotekę klas Java oraz interaktywne środowisko programistyczne.

- Strony mogą być łączone w jeden dokument do przeglądania lub wydruku.

- Umożliwia wyodrębnienie tekstu zgodnie z określonym wzorcem z sekwencji stron.

- Dzięki temu pakietowi można tworzyć roboty sieciowe w Javie.

- WebSPHINX zawiera Crawler Workbench oraz bibliotekę klas.

- Crawler Workbench to graficzny interfejs użytkownika, który pozwala na dostosowywanie i zarządzanie robotem indeksującym.

- Można tworzyć wykresy z grupy stron internetowych.

- Umożliwia zapisanie stron na dysku lokalnym do późniejszego przeglądania offline.

13. Centrum OutWit

OutWit Hub to platforma zawierająca szeroką bibliotekę możliwości rozpoznawania i ekstrakcji danych, umożliwiająca tworzenie różnych aplikacji.

- To narzędzie przeszukiwacza sieci może skanować witryny i przechowywać zebrane dane w przystępnej formie.

- Jest to wielofunkcyjna aplikacja, która zaspokaja różnorodne potrzeby.

- Hub istnieje na rynku od dłuższego czasu.

- To użyteczne narzędzie zarówno dla nietechnicznych użytkowników, jak i dla specjalistów IT, którzy wiedzą, że PHP nie zawsze jest najlepszym wyborem do pozyskiwania danych.

- OutWit Hub umożliwia zbieranie danych z dowolnej strony internetowej bezpośrednio z przeglądarki oraz tworzenie automatycznych agentów do pobierania danych.

- Można złożyć zapytanie dotyczące wyceny na ich stronie internetowej.

14. Scrapy

Scrapy to framework do skrobania danych w Pythonie, który umożliwia tworzenie skalowalnych robotów indeksujących.

- To kompleksowa platforma do przeszukiwania sieci, która obsługuje wszystkie aspekty tworzenia robotów, w tym oprogramowanie pośredniczące i zapytania.

- Możesz pisać zasady wyodrębniania danych, a następnie pozwolić Scrapy zająć się resztą.

- Łatwo dodaje się nowe funkcje bez modyfikacji rdzenia oprogramowania, ponieważ został zaprojektowany w ten sposób.

- To program oparty na Pythonie, działający na systemach Linux, Windows, Mac OS X i BSD.

- Jest to całkowicie darmowe narzędzie.

- Jego biblioteka oferuje programistom gotową strukturę do dostosowywania robotów sieciowych i wydobywania danych na dużą skalę.

15. Mozenda

Mozenda to kolejna znakomita darmowa aplikacja dla robotów internetowych. To chmurowe, samoobsługowe narzędzie do skrobania danych, które zyskało uznanie na całym świecie.

- Technologia web scrapingu firmy Mozenda eliminuje potrzebę pisania skryptów oraz zatrudniania inżynierów.

- Przyspiesza proces zbierania danych pięciokrotnie.

- Można zeskrobać tekst, pliki, obrazy i informacje PDF za pomocą opcji „wskaż i kliknij”.

- Umożliwia organizację danych w pliki gotowe do publikacji.

- Eksportuj dane bezpośrednio do TSV, CSV, XML, XLSX lub JSON za pomocą API Mozendy.

- Technologia Data Wrangling pozwala na uporządkowanie informacji w celu podejmowania kluczowych decyzji.

- Można skorzystać z platform partnerów Mozendy do integracji danych lub tworzenia niestandardowych rozwiązań.

16. Cyotek Webcopy

Cyotek Webcopy to darmowe narzędzie, które pozwala na automatyczne pobieranie zawartości witryny na lokalne urządzenie.

- Wybrana strona jest skanowana i pobierana.

- Można określić, które części witryny chcesz sklonować oraz jak wykorzystać jej złożoną strukturę.

- Nowa lokalizacja będzie odpowiednio przekierowywać linki do zasobów witryny, takich jak arkusze stylów czy obrazy.

- Prowadzi analizę znaczników HTML, aby zidentyfikować powiązane zasoby, takie jak inne witryny czy pliki do pobrania.

- Może indeksować witrynę i pobierać wszystko, co widzi, aby stworzyć akceptowalną kopię oryginału.

17. Common Crawl

Common Crawl to organizacja non-profit, która umożliwia badanie i analizę danych w celu uzyskania użytecznych informacji.

- Każdy może korzystać z danych Common Crawl bez ponoszenia kosztów.

- Organizacja opiera swoją działalność na darowiznach.

- Common Crawl stanowi zasób do nauki, badań oraz analizy.

- Osoby bez umiejętności technicznych mogą zapoznać się z artykułami o odkryciach dokonanych przez innych z wykorzystaniem tych danych.

- Nauczyciele mogą używać tych narzędzi do nauczania analizy danych.

18. Semrush

Semrush to narzędzie robotów indeksujących, które analizuje strony oraz ich strukturę pod kątem technicznych problemów SEO. Rozwiązanie tych problemów może poprawić wyniki wyszukiwania.

- Oferuje narzędzia do SEO, badań rynku, marketingu w mediach społecznościowych oraz reklamy.

- Interfejs użytkownika jest przyjazny i intuicyjny.

- Analizuje metadane, HTTP/HTTPS, dyrektywy, kody stanu, duplikaty treści oraz inne elementy.

- Umożliwia szybki audyt witryny.

- Wspiera analizę plików dziennika.

- Program oferuje pulpit nawigacyjny, który ułatwia przeglądanie problemów z witryną.

19. Sitechecker.pro

Sitechecker.pro to kolejne znakomite darmowe narzędzie dla robotów indeksujących. Umożliwia sprawdzanie SEO witryn, co przyczynia się do poprawy ich pozycji w wynikach wyszukiwania.

- Ułatwia wizualizację struktury strony internetowej.

- Generuje raporty z audytu SEO, które można przesyłać klientom drogą mailową.

- Robot indeksujący może przeszukiwać wewnętrzne i zewnętrzne linki witryny.

- Pomaga w identyfikacji szybkości działania witryny.

- Można również sprawdzić problemy z indeksowaniem na stronach docelowych.

- Chroni przed atakami hakerskimi.

20. Webharvy

Webharvy to narzędzie do skrobania sieci, które charakteryzuje się prostym interfejsem „wskaż i kliknij”, co czyni je idealnym dla osób bez umiejętności programistycznych.

- Koszt licencji zaczyna się od 139 USD.

- Użytkownicy mogą korzystać z wbudowanej przeglądarki WebHarvy do ładowania witryn internetowych i wyodrębniania danych poprzez kliknięcia.

- Automatycznie skroba tekst, zdjęcia, adresy URL oraz e-maile, zapisując je w różnych formatach.

- Można korzystać z serwerów proxy lub VPN, aby uzyskać dostęp do docelowych witryn.

- Nie wymaga tworzenia żadnego oprogramowania ani aplikacji.

- Zapewnia anonimowe skrobanie, co ogranicza ryzyko blokady przez serwery internetowe.

- WebHarvy automatycznie identyfikuje wzorce danych na stronach internetowych.

- Umożliwia skrobanie list obiektów bez dodatkowych działań ze strony użytkownika.

21. Pająk NetSpeak

NetSpeak Spider to aplikacja do codziennych audytów SEO, która pozwala na szybkie identyfikowanie problemów oraz systematyczne analizy stron internetowych.

- Sprawdza duże witryny, minimalizując jednocześnie użycie pamięci RAM.

- Dane można łatwo importować i eksportować w formacie CSV.

- Zaledwie kilka kliknięć wystarczy, aby zidentyfikować poważne problemy związane z SEO.

- Narzędzie ocenia optymalizację witryny, w tym kody stanu, instrukcje przeszukiwania oraz struktury witryny.

- Możliwe jest eksportowanie danych z Google Analytics oraz Yandex.

- Umożliwia uwzględnienie zakresu danych, typu urządzenia oraz segmentacji dla ruchu, konwersji czy celów.

- Subskrypcje zaczynają się od 21 USD miesięcznie.

- Wykrywa uszkodzone linki oraz duplikaty treści, takie jak strony, teksty, tagi tytułu i metaopisu.

22. UiPath

UiPath to narzędzie do automatyzacji procesów, które pozwala na zautomatyzowanie indeksowania danych w Internecie oraz na komputerze.

- Możesz zainstalować aplikację do automatyzacji procesów w systemie Windows.

- Potrafi wyodrębniać dane w formie tabelarycznej oraz opartej na wzorcach z różnych stron internetowych.

- UiPath może realizować dodatkowe indeksowanie zaraz po instalacji.

- Raportuje działania robotów, co pozwala na bieżąco przeglądać dokumentację.

- Ujednolicenie praktyk przyczynia się do zwiększenia efektywności wyników.

- Subskrypcje zaczynają się od 420 USD miesięcznie.

- Oferuje ponad 200 gotowych komponentów, co umożliwia szybkie działanie.

- Roboty UiPath zwiększają zgodność, stosując dokładną metodę dopasowaną do potrzeb.

- Firmy mogą osiągnąć cyfrową transformację przy niższych kosztach dzięki optymalizacji procesów i analizie danych.

23. Helium Scraper

Helium Scraper to wizualne narzędzie do skrobania danych online, które sprawdza się w sytuacjach, gdzie istnieje ograniczona liczba połączeń między elementami. Może spełniać wymagania użytkowników w zakresie indeksowania.

- Nie wymaga kodowania ani konfiguracji.

- Intuicyjny interfejs użytkownika pozwala na wybieranie i dodawanie działań z listy.

- Dostępne są szablony online do specjalnych wymagań.

- Wykorzystuje wiele przeglądarek internetowych Chromium w tle.

- Można zwiększyć liczbę równoległych przeglądarek, aby uzyskać więcej danych.

- Można definiować własne działania lub korzystać z niestandardowego JavaScript dla bardziej złożonych przypadków.

- Licencje zaczynają się od 99 USD i mogą wzrastać.

24. 80Legs

80Legs powstało w 2009 roku, aby zwiększyć dostępność danych online. To kolejne znakomite darmowe narzędzie dla robotów indeksujących. Początkowo firma koncentrowała się na świadczeniu usług indeksowania sieci.

- Nasza rozwinięta aplikacja dostarcza spersonalizowane informacje.

- Szybkość indeksowania jest automatycznie dostosowywana w zależności od ruchu na stronie.

- Możesz pobrać wyniki do swojego lokalnego środowiska za pośrednictwem 80Legs.

- Wystarczy podać adres URL do zaindeksowania witryny.

- Subskrypcje zaczynają się od 29 USD miesięcznie.

- Dzięki modelowi SaaS możliwe jest tworzenie i przeprowadzanie indeksowania sieci.

- Posiada wiele serwerów, co umożliwia przeglądanie witryn z różnych adresów IP.

- Umożliwia szybki dostęp do danych witryn bez konieczności przeszukiwania sieci.

- Ułatwia tworzenie i wykonywanie niestandardowych indeksów sieci.

- Można używać tej aplikacji do śledzenia trendów online.

- Umożliwia tworzenie własnych szablonów.

25. ParseHub

ParseHub to doskonałe narzędzie dla robotów indeksujących, które może zbierać informacje ze stron korzystających z technologii AJAX, JavaScript oraz plików cookie.

- Silnik uczenia maszynowego potrafi analizować i przekształcać treści online na znaczące dane.

- Można korzystać z wbudowanej aplikacji internetowej w przeglądarkach.

- Umożliwia pozyskiwanie danych z milionów stron internetowych.

- ParseHub automatycznie przeszukuje tysiące linków oraz słów kluczowych.

- Dane są zbierane i przechowywane automatycznie na serwerach.

- Pakiety miesięczne zaczynają się od 149 USD.

- Jako shareware można stworzyć pięć publicznych projektów w ParseHub.

- Umożliwia dostęp do rozwijanych menu, logowanie się na stronach internetowych oraz zarządzanie stronami z nieskończonym przewijaniem i wyskakującymi okienkami.

- Klient stacjonarny jest dostępny dla Windows, Mac OS X oraz Linux.

- Można pozyskiwać zeskrobane dane w dowolnym formacie do analizy.

- Użytkownicy mogą tworzyć co najmniej 20 prywatnych projektów na poziomie członkostwa premium.

***

Mamy nadzieję, że ten artykuł okazał się pomocny i że znajdziesz w nim swoje ulubione darmowe narzędzie do indeksowania sieci. Zachęcamy do dzielenia się swoimi przemyśleniami, pytaniami oraz sugestiami w sekcji komentarzy poniżej. Możesz również zasugerować nam brakujące narzędzia i powiedzieć, czego chciałbyś się nauczyć w przyszłości.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.