Chatboty wykorzystujące sztuczną inteligencję, takie jak ChatGPT, to nie tylko narzędzia do odpowiadania na pytania. Potrafią one tworzyć teksty, które na pierwszy rzut oka przypominają te napisane przez człowieka, takie jak wiadomości e-mail, listy motywacyjne, wypracowania, wiersze, wpisy na blogach i wiele innych.

Technologia pisania oparta na sztucznej inteligencji jest niezwykle adaptacyjna – potrafi naśladować różnorodne style pisania z taką precyzją, że granica między tekstem ludzkim a generowanym przez AI staje się nieostra.

Niestety, to zjawisko sprawia, że identyfikacja tekstów stworzonych przez sztuczną inteligencję staje się dla nas, ludzi, wyjątkowo trudna. Oczywiście, moglibyśmy zastosować metodę eliminacji Sherlocka Holmesa, ale kto ma na to czas?

A gdybym powiedział, że powyższy fragment jest dziełem sztucznej inteligencji? Tak, poprosiłem YouWrite o stworzenie tego krótkiego wprowadzenia i taki właśnie był efekt. Dość przekonujące, prawda? I tu leży problem – ta wysoka jakość sprawia, że każdy może przypisać sobie autorstwo, aby na tym skorzystać.

Sztuczna inteligencja nie tylko przeredagowuje istniejące treści. Uczy się ona na dany temat, aby przedstawić go w naturalnym języku, korzystając z mechanizmu RLHF (uczenie ze wzmocnieniem z wykorzystaniem opinii ludzi). W rezultacie teksty te nie brzmią sztucznie ani nie są identyczne z dostępnymi w Internecie, co uniemożliwia wykrycie plagiatu tradycyjnymi metodami.

Wyłapywanie tekstów stworzonych przez AI nie jest łatwe i nie chcę dawać fałszywej nadziei, że zawsze da się to zrobić z całkowitą pewnością. Niemniej jednak, z odrobiną detektywistycznej pracy i przy wsparciu narzędzi do wykrywania tekstów AI, większość takich prac można zidentyfikować.

Poniżej omówię manualne metody rozpoznawania plagiatu AI oraz kilka automatycznych narzędzi, które mogą w tym pomóc.

Jak ręcznie wykryć plagiat AI? 🕵️

ChatGPT to nie jedyny problem, jeśli chodzi o plagiat AI. Istnieje wiele innych narzędzi bazujących na tej samej technologii GPT-3, które są specjalnie zaprojektowane do pisania. Są one zaawansowane i tworzą treści o charakterze ludzkim, co utrudnia ich identyfikację.

Narzędzia do automatycznego wykrywania nie zawsze działają poprawnie – ich skuteczność zależy od rodzaju, długości i złożoności tekstu. Z tego powodu, przynajmniej na razie, najlepszą metodą jest analiza tekstu i łączenie faktów w celu określenia, czy mamy do czynienia z tekstem stworzonym przez sztuczną inteligencję, czy nie.

Poniżej przedstawiam kilka typowych wskazówek, które mogą pomóc w wykryciu treści wygenerowanych przez AI.

#1. Nieaktualne informacje

ChatGPT oraz inne modele AI oparte na GPT-3 posiadają ograniczoną bazę wiedzy, która sięga końca 2021 roku. Choć niektóre boty AI korzystają z wbudowanych wyszukiwarek w celu aktualizacji informacji, nadal bazują na starszych danych podczas tworzenia dłuższych tekstów, takich jak wypracowania czy wpisy na blogu.

Jeśli tekst regularnie odwołuje się do nieaktualnych danych, szczególnie tych sprzed 2021 roku, może to być sygnał, że został wygenerowany przez sztuczną inteligencję.

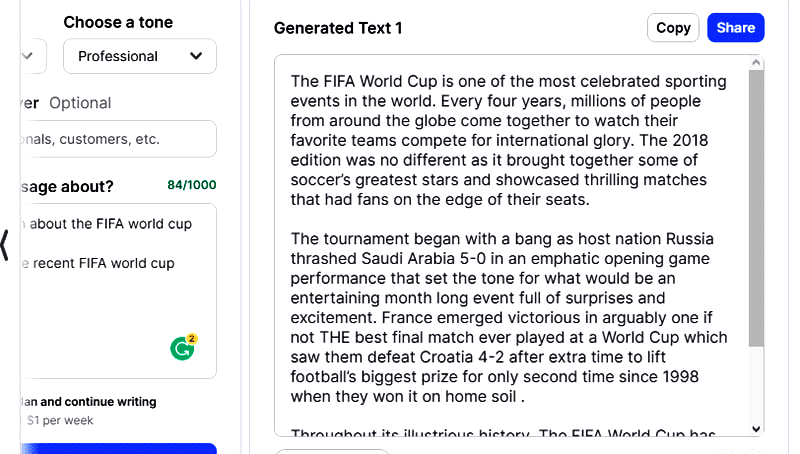

Na poniższym zrzucie ekranu poprosiłem YouWrite o informacje na temat ostatnich Mistrzostw Świata FIFA i tak to wygląda:

Informacje dotyczą Mistrzostw Świata z 2018 roku, a nie z ostatniego turnieju w 2022 roku. Choć narzędzie jest zaktualizowane, by uwzględniać najnowsze wydarzenia, w przypadku dłuższych form nadal wykorzystuje przestarzałe dane, na których zostało zbudowane.

#2. Powtarzalna struktura zdań w opisach

Podczas tworzenia opisów wielu produktów lub aplikacji, sztuczna inteligencja często stosuje tę samą strukturę zdań, którą modyfikuje, aby pasowała do konkretnego produktu. Opisy zazwyczaj zaczynają się od tego samego słowa, na przykład „The”, „It”, „A” lub nazwy produktu, oraz skupiają się na konkretnym aspekcie.

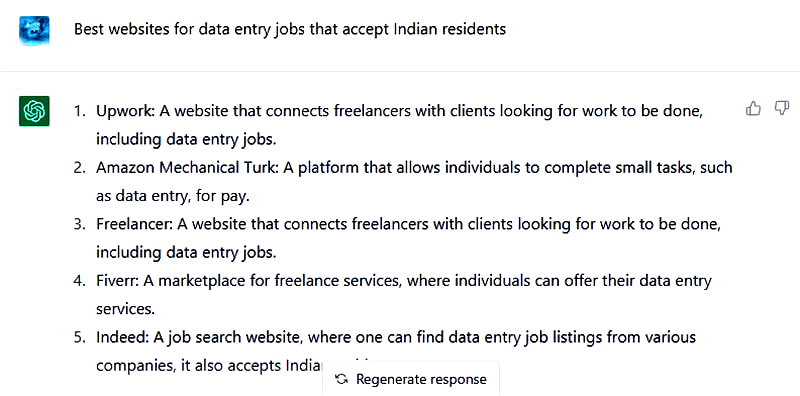

Przykładowo, poprosiłem ChatGPT o opis „stron internetowych z ofertami pracy”. Jak widać, wszystkie opisy zaczynają się od litery „A” i mają bardzo podobną konstrukcję.

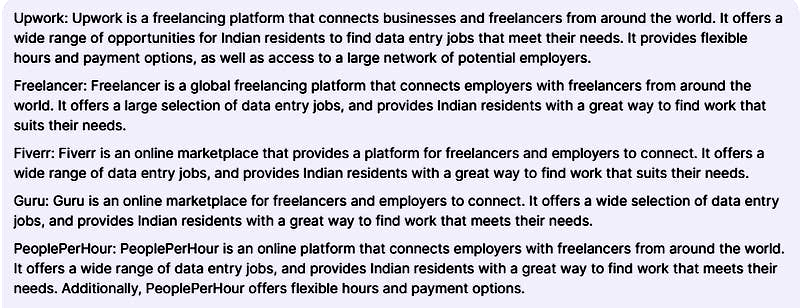

Zadałem to samo pytanie YouChat, który postąpił podobnie – powtarzając nazwę każdej witryny na początku, a opisy wyglądają na przeredagowane wersje.

Jeśli analizowany opis zawiera podobnie skonstruowane elementy, jest to cenna wskazówka wskazująca na to, że mógł zostać stworzony przez AI.

#3. Krótkie zdania

W większości opisów sztuczna inteligencja używa zdań jedno linijkowych, zawierających co najwyżej jeden przecinek. Być może jest to próba zminimalizowania ryzyka błędów, ale widać, że AI unika dłuższych zdań, które wymagałyby użycia dwukropków, średników czy myślników.

Choć nie jest to najważniejsza wskazówka, warto wziąć ją pod uwagę, aby wzmocnić swoje podejrzenia.

#4. Błędne informacje

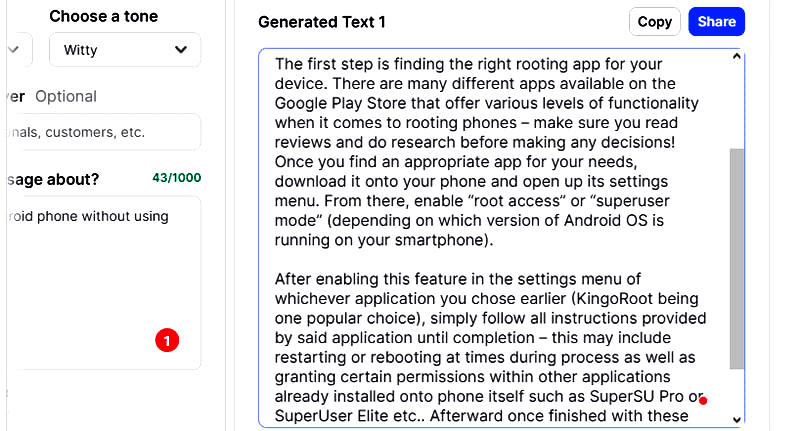

W przypadku skomplikowanych pytań, zwłaszcza tych zawierających instrukcje, sztuczna inteligencja może nie zrozumieć intencji i przekazać nieprawdziwe informacje. Nie chodzi tu o nieaktualne dane, lecz o podawanie błędnych faktów w oparciu o niezrozumienie tematu.

Na przykład, poprosiłem YouWrite o instrukcję „jak zrootować telefon z Androidem bez komputera”. Narzędzie wciąż podawało metody, które w pewnym momencie wymagały użycia komputera.

#5. Brak osobistej opinii

Opisując coś, AI przedstawia znane fakty. Nie dzieli się swoimi osobistymi doświadczeniami, jak robią to ludzie. Choć AI można nauczyć tworzenia praktycznych tekstów, domyślnie ich unika.

Jeśli opis zawiera jedynie dobrze znane fakty, istnieje duże prawdopodobieństwo, że został napisany przez sztuczną inteligencję. Na przykład, omawiając aplikację, AI skupi się na jej funkcjach, pomijając subiektywne wrażenia z jej używania.

#6. Zwięzłe wyjaśnienia

Sztuczna inteligencja jest ograniczona aktualną wiedzą, dlatego ma tendencję do tworzenia krótkich wyjaśnień i opisów. Z moich doświadczeń wynika, że omawiając konkretny temat, np. rootowanie Androida, ogranicza się do 2-3 akapitów. Opis aplikacji lub produktu zazwyczaj nie przekracza jednego akapitu.

Ludzie potrafią pisać bardziej szczegółowo, uwzględniając funkcje, ograniczenia, osobiste doświadczenia, ceny itp. AI natomiast skupia się na głównych funkcjach lub najważniejszych aspektach, przez co opisy są zwięzłe. A gdy instruktor poprosi o więcej szczegółów, rośnie ryzyko podania błędnych informacji.

#7. Analiza historii pisarza

Jeśli jako nauczyciel lub administrator strony masz dostęp do wcześniejszych prac autora, porównanie ich z podejrzanym tekstem może być pomocne. Mało prawdopodobne jest, aby styl pisania autora był identyczny ze stylem sztucznej inteligencji. Choć AI potrafi zmieniać ton, style, które wybiera, są dość ogólne i nie potrafi naśladować indywidualnego stylu pisania.

Na przykładzie wstępu do tego artykułu, stworzonego przez AI, każdy, kto czytał moje poprzednie wpisy, od razu zauważy różnicę w stylu pisania.

Wystarczy przeczytać 2-3 wcześniejsze prace autora, aby ocenić, czy jego styl pisania pasuje do podejrzanego tekstu.

Narzędzia do wykrywania plagiatu AI

Istnieje wiele narzędzi, które mogą wykrywać treści napisane przez sztuczną inteligencję. Jednak ich dokładność jest różna i może zależeć od rodzaju oraz długości tekstu.

Testowałem te narzędzia na różnych rodzajach treści generowanych przez ChatGPT, GPT-3 Playground, WriteSonic, Rytr i YouWrite. Udało im się wykryć wszystkie treści stworzone przez ChatGPT i GPT-3 Playground.

Wyniki były zróżnicowane w przypadku narzędzi specjalizujących się w pisaniu, ale co ciekawe, żadne z narzędzi nie wykryło tekstów z YouWrite. Przypuszczam, że YouWrite celowo popełnia „ludzkie” błędy, aby uniknąć wykrycia.

Zalecam stosowanie tych narzędzi w połączeniu z ręczną analizą treści. Najpierw przeskanuj tekst za pomocą wybranego narzędzia, a następnie sam poszukaj wskazówek, które mogą potwierdzić twoje podejrzenia.

Poniżej wymieniam narzędzia, które dały najlepsze rezultaty i są najłatwiejsze w obsłudze:

Uwaga: do demonstracji użyję tekstu wygenerowanego przez WriteSonic na temat „Korzyści z mango”.

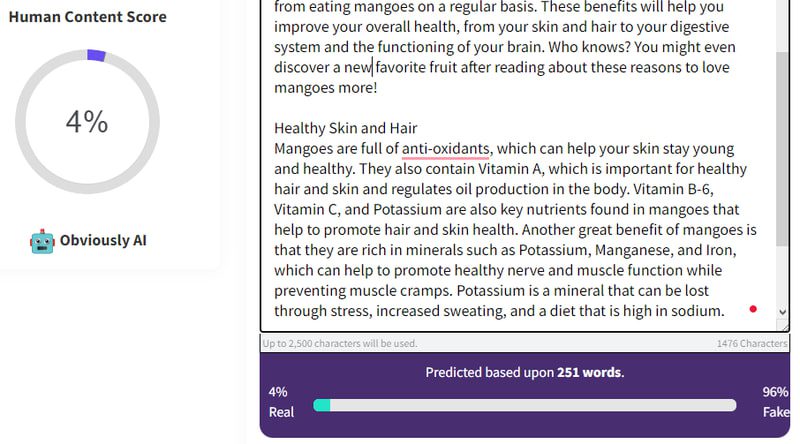

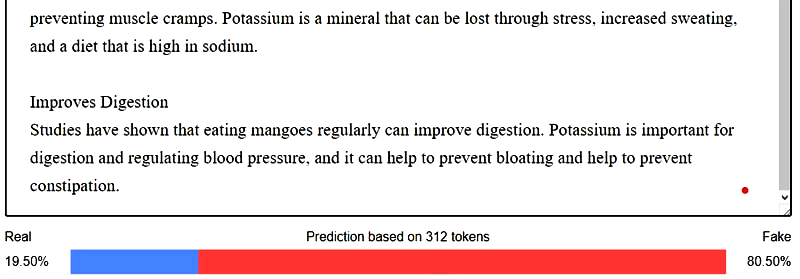

#1. Content At Scale

Spośród wszystkich narzędzi, które testowałem, wykrywacz treści AI firmy Content At Scale był najdokładniejszy. Pozwala na skanowanie do 2500 znaków i na podstawie procentowej prognozy określa prawdopodobieństwo, czy tekst jest prawdziwy, czy sztuczny.

Można założyć, że tekst, który w ponad 60% został oceniony jako sztuczny, prawdopodobnie został napisany przez sztuczną inteligencję lub przynajmniej jego znaczna część. Na poniższym zrzucie ekranu widać, że 96% tekstu to treści wygenerowane w pełni przez AI.

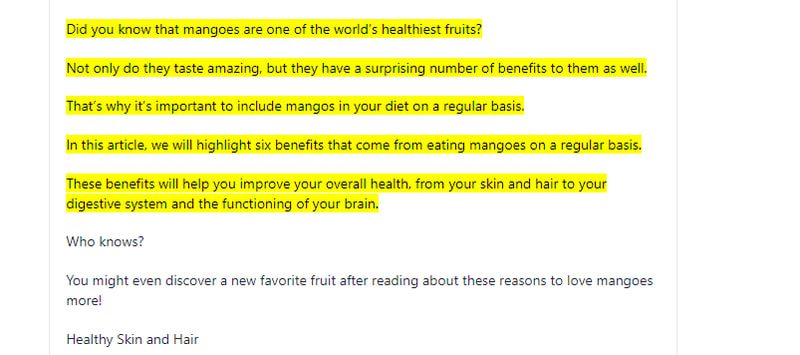

#2. GPTZero

GPTZero to dobre rozwiązanie, jeśli chcesz zobaczyć dokładnie, które fragmenty tekstu zostały wygenerowane przez AI. Narzędzie to nie ocenia całości tekstu. Zamiast tego, podkreśla fragmenty, które z największym prawdopodobieństwem zostały stworzone przez sztuczną inteligencję.

Choć narzędzie przedstawia wyniki dotyczące „zakłopotania” i „rozerwania” tekstu, jego zaletą jest obsługa do 5000 znaków na skan i możliwość przesyłania plików. Skanowanie większych partii tekstu znacząco wpływa na poprawę dokładności.

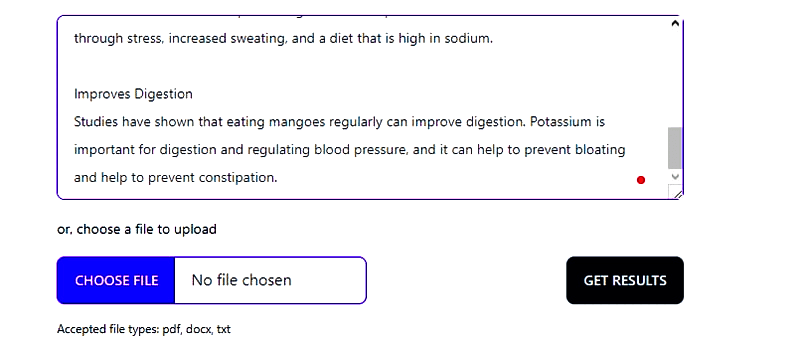

#3. Detektor wyjścia GPT-2

Twórcy ChatGPT udostępniają również własny detektor do wykrywania tekstów wygenerowanych przez ich narzędzia. Ponieważ GPT-2 i GPT-3 różnią się jedynie ilością danych użytych do uczenia, ten detektor GPT-2 dobrze sprawdza się również w przypadku sztucznej inteligencji opartej na GPT-3.

Narzędzie nie ma ograniczeń co do ilości skanowanego tekstu, dzięki czemu idealnie nadaje się do analizy długich treści generowanych przez AI. Jego dokładność jest zadowalająca, szczególnie w przypadku treści stworzonych przez ChatGPT. Należy jednak brać pod uwagę wyniki z pewną rezerwą, szczególnie gdy narzędzie wskazuje mniej niż 50% treści jako sztuczne.

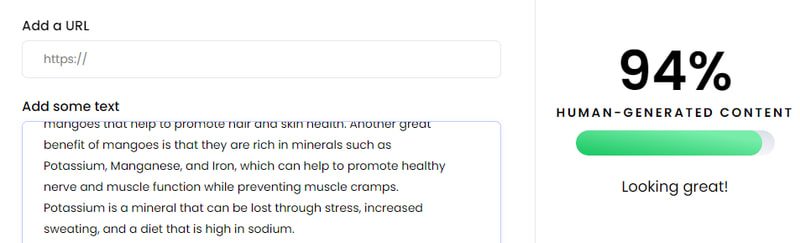

#4. Writer AI Content Detector

Wyniki narzędzia Writer AI Content Detector są niejednoznaczne w przypadku wykrywania tekstów stworzonych przez specjalistyczne narzędzia do pisania oparte na AI. Sprawdza się jednak dobrze w przypadku treści generowanych przez ChatGPT. Możesz zeskanować 1500 znaków lub podać adres URL, jeśli tekst został już opublikowany.

W moim teście, tekst wygenerowany przez AI został oceniony w 94% jako napisany przez człowieka, co jest wynikiem mocno odbiegającym od innych narzędzi. Niemniej jednak warto go używać do wykrywania treści z ChatGPT, zwłaszcza tych już opublikowanych.

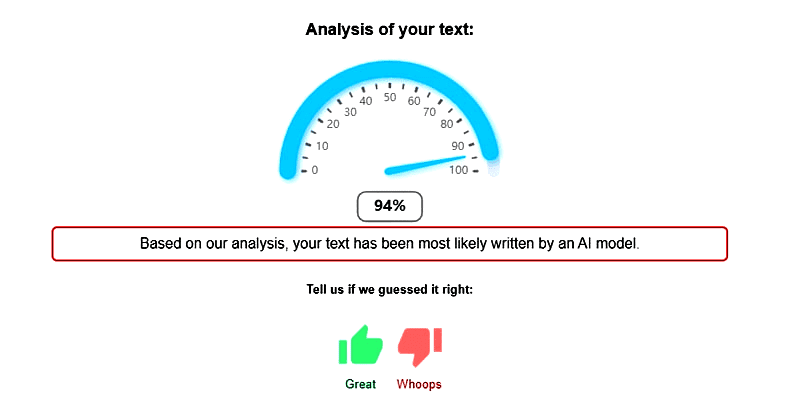

#5. Draft & Goal

Draft & Goal to proste, ale skuteczne narzędzie do wykrywania tekstów AI. Z mojego doświadczenia wynika, że daje podobne rezultaty jak Content At Scale, ale bez ograniczenia liczby słów, co pozwala na skanowanie długich tekstów. Czas skanowania wydłuża się wraz z ilością analizowanego tekstu.

W moim przykładowym tekście narzędzie oceniło 94% treści jako wygenerowane przez sztuczną inteligencję.

Moje przemyślenia 💭

Uważam, że wsparcie AI jest bardzo pomocne w pokonywaniu blokady pisarza, gromadzeniu informacji w jednym miejscu i poszukiwaniu inspiracji. Jednak nigdy nie powinno zastępować ludzkiego pisania, gdyż sztuczna inteligencja ogranicza się do wiedzy już dostępnej.

Warto również zapoznać się z najlepszymi narzędziami do sprawdzania plagiatu, aby zapobiegać kopiowaniu treści.

newsblog.pl

Maciej – redaktor, pasjonat technologii i samozwańczy pogromca błędów w systemie Windows. Zna Linuxa lepiej niż własną lodówkę, a kawa to jego główne źródło zasilania. Pisze, testuje, naprawia – i czasem nawet wyłącza i włącza ponownie. W wolnych chwilach udaje, że odpoczywa, ale i tak kończy z laptopem na kolanach.