Uczenie maszynowe umożliwia komputerom uczenie się na podstawie danych, identyfikowanie wzorców i trendów oraz wykorzystywanie tych spostrzeżeń do podejmowania decyzji lub wspomagania ich podejmowania w firmach.

Jest to jednak trudny przedmiot, który wymaga dużej ilości matematyki i programowania. Nie oznacza to, że nie można się tego nauczyć; jest to bardzo możliwe. Możliwe jest również uniknięcie technicznych komplikacji przy użyciu platform, które omówimy w tym artykule.

Platformy te nie tylko upraszczają proces budowy modelu, ale także ukrywają szczegóły związane z infrastrukturą.

Spis treści:

Co to jest uczenie maszynowe?

Uczenie maszynowe to dziedzina nauki, której celem jest tworzenie komputerów zdolnych do podejmowania decyzji bez potrzeby programowania jawnego. Przed uczeniem maszynowym komputery mogły wykonywać tylko jawnie zaprogramowane zadania.

Programiści musieli dokładnie określić, w jaki sposób komputery mają podejmować decyzje. Chociaż działa to w przypadku niektórych funkcji, niektóre są zbyt skomplikowane, aby można je było jawnie zaprogramować.

Na przykład napisanie programu do klasyfikowania obrazów jest niemożliwe, biorąc pod uwagę, ile różnych kątów, orientacji i oświetlenia jest możliwych dla tego samego obrazu. Uczenie maszynowe umożliwia komputerom wykonywanie zadań bez programowania.

Dlaczego warto korzystać z platform uczenia maszynowego?

Platformy uczenia maszynowego oferują uproszczony sposób budowania modeli. Większość platform oferuje konstruktory o niskim kodzie i bez kodu. Wystarczy, że dostarczysz dane do nauki, a platforma zajmie się resztą. Często nie musisz też martwić się o opłacalne udostępnianie infrastruktury i wdrażanie modeli.

Platformy są zwykle opłacalne w porównaniu z konfiguracjami typu „zrób to sam” dla mniejszych firm, które rzadko budują mniejsze modele. Skonfigurowanie własnej konfiguracji uczenia maszynowego będzie wymagało zakupu drogich procesorów graficznych.

Jednak wynajmując konfigurację, płacisz tylko za to, czego używasz, kiedy z niej korzystasz. Oczywiście, jeśli trenujesz większe modele i/lub często trenujesz, wynik może być inny.

Platformy upraszczają również zarządzanie MLOps. Pomagają przechowywać dzienniki i metryki w celu zapewnienia odtwarzalności.

Teraz omówimy platformy infrastruktury uczenia maszynowego.

Baseten

Baseten zapewnia łatwy sposób wdrażania modeli uczenia maszynowego za pomocą Truss — standardu open source dla modeli pakowania zbudowanych przy użyciu dowolnego popularnego frameworka uczenia maszynowego.

Po wdrożeniu Baseten rejestruje i monitoruje kondycję wdrożonych modeli. Pomaga zarządzać infrastrukturą, automatycznie skalując infrastrukturę obsługującą model na podstawie generowanego ruchu.

Dzięki Baseten możesz również dostroić modele, takie jak FLAN-T5, Llama i Stable Diffusion. Platforma integruje się również z istniejącymi przepływami pracy CI/CD, dzięki czemu możesz budować zgodnie z własnym procesem.

Możesz także pisać bezserwerowe funkcje Pythona, które integrują się z Twoimi modelami. Rozliczenia są dokonywane w momencie wdrożenia modeli, skalowania lub wykonania prognoz. Pomaga to lepiej zarządzać kosztami.

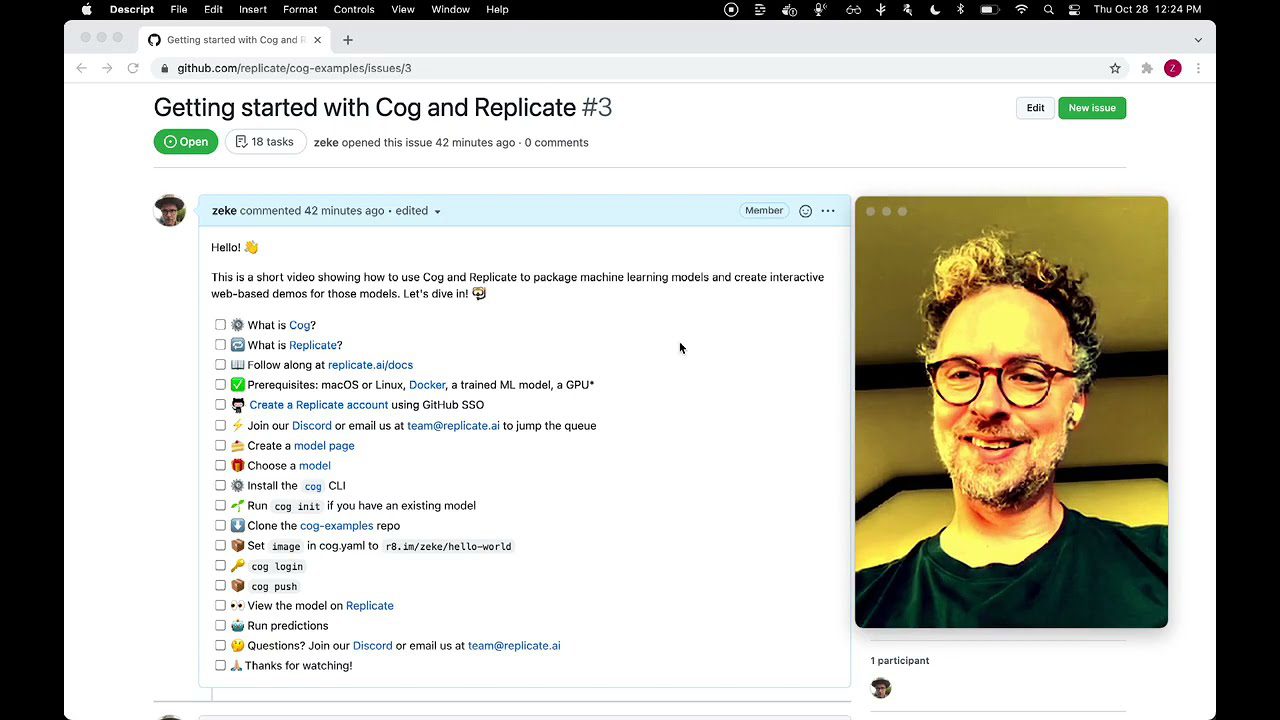

Replika

Replikuj to prosty sposób na uruchamianie modeli uczenia maszynowego. Replicate upraszcza proces opracowywania i uczenia modeli, udostępniając zestaw Python SDK i Rest API, których można używać do przewidywania.

Zasadniczo zapewnia konstruktora o niskim kodzie. Zapewnia modele do wykonywania typowych zadań uczenia maszynowego, takich jak przywracanie obrazu, tworzenie i edycja wideo, generowanie tekstu przy użyciu dużych modeli językowych, konwertowanie obrazów na tekst i odwrotnie oraz zwiększanie rozdzielczości obrazów.

Replicate wykorzystuje Cog, narzędzie do wdrażania modeli uczenia maszynowego w kontenerze gotowym do produkcji, który jest następnie wbudowany w kontener Docker w celu wdrożenia. Replicate zapewnia produkcyjne środowisko uruchomieniowe, które skaluje się w zależności od użycia. To środowisko wykonawcze udostępnia interfejs API REST, do którego można uzyskać dostęp iz którego można korzystać. Rozliczenia są również dokonywane przez sekundę.

Przytulanie twarzy

Hugging Face to społeczność sztucznej inteligencji i platforma do nauki o danych, która zapewnia narzędzia potrzebne do tworzenia, trenowania i wdrażania najnowocześniejszych modeli uczenia maszynowego.

Główną atrakcją Hugging Face w tym kontekście jest AutoTrain, sposób budowania modeli uczenia maszynowego bez kodu poprzez proste przesyłanie zestawu danych szkoleniowych.

AutoTrain automatycznie wypróbuje różne modele, aby znaleźć ten, który najlepiej pasuje do danych treningowych. Następnie możesz wdrożyć przeszkolony model w Hugging Face Hub, usłudze obsługującej model.

Dzięki AutoTrain możesz budować modele do klasyfikacji obrazów, klasyfikacji tekstu, klasyfikacji tokenów, odpowiedzi na pytania, tłumaczenia, podsumowania, regresji tekstu, klasyfikacji danych tabelarycznych i regresji danych tabelarycznych. Po wdrożeniu Twoje modele będą dostępne przez HTTP.

Google AutoML

Google AutoML zapewnia łatwy sposób tworzenia modeli uczenia maszynowego przy minimalnym wysiłku i wiedzy. Obejmuje Vertex AI — ujednoliconą platformę do budowania, wdrażania i skalowania modeli AI.

Dzięki Google AutoML możesz przechowywać zbiory danych i uzyskiwać dostęp do narzędzi uczenia maszynowego używanych przez zespoły w Google. Umożliwia także zarządzanie danymi strukturalnymi w postaci tabelarycznej AutoML, wykrywanie obiektów na obrazach i klasyfikowanie obrazów przy użyciu obrazu AutoML.

Możesz również zrobić to samo dla plików wideo za pomocą AutoML Video. Ponadto możesz przeprowadzać analizę nastrojów w tekście za pomocą funkcji AutoML Text i tłumaczyć między ponad 50 parami językowymi za pomocą funkcji AutoML Translation. Wdrożone modele są dostępne za pomocą interfejsów API REST i RPC.

Azure Open AI

Usługa Azure OpenAI zapewnia dostęp do różnych modeli utworzonych przez OpenAI. Modele te obejmują GPT-3 i GPT-4, które są modelami, które rozumieją język naturalny i kod oraz tworzą w rezultacie język naturalny i kod. GPT-3.5 obsługuje ChatGPT.

Ponadto usługa zapewnia również dostęp do DALL-E, generatora tekstu do obrazu w języku naturalnym. Istnieje również Codex, model, który rozumie i generuje kod z języka naturalnego.

Wreszcie istnieją modele osadzania, które zajmują się wyspecjalizowanym zestawem danych zwanym osadzaniem. Dostęp do tych modeli można uzyskać za pośrednictwem usługi Azure OpenAI przy użyciu interfejsu API REST, zestawu SDK języka Python lub opartego na sieci Web programu Azure OpenAI Studio.

Platforma Azure zapewnia bezpieczeństwo chmury Azure, takie jak prywatna sieć, dostępność regionalna i odpowiedzialne filtrowanie zawartości AI.

AWS Sagemaker

Sagemaker to zarządzana usługa AWS oferowana jako część pakietu usług AWS. Zapewnia narzędzia do tworzenia, trenowania i wdrażania modeli uczenia maszynowego.

Zasadniczo Sagemaker pomaga zautomatyzować żmudny proces tworzenia potoku opracowywania modeli AI/ML na poziomie produkcyjnym. Zapewnia platformę do budowania, hostowania, trenowania i wdrażania modeli AI na dużą skalę w AWS Public Cloud. Sagemaker zapewnia wbudowane algorytmy do wykonywania zadań, takich jak regresja liniowa i klasyfikacja obrazów.

Ponadto obsługuje Jupyter Notebooks, których można używać do tworzenia niestandardowych modeli. Sagemaker jest również wyposażony w ciągły monitor modelu, który próbuje automatycznie znaleźć zestaw parametrów i hiperparametrów, który daje najlepsze wyniki dla twojego algorytmu.

SageMaker pomaga również łatwo wdrażać modele w różnych strefach dostępności jako punkty końcowe HTTP. AWS Cloudwatch może służyć do monitorowania wydajności modeli w czasie.

Kostki danych

Databricks to data lakehouse, który umożliwia przygotowanie i przetwarzanie danych. Ułatwia zarządzanie rozwojem modelu uczenia maszynowego w całym jego cyklu życia.

Kostki danych ułatwiają tworzenie generatywnej sztucznej inteligencji i dużych modeli językowych. Zapewnia kilka kluczowych funkcji, takich jak notesy Databricks do współpracy, które obsługują języki programowania, takie jak Python, R, SQL i Scala.

Datakostki udostępniają również środowisko uruchomieniowe Machine Learning, które jest wstępnie skonfigurowane z klastrami zoptymalizowanymi pod kątem uczenia maszynowego. Aby pomóc we wdrożeniu, platforma zapewnia udostępnianie modeli i monitorowanie. Pomaga także zarządzać potokiem programistycznym za pomocą AutoML i MLFLow.

Ostatnie słowa

Uczenie maszynowe bez wątpienia przyda się każdej firmie. Jednak dogłębna wiedza techniczna wymagana do tworzenia i szkolenia modeli uczenia maszynowego stanowi barierę wejścia dla większości firm.

Jednak platformy omówione w tym artykule upraszczają ten proces i sprawiają, że tworzenie uczenia maszynowego jest bardziej dostępne.

Następnie zapoznaj się ze szczegółowym artykułem na temat DataBricks vs. Snowflake.