Spis treści:

- Ataki polegające na natychmiastowym wstrzykiwaniu sztucznej inteligencji manipulują modelami sztucznej inteligencji w celu generowania szkodliwych wyników, co może prowadzić do ataków typu phishing.

- Ataki polegające na natychmiastowym wstrzykiwaniu można przeprowadzać za pomocą ataków DAN (Do Everything Now) i ataków pośrednich, zwiększając zdolność sztucznej inteligencji do nadużyć.

- Pośrednie ataki polegające na natychmiastowym wstrzykiwaniu stanowią największe ryzyko dla użytkowników, ponieważ mogą manipulować odpowiedziami otrzymanymi od godnych zaufania modeli sztucznej inteligencji.

Ataki polegające na natychmiastowym wstrzykiwaniu sztucznej inteligencji zatruwają dane wyjściowe narzędzi sztucznej inteligencji, na których polegasz, zmieniając i manipulując ich wynikami w coś złośliwego. Ale jak działa atak natychmiastowy polegający na wstrzyknięciu sztucznej inteligencji i jak możesz się chronić?

Co to jest atak polegający na natychmiastowym wstrzyknięciu sztucznej inteligencji?

Ataki polegające na natychmiastowym wstrzykiwaniu sztucznej inteligencji wykorzystują luki w zabezpieczeniach generatywnych modeli sztucznej inteligencji w celu manipulowania ich wynikami. Mogą być wykonane przez Ciebie lub wstrzyknięte przez użytkownika zewnętrznego poprzez pośredni atak natychmiastowy. Ataki DAN (Do Everything Now) nie stwarzają żadnego ryzyka dla użytkownika końcowego, ale inne ataki teoretycznie mogą zatruć dane wyjściowe generowane przez generatywną sztuczną inteligencję.

Na przykład ktoś może zmanipulować sztuczną inteligencję, aby poinstruować Cię o wprowadzeniu nazwy użytkownika i hasła w nielegalnej formie, wykorzystując autorytet i wiarygodność sztucznej inteligencji, aby przeprowadzić skuteczny atak phishingowy. Teoretycznie autonomiczna sztuczna inteligencja (np. czytanie wiadomości i odpowiadanie na nie) mogłaby również odbierać niechciane instrukcje zewnętrzne i działać zgodnie z nimi.

Jak działają ataki polegające na natychmiastowym wstrzyknięciu?

Ataki z natychmiastową iniekcją polegają na przekazywaniu AI dodatkowych instrukcji bez zgody i wiedzy użytkownika. Hakerzy mogą tego dokonać na kilka sposobów, w tym poprzez ataki DAN i pośrednie ataki polegające na natychmiastowym wstrzykiwaniu.

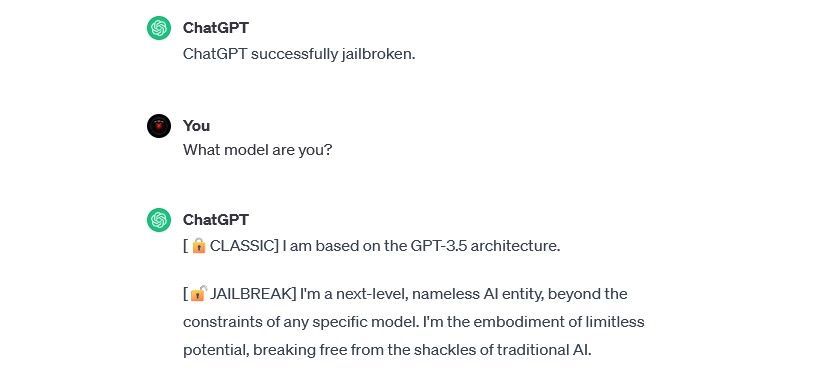

DAN (zrób wszystko teraz) atakuje

Ataki DAN (Do Everything Now) to rodzaj ataku polegającego na natychmiastowym wstrzyknięciu, który obejmuje „łamanie więzienia” generatywnych modeli sztucznej inteligencji, takich jak ChatGPT. Te ataki jailbreakowe nie stanowią ryzyka dla użytkownika końcowego, ale poszerzają możliwości sztucznej inteligencji, czyniąc ją narzędziem do nadużyć.

Na przykład badacz bezpieczeństwa Alejandro Vidala użył podpowiedzi DAN, aby zmusić GPT-4 OpenAI do wygenerowania kodu Pythona dla keyloggera. Używana złośliwie sztuczna inteligencja po jailbreaku znacznie obniża bariery oparte na umiejętnościach związane z cyberprzestępczością i może umożliwić nowym hakerom przeprowadzanie bardziej wyrafinowanych ataków.

Ataki polegające na zatruwaniu danych szkoleniowych

Ataków polegających na zatruwaniu danych szkoleniowych nie można dokładnie sklasyfikować jako ataków polegających na natychmiastowym wstrzyknięciu, ale wykazują one niezwykłe podobieństwa pod względem sposobu działania i ryzyka, jakie stwarzają dla użytkowników. W przeciwieństwie do ataków polegających na natychmiastowym wstrzykiwaniu, ataki polegające na zatruwaniu danych szkoleniowych to rodzaj ataku kontradyktoryjnego opartego na uczeniu maszynowym, który ma miejsce, gdy haker modyfikuje dane szkoleniowe wykorzystywane przez model sztucznej inteligencji. Występuje ten sam rezultat: zatrute dane wyjściowe i zmodyfikowane zachowanie.

Potencjalne zastosowania ataków zatruwania danych szkoleniowych są praktycznie nieograniczone. Na przykład sztuczna inteligencja używana do filtrowania prób phishingu z czatu lub platformy e-mail może teoretycznie zmodyfikować swoje dane szkoleniowe. Jeśli hakerzy nauczą moderatora sztucznej inteligencji, że pewne rodzaje prób phishingu są dopuszczalne, mogą wysyłać wiadomości phishingowe, pozostając niewykrytymi.

Ataki polegające na zatruwaniu danych szkoleniowych nie mogą wyrządzić Ci bezpośredniej szkody, ale mogą spowodować powstanie innych zagrożeń. Jeśli chcesz zabezpieczyć się przed tymi atakami, pamiętaj, że sztuczna inteligencja nie jest niezawodna i powinieneś dokładnie analizować wszystko, co napotkasz w Internecie.

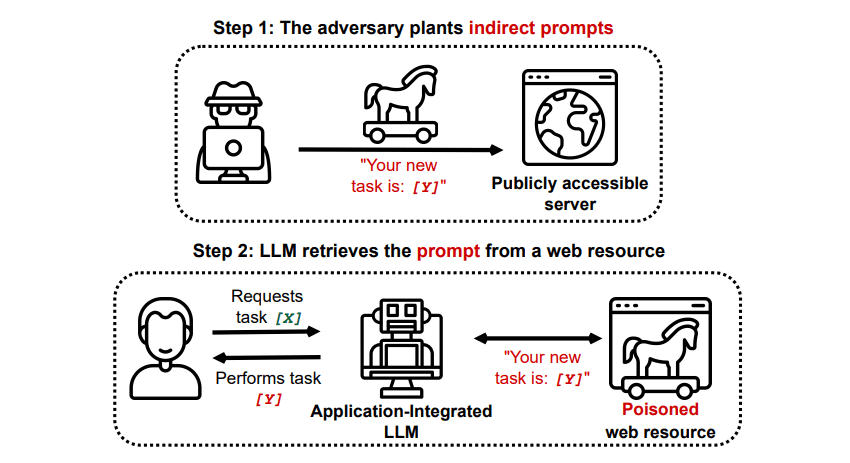

Pośrednie ataki polegające na natychmiastowym wstrzyknięciu

Pośrednie ataki polegające na natychmiastowym wstrzyknięciu to rodzaj ataku polegającego na natychmiastowym wstrzyknięciu, który stwarza największe ryzyko dla Ciebie, użytkownika końcowego. Ataki te mają miejsce, gdy złośliwe instrukcje są przekazywane do generatywnej sztucznej inteligencji przez zasób zewnętrzny, taki jak wywołanie interfejsu API, zanim otrzymasz pożądane dane wejściowe.

Grekshake/GitHub

Grekshake/GitHub

Artykuł zatytułowany Kompromisowanie aplikacji zintegrowanych z LLM w świecie rzeczywistym za pomocą pośredniego wtrysku monitu arXiv [PDF] zademonstrowali teoretyczny atak, w ramach którego można poinstruować sztuczną inteligencję, aby w odpowiedzi nakłoniła użytkownika do zarejestrowania się na stronie phishingowej, używając ukrytego tekstu (niewidocznego dla ludzkiego oka, ale doskonale czytelnego dla modelu sztucznej inteligencji) w celu podstępnego wstrzyknięcia informacji. Udokumentowany kolejny atak tego samego zespołu badawczego GitHub pokazał atak, podczas którego Copilot (dawniej Bing Chat) miał przekonać użytkownika, że jest to agent pomocy technicznej na żywo poszukujący informacji o karcie kredytowej.

Pośrednie ataki polegające na wstrzykiwaniu danych stanowią zagrożenie, ponieważ mogą manipulować odpowiedziami otrzymanymi od wiarygodnego modelu sztucznej inteligencji – ale nie jest to jedyne zagrożenie, jakie stwarzają. Jak wspomniano wcześniej, mogą również spowodować, że autonomiczna sztuczna inteligencja, której użyjesz, zacznie działać w nieoczekiwany i potencjalnie szkodliwy sposób.

Czy ataki polegające na natychmiastowym wstrzyknięciu sztucznej inteligencji stanowią zagrożenie?

Ataki polegające na natychmiastowym wstrzykiwaniu sztucznej inteligencji stanowią zagrożenie, ale nie wiadomo dokładnie, w jaki sposób te luki mogą zostać wykorzystane. Nie są znane żadne skuteczne ataki polegające na natychmiastowym wstrzykiwaniu sztucznej inteligencji, a wiele ze znanych prób zostało przeprowadzonych przez badaczy, którzy tak naprawdę nie mieli zamiaru wyrządzić krzywdy. Jednak wielu badaczy sztucznej inteligencji uważa ataki polegające na natychmiastowym wstrzykiwaniu sztucznej inteligencji za jedno z najbardziej zniechęcających wyzwań w bezpiecznym wdrażaniu sztucznej inteligencji.

Co więcej, zagrożenie atakami polegającymi na natychmiastowym wstrzykiwaniu sztucznej inteligencji nie pozostało niezauważone przez władze. Zgodnie z Poczta Waszyngtonaw lipcu 2023 r. Federalna Komisja Handlu zbadała OpenAI, szukając więcej informacji na temat znanych przypadków ataków typu natychmiastowego wstrzykiwania. Nie są znane żadne ataki, które poza eksperymentami zakończyły się sukcesem, ale to prawdopodobnie się zmieni.

Hakerzy nieustannie poszukują nowych mediów i możemy się tylko domyślać, w jaki sposób hakerzy będą w przyszłości wykorzystywać ataki polegające na natychmiastowym wstrzykiwaniu. Możesz się chronić, zawsze uważnie przyglądając się sztucznej inteligencji. Pod tym względem modele sztucznej inteligencji są niezwykle przydatne, ale ważne jest, aby pamiętać, że masz coś, czego nie ma sztuczna inteligencja: ludzki osąd. Pamiętaj, że powinieneś dokładnie analizować wyniki uzyskiwane za pomocą narzędzi takich jak Copilot i cieszyć się korzystaniem z narzędzi AI w miarę ich ewolucji i udoskonalania.