Jeśli spędziłeś w przedsiębiorstwie choćby krótki czas, być może napotkałeś potrzebę skutecznego zbierania danych z różnych źródeł analiz i spostrzeżeń.

Te analizy danych wywarły ogromny wpływ na generowanie przychodów i ograniczanie kosztów przez wiele organizacji. Ale nie powinnaś być zaskoczona ilością generowanych i analizowanych danych, ponieważ ich liczba i rodzaje eksplodują.

Ta eksplozja zmusza firmy działające w oparciu o dane do korzystania z niezawodnych, skalowalnych i bezpiecznych rozwiązań do analizowania danych i zarządzania nimi. Wymagania systemów przewyższają możliwości tradycyjnej bazy danych i tu właśnie pojawia się technologia chmury.

Wraz z postępującą współczesną technologią chmurową wiele krytycznych aplikacji biznesowych, takich jak planowanie zasobów przedsiębiorstwa (ERP), bazy danych i narzędzia marketingowe, zostało przeniesionych do chmury. Podczas gdy dane biznesowe znajdują się w chmurze, firmy potrzebują rozwiązania, które bezproblemowo przechowuje wszystkie dane z różnych aplikacji opartych na chmurze. Rozwiązaniem jest hurtownia danych w chmurze.

Ten artykuł pomoże Ci zrozumieć hurtownię danych w chmurze i wymienić kilka najlepszych. Na zakończenie wyjaśnij, jak wybrać najlepszą dla swojej organizacji.

Spis treści:

Krótka historia danych w chmurze Hurtownie danych w chmurze

Jak w przypadku każdej domeny technicznej, musisz zrozumieć, dlaczego istnieje, aby naprawdę ją zrozumieć. Ta konwencja dotyczy zrozumienia modelu działania hurtowni danych w chmurze.

Według Education Ecosystem hurtownie danych pojawiły się po raz pierwszy w latach 80. XX wieku i miały pomagać w przepływie danych z systemów operacyjnych do systemów wspomagania decyzji (DSS). Wczesne wersje wymagały ogromnej redundancji, a wiele organizacji musiało mieć wiele środowisk DSS, aby obsługiwać kilku użytkowników. Środowiska DSS używają tych samych danych. Jednak gromadzenie, sprzątanie i integracja były często powielane.

Wraz ze wzrostem wydajności hurtowni danych ewoluowały one od obsługujących informacje tradycyjnych platform analizy biznesowej (BI) do szerokich architektur analitycznych obsługujących różne aplikacje, takie jak zarządzanie wydajnością i analiza wydajności.

Na przestrzeni lat poczyniono ogromne postępy w dostarczaniu przedsiębiorstwom dodatkowej wartości dzięki najnowszym magazynom sterowanym danymi (EWD), które zapewniają dostęp do danych w czasie rzeczywistym i wgląd w uczenie maszynowe. To jednak wykracza poza zakres tego postu.

Co to jest hurtownia danych w chmurze

Jeśli chcesz wykorzystać inteligencję w infrastrukturze biznesowej, hurtownia danych jest rdzeniem Twojej architektury. W przeciwieństwie do zwykłych baz danych, hurtownie danych są zaprojektowane tak, aby oferować optymalne zapytania analityczne dotyczące ogromnych zbiorów danych. Bazy danych to często systemy przetwarzania transakcji.

Hurtownia danych w chmurze obejmuje bazę danych dostępną jako usługa zarządzana w chmurze publicznej i można ją zoptymalizować pod kątem skalowalnej analizy biznesowej i analiz. Można go również przeglądać jako zbiór aktualnych i przeszłych informacji.

Chociaż dostępnych jest wiele hurtowni danych w chmurze, każda oferuje inny rodzaj usług. Istnieje jednak kilka wspólnych czynników, których można się spodziewać na wszystkich tych platformach: przechowywanie danych i zarządzanie nimi, automatyczne aktualizacje oprogramowania oraz elastyczne zarządzanie pojemnością, które bezproblemowo rozszerza lub zmniejsza ilość danych.

Kluczowe cechy

- Przetwarzanie masowo równoległe (MPP) — ta funkcja jest dostępna w hurtowniach danych w chmurze obsługujących projekty dużych zbiorów danych, aby korzystać z wysokowydajnych zapytań w przypadku dużych ilości danych. MPP obejmuje wiele serwerów działających równolegle w celu dystrybucji obciążeń związanych z przetwarzaniem, wejściem i wyjściem.

- Magazyn danych kolumnowych — ta funkcja zapewnia ekonomiczną elastyczność podczas obsługi analiz. Dane kolumnowe przechowują dane procesowe w kolumnach zamiast w wierszach, co przyspiesza agregację zapytań, na przykład w raportach.

Korzyści

Hurtownie danych w chmurze pokazują, że muszą być obecne w każdej nowoczesnej firmie w zakresie analiz i spostrzeżeń biznesowych, które usprawniają operacje i ulepszają obsługę klienta, zapewniając Twojej firmie przewagę konkurencyjną. Oto korzyści płynące z korzystania z hurtowni danych w chmurze.

Dostawcy hurtowni danych w chmurze

Teraz, gdy znasz już ofertę hurtowni danych w chmurze, możesz wybrać odpowiednią dla swoich potrzeb. Chociaż te wymienione tutaj nie są uszeregowane w określonej kolejności, zaczęliśmy od tych, którzy mają najlepszą wiedzę techniczną.

Google BigQuery

Opracowana przez Google usługa BigQuery to w pełni zarządzana bezserwerowa hurtownia danych, która jest automatycznie skalowalna, aby dopasować ją do Twoich potrzeb w zakresie przechowywania i przetwarzania danych. Podobnie jak inne produkty Google, oprócz opłacalności oferuje potężne możliwości analityczne. Jest również niezawodny i oferuje kilka narzędzi analizy biznesowej, których można użyć do zebrania informacji i dokonania dokładnych prognoz. BigQuery obsługuje złożone agregacje w ogromnych zbiorach danych dzięki przechowywaniu opartemu na kolumnach.

Google nie chce pozwolić Ci zarządzać infrastrukturą magazynową, dlatego Big Query ukrywa podstawowy sprzęt, węzły, bazę danych i szczegóły konfiguracji. A jeśli chcesz szybko zacząć, musisz utworzyć konto w Google Cloud Platform (GCP), załadować tabelę i uruchomić zapytanie.

Możesz także używać kolumnowych baz danych BigQuery i ANSI SQL do analizowania petabajtów danych z dużą szybkością. Jego możliwości są wystarczająco szerokie, aby umożliwić analizę przestrzenną przy użyciu SQL i BigQuery GIS. Możesz też szybko tworzyć i uruchamiać modele uczenia maszynowego (ML) na danych strukturalnych o średniej lub dużej skali, używając prostego SQL i BigQuery ML. Korzystaj też z interaktywnego pulpitu nawigacyjnego działającego w czasie rzeczywistym za pomocą mechanizmu BigQuery BI.

Aby w pełni wykorzystać możliwości analizy danych BigQuery, musisz dobrze znać SQL, podobnie jak w przypadku innych hurtowni danych. Jest to również opłacalne. Ale cena zależy od jakości kodu (płacisz za szybkość przetwarzania i pamięć), więc musisz zoptymalizować swoje zapytania, aby przeciwdziałać wysokim kosztom podczas pobierania danych.

BigQuery obsługuje ciężkie operacje obliczeniowe w oparciu o oddzielne warstwy przetwarzania i przechowywania, dzięki czemu jest odpowiedni dla organizacji, dla których dostępność jest ważniejsza niż spójność.

Przesunięcie ku czerwieni Amazonki

Powstały w listopadzie 2021 r. Amazon Redshift został uruchomiony jako w pełni zarządzany magazyn danych w chmurze, który może obsługiwać dane w skali petabajtów. Chociaż nie była to pierwsza hurtownia danych w chmurze, stała się pierwszą, która zwiększyła udział w rynku po przyjęciu na dużą skalę. Redshift wykorzystuje dialekt SQL oparty na PostgreSQL, który jest dobrze znany wielu analitykom na całym świecie, a jego architektura przypomina lokalne hurtownie danych.

Z drugiej strony Redshift różni się od innych rozwiązań z tej listy. Jego warstwy obliczeniowe i pamięci masowej nie są całkowicie oddzielne. Ta architektura znacząco wpływa na wydajność zapytań analitycznych, jeśli wykonujesz wiele operacji zapisu. Dlatego będziesz potrzebować wewnętrznego personelu, który będzie aktualizował systemy za pomocą bieżącej konserwacji i aktualizacji.

Jeśli szukasz doskonałej spójności na poziomie wierszy, takiej jak ta stosowana w sektorze bankowym, Redshift jest dobrym wyborem. Jednak może to nie być najlepszy wybór, jeśli Twoja organizacja musi wykonywać operacje zapisu i przetwarzania jednocześnie.

Płatek śniegu

Hurtownia danych w chmurze Snowflake jest jedyna w swoim rodzaju; jest w pełni zarządzany i działa na AWS, GCP i Azure, w przeciwieństwie do innych profilowanych tutaj magazynów działających w ich chmurze. Snowflake jest łatwy w użyciu i dobrze znany ze swojej zaawansowanej zdolności do przekształcania, wykonywania szybkich zapytań, wysokiego poziomu bezpieczeństwa i automatycznego skalowania w zależności od potrzeb.

Elastyczna baza kodu Snowflake umożliwia prowadzenie globalnych działań związanych z replikacją danych, takich jak przechowywanie danych w dowolnej chmurze bez ponownego kodowania lub uczenia się nowych umiejętności.

Snowflake obsługuje analityków danych na wszystkich poziomach, ponieważ nie używa języka programowania Python ani R. Jest również dobrze znany z bezpiecznego i skompresowanego przechowywania danych częściowo ustrukturyzowanych. Poza tym umożliwia obracanie wielu wirtualnych magazynów w zależności od potrzeb, jednocześnie równolegle i izolując poszczególne zapytania, zwiększając ich wydajność. Możesz wchodzić w interakcje z Snowflake za pomocą przeglądarki internetowej, wiersza poleceń, platform analitycznych i innych obsługiwanych sterowników.

Mimo że Snowflake jest preferowany ze względu na możliwość uruchamiania zapytań, które nie są możliwe w przypadku innych rozwiązań, oferuje najlepsze kreacje pulpitu nawigacyjnego; musisz kodować niestandardowe funkcje i procedury.

Płatek śniegu jest popularny wśród firm średniej wielkości, które nie muszą wykonywać operacji zapisu i przetwarzania dużej ilości danych lub wymagają spójności w dużych ilościach danych.

Baza danych Azure SQL

Ten produkt to zarządzana baza danych jako usługa dostępna jako sekcja Microsoft Azure, platformy przetwarzania w chmurze. Jeśli Twoja organizacja korzysta z narzędzi biznesowych firmy Microsoft, może to być dla Ciebie naturalny wybór.

Baza danych Azure SQL jest widoczna w przypadku hostingu w chmurze z interaktywną podróżą użytkownika od tworzenia serwerów SQL do konfigurowania baz danych. Jest również powszechnie preferowany ze względu na łatwy w użyciu interfejs i wiele funkcji do manipulowania danymi. Ponadto jest skalowalny w celu obniżenia kosztów i optymalizacji wydajności przy niskim zużyciu.

Z drugiej strony nie jest przeznaczony do dużych ilości danych. Nadaje się do obsługi obciążeń związanych z przetwarzaniem transakcji online (OLTP) i obsługuje duże ilości procesów odczytu i zapisu w centrach handlowych.

To narzędzie byłoby ulubionym wyborem, jeśli Twoja firma zajmuje się prostymi zapytaniami i niewielkimi obciążeniami danych. Jednak nie jest to najlepsze rozwiązanie, jeśli Twoja firma potrzebuje potężnej siły analitycznej.

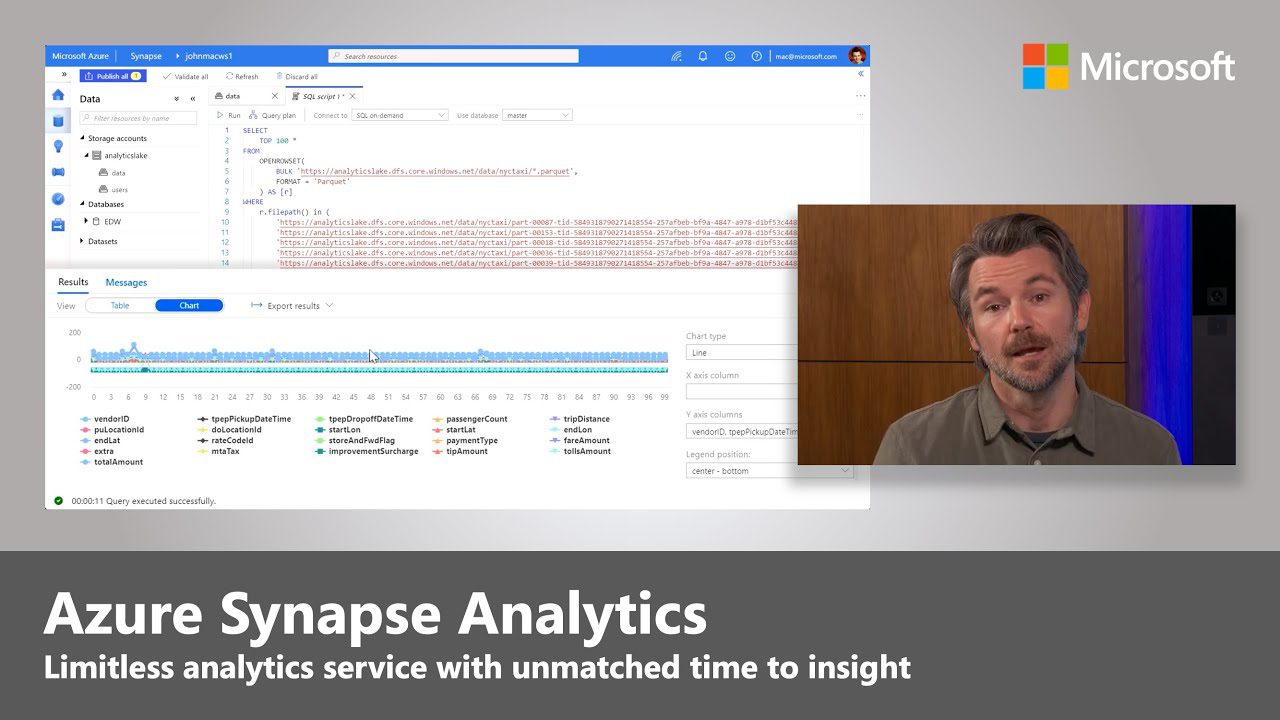

Azure Synapse

Ta sekcja platformy Azure jest ukierunkowana na analitykę i łączy kilka usług, takich jak integracja danych, magazynowanie danych i analiza ogromnych ilości danych. Chociaż wydaje się podobny do bazy danych Azure SQL, jest inny.

Analiza usługi Azure Synapse jest skalowalna dla dużych tabel danych w oparciu o przetwarzanie rozproszone. Opiera się na MPP (wspomnianym na początku, wróć do niego, jeśli go nie rozumiesz), aby szybko uruchamiać duże ilości złożonych zapytań w wielu węzłach. Synapse kładzie dodatkowy nacisk na bezpieczeństwo i prywatność.

Chociaż jest to standardowa opcja dla firm, które już korzystają z narzędzi Microsoft, trudno jest zintegrować ją z produktami innymi niż hurtownie danych innych firm. Usługa może czasami powodować błędy, ponieważ jest stale aktualizowana.

Usługa Azure Synapse jest przeznaczona do przetwarzania analitycznego w trybie online i dlatego najlepiej nadaje się do przetwarzania dużych zestawów danych w czasie rzeczywistym. Możesz rozważyć użycie usługi Azure Synapse przez SQL, jeśli dane magazynu są bardziej znaczące niż jeden terabajt

Ognisty pocisk

Wciąż nowy w tej dziedzinie. Firebolt twierdzi, że jest magazynem przyszłej generacji, działającym 182 razy szybciej niż systemy oparte na SQL. Firebolt jest szybki, ponieważ wykorzystuje nowe techniki analizy i kompresji danych.

Podczas swoich zapytań uzyskuje dostęp do małych zakresów danych za pomocą indeksów, w przeciwieństwie do innych hurtowni danych, które wykorzystują całe partycje i segmenty, zwalniając przepustowość sieci. Jest skalowalny i może wyszukiwać duże zbiory danych z imponującą szybkością.

Chociaż jest nowością na rynku, nie integruje się z całym ekosystemem (który jest rozległy) platform biznesowych i narzędzi wywiadowczych. Jednak problem można łatwo rozwiązać za pomocą specjalnego narzędzia do wyodrębniania, przekształcania i ładowania (ETL) do kierowania danych do iz hurtowni.

Pamięć masowa i moce obliczeniowe Firebolt są rozdzielone, co czyni go ekonomicznym dla dużych i małych instytucji. Jest najlepszy dla firm, które potrzebują szybkich analiz, chociaż potrzebni są doświadczeni analitycy danych.

Wybór odpowiedniej hurtowni danych w chmurze

Jeśli potrzebujesz hurtowni danych w chmurze i chcesz dobrej, weź pod uwagę wielkość swojej organizacji i sposób zarządzania danymi. Jeśli jesteś właścicielem małej organizacji zarządzającej małymi rozmiarami danych i dysponującej niewielkimi lub żadnymi zasobami ludzkimi do obsługi sektora analizy danych, na przykład niektórych witryn handlu elektronicznego, chciałbyś zamiast tego wybrać dom danych, który jest łatwy w użyciu i opłacalny perspektywicznej wydajności.

Z drugiej strony, jeśli prowadzisz dużą organizację, która potrzebuje określonego zestawu danych, musisz stawić czoła kompromisowi. Kompromis jest szczegółowo opisany zgodnie z twierdzeniem CAP, które stwierdza, że wszelkie rozproszone dane gwarantują bezpieczeństwo, dostępność i tolerancję partycji (czyli ochronę przed awarią). W większości przypadków każda organizacja będzie potrzebować częściowej tolerancji, pozostawiając kompromis między spójnością a dostępnością.

Możesz teraz sprawdzić najbardziej niezawodne narzędzia do integracji danych.